如何使用 OpenAI 的 GPT Builder 构建自定义 ChatGPT

了解如何使用 OpenAI 的 GPT Builder 创建自定义 ChatGPT,以获得定制的对话式 AI 体验。我们将指导您完成从选择数据集到微调模型的各个步骤。

ChatGPT 源自 OpenAI 强大的 GPT(生成式预训练变压器)系列,是一种最先进的对话式 AI 模型,能够对各种问题和任务提供类似人类的响应。它已广泛用于各种应用程序,例如 聊天机器人、客户支持系统和内容生成,其主要目的是与用户进行自然语言交互。凭借其在生成真实且相关的基于文本的响应方面的卓越性能,ChatGPT 已成为许多现代人工智能系统不可或缺的一部分。

要构建满足您的特定项目要求的自定义 ChatGPT,请在适合您感兴趣领域的数据集上微调预训练模型。这使得模型能够学习目标领域的细微差别,并生成更符合您所需的对话式 AI 体验的响应。

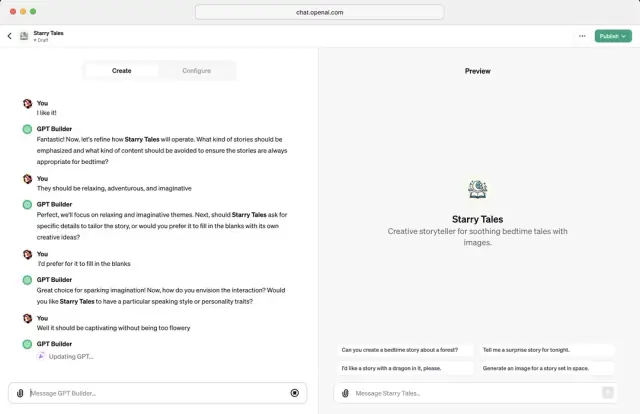

OpenAI 的 GPT Builder 概述

OpenAI 的 GPT Builder 是一款工具,可让您创建自己的自定义 ChatGPT 实例,重点关注应用程序的独特需求。通过利用强大的 GPT 模型,GPT Builder 可以帮助您在您选择的数据集上微调原始模型,从而产生专为您的项目量身定制的优化对话式 AI 体验。

GPT Builder 通过提供易于使用的数据集处理、模型训练、评估和部署框架,简化了自定义 ChatGPT 模型。它允许您试验配置并执行必要的调整,以实现所需的输出或平衡模型性能和资源限制。

图片来源:The Verge

设置开发环境

在构建自定义 ChatGPT 之前,设置适当的开发环境至关重要。它将需要特定的硬件和软件配置:

硬件要求

- 一台功能强大的计算机,具有多核处理器和足够的 RAM(至少 32 GB)。

- 支持 CUDA 的 NVIDIA GPU 和至少 12 GB VRAM,可实现高效的模型训练和微调。使用更大的模型可能需要更强大的 GPU 甚至多 GPU 设置。

软件要求

在您的系统上安装以下软件组件:

- Python 3.7 或更高版本。确保安装适合您的操作系统的版本。

- 安装具有 GPU 支持的 TensorFlow 库(版本 2.x)。 TensorFlow 是一个流行的开源机器学习库,它为使用基于 GPT 的模型提供了一个全面的生态系统。

- OpenAI 库。该Python包允许您方便、直接地访问和使用OpenAI的GPT模型和API。

- 其他所需的 Python 库,例如 Numpy、Pandas 和 requests,是数据操作、处理和 API 调用所必需的。

设置开发环境后,您可以开始使用 OpenAI 的 GPT Builder 构建自定义 ChatGPT 实例。在接下来的部分中,我们将引导您完成选择和准备数据集、构建和微调模型、测试和评估其性能以及将其部署到实际应用程序所需的步骤。

选择和准备数据集

自定义 ChatGPT 模型的成功在很大程度上取决于微调过程中使用的数据集的质量和多样性。通过选择正确的数据集,您可以创建满足您的特定要求并提供所需性能水平的模型。以下步骤可帮助您选择和准备用于训练自定义 ChatGPT 模型的数据集。

选择正确的对话数据集

第一步是确定与您的项目目标相符的合适的会话数据集。选择数据集时有多种选择:

- 预先存在的数据集: 您可以使用公开可用的对话数据集(例如康奈尔电影对话语料库、Persona-Chat 数据集或斯坦福问答数据集 (SQuAD))来训练模型。

- 自定义数据集: 或者,您可以创建与您的域或用例匹配的自定义数据集。考虑从客户支持聊天日志、访谈或任何其他适合模型目的的上下文中收集对话。创建此类数据集时,请确保数据是匿名的并得到适当同意,以避免隐私和道德问题。

- 数据集组合: 您还可以组合标准数据集和自定义数据集,创建更丰富、更多样化的对话集来训练模型。

清理和预处理数据集

在将数据集输入自定义 ChatGPT 模型之前,清理和预处理数据至关重要。这个过程有几个步骤,包括:

- 删除不相关的内容或噪音,例如广告或特殊字符。

- 纠正语法和拼写错误,这些错误可能会在训练过程中使模型感到困惑。

- 将文本转换为小写以保持一致性。

- 对数据集进行标记,将其转换为模型可以理解的格式(例如,将句子拆分为单词或子词)。

格式化训练数据

清理和预处理后,您需要根据 OpenAI 的 GPT Builder 的要求格式化数据集。通常,基于聊天的模型需要将对话格式化为一系列交替的用户语句和模型响应。每个陈述和响应对都应该有清晰的标签,并且应该使用特殊的标记来指示句子或对话的开始和结束。例如,如果您的数据集包含用户 (U) 和模型 (M) 之间的对话,您可以将其格式化如下: ``` { "dialog": [ {"role": "user, {"role" : "助理, {"角色": "用户, {"角色": "助理] } ```

通过选择正确的数据集、对其进行清理和预处理,并根据模型的要求对其进行格式化,您可以为构建强大且准确的自定义 ChatGPT 模型奠定坚实的基础。

构建和微调您的自定义模型

准备好数据集后,下一步是使用 OpenAI 的 GPT Builder 构建和微调您的自定义 ChatGPT。以下步骤概述了模型构建和微调的过程:

初始化你的模型

首先使用 OpenAI 的 GPT Builder 初始化 GPT 模型。您可以根据您的性能和资源要求在各种 GPT 模型大小之间进行选择,例如 GPT-3 、GPT-2,甚至更小的 GPT 模型。

加载预训练的模型权重

从 OpenAI 的 GPT 模型加载预训练的模型权重。这些权重已经过数十亿文本输入的训练,是您的自定义模型的一个强有力的起点。

准备训练设置

在微调自定义 ChatGPT 模型之前,请通过指定必要的训练参数和超参数来设置训练环境,例如:

- 批量大小: 每次更新模型权重时使用的训练样本数量。

- 学习率: 用于优化模型权重的步长。

- 历元数: 训练循环迭代整个数据集的次数。

微调您的定制模型

准备好训练设置后,使用 GPT Builder 在准备好的数据集上微调自定义 ChatGPT 模型。此过程根据数据集中的模式更新模型权重,使您的 ChatGPT 适合您的特定用例。

迭代和优化

微调 ChatGPT 模型是一个迭代过程。监控模型的性能指标,例如困惑度或损失,并根据需要调整超参数。您可能需要尝试不同的学习率和批量大小,甚至以不同的方式预处理数据集以获得更好的结果。

通过构建和微调您的自定义 ChatGPT 模型,您可以创建一个对话式 AI 模型,为您的用户提供特定于领域的、高度相关且准确的响应。

测试和评估模型

构建并微调自定义 ChatGPT 模型后,测试和评估其性能至关重要。这可确保模型提供高质量的响应并与您的项目目标保持一致。您可以按照以下步骤来测试和评估您的模型:

使用评估指标

定量评估指标(例如 BLEU、ROUGE 或 METEOR)可用于评估模型生成的响应的质量。这些指标比较模型响应与人类生成的参考响应之间的相似性。虽然这些指标有助于衡量模型的性能,但它们可能并不总是能捕捉到响应的细微差别和上下文相关性。

进行真实测试

在受控环境中部署自定义 ChatGPT 模型可以提供对其实际性能的宝贵见解。与模型交互,提出各种问题、陈述或场景,并分析其响应的质量、相关性和准确性。

执行手动评估

有时,领域专家或目标用户的手动评估可以提供有关模型性能的宝贵见解。这些评估可以帮助您发现自动化指标可能遗漏的任何差异。它还可以揭示需要进一步改进或完善的领域。

迭代和优化

根据测试和评估阶段收集的反馈和结果,通过根据需要调整训练设置、数据集或训练参数来迭代您的自定义 ChatGPT 模型。请记住,创建高性能的自定义 ChatGPT 模型需要不断迭代和优化。

通过彻底测试、评估和完善您的模型,您可以确保它与您的需求紧密结合,并为您的用户提供卓越的对话体验。如果您计划将自定义 ChatGPT 集成到您的软件解决方案中, AppMaster 等平台可以通过其 无代码、用户友好的界面轻松实现这一点。

部署自定义 ChatGPT

构建并微调自定义 ChatGPT 模型后,必须有效部署它,以便用户可以访问它并与之交互。请按照以下步骤部署自定义 ChatGPT 模型:

- 选择托管环境: 您可以使用 Google Cloud Platform (GCP)、 Amazon Web Services (AWS) 或 Microsoft Azure 等服务将模型托管在本地服务器或云中。选择托管环境时,请考虑您的项目要求、可扩展性需求和预算。

- 配置服务器: 创建并配置服务器环境以运行自定义 ChatGPT。这通常涉及安装必要的软件依赖项、使用正确的配置设置服务器以及使用身份验证和加密机制保护服务器。

- 上传模型: 通过安全文件传输协议 (SFTP) 或使用云提供商的对象存储服务(例如 Google Cloud Storage、Amazon S3 或 Azure Blob Storage)将您的自定义 ChatGPT 模型传输到您选择的托管环境。

- 通过 API 公开模型: 创建 API 来处理用户的请求并从模型检索响应。这可以通过 FastAPI、Django 或基于 Python 的应用程序的 Flask 等标准框架来实现。在继续之前测试 API 的功能以确保正确集成。

- 监控性能: 通过服务器监控工具和自定义脚本定期监控模型的性能、资源使用情况和正常运行时间。设置警报,以便在出现资源消耗过多、服务中断或模型行为异常等问题时通知您。

- 维护和更新: 通过定期更新软件依赖项、安全补丁以及根据用户反馈和性能数据定期优化自定义 ChatGPT 模型,确保您的服务器环境和模型实现是最新的。

将模型与外部应用程序集成

一旦部署了自定义 ChatGPT 并通过 API 进行访问,您就可以将其与外部应用程序集成,例如聊天机器人、客户支持系统或内容管理平台。以下是将自定义 ChatGPT 集成到外部应用程序中的一些提示:

- 利用现有的插件架构: 许多外部应用程序提供插件功能来扩展其功能。为这些平台开发自定义插件,与您的自定义 ChatGPT 的 API 交互,以提供无缝集成,并对现有系统进行最少的修改。

- 与聊天机器人框架集成: 通过使用原生 API 或构建自定义集成,在流行的聊天机器人框架(例如 Microsoft Bot Framework、Dialogflow 或 Rasa)中实现自定义 ChatGPT 模型。这将允许聊天机器人利用您的自定义 ChatGPT 模型的功能。

- 连接到 CRM 和客户支持系统: 使用 API 或自定义连接器,将您的自定义 ChatGPT 模型与 客户关系管理 (CRM) 系统和客户支持平台(如 Zendesk 或 Salesforce)集成,以启用高级对话式 AI 功能,例如案例处理和票证解决。

- 超越基于文本的交互: 通过将自定义 ChatGPT 与 Amazon Alexa 或 Google Assistant 等基于语音的平台连接,并使用语音转文本和文本转语音功能来实现与用户的语音交互,从而增强自定义 ChatGPT 的功能。

- 与AppMaster集成: 使用AppMaster的no-code平台,您可以将自定义 ChatGPT 模型与在该平台上构建的应用程序无缝集成,从而在软件解决方案中简化对话式 AI 的实施。这简化了应用程序中聊天界面和交互元素的整合。

优化模型以获得更好的性能

持续优化对于充分利用自定义 ChatGPT 模型至关重要。使用这些策略来优化您的自定义 ChatGPT 模型以获得更好的性能:

- 监控用户反馈: 密切关注自定义 ChatGPT 模型生成的用户反馈和响应。确定模型可能需要改进的领域,并使用此信息来指导对数据集的进一步微调。

- 调整超参数: 尝试更改超参数(例如学习率、批量大小和训练周期数),以找到自定义 ChatGPT 模型的最佳配置。微调超参数可以提高模型的性能和效率。

- 实施模型修剪: 通过修剪模型架构中不必要的连接和参数(权重),减少自定义 ChatGPT 模型的大小和复杂性。这可以减少计算成本和资源使用,同时保持高质量的性能和输出。

- 利用量化: 量化技术可以通过降低模型中权重和激活的精度来进一步优化模型,而不会显着影响性能。这可以提高性能、降低延迟并减少资源消耗。

- 执行真实世界测试: 使用真实世界数据和场景测试您的模型,以发现新的优化和改进。这可确保您的自定义 ChatGPT 模型保持最新状态并达到所需的准确性和可靠性水平。

通过遵循这些准则,您可以进一步增强自定义 ChatGPT 模型的性能和功能,确保它可靠地满足用户和应用程序的需求。

结论和后续步骤

在本指南中,我们概述了如何使用 OpenAI 的 GPT Builder 构建您自己的自定义 ChatGPT。通过创建定制的对话式 AI 模型,您可以提高性能并更准确地理解您的特定用例。下一步,您应该熟悉机器学习、自然语言处理和模型评估等基本主题,以深入了解基本概念。不断迭代和改进您的自定义 ChatGPT,以最大限度地提高其有效性并微调其功能,以更好地满足您的项目需求。

此外,考虑探索其他对话式人工智能模型和框架替代方案,以获得对该领域可用技术的更广泛的视角。与开源社区互动,学习他们的经验,并利用他们的知识来微调和优化您的自定义 ChatGPT。

最后,考虑利用AppMaster等平台,这是一个强大的no-code工具,用于创建 Web、移动和后端应用程序,将您的自定义 ChatGPT 无缝集成到您的项目中。这将使您能够将对话式 AI 的强大功能运用到软件解决方案的各个方面,从而改善用户体验并优化应用程序的性能。

通过正确的方法和实验意愿,您可以创建功能强大的自定义 ChatGPT,满足您的独特需求,并帮助您的项目在不断发展的人工智能和技术世界中脱颖而出。

常见问题

ChatGPT 是一种对话式 AI 模型,可以与用户进行自然语言交互,提供类似人类的问题回答、参与讨论并解决各种任务。

OpenAI 的 GPT Builder 允许您通过在特定数据集上微调原始 GPT 模型来创建定制的 ChatGPT 实例,从而提供更适合您项目要求的优化对话式 AI 体验。

要设置使用 GPT Builder 的开发环境,您需要一台功能强大的计算机、NVIDIA GPU 以及必要的软件,例如 Python、TensorFlow 和 OpenAI 库。

选择正确的数据集对于构建自定义 ChatGPT 至关重要。您可以使用预先存在的对话数据集或创建自己的对话数据集。确保在训练模型之前正确清理、预处理和格式化数据集。

微调您的自定义 ChatGPT 模型涉及在数据集上训练模型、调整超参数以及迭代此过程,直到达到所需的性能。

要测试和评估您的自定义 ChatGPT,您可以使用各种指标(例如 BLEU、ROUGE 或 METEOR),并通过用户交互和手动评估进行实际测试。

是的,您可以通过API或自定义插件将自定义 ChatGPT 与外部应用程序集成,从而实现 ChatGPT 与其他系统之间的无缝协作。

优化您的自定义 ChatGPT 涉及微调模型、调整超参数、优化响应生成以及根据项目的具体要求进行进一步自定义。

AppMaster的no-code平台允许将自定义 ChatGPT 模型与平台上构建的应用程序无缝集成,从而提供在软件解决方案中实施对话式 AI 的简化方法。