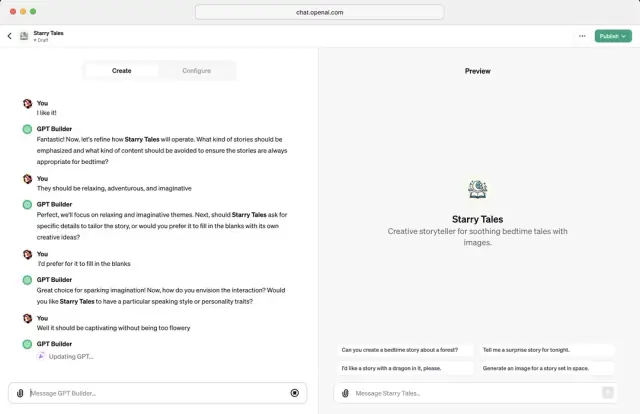

OpenAI の GPT ビルダーを使用してカスタム ChatGPT を構築する方法

OpenAI の GPT Builder を使用してカスタマイズされた ChatGPT を作成し、カスタマイズされた会話型 AI エクスペリエンスを実現する方法を学びます。データセットの選択からモデルの微調整までの手順を説明します。

ChatGPT は、OpenAI の強力な GPT (Generative Pretrained Transformer) ファミリから派生した、さまざまな質問やタスクに対して人間のような応答を提供できる最先端の会話型 AI モデルです。これは、 チャットボット、カスタマー サポート システム、コンテンツ生成などのさまざまなアプリケーションで広く使用されており、その主な目的はユーザーと自然言語で対話することです。 ChatGPT は、現実的で関連性の高いテキストベースの応答を生成する際の優れたパフォーマンスにより、多くの最新の AI システムに不可欠な部分となっています。

特定のプロジェクト要件に応えるカスタム ChatGPT を構築するには、対象のドメインに適したデータセットで事前トレーニングされたモデルを微調整します。これにより、モデルはターゲット ドメインのニュアンスを学習し、目的の会話型 AI エクスペリエンスにより密接に一致する応答を生成できるようになります。

OpenAI の GPT ビルダーの概要

OpenAI の GPT Builder は、アプリケーション固有のニーズに重点を置いて、独自にカスタマイズされた ChatGPT インスタンスを作成できるツールです。 GPT Builder は、強力な GPT モデルを活用することで、選択したデータセットで元のモデルを微調整し、プロジェクトに合わせて最適化された会話型 AI エクスペリエンスを実現するのに役立ちます。

GPT Builder は、データセットの処理、モデルのトレーニング、評価、展開のための使いやすいフレームワークを提供することで、ChatGPT モデルのカスタマイズを合理化します。これにより、構成を実験し、必要な調整を実行して、目的の出力を達成したり、モデルのパフォーマンスとリソースの制約のバランスを取ることができます。

画像出典: The Verge

開発環境のセットアップ

カスタム ChatGPT を構築する前に、適切な開発環境をセットアップすることが重要です。特定のハードウェアおよびソフトウェア構成を導入する必要があります。

ハードウェア要件

- マルチコア プロセッサと十分な量の RAM (最低 32 GB) を備えた強力なコンピュータ。

- 効率的なモデルのトレーニングと微調整のための CUDA サポートと少なくとも 12 GB VRAM を備えた NVIDIA GPU。より大きなモデルを操作するには、より強力な GPU またはマルチ GPU セットアップが必要になる場合があります。

ソフトウェア要件

次のソフトウェア コンポーネントをシステムにインストールします。

- Python 3.7 以降。オペレーティング システムに適切なバージョンをインストールしてください。

- GPU をサポートする TensorFlow ライブラリ (バージョン 2.x) のインストール。 TensorFlow は、GPT ベースのモデルを操作するための包括的なエコシステムを提供する、人気のあるオープンソースの機械学習ライブラリです。

- OpenAIライブラリ。この Python パッケージを使用すると、OpenAI の GPT モデルと API に簡単かつ簡単にアクセスして利用できるようになります。

- データ操作、処理、API 呼び出しに必要なその他の Python ライブラリ (Numpy、Pandas、リクエストなど)。

開発環境がセットアップされたら、OpenAI の GPT Builder を使用してカスタム ChatGPT インスタンスの構築を開始できます。次のセクションでは、データセットの選択と準備、モデルの構築と微調整、パフォーマンスのテストと評価、実際のアプリケーションへの展開に必要な手順を説明します。

データセットの選択と準備

カスタム ChatGPT モデルの成功は、微調整プロセス中に使用されるデータセットの品質と多様性に大きく依存します。適切なデータセットを選択することで、特定の要件を満たし、望ましいレベルのパフォーマンスを実現するモデルを作成できます。以下は、カスタム ChatGPT モデルをトレーニングするためのデータセットを選択して準備するのに役立つ手順です。

適切な会話データセットを選択する

最初のステップは、プロジェクトの目標に合致する適切な会話データセットを特定することです。データセットの選択にはいくつかのオプションがあります。

- 既存のデータセット: Cornell Movie Dialogs Corpus、Personal-Chat データセット、Stanford Question Answering Dataset (SQuAD) など、公開されている会話型データセットを使用してモデルをトレーニングできます。

- カスタム データセット: または、ドメインまたはユースケースに一致するカスタム データセットを作成することもできます。カスタマー サポートのチャット ログ、インタビュー、またはモデルの目的に合ったその他のコンテキストから会話を収集することを検討してください。このようなデータセットを作成するときは、プライバシーと倫理上の懸念を避けるために、データが匿名化され、適切に同意されていることを確認してください。

- データセットの組み合わせ: 標準データセットとカスタム データセットを組み合わせて、モデルをトレーニングするためのより豊富で多様な会話セットを作成することもできます。

データセットのクリーンアップと前処理

データセットをカスタム ChatGPT モデルにフィードする前に、データをクリーンアップして前処理することが重要です。このプロセスには、次のようないくつかの手順があります。

- 無関係なコンテンツや、広告や特殊文字などのノイズを削除します。

- トレーニング中にモデルを混乱させる可能性がある文法およびスペルの間違いを修正します。

- 統一性を維持するためにテキストを小文字に変換します。

- データセットをトークン化し、モデルが理解できる形式に変換します (文を単語またはサブワードに分割するなど)。

トレーニング データのフォーマットを設定する

クリーニングと前処理の後、OpenAI の GPT Builder の要件に従ってデータセットをフォーマットする必要があります。通常、チャットベースのモデルでは、会話をユーザーのステートメントとモデルの応答が交互に繰り返されるシーケンスとしてフォーマットする必要があります。各発言と応答のペアには明確にラベルを付ける必要があり、文や会話の始まりと終わりを示すために特別なトークンを使用する必要があります。たとえば、データセットにユーザー (U) とモデル (M) の間の会話が含まれている場合、次のようにフォーマットできます: ``` { "dialog": [ {"role": "user, {"role" : "アシスタント、{"役割": "ユーザー、{"役割": "アシスタント] } ``

適切なデータセットを選択し、データセットをクリーニングして前処理し、モデルの要件に従ってフォーマットすることで、強力で正確なカスタム ChatGPT モデルを構築するための強力な基盤を作成できます。

カスタムモデルの構築と微調整

データセットを準備したら、次のステップは、OpenAI の GPT Builder を使用してカスタム ChatGPT を構築し、微調整することです。次の手順は、モデルの構築と微調整のプロセスの概要を示しています。

モデルを初期化する

まず、OpenAI の GPT Builder を使用して GPT モデルを初期化します。パフォーマンスとリソースの要件に基づいて、 GPT-3 、 GPT-2 、さらにはより小さい GPT モデルなど、さまざまな GPT モデル サイズの中から選択できます。

事前トレーニングされたモデルの重みをロードする

OpenAI の GPT モデルから事前トレーニングされたモデルの重みを読み込みます。これらの重みは数十億のテキスト入力でトレーニングされており、カスタム モデルの強力な開始点となります。

トレーニングセットアップを準備する

カスタム ChatGPT モデルを微調整する前に、次のような必要なトレーニング パラメーターとハイパーパラメーターを指定してトレーニング環境をセットアップします。

- バッチ サイズ: モデルの重みの各更新に使用されるトレーニング サンプルの数。

- 学習率: モデルの重みを最適化するために使用されるステップ サイズ。

- エポック数: トレーニング ループがデータセット全体で反復される回数。

カスタムモデルを微調整する

トレーニング設定の準備ができたら、GPT Builder を使用して、準備したデータセットでカスタム ChatGPT モデルを微調整します。このプロセスでは、データセット内のパターンに基づいてモデルの重みを更新し、ChatGPT を特定のユースケースに合わせて調整します。

反復と最適化

ChatGPT モデルの微調整は反復的なプロセスです。複雑さや損失などのモデルのパフォーマンス指標を監視し、必要に応じてハイパーパラメータを調整します。より良い結果を得るには、さまざまな学習率とバッチ サイズを試したり、データセットを異なる方法で前処理したりする必要がある場合があります。

カスタム ChatGPT モデルを構築して微調整することで、ドメイン固有で関連性の高い、正確な応答をユーザーに提供する会話型 AI モデルを作成できます。

モデルのテストと評価

カスタム ChatGPT モデルを構築して微調整した後、そのパフォーマンスをテストして評価することが重要です。これにより、モデルが高品質の応答を提供し、プロジェクトの目標と一致することが保証されます。モデルをテストおよび評価するために実行できるいくつかの手順を次に示します。

評価指標を使用する

BLEU、ROUGE、METEOR などの定量的評価メトリクスを使用して、モデルが生成した応答の品質を評価できます。これらのメトリクスは、モデルの応答と人間が生成した参照応答の間の類似性を比較します。これらのメトリクスはモデルのパフォーマンスを評価するのに役立ちますが、応答のニュアンスや文脈上の関連性を常に捉えているとは限りません。

現実世界のテストを実施する

カスタム ChatGPT モデルを制御された環境内にデプロイすると、実際のパフォーマンスについての貴重な洞察が得られます。モデルと対話し、さまざまな質問、ステートメント、またはシナリオを提示し、その応答の品質、関連性、正確性を分析します。

手動評価を実行する

場合によっては、ドメインの専門家や対象ユーザーによる手動評価により、モデルのパフォーマンスに関する貴重な洞察が得られることがあります。これらの評価は、自動化されたメトリクスが見逃していた不一致を発見するのに役立ちます。さらに改善や改良が必要な領域を明らかにすることもできます。

反復と最適化

テストおよび評価フェーズ中に収集されたフィードバックと結果に基づいて、必要に応じてトレーニング セットアップ、データセット、またはトレーニング パラメーターを調整して、カスタム ChatGPT モデルを反復処理します。高性能のカスタム ChatGPT モデルを作成するには、継続的な反復と最適化が必要であることに注意してください。

モデルを徹底的にテスト、評価、改良することで、モデルが要件に厳密に適合していることを確認し、ユーザーに優れた会話エクスペリエンスを提供することができます。また、カスタム ChatGPT をソフトウェア ソリューションに統合する予定がある場合は、 AppMaster のようなプラットフォームを使用すると、 ノーコードの ユーザー フレンドリーなインターフェイスを通じて簡単に統合できます。

カスタム ChatGPT のデプロイ

カスタム ChatGPT モデルを構築して微調整した後、それを効果的に展開して、ユーザーがアクセスして操作できるようにすることが重要です。カスタム ChatGPT モデルをデプロイするには、次の手順に従います。

- ホスティング環境の選択: ローカル サーバー上でモデルをホストすることも、Google Cloud Platform (GCP)、 アマゾン ウェブ サービス (AWS) 、 Microsoft Azure などのサービスを使用してクラウド内でモデルをホストすることもできます。ホスティング環境を選択するときは、プロジェクトの要件、スケーラビリティのニーズ、予算を考慮してください。

- サーバーの構成: カスタム ChatGPT を実行するサーバー環境を作成および構成します。これには多くの場合、必要なソフトウェアの依存関係のインストール、適切な構成でのサーバーのセットアップ、認証および暗号化メカニズムによるサーバーの保護が含まれます。

- モデルをアップロードする: セキュア ファイル転送プロトコル (SFTP) 経由、またはクラウド プロバイダーのオブジェクト ストレージ サービス (Google Cloud Storage、Amazon S3、Azure Blob Storage など) を使用して、カスタム ChatGPT モデルを選択したホスティング環境に転送します。

- API 経由でモデルを公開する: ユーザーのリクエストを処理し、モデルから応答を取得するための API を作成します。これは、Python ベースのアプリケーション用の FastAPI、Django、または Flask などの標準フレームワークを通じて実現できます。適切に統合されていることを確認する前に、API の機能をテストしてください。

- パフォーマンスの監視: サーバー監視ツールとカスタム スクリプトを使用して、モデルのパフォーマンス、リソース使用量、稼働時間を定期的に監視します。過剰なリソースの消費、サービスの停止、モデルの動作の異常などの問題が発生した場合に通知するアラートを設定します。

- メンテナンスと更新: ソフトウェアの依存関係やセキュリティ パッチを定期的に更新し、ユーザーのフィードバックとパフォーマンス データに基づいてカスタム ChatGPT モデルを定期的に最適化することで、サーバー環境とモデルの実装が最新であることを確認します。

モデルと外部アプリケーションの統合

カスタム ChatGPT がデプロイされ、API 経由でアクセスできるようになると、チャットボット、カスタマー サポート システム、コンテンツ管理プラットフォームなどの外部アプリケーションと統合できます。カスタム ChatGPT を外部アプリケーションに統合するためのヒントをいくつか紹介します。

- 既存のプラグイン アーキテクチャを利用する: 多くの外部アプリケーションは、機能を拡張するプラグイン機能を提供します。カスタム ChatGPT の API と対話するこれらのプラットフォーム用のカスタム プラグインを開発して、既存のシステムへの最小限の変更でシームレスな統合を提供します。

- チャットボット フレームワークとの統合: ネイティブ API を使用するかカスタム統合を構築することにより、Microsoft Bot Framework、Dialogflow、Rasa などの一般的なチャットボット フレームワーク内にカスタム ChatGPT モデルを実装します。これにより、チャットボットがカスタム ChatGPT モデルの機能を活用できるようになります。

- CRM およびカスタマー サポート システムに接続する: API またはカスタム コネクタを使用して、カスタム ChatGPT モデルを 顧客関係管理 (CRM) システムおよび Zendesk や Salesforce などのカスタマー サポート プラットフォームと統合し、ケース処理やチケット解決などの高度な会話型 AI 機能を有効にします。 。

- テキストベースのインタラクションを超える: カスタム ChatGPT を Amazon Alexa や Google アシスタントなどの音声ベースのプラットフォームに接続し、音声テキスト変換およびテキスト読み上げ機能を使用してユーザーとの音声インタラクションを可能にすることで、カスタム ChatGPT の機能を強化します。 。

- AppMasterとの統合: AppMasterのno-codeプラットフォームを使用すると、カスタム ChatGPT モデルをプラットフォーム上に構築されたアプリケーションとシームレスに統合し、ソフトウェア ソリューションで会話型 AI を合理的に実装できます。これにより、アプリ内にチャット インターフェイスとインタラクティブな要素を組み込むことが効率化されます。

モデルを最適化してパフォーマンスを向上させる

カスタム ChatGPT モデルを最大限に活用するには、継続的な最適化が不可欠です。これらの戦略を使用してカスタム ChatGPT モデルを最適化し、パフォーマンスを向上させます。

- ユーザー フィードバックを監視する: カスタム ChatGPT モデルから生成されたユーザー フィードバックと応答に細心の注意を払ってください。モデルの改善が必要な領域を特定し、この情報を使用してデータセットをさらに微調整します。

- ハイパーパラメーターを調整する: 学習率、バッチ サイズ、トレーニング エポック数などのハイパーパラメーターを変更して実験し、カスタム ChatGPT モデルに最適な構成を見つけます。ハイパーパラメーターを微調整すると、モデルのパフォーマンスと効率が向上します。

- モデルの枝刈りを実装する: モデルのアーキテクチャ内の不要な接続とパラメーター (重み) を枝刈りすることで、カスタム ChatGPT モデルのサイズと複雑さを軽減します。これにより、高品質のパフォーマンスと出力を維持しながら、計算コストとリソース使用量を削減できます。

- 量子化を利用する: 量子化技術を使用すると、パフォーマンスを大幅に損なうことなく、モデル内の重みとアクティベーションの精度を下げることで、モデルをさらに最適化できます。これにより、パフォーマンスが向上し、待ち時間が短縮され、リソース消費が削減される可能性があります。

- 現実世界のテストを実行する: 現実世界のデータとシナリオを使用してモデルをテストし、新しい最適化と改善を明らかにします。これにより、カスタム ChatGPT モデルが常に最新の状態に保たれ、必要なレベルの精度と信頼性が得られます。

これらのガイドラインに従うことで、カスタム ChatGPT モデルのパフォーマンスと機能をさらに強化し、ユーザーとアプリケーションのニーズを確実に満たすことができます。

結論と次のステップ

このガイドでは、OpenAI の GPT Builder を使用して独自のカスタム ChatGPT を構築する概要を説明しました。カスタマイズされた会話型 AI モデルを作成することで、パフォーマンスが向上し、特定のユースケースをより正確に理解できるようになります。次のステップとして、機械学習、自然言語処理、モデル評価などの重要なトピックに慣れ、基礎となる概念を深く理解する必要があります。カスタム ChatGPT を継続的に反復および改善して、その効果を最大化し、その機能を微調整して、プロジェクトの要件をより適切に満たすことができます。

さらに、現場で利用可能なテクノロジーについてより広い視野を得るために、他の会話型 AI モデルやフレームワークの代替案を検討することも検討してください。オープンソース コミュニティに参加して、その経験から学び、その知識をカスタム ChatGPT の微調整と最適化に活用します。

最後に、Web、モバイル、バックエンド アプリケーションを作成するための強力なno-codeツールであるAppMasterなどのプラットフォームを利用して、カスタム ChatGPT をプロジェクトにシームレスに統合することを検討してください。これにより、対話型 AI の力をソフトウェア ソリューションのさまざまな側面に活用できるようになり、ユーザー エクスペリエンスが向上し、アプリケーションのパフォーマンスが最適化されます。

適切なアプローチと実験意欲があれば、独自のニーズに応え、進化し続ける AI とテクノロジーの世界でプロジェクトを目立たせる強力なカスタム ChatGPT を作成できます。

よくある質問

ChatGPT は、ユーザーと自然言語で対話し、質問に対して人間のような応答を返し、ディスカッションに参加し、さまざまなタスクを解決できる会話型 AI モデルです。

OpenAI の GPT Builder を使用すると、特定のデータセットで元の GPT モデルを微調整することでカスタム カスタマイズされた ChatGPT インスタンスを作成でき、プロジェクトの要件により適した最適化された会話型 AI エクスペリエンスを提供できます。

GPT Builder を使用するための開発環境をセットアップするには、強力なコンピューター、NVIDIA GPU、および Python、TensorFlow、OpenAI ライブラリなどの必要なソフトウェアが必要です。

カスタム ChatGPT を構築するには、適切なデータセットを選択することが重要です。既存の会話データセットを使用することも、独自の会話データセットを作成することもできます。モデルをトレーニングする前に、データセットを適切にクリーンアップ、前処理、およびフォーマットしてください。

カスタム ChatGPT モデルの微調整には、データセット上でモデルをトレーニングし、ハイパーパラメーターを調整し、目的のパフォーマンスが達成されるまでこのプロセスを繰り返すことが含まれます。

カスタム ChatGPT をテストして評価するには、BLEU、ROUGE、METEOR などのさまざまなメトリックを使用し、ユーザー インタラクションや手動評価を通じて実際のテストを実施できます。

はい、 APIまたはカスタム構築プラグインを通じてカスタム ChatGPT を外部アプリケーションと統合することができ、ChatGPT と他のシステム間のシームレスなコラボレーションが可能になります。

カスタム ChatGPT の最適化には、モデルの微調整、ハイパーパラメーターの調整、応答生成の最適化、およびプロジェクト固有の要件に基づくさらなるカスタマイズが含まれます。

AppMasterのno-codeプラットフォームを使用すると、カスタム ChatGPT モデルとプラットフォーム上に構築されたアプリケーションをシームレスに統合でき、ソフトウェア ソリューションに会話型 AI を実装する合理的な方法を提供します。