Inteligencja debugowania: porady i wskazówki dotyczące kodowania narzędzi AI

Opanuj sztukę debugowania narzędzi AI, korzystając z porad ekspertów i wskazówek dotyczących kodowania narzędzi AI. Zwiększ wydajność i dokładność aplikacji AI.

Debugowanie to kluczowy element tworzenia oprogramowania , systematyczny proces diagnozowania i naprawiania błędów, wąskich gardeł wydajności i innych problemów, które uniemożliwiają prawidłowe działanie oprogramowania. Jeśli chodzi o narzędzia sztucznej inteligencji (AI), złożoność debugowania wzrasta wielokrotnie ze względu na wyjątkowe wyzwania, jakie stwarzają te systemy oparte na danych.

W przeciwieństwie do tradycyjnego oprogramowania narzędzia AI w dużej mierze opierają się na jakości i zawiłościach danych, na których są szkolone. Obejmują one wyrafinowane algorytmy, które uczą się na podstawie tych danych i dokonują prognoz lub podejmują działania na podstawie zdobytej wiedzy. W związku z tym debugowanie sztucznej inteligencji wymaga technicznego zrozumienia programowania i inżynierii oprogramowania oraz znajomości konkretnej dziedziny sztucznej inteligencji – czy to uczenia maszynowego, głębokiego uczenia się, przetwarzania języka naturalnego czy innych.

U podstaw debugowania narzędzi AI leży dążenie do przejrzystości i niezawodności. Twórcy i inżynierowie AI starają się wyjaśnić „czarną skrzynkę” aplikacji AI, aby mieć pewność, że działają one zgodnie z oczekiwaniami i można im zaufać w przypadku zadań, do których zostały zaprojektowane. Obejmuje to rygorystyczne testowanie modeli sztucznej inteligencji, dokładną kontrolę potoków danych, walidację wyników i ciągłe monitorowanie wdrożonych aplikacji AI.

Aby skutecznie debugować narzędzia AI, należy poruszać się po złożonych warstwach abstrakcji — począwszy od wstępnego przetwarzania surowych danych, ekstrakcji funkcji i uczenia modeli, aż po dostrajanie hiperparametrów i wdrażanie modeli. Niezbędne jest metodyczne śledzenie źródła wszelkich nieoczekiwanych zachowań lub wyników, które mogą wynikać z wielu czynników, takich jak błędy algorytmiczne, uszkodzenie danych lub nadmierne dopasowanie modelu.

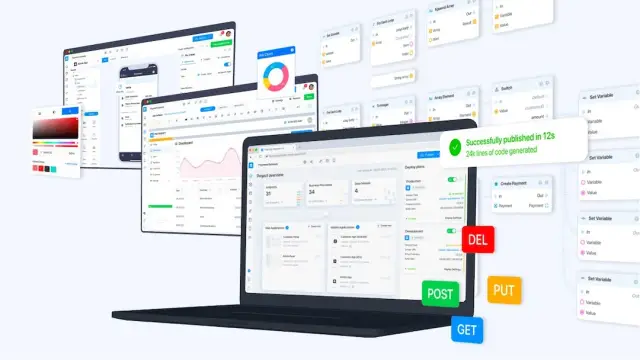

W tym skomplikowanym procesie wykrywania i korygowania kluczową rolę odgrywają narzędzia i praktyki, takie jak kontrola wersji, interaktywne środowiska programistyczne, narzędzia do wizualizacji i kodowanie modułowe. Co więcej, zastosowanie platformy niewymagającej kodu, takiej jak AppMaster , może ułatwić szybkie tworzenie i debugowanie narzędzi AI, zapewniając wizualne środowisko programistyczne i automatyzując wiele rutynowych zadań związanych z kodowaniem.

Kiedy zagłębiamy się w niuanse debugowania narzędzi AI, niezwykle ważne jest zrozumienie, że jest to iteracyjne i często złożone przedsięwzięcie, wymagające cierpliwości, umiejętności i bystrego analitycznego umysłu. W kolejnych sekcjach omówione zostaną wyzwania charakterystyczne dla sztucznej inteligencji, strategie skutecznego debugowania, rola automatyzacji i ludzkiej wiedzy, a także studia przypadków ze świata rzeczywistego, które podkreślają praktyczne zastosowania tych technik.

Zrozumienie wyzwań związanych z debugowaniem związanych ze sztuczną inteligencją

Systemy AI posiadają unikalne cechy, które sprawiają, że debugowanie jest szczególnie skomplikowaną sprawą. W przeciwieństwie do tradycyjnego oprogramowania, w którym błędy zazwyczaj wynikają z błędów logicznych lub problemów w bazie kodu, systemy AI przeplatają kod z danymi i algorytmami uczenia się. To połączenie wprowadza złożony zestaw wyzwań wymagających specjalistycznych technik debugowania.

Dane w dużej mierze determinują zachowanie modelu sztucznej inteligencji, na którym są trenowane. Dlatego debugowanie specyficzne dla sztucznej inteligencji często rozpoczyna się od dokładnego sprawdzenia tych danych. Częstym problemem jest obecność błędów w zbiorze uczącym, co może prowadzić do wypaczonych lub nieuczciwych przewidywań. Debugowanie wymaga następnie zidentyfikowania tych błędów oraz zrozumienia ich pierwotnych przyczyn i konsekwencji, aby naprawić problem bez wprowadzania nowych problemów.

Kolejnym znaczącym wyzwaniem w debugowaniu AI jest radzenie sobie ze stochastyczną naturą wielu algorytmów AI. Wyniki mogą się różnić nawet w przypadku tych samych danych wejściowych ze względu na przypadkowe inicjalizacje lub nieodłączną zmienność procesów szkoleniowych, takich jak opadanie w gradiencie stochastycznym. W związku z tym replikowanie problemów może być frustrująco trudne i należy zastosować metody statystyczne lub naprawić początkowe nasiona, aby zapewnić spójne zachowanie w celu dokładnego zbadania.

Nadmierne i niedostateczne dopasowanie to dwie strony tego samego medalu, które komplikują proces debugowania. Przeuczenie ma miejsce, gdy model jest zbyt złożony i uczy się zapamiętywać dane szkoleniowe, w tym szum i wartości odstające, zamiast uogólniać na podstawie wzorców. I odwrotnie, niedopasowanie wynika ze zbyt uproszczonych modeli, które nie oddają podstawowej struktury danych. Debugowanie tych problemów polega na poprawianiu złożoności modelu, często odbywającym się za pomocą technik sprawdzania krzyżowego i regularyzacji.

Istotnym wyzwaniem jest także interpretowalność modelu. Niektóre modele sztucznej inteligencji, takie jak głębokie sieci neuronowe, często nazywane są „czarnymi skrzynkami” ze względu na trudności w zrozumieniu dokładnego sposobu, w jaki podejmują one decyzje. Może to stanowić poważną przeszkodę w debugowaniu, ponieważ zrozumienie przyczyny wyjścia modelu jest niezwykle istotne, aby rozwiązać podstawowy problem. Techniki takie jak analiza ważności cech, destylacja modelu i wizualizacja warstw sieci mogą czasami rzucić światło na ciemne zakątki tych złożonych modeli.

Wreszcie szybko rozwijający się charakter narzędzi i struktur sztucznej inteligencji może sprawić, że debugowanie stanie się stale zmieniającym się celem. Dzięki częstym aktualizacjom i pojawiającym się najlepszym praktykom programiści muszą stale trzymać rękę na pulsie, aby mieć pewność, że nie napotkają problemów, które zostały już rozwiązane w nowszych wersjach, lub że ich narzędzia do debugowania są zgodne z najnowszymi osiągnięciami w tej dziedzinie.

Debugowanie narzędzi AI wymaga połączenia wiedzy dziedzinowej, metodycznej analizy i często odrobiny kreatywności. Jako twórca sztucznej inteligencji zrozumienie wyzwań związanych ze sztuczną inteligencją i przygotowanie się do metodycznego podejścia do nich może znacznie usprawnić proces debugowania, prowadząc do powstania bardziej niezawodnych aplikacji AI.

Konfigurowanie niezawodnego środowiska debugowania

Tworzenie narzędzi AI wymaga szczególnej dbałości o szczegóły na etapie tworzenia oraz w momencie pojawienia się problemów. Aby skutecznie debugować systemy AI, programiści potrzebują systematycznego środowiska, które poradzi sobie ze złożonością algorytmów i zbiorów danych AI. Poniższe techniki pomogą Ci w stworzeniu takiego środowiska, zwiększając Twoją zdolność identyfikowania, izolowania i rozwiązywania problemów w narzędziach AI.

Po pierwsze, utwórz obszar roboczy z kontrolą wersji dla swojego kodu i zestawów danych. Systemy kontroli wersji, takie jak Git, pomagają śledzić zmiany i umożliwiają przywracanie poprzednich stanów, jeśli zostaną wprowadzone nowe błędy. Ponadto narzędzi takich jak DVC (Data Version Control) można używać specjalnie do zarządzania zbiorami danych i wersjonowania ich, co ma kluczowe znaczenie, ponieważ dane często stanowią sedno problemów w systemach AI.

Upewnij się, że środowisko debugowania obejmuje weryfikację danych . Jakość danych jest najważniejsza; przed wprowadzeniem do modelu należy je sprawdzić pod kątem poprawności, spójności i braku stronniczości. Niezawodna konfiguracja będzie obejmować automatyczne skrypty, które sprawdzają integralność danych w regularnych odstępach czasu lub przed każdą sesją szkoleniową. Ten środek zapobiegawczy może pomóc zapobiec wielu problemom związanym z obsługą danych.

Kolejnym kluczowym czynnikiem jest skonfigurowanie śledzenia eksperymentu . Rozwój sztucznej inteligencji obejmuje wiele eksperymentów z różnymi hiperparametrami, zbiorami danych i architekturami modeli. Narzędzia takie jak MLflow, Weights & Biases lub TensorBoard umożliwiają śledzenie, wizualizację i porównywanie różnych eksperymentów. To systematyczne podejście pomaga w zrozumieniu zachowania modelu i określeniu, dlaczego pewne zmiany mogły prowadzić do błędów.

Ponadto wykorzystuj praktyki ciągłej integracji i testowania . Nie dotyczą one tylko tradycyjnego tworzenia oprogramowania; są one równie ważne w AI. Zautomatyzowane testy mogą zapewnić, że małe elementy systemu AI będą działać zgodnie z oczekiwaniami po zmianach. Serwery ciągłej integracji mogą automatycznie uruchamiać weryfikację danych, skrypty szkoleniowe i testy w przypadku nowych zatwierdzeń w bazie kodu, natychmiast powiadamiając Cię o problemach.

Narzędzia do wizualizacji stanowią integralną część debugowania aplikacji AI. Na przykład użycie narzędzi do wizualizacji wykresu obliczeniowego sieci neuronowej może pomóc w dostrzeżeniu, gdzie coś może pójść nie tak. Podobnie wizualizacja rozkładów danych, przewidywań modelu w porównaniu z rzeczywistymi wynikami i metryk szkoleniowych może uwypuklić rozbieżności, które mogą wskazywać na błędy.

Na koniec uzupełnij narzędzia technologiczne kompleksową dokumentacją zawierającą szczegółowe informacje na temat źródeł danych, architektur modeli, założeń, wyników eksperymentów i podjętych środków rozwiązywania problemów. Zasoby te okażą się nieocenione przy bieżącym debugowaniu oraz przyszłej konserwacji i aktualizacjach, zapewniając przejrzystość i ciągłość wysiłków programistycznych.

W połączeniu z tymi strategiami i możliwościami AppMasterno-code programiści mogą znacznie ograniczyć błędy systemu AI. Narzędzia wizualne platformy i automatyczne generowanie kodu upraszczają aspekty rozwoju sztucznej inteligencji, które w przeciwnym razie mogłyby być podatne na błędy, pomagając programistom w łatwym tworzeniu, wdrażaniu i utrzymywaniu wysokiej jakości aplikacji AI.

Strategie debugowania modeli uczenia maszynowego

Modele uczenia maszynowego (ML) mogą czasami sprawiać wrażenie czarnych skrzynek, co stwarza wyjątkowe wyzwania, jeśli chodzi o debugowanie. W przeciwieństwie do systematycznych błędów logicznych, które często są plagą tradycyjnego oprogramowania, w modelach ML występują problemy wynikające z jakości danych, architektury modelu i procedur szkoleniowych. Aby skutecznie debugować modele uczenia maszynowego, programiści muszą zastosować podejście strategiczne, uwzględniające te wyjątkowe złożoności.

Zacznij od solidnych podstaw: weryfikacja danych

Przed zagłębieniem się w obliczeniowe aspekty debugowania ważne jest, aby upewnić się, że dane są poprawne i dobrze przygotowane. Problemy takie jak brakujące wartości, niespójne formatowanie i wartości odstające mogą znacząco zniekształcić wydajność modelu. Ten pierwszy krok obejmuje rygorystyczne praktyki czyszczenia, normalizacji i powiększania danych, a także kontrole poprawności dystrybucji danych, które mogą uwypuklić potencjalne odchylenia lub błędy w zbiorze danych.

Uprość, aby wyjaśnić: redukcja modelu

Kiedy masz do czynienia z problematycznym modelem, zmniejsz jego złożoność, aby wyizolować problemy. Zmniejszając liczbę funkcji lub upraszczając architekturę, często można określić, gdzie coś idzie nie tak. Jeśli w zredukowanym modelu nadal występują problemy, przyczyną mogą być dane lub używane funkcje. I odwrotnie, jeśli uproszczenie rozwiąże problem, przyczyną może być złożoność oryginalnego modelu.

Wizualizuj, aby zrozumieć: analiza błędów

Wykorzystaj narzędzia do wizualizacji, aby analizować wzorce błędów. Wykreślanie krzywych uczenia się może wskazywać problemy z wydajnością modelu, takie jak nadmierne lub niedopasowanie. Badanie macierzy zamieszania i krzywych charakterystyki operacyjnej odbiornika (ROC) na potrzeby zadań klasyfikacyjnych pomaga zidentyfikować klasy, z którymi model ma problemy, sugerując obszary, które mogą wymagać bardziej szczegółowych funkcji lub dodatkowych danych w celu poprawy wydajności.

Zapewnij powtarzalność: kontrola wersji i śledzenie eksperymentów

Aby debugowanie było skuteczne, każdy eksperyment musi być powtarzalny. Systemów kontroli wersji, takich jak Git należy używać nie tylko do kodu, ale także do śledzenia zmian w zbiorach danych i konfiguracjach modeli. Narzędzia do śledzenia eksperymentów są niezbędne do porównywania różnych przebiegów, zrozumienia wpływu modyfikacji i systematycznego zbliżania się do udoskonalania modelu.

Tradycyjne techniki: testowanie jednostkowe i ciągła integracja

Stosowanie najlepszych praktyk inżynierii oprogramowania do rozwoju uczenia maszynowego jest często pomijane, ale ma kluczowe znaczenie. Implementuj testy jednostkowe dla potoków przetwarzania danych i poszczególnych komponentów modelu, aby upewnić się, że działają zgodnie z oczekiwaniami. Potoki ciągłej integracji (CI) pomagają w automatycznym uruchamianiu tych testów i wychwytywaniu błędów na początku cyklu programowania.

Debugowanie przez sondowanie: wykorzystanie narzędzi diagnostycznych

Narzędzia diagnostyczne są przydatne do głębszego wnikania w zachowanie modelu. Techniki takie jak analiza ważności cech i wykresy częściowych zależności pozwalają uzyskać wgląd w to, które cechy mają największy wpływ na przewidywania modelu. Ponadto destylacja modelu, podczas której prostszy model jest szkolony w celu przybliżenia przewidywań modelu złożonego, może uwydatnić aspekty danych szkoleniowych, na których koncentruje się oryginalny model, co może prowadzić do odkrycia błędnie oznakowanych danych lub nadmiernie uwydatnionych funkcji.

Potęga zespołów: łączenie modeli w celu uzyskania wglądu

Debugowanie może również pochodzić z zestawów modeli. Łącząc różne modele, można ocenić ich konsensus i zidentyfikować każdy indywidualny model, który znacząco odbiega od innych, co może być symptomatyczne dla problemu w ramach uczenia tego konkretnego modelu lub przetwarzania danych.

Debugowanie skoncentrowane na człowieku: angażuj ekspertów dziedzinowych

Podczas debugowania sztucznej inteligencji ludzie nie powinni być poza pętlą. Nawiąż kontakt z ekspertami dziedzinowymi, którzy rozumieją dane i mogą dostarczyć cennych informacji na temat tego, czy wyniki modelu mają sens. Mogą pomóc w identyfikacji niedokładności, które mogłyby pozostać niezauważone w przypadku wskaźników opartych wyłącznie na danych.

Iteracyjne doskonalenie jest kluczowe

Ostatecznie debugowanie modeli ML jest procesem iteracyjnym. Każda pętla umożliwia głębsze zrozumienie modelu i danych, z których się uczy. Strategie te dostarczają wskazówek, ale muszą być dostosowane do kontekstu konkretnego projektu i rodzaju opracowywanego modelu uczenia maszynowego. Pamiętaj, aby korzystać z platform no-code takich jak AppMaster, które oferują narzędzia pomagające usprawnić początkowe etapy rozwoju modelu i stanowią podstawę do dalszego debugowania i udoskonalania.

Najczęstsze pułapki i sposoby ich uniknięcia

W miarę jak sztuczna inteligencja staje się coraz bardziej złożona i zróżnicowana, programiści często stają przed unikalnymi wyzwaniami, które mogą wykoleić proces debugowania. Rozpoznanie i obejście tych pułapek ma kluczowe znaczenie dla tworzenia i utrzymywania skutecznych narzędzi sztucznej inteligencji. W tym miejscu zagłębiamy się w niektóre z najczęstszych pułapek związanych z debugowaniem narzędzi AI i przedstawiamy strategie ich unikania.

Ignorowanie generalizacji modelu

Jednym z najczęstszych problemów w rozwoju sztucznej inteligencji jest utworzenie modelu, który działa wyjątkowo dobrze na danych szkoleniowych, ale nie pozwala na uogólnianie na nowe, niewidoczne dane – nadmierne dopasowanie. Aby tego uniknąć , konieczne jest:

- Wykorzystaj kompleksowy zbiór danych odzwierciedlający rzeczywiste sytuacje, z którymi spotka się model.

- Stosuj techniki takie jak walidacja krzyżowa i regularyzacja.

- Stale testuj swoje modele w ramach walidacji i testowania zbiorów danych.

Przeoczenie jakości danych

Syf na wejściu, syf na wyjściu; ten truizm jest szczególnie istotny w przypadku sztucznej inteligencji. Zła jakość danych może całkowicie zniekształcić wydajność modelu. Aby ominąć tę pułapkę:

- Zapewnij dokładne czyszczenie i wstępne przetwarzanie danych.

- Zaimplementuj wykrywanie anomalii, aby wychwycić wartości odstające i nieprawidłowe.

- Skoncentruj się na gromadzeniu różnorodnych i reprezentatywnych danych, aby uniknąć uprzedzeń.

Brak kontroli wersji

Bez skrupulatnej kontroli wersji modeli AI i zbiorów danych odtwarzanie wyników i śledzenie zmian staje się uciążliwe. Wykorzystaj narzędzia do wersjonowania i zarządzania eksperymentami, aby:

- Prowadź szczegółowy dziennik wersji danych, parametrów modelu i zmian w kodzie.

- Zorganizuj proces programowania, aby zachować spójność między sesjami debugowania.

Niedocenianie złożoności modelu

Złożone modele nie zawsze są lepsze — czasami po prostu trudniej je debugować. Zacznij od prostego i stopniowo zwiększaj złożoność tylko w razie potrzeby. Opieranie się na prostszych modelach często może prowadzić do bardziej przejrzystych i możliwych do zinterpretowania wyników, dzięki czemu proces debugowania jest łatwiejszy w zarządzaniu.

Zaniedbanie narzędzi do debugowania

Rezygnacja ze stosowania specjalistycznych narzędzi do debugowania może prowadzić do znacznie wydłużenia czasu rozwiązywania problemów. Wykorzystaj platformy takie jak AppMaster, aby usprawnić programowanie dzięki narzędziom i funkcjom do wizualnego debugowania, które umożliwiają programistom wizualizację procesów biznesowych i przepływu danych bez konieczności zagłębiania się w kod.

Przewidując te typowe pułapki i wdrażając strategie przeciwdziałania im, programiści mogą złagodzić wiele frustracji często związanych z debugowaniem narzędzi AI i utorować drogę dla płynniejszych i wydajniejszych sesji debugowania.

Zautomatyzowane narzędzia a ludzka intuicja w debugowaniu AI

W sztucznej inteligencji debugowanie wykracza poza systematyczne błędy logiczne i obejmuje zróżnicowane interpretacje danych i zachowań modeli. Pojawienie się narzędzi do automatycznego debugowania sugeruje zmianę w podejściu programistów do rozwiązywania problemów w sztucznej inteligencji. Jednak pomimo wyrafinowanych osiągnięć ludzka intuicja pozostaje niezbędnym atutem w całym procesie debugowania. W tej sekcji zagłębiamy się w dynamiczną interakcję między zautomatyzowanymi narzędziami a ludzką intuicją na arenie debugowania sztucznej inteligencji.

Zautomatyzowane narzędzia do debugowania AI stanowią pierwszą linię obrony. Są biegli w identyfikowaniu prostych błędów, takich jak błędy składni, wyjątki i błędy czasu wykonania, które w przeciwnym razie mogłyby zająć cenny czas, jeśli zostaną rozwiązane ręcznie. Narzędzia te, oparte na samej sztucznej inteligencji, mogą usprawnić testowanie, szybko analizując ogromne tablice kodu w celu wykrycia anomalii. Technologie takie jak analityka predykcyjna i algorytmy wykrywania anomalii mają potencjał rozpoznawania wzorców i przewidywania problemów, zanim w pełni się ujawnią, skutecznie działając jako środek zapobiegawczy w procesie rozwiązywania problemów.

Jednak systemy sztucznej inteligencji definiuje ich złożoność i wyjątkowość; uczą się i dostosowują w oparciu o dane. Zautomatyzowane narzędzia mogą zawodzić w obliczu abstrakcyjnego charakteru problemów związanych ze sztuczną inteligencją, takich jak te związane z jakością danych, architekturą modelu lub subtelnościami dostrajania hiperparametrów. Tutaj wkracza ludzka intuicja i specjalistyczna wiedza. Twórcy ludzcy wnoszą do stołu swoją wiedzę techniczną, zniuansowane zrozumienie kontekstu, umiejętność stawiania hipotez na temat nieustrukturyzowanych problemów i umiejętności kreatywnego rozwiązywania problemów.

Czasami zwykła nieprzewidywalność sztucznej inteligencji wymaga od człowieka świadomego domysłu, aby wykorzenić mniej oczywiste rozbieżności. Na przykład, gdy model sztucznej inteligencji generuje nieoczekiwane wyniki, zautomatyzowane narzędzia mogą zgłosić anomalię, ale często to intuicja programistów prowadzi ich do podstawowej przyczyny — czy to problem z danymi szkoleniowymi, nadmiernym dopasowaniem modelu, czy też coś bardziej tajnego, np. subtelny błąd logiczny na etapie wstępnego przetwarzania danych.

Co więcej, nadzór człowieka ma kluczowe znaczenie przy interpretacji wyników automatycznego debugowania. Aby ustalić priorytety błędów, które warto wyeliminować, na podstawie ich potencjalnego wpływu na system, konieczna jest ludzka ocena. Co więcej, debugowanie systemów sztucznej inteligencji może wiązać się z kwestiami etycznymi – takimi jak naruszenia prywatności lub stronnicze wyniki – z którymi zautomatyzowane narzędzia z natury nie są w stanie sobie poradzić. Dzięki ludzkiej empatii i etycznemu rozumowaniu programiści są najlepiej przygotowani do poruszania się w tych wrażliwych obszarach.

Należy pamiętać, że zautomatyzowane narzędzia nie mają na celu zastąpienia ludzkich programistów, ale zwiększenie ich możliwości. Na przykład na platformie AppMaster zautomatyzowane narzędzia upraszczają proces programowania i debugowania no-code. Funkcje platformy umożliwiają wizualne debugowanie, umożliwiając programistom bardziej intuicyjną obserwację przepływów danych i ścieżek logicznych oraz interakcję z nimi. Tym samym AppMaster stanowi świadectwo synergii pomiędzy zautomatyzowanymi systemami i ludzką wiedzą, prezentując model wspólnego rozwiązywania problemów, który wykorzystuje mocne strony obu światów.

Chociaż zautomatyzowane narzędzia zapewniają wydajność i szybkość rutynowych zadań debugowania, nie negują potrzeby ludzkiej intuicji, która pozostaje kluczowa w radzeniu sobie ze zawiłościami systemów AI. Harmonijne połączenie zautomatyzowanego oprogramowania i wiedzy ludzkiej nie tylko przyspiesza proces debugowania, ale także zapewnia bardziej niezawodne i wydajne narzędzie AI w efekcie końcowym. W miarę ewolucji sztucznej inteligencji, ewoluować będą także metodologie i repozytoria narzędzi mających na celu objaśnienie jej złożoności – zawsze z elementem ludzkim w centrum uwagi.

Studia przypadków: debugowanie sztucznej inteligencji w działaniu

Nawet najbardziej skrupulatnie zaprojektowane systemy sztucznej inteligencji mogą wykazywać nieoczekiwane zachowanie lub błędy po wejściu w interakcję z rzeczywistymi danymi i scenariuszami. Analizując studia przypadków, programiści mogą uzyskać wgląd w skuteczne strategie debugowania, a tym samym udoskonalić swoje podejście do tworzenia bardziej niezawodnych i wydajnych narzędzi AI. Zagłębmy się w kilka godnych uwagi studiów przypadków, które rzucają światło na złożoność debugowania AI.

- Studium przypadku 1: Diagnozowanie nadmiernego dopasowania w modelu predykcyjnym: Firma zajmująca się sprzedażą detaliczną opracowała model uczenia maszynowego w celu prognozowania przyszłego popytu na produkty w oparciu o historyczne dane dotyczące sprzedaży. Jednak przewidywania modelu nie pokrywały się z rzeczywistymi wynikami. Deweloperzy odkryli, że model był nadmiernie dopasowywany na etapie uczenia, powodując hałas uczenia się i anomalie w danych szkoleniowych, a nie podstawowe wzorce. Zastosowali takie techniki, jak walidacja krzyżowa i wprowadzili parametr regularyzacji, aby złagodzić nadmierne dopasowanie, co zaowocowało modelem, który lepiej uogólnia niewidoczne dane.

- Studium przypadku 2: Eliminowanie błędów w danych w oprogramowaniu do rozpoznawania twarzy: Firma zajmująca się sztuczną inteligencją spotkała się z ostrym sprzeciwem opinii publicznej, gdy jej oprogramowanie do rozpoznawania twarzy wykazywało stronniczość i słabo radziło sobie z niektórymi grupami demograficznymi. Podczas debugowania zespół zdał sobie sprawę, że danym szkoleniowym brakuje różnorodności. Zbierając bardziej reprezentatywne dane i stosując algorytmy uczciwości, poprawili dokładność i zmniejszyli stronniczość swojego oprogramowania, demonstrując znaczenie jakości i różnorodności danych w szkoleniu modeli sztucznej inteligencji.

- Studium przypadku 3: Poprawa dokładności przetwarzania języka naturalnego: startup opracował narzędzie do przetwarzania języka naturalnego (NLP) , które nie klasyfikowało dokładnie opinii klientów. Proces debugowania ujawnił, że osadzanie słów użyte w modelu było niewystarczające, aby uchwycić kontekst pewnych terminów specyficznych dla branży. Startup znacznie zwiększył dokładność narzędzia w rozumieniu nastrojów klientów, dostosowując osadzanie słów i włączając dane specyficzne dla domeny do swoich zestawów szkoleniowych.

- Studium przypadku 4: Debugowanie algorytmów pojazdów autonomicznych: Firma specjalizująca się w pojazdach autonomicznych napotkała krytyczne problemy polegające na błędnym zinterpretowaniu znaków stopu w określonych warunkach pogodowych. Debugowanie ujawniło, że algorytmy wizyjne w zbyt dużym stopniu opierały się na wykrywaniu kolorów. Integrując bardziej kontekstowe wskazówki i techniki łączenia czujników, inżynierom udało się znacznie zwiększyć wiarygodność interpretacji znaków drogowych przez sztuczną inteligencję.

Każde studium przypadku podkreśla unikalny aspekt debugowania AI, podkreślając różnorodne wyzwania, jakie mogą napotkać programiści. Niezależnie od tego, czy chodzi o jakość zbioru danych, złożoność modelu, błędy algorytmów czy zdolność adaptacji systemu, rozpoznanie tych problemów i rozwiązanie tych problemów poprzez strategiczne debugowanie jest niezbędne. Chociaż studia przypadków dostarczają cennych lekcji, platformy takie jak AppMaster wspierają programistów, zmniejszając złożoność tworzenia i debugowania narzędzi AI, umożliwiając nawet osobom z niewielkim doświadczeniem w kodowaniu naukę i zastosowanie wniosków płynących z rzeczywistych wyzwań związanych ze sztuczną inteligencją.

Integracja technik debugowania z AppMaster

Podczas opracowywania narzędzi AI odpowiednie debugowanie jest niezbędne, aby zapewnić wydajność, niezawodność i dokładność aplikacji. Do tej pory programiści mają wiele technik radzenia sobie z tradycyjnymi scenariuszami debugowania. Sztuczna inteligencja stwarza jednak złożone wyzwania ze względu na jej charakter skoncentrowany na danych i często nieprzejrzyste procesy decyzyjne. Biorąc pod uwagę jego ogromny potencjał w zakresie upraszczania i ulepszania procesu programowania, integracja debugowania AI z platformami no-code takimi jak AppMaster, oferuje płynną i wydajną drogę do rozwiązania skomplikowanych problemów, które mogą wynikać z nieodłącznej złożoności sztucznej inteligencji.

AppMaster to platforma programistyczna no-code, która doskonale usprawnia tworzenie aplikacji internetowych, mobilnych i backendowych. Korzystając z AppMaster, programiści otrzymują potężny zestaw narzędzi, które mogą ulepszyć ich strategie debugowania AI:

- Wizualizacja: debugowanie sztucznej inteligencji często wymaga zrozumienia relacji między danymi i zachowania modelu. AppMaster zapewnia programistom narzędzia wizualne, takie jak projektant procesów biznesowych (BP) , które mogą przełożyć złożoną logikę na zrozumiałe i modyfikowalne komponenty wizualne. Jest to szczególnie przydatne w zastosowaniach AI, gdzie należy zwizualizować przepływy pracy i punkty decyzyjne, aby ocenić poprawność przetwarzania danych i wnioskowania o modelu AI.

- Testowanie automatyczne: debugowanie nie jest procesem jednorazowym – wymaga ciągłej ponownej oceny. Platforma zapewnia funkcje automatycznego testowania, które umożliwiają programistom skuteczne tworzenie i przeprowadzanie testów po każdej zmianie, zapewniając, że podstawowa funkcjonalność sztucznej inteligencji pozostanie nienaruszona i że wszelkie potencjalne regresje zostaną wykryte wcześnie.

- Modułowość: debugowanie AI może wymagać iteracyjnych zmian w niektórych częściach aplikacji, pozostawiając inne nietknięte. AppMaster promuje modułowość poprzez możliwość segmentowania aplikacji na różne mikrousługi. Obszary kokpitu narzędzia AI można wyizolować w celu ukierunkowanego debugowania bez utrudniania działania pełnej aplikacji.

- Integralność danych: narzędzia AI napędzające dane muszą zostać rygorystycznie sprawdzone. Błędy w danych nieuchronnie doprowadzą do błędnych zachowań AI. AppMaster zawiera mechanizmy zapewniające integralność danych, w tym wbudowane reguły sprawdzania poprawności, które mogą zapobiegać typowym problemom związanym z danymi, zanim przerodzą się one w większe, bardziej złożone problemy.

- Funkcje współpracy: Często debugowanie narzędzia AI wymaga wysiłku zespołowego. Środowisko współpracy platformy pozwala wielu programistom na jednoczesną pracę nad projektem, co ułatwia rozwiązywanie problemów w miarę ich pojawiania się i zbiorową weryfikację poprawek.

- Wdrożenie i hosting: Dzięki AppMaster programiści mogą wdrażać swoje aplikacje jednym kliknięciem. To szybkie wdrożenie umożliwia szybkie cykle iteracyjne w celu testowania i debugowania aplikacji AI w środowisku przejściowym lub produkcyjnym, zapewniając uwzględnienie scenariuszy ze świata rzeczywistego.

- Analityka i monitorowanie: monitorowanie wydajności aplikacji AI po wdrożeniu jest niezbędne do wykrywania anomalii, które mogą oznaczać błędy. AppMaster może oferować rozwiązania analityczne i monitorujące umożliwiające śledzenie zachowania aplikacji, dostarczając danych empirycznych przydatnych do ciągłego debugowania.

Co więcej, AppMasterno-code przyspiesza proces debugowania, wyodrębniając zawiłości kodu, umożliwiając programistom skupienie się na logice i wydajności swoich narzędzi AI zamiast grzęznąć w błędach składniowych lub strukturalnych. Zdolność platformy do automatycznego generowania dokumentacji i specyfikacji Open API również pomaga w procesie debugowania, zapewniając, że cały zespół jest zawsze na tej samej stronie w zakresie bieżącej kompilacji i zachowania narzędzia.

W procesie opracowywania narzędzi sztucznej inteligencji włączenie platform takich jak AppMaster stanowi świadectwo harmonijnego połączenia elastyczności no-code i wyrafinowanych podejść do debugowania sztucznej inteligencji. Ilustruje przyszłość rozwoju oprogramowania, w którym zawiłości związane z debugowaniem nie są wąskim gardłem, ale raczej zaaranżowaną częścią symfonii rozwojowej.

Wskazówki dotyczące wydajnego debugowania

Usprawnij swoje narzędzia do debugowania

Jednym z pierwszych kroków w kierunku wydajnego debugowania jest wyposażenie się w odpowiednie narzędzia. Będziesz potrzebować programów obsługujących złożone zbiory danych i algorytmy, takich jak interaktywne debugery, narzędzia do wizualnej analizy danych i zestawy testów automatycznych. Zintegrowane środowisko programistyczne (IDE), które oferuje wtyczki i rozszerzenia specyficzne dla sztucznej inteligencji, może zaoszczędzić czas i zwiększyć produktywność. Gdy narzędzia zostaną skonsolidowane w płynny przepływ pracy, umożliwią szybszą identyfikację i rozwiązywanie błędów.

Korzystaj z kontroli wersji

Kontrola wersji to nie tylko śledzenie zmian w kodzie; jest to również niezbędne do zarządzania zbiorami danych, na których działa sztuczna inteligencja. Platform takich jak Git można używać do zarządzania zarówno kodem, jak i danymi, umożliwiając lepsze śledzenie zmian i możliwość przywrócenia poprzedniego stanu, gdy coś pójdzie nie tak. Dodatkowo możesz rozgałęziać funkcje eksperymentalne lub transformacje danych, aby nie kolidowały z główną linią rozwoju.

Skutecznie ustalaj priorytety błędów

Nie wszystkie błędy są sobie równe. Niektóre znacząco wpływają na funkcjonalność, inne zaś mają minimalny wpływ na aplikację AI. Ocena i ustalanie priorytetów błędów na podstawie ich wagi i wpływu na wydajność oprogramowania ma kluczowe znaczenie dla utrzymania wydajnego przepływu pracy. Korzystanie z macierzy Eisenhowera, która dzieli zadania na pilne/ważne macierze, może pomóc w kategoryzowaniu i ustalaniu priorytetów problemów.

Automatyzuj powtarzalne zadania za pomocą skryptów

Debugowanie często obejmuje powtarzalne testy i kontrole. Pisząc skrypty automatyzujące te zadania, możesz zaoszczędzić cenny czas i ograniczyć błędy ludzkie. Skrypty mogą uruchamiać predefiniowane procedury debugowania, co pozwala skupić uwagę na bardziej skomplikowanych i unikalnych wyzwaniach związanych z debugowaniem. Narzędzia do ciągłej integracji mogą pomóc w automatycznym wyzwalaniu takich skryptów na podstawie zatwierdzeń kodu lub danych.

Dokumentuj wszystko rygorystycznie

Dokumentację często traktuje się później, ale szczegółowe zapisy dotyczące tego, co powinna robić każda część systemu AI, wraz z notatkami na temat błędów i poprawek z przeszłości, mogą uratować życie podczas debugowania. Ta praktyka umożliwia każdemu programiście szybkie zrozumienie decyzji podjętych wcześniej w cyklu rozwoju. Co więcej, dokumentowanie sesji debugowania może pomóc w zidentyfikowaniu powtarzających się problemów i zrozumieniu długoterminowego zachowania narzędzi AI.

Ustanów jasne kanały komunikacji

W środowisku zespołowym najważniejsza jest skuteczna komunikacja. Należy ustanowić jasne kanały zgłaszania, omawiania i rozwiązywania błędów. Obejmuje to regularne spotkania, zwięzłe formaty raportowania i wspólne pulpity nawigacyjne. Ponadto stworzenie kultury zachęcającej do otwartej dyskusji na temat błędów może promować bardziej oparte na współpracy i efektywne podejście do ich rozwiązywania.

Wykorzystaj automatyczne rejestrowanie i monitorowanie

Wdrożenie zautomatyzowanych narzędzi do rejestrowania i monitorowania może zapewnić spójny i obiektywny wgląd w zachowanie sztucznej inteligencji. Narzędzia te mogą wykrywać anomalie i problemy z wydajnością w czasie rzeczywistym, co jest niezbędne zarówno do natychmiastowego rozwiązywania problemów, jak i długoterminowej konserwacji. Co więcej, zaawansowane monitorowanie może pomóc w zidentyfikowaniu wzorców prowadzących do błędów, dostarczając cennych danych, aby zapobiec ich występowaniu w przyszłych cyklach rozwoju.

Użyj flag funkcji, aby zapewnić bezpieczniejsze wdrożenie

Wprowadzenie flag funkcji pozwala na stopniowe wdrażanie nowych funkcjonalności i kontrolę nad tym, kto uzyskuje do nich dostęp. Praktyka ta może ograniczyć wpływ niewykrytych błędów, udostępniając je początkowo niewielkiej grupie użytkowników. Co więcej, jeśli po wydaniu zostanie wykryty błąd, flagi funkcji umożliwiają łatwe wycofanie zmian bez wpływu na inne aspekty aplikacji AI.

Ciągłe uczenie się i adaptacja

Debugowanie to nie tylko naprawianie tego, co jest zepsute. Chodzi o uczenie się na błędach i doskonalenie procesów. Wydajny debuger będzie na bieżąco z nowymi narzędziami, technikami i platformami, które mogą uprościć i usprawnić przepływ pracy. Na przykład platformy takie jak AppMaster oferują rozwiązanie no-code, umożliwiające szybkie opracowywanie i wdrażanie narzędzi AI ze zintegrowanymi funkcjami debugowania i monitorowania, co znacznie zmniejsza zasoby wydawane na te zadania.

Utrzymywanie zdrowego sposobu myślenia o debugowaniu

Wreszcie, utrzymuj pozytywne i dociekliwe nastawienie. Postrzeganie błędów jako wyzwań, a nie problemów, może działać motywująco. Pamiętaj, że każdy błąd jest okazją do lepszego zrozumienia systemu AI i poprawy jego niezawodności. Zachowaj cierpliwość i zawsze podchodź do debugowania metodycznie, ale kreatywnie.

Wdrażając te wskazówki i stale udoskonalając procesy debugowania, możesz zapewnić płynniejszy i wydajniejszy przepływ pracy, co ostatecznie doprowadzi do opracowania niezawodnych i wydajnych aplikacji AI.

Utrzymanie narzędzi AI po debugowaniu

Po pomyślnym przejściu przez labirynt debugowania narzędzi AI podróż na tym się nie kończy. Podobnie jak precyzyjnie wykonany zegarek, narzędzia AI wymagają ciągłej konserwacji i nadzoru, aby zapewnić ich najwyższą wydajność. W tym miejscu zagłębiamy się w rozsądne podejście do utrzymywania narzędzi AI po rygorystycznym procesie debugowania, oferując strategie zabezpieczające Twoją inwestycję na przyszłość i zapewniające trwałe, spójne wyniki.

Ciągłe monitorowanie wydajności modelu

Modele sztucznej inteligencji są podatne na „dryfowanie modelu” w miarę ewolucji danych i okoliczności w świecie rzeczywistym. Konieczne jest wdrożenie mechanizmu ciągłego monitorowania wyników. Takie systemy ostrzegają programistów o potencjalnym spadku dokładności lub skuteczności, umożliwiając wprowadzenie korekt w odpowiednim czasie. To czujne podejście oznacza, że modele zachowują swoją przydatność i nadal dostarczają cennych spostrzeżeń.

Regularne aktualizacje modeli i zbiorów danych

Apetyt sztucznej inteligencji na dane jest nienasycony, a jej wydajność jest nierozerwalnie powiązana z jakością i ilością przyswajanych informacji. Dlatego kluczowe znaczenie ma dostarczanie mu świeżych, wysokiej jakości danych oraz ponowne przeglądanie i udoskonalanie modeli. W miarę pojawiania się nowych wzorców i zanikania starych narzędzia sztucznej inteligencji powinny ewoluować, aby dotrzymać kroku tym zmianom. Nie tylko zalecane jest okresowe dokształcanie się z wykorzystaniem aktualnych danych; konieczne jest utrzymanie konkurencyjności i efektywności.

Bieżące testowanie i walidacja

Chociaż naprawiłeś błędy w fazie debugowania, nie ma powodu, aby odkładać zestaw narzędzi testowych. Podobnie jak czujny strażnik, musisz stale testować i weryfikować swoje modele sztucznej inteligencji pod kątem nowych scenariuszy, przypadków brzegowych i zbiorów danych. Zautomatyzowane potoki testowania mogą tutaj znacznie pomóc, stając się Twoimi nieustannymi sojusznikami w utrzymaniu odporności i niezawodności narzędzi AI.

Śledzenie dokumentacji i wersji

Prowadzenie skrupulatnej dokumentacji to nie tylko zachowanie należytej staranności — to drogowskaz dla każdego, kto będzie w przyszłości wchodzić w interakcję z Twoim systemem. Przejrzyste zapisy zmian, decyzji i zmian w architekturze tworzą plan działania, który może pomóc zespołom konserwacyjnym, skrócić czas wdrażania nowych programistów i znacząco pomóc w przypadku pojawienia się nieoczekiwanych problemów.

Dostosowywanie się do opinii użytkowników i zmian rynkowych

Narzędzie AI, niezależnie od tego, jak zaawansowane technicznie, musi ostatecznie służyć potrzebom i rozwiązywać problemy swoich użytkowników. Uzyskiwanie informacji zwrotnych od użytkowników i reagowanie na nie ma ogromne znaczenie dla zapewnienia, że sztuczna inteligencja pozostanie istotna i skupiona na użytkowniku. Podobnie rynek, na którym działa, jest dynamiczny, a bycie na czele wymaga dostosowania sztucznej inteligencji do zmian regulacyjnych, presji konkurencyjnej i postępu technologicznego.

Wdrażanie kontroli etyki i stronniczości

Głęboki wpływ sztucznej inteligencji rozciąga się dalej na terytoria etyczne i potencjalne uprzedzenia. Bieżące audyty i kontrole mające na celu skorygowanie braku równowagi danych, usunięcie uprzedzeń i zapewnienie uczciwych i etycznych wyników to niepodlegający negocjacjom obowiązek opiekunów narzędzi AI.

Rola AppMaster

Platformy takie jak AppMaster mogą służyć jako cenne zasoby, zapewniając podstawę do szybkiego tworzenia aplikacji no-code i łatwej iteracji w utrzymaniu narzędzi AI po debugowaniu. Bezproblemowa integracja funkcji AI z tradycyjnymi komponentami aplikacji pomaga zrównoważyć innowacyjność i stabilność. Dzięki zautomatyzowanemu generowaniu kodu AppMaster pomaga zminimalizować koszty utrzymania, umożliwiając zespołom skupienie się na działaniach tworzących wartość dodaną, takich jak ulepszanie modelu i optymalizacja wydajności.

Przestrzegając tych strategii, możesz zapewnić stały poziom wydajności narzędzi AI, zachowując jednocześnie elastyczność i przygotowanie na ciągłą ewolucję w dziedzinie sztucznej inteligencji. Ten proaktywny plan konserwacji nie tylko ma na celu zachowanie funkcjonalności, ale także udoskonalanie i ulepszanie narzędzi AI, aby spełniały, a nawet przekraczały wymagania jutra.

Wniosek: plan działania zapewniający bezbłędne zastosowania sztucznej inteligencji

Podczas opracowywania narzędzi AI debugowanie jest nieodzowną częścią tworzenia inteligentnych i niezawodnych aplikacji. Jest to proces wymagający zarówno skrupulatnej dbałości o szczegóły techniczne, jak i szerokiego zrozumienia złożonych systemów. Kiedy zagłębiliśmy się w wyrafinowany świat debugowania AI, przekonaliśmy się, że nie chodzi tylko o naprawianie błędów. Jest to raczej okazja do optymalizacji wydajności, zwiększenia dokładności i ostatecznie zaufania tworzonym przez nas rozwiązaniom AI.

Plan działania zapewniający bezbłędne aplikacje AI jest jasny, ale wymaga poświęcenia i strategicznej realizacji. Zacznij od zrozumienia wyjątkowych wyzwań, jakie stwarzają systemy AI. Wykorzystaj zawiłości zachowań opartych na danych, uważnie obserwuj wydajność modelu i używaj debugowania jako soczewki, aby udoskonalić i zrozumieć niuanse swojej sztucznej inteligencji. Taktyki omówione w tym dyskursie, od skonfigurowania niezawodnego środowiska po wybór właściwych strategii debugowania, poprowadzą Cię do wydajnego przepływu pracy.

Narzędzia AI mogą być bardzo złożone i żadna pojedyncza podróż debugowania nie będzie taka sama. Dlatego istotne jest zachowanie poczucia elastyczności i ciągłego uczenia się. Bądź na bieżąco z najnowszymi trendami, narzędziami i metodologiami w debugowaniu AI. I pamiętaj, że element ludzki – Twoja intuicja i wiedza – zawsze będzie cennym atutem w połączeniu z inteligencją i automatyzacją zapewnianą przez platformy takie jak AppMaster. Tutaj znajdziesz równowagę pomiędzy zaawansowanymi możliwościami zautomatyzowanych narzędzi a wnikliwością doświadczonego programisty.

Wreszcie, nie należy lekceważyć konserwacji aplikacji AI po debugowaniu. Ciężko pracowałeś, aby osiągnąć stan z minimalną liczbą błędów i płynnym działaniem, dlatego ważne jest, aby to utrzymać poprzez konsekwentne monitorowanie, aktualizowanie i testowanie systemów.

Plan działania prowadzący do opanowania debugowania narzędzi AI nie jest ścieżką liniową, ale cyklem ciągłego doskonalenia. Wymaga synergii najnowocześniejszych technologii, takich jak rozwiązania no-code dostarczane przez AppMaster, oraz niezastąpionych umiejętności kreatywnego rozwiązywania problemów programistów. Postępując zgodnie z tym planem, programiści mogą zapewnić, że ich aplikacje AI nie tylko będą działać, ale będą osiągać szczyt swojego potencjału, zapewniając wartość i innowacje w dynamicznym technologicznie świecie.

FAQ

Debugowanie narzędzi AI wiąże się ze złożonymi zachowaniami opartymi na danych, co oznacza, że podczas debugowania należy wziąć pod uwagę jakość danych, architekturę modelu i procesy szkoleniowe.

Niektóre z typowych wyzwań obejmują nadmierne dopasowanie, niedopasowanie, błąd danych i radzenie sobie z niedeterministycznymi wynikami.

Niezawodne środowisko debugowania AI obejmuje kontrolę wersji kodu i danych, dokładną weryfikację danych oraz narzędzia do śledzenia i wizualizacji eksperymentów.

Strategie obejmują zastosowanie podejścia modułowego, uproszczenie modelu, wizualizację zachowania modelu i zastosowanie technik takich jak testy jednostkowe i ciągła integracja.

Chociaż zautomatyzowane narzędzia mogą znacznie wspomóc ten proces, ludzka intuicja odgrywa kluczową rolę w zrozumieniu kontekstu, interpretacji danych i podejmowaniu strategicznych decyzji.

AppMaster zapewnia platformę no-code, która upraszcza tworzenie i debugowanie aplikacji AI za pomocą narzędzi do debugowania wizualnego i automatycznego generowania kodu.

Możesz zachować wydajność, koncentrując się na odtwarzalności, porządkując dokumentację i nadając priorytet debugowaniu istotnych błędów.

Konserwacja po debugowaniu powinna obejmować ciągłe monitorowanie, regularne aktualizacje modelu i zbioru danych oraz ciągłe testowanie, aby zapobiec nowym problemom.

Tak, techniki sztucznej inteligencji można zastosować do automatyzacji niektórych aspektów procesu debugowania, takich jak wykrywanie anomalii i konserwacja predykcyjna.

Analiza rzeczywistych studiów przypadków może zapewnić wgląd w skuteczne strategie i typowe błędy, wyposażając Cię w praktyczną wiedzę na temat debugowania narzędzi AI.

Typowe pułapki obejmują zaniedbywanie jakości danych, ignorowanie stronniczości modelu, nadmierne komplikowanie modelu i brak weryfikacji wyników w porównaniu ze scenariuszami ze świata rzeczywistego.