Debugging Intelligence: Tipps und Tricks zum Codieren von KI-Tools

Meistern Sie die Kunst des Debuggens von KI-Tools mit Expertentipps und -tricks zum Codieren von KI-Tools. Verbessern Sie die Leistung und Genauigkeit Ihrer KI-Anwendungen.

Das Debuggen ist ein wichtiger Bestandteil der Softwareentwicklung , ein systematischer Prozess zur Diagnose und Behebung von Fehlern, Leistungsengpässen und anderen Problemen, die die ordnungsgemäße Funktion von Software verhindern. Wenn es um Tools für künstliche Intelligenz (KI) geht, erhöht sich die Komplexität des Debuggens aufgrund der einzigartigen Herausforderungen, die diese datengesteuerten Systeme mit sich bringen, um ein Vielfaches.

Im Gegensatz zu herkömmlicher Software verlassen sich KI-Tools weitgehend auf die Qualität und Komplexität der Daten, auf denen sie trainiert werden. Dabei handelt es sich um hochentwickelte Algorithmen, die aus diesen Daten lernen und auf der Grundlage ihrer Erkenntnisse Vorhersagen treffen oder Maßnahmen ergreifen. Folglich erfordert das Debuggen von KI ein technisches Verständnis der Programmierung und Softwareentwicklung sowie ein Verständnis des jeweiligen KI-Bereichs – sei es maschinelles Lernen, Deep Learning, Verarbeitung natürlicher Sprache oder andere.

Im Mittelpunkt des Debuggens von KI-Tools steht das Streben nach Transparenz und Zuverlässigkeit. KI-Entwickler und -Ingenieure sind bestrebt, den „Black-Box“-Charakter von KI-Anwendungen zu entmystifizieren, um sicherzustellen, dass sie wie erwartet funktionieren und man ihnen die Aufgaben anvertrauen kann, für die sie entwickelt wurden. Dazu gehören strenge Tests der KI-Modelle, eine gründliche Inspektion der Datenpipelines, die Validierung der Ergebnisse und eine kontinuierliche Überwachung der eingesetzten KI-Anwendungen.

Um KI-Tools effektiv zu debuggen, muss man durch komplexe Abstraktionsebenen navigieren – von der Vorverarbeitung von Rohdaten, der Merkmalsextraktion und dem Modelltraining bis hin zur Optimierung von Hyperparametern und der Modellbereitstellung. Es ist wichtig, die Quelle unerwarteten Verhaltens oder Ergebnisses methodisch aufzuspüren, die auf zahlreiche Faktoren wie Algorithmusfehler, Datenbeschädigung oder Modellüberanpassung zurückzuführen sein können.

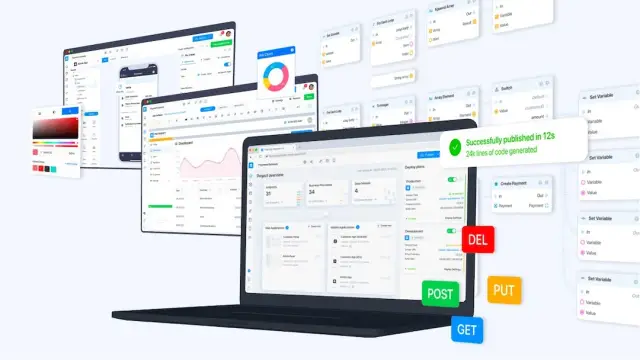

In diesem komplizierten Erkennungs- und Korrekturprozess spielen Tools und Praktiken wie Versionskontrolle, interaktive Entwicklungsumgebungen, Visualisierungstools und modulare Codierung eine entscheidende Rolle. Darüber hinaus kann der Einsatz einer No-Code- Plattform wie AppMaster die schnelle Entwicklung und Fehlerbehebung von KI-Tools erleichtern, indem eine visuelle Entwicklungsumgebung bereitgestellt und viele routinemäßige Codierungsaufgaben automatisiert werden.

Wenn wir tiefer in die Feinheiten des Debuggens von KI-Tools eintauchen, ist es wichtig zu verstehen, dass es sich um ein iteratives und oft komplexes Unterfangen handelt, das Geduld, Geschick und einen ausgeprägten analytischen Verstand erfordert. In den nächsten Abschnitten werden die besonderen Herausforderungen der KI, Strategien für effektives Debugging, die Rolle von Automatisierung und menschlicher Einsicht sowie Fallstudien aus der Praxis untersucht, die die praktischen Anwendungen dieser Techniken hervorheben.

KI-spezifische Debugging-Herausforderungen verstehen

KI-Systeme verfügen über einzigartige Eigenschaften, die das Debuggen zu einer besonders komplizierten Angelegenheit machen. Im Gegensatz zu herkömmlicher Software, bei der Fehler typischerweise auf Logikfehler oder Probleme in der Codebasis zurückzuführen sind, verknüpfen KI-Systeme Code mit Daten und Lernalgorithmen. Diese Mischung bringt eine Reihe komplexer Herausforderungen mit sich, die spezielle Debugging-Techniken erfordern.

Die Daten bestimmen weitgehend das Verhalten eines KI-Modells, auf dem es trainiert wird. Daher beginnt das KI-spezifische Debugging häufig mit einer gründlichen Untersuchung dieser Daten. Ein häufiges Problem ist das Vorhandensein von Verzerrungen im Trainingssatz, die zu verzerrten oder unfairen Vorhersagen führen können. Beim Debuggen müssen dann diese Vorurteile identifiziert und ihre Grundursachen und Auswirkungen verstanden werden, um das Problem zu beheben, ohne neue Probleme einzuführen.

Eine weitere große Herausforderung beim KI-Debugging ist der Umgang mit der stochastischen Natur vieler KI-Algorithmen. Die Ergebnisse können selbst bei denselben Eingabedaten aufgrund zufälliger Initialisierungen oder inhärenter Variabilität in Trainingsprozessen wie dem stochastischen Gradientenabstieg variieren. Folglich kann es frustrierend schwierig sein, Probleme zu reproduzieren, und man muss statistische Methoden anwenden oder anfängliche Seeds festlegen, um ein konsistentes Verhalten für eine gründliche Untersuchung sicherzustellen.

Überanpassung und Unteranpassung sind zwei Seiten derselben Medaille, die den Debugging-Prozess erschweren. Überanpassung tritt auf, wenn ein Modell zu komplex ist und lernt, sich die Trainingsdaten, einschließlich Rauschen und Ausreißer, zu merken, anstatt aus Mustern zu verallgemeinern. Umgekehrt resultiert eine unzureichende Anpassung aus zu vereinfachten Modellen, die die zugrunde liegende Struktur in den Daten nicht erfassen können. Um diese Probleme zu beheben, muss die Komplexität des Modells optimiert werden, was häufig durch Kreuzvalidierungs- und Regularisierungstechniken erfolgt.

Auch die Modellinterpretierbarkeit stellt eine erhebliche Herausforderung dar. Einige KI-Modelle, wie zum Beispiel tiefe neuronale Netze, werden oft als „Black Boxes“ bezeichnet, da es schwierig ist, genau zu verstehen, wie sie Entscheidungen treffen. Dies kann ein ernstes Hindernis beim Debuggen darstellen, da es wichtig ist, den Grund für die Ausgabe eines Modells zu verstehen, um das zugrunde liegende Problem zu beheben. Techniken wie die Analyse der Merkmalsbedeutung, die Modelldestillation und die Visualisierung von Netzwerkschichten können manchmal Licht in die dunklen Ecken dieser komplexen Modelle bringen.

Schließlich kann die schnelle Weiterentwicklung von KI-Tools und -Frameworks das Debuggen zu einem sich ständig verändernden Ziel machen. Aufgrund häufiger Updates und neuer Best Practices müssen Entwickler ständig auf dem Laufenden bleiben, um sicherzustellen, dass sie nicht mit Problemen konfrontiert werden, die bereits in neueren Versionen behoben wurden, oder dass ihre Debugging-Tools den neuesten Fortschritten auf diesem Gebiet entsprechen.

Das Debuggen von KI-Tools erfordert eine Mischung aus Fachwissen, methodischer Analyse und oft auch etwas Kreativität. Wenn Sie als KI-Entwickler diese KI-spezifischen Herausforderungen verstehen und sich darauf vorbereiten, sie methodisch anzugehen, kann dies den Debugging-Prozess erheblich verbessern und zu zuverlässigeren KI-Anwendungen führen.

Einrichten einer zuverlässigen Debugging-Umgebung

Die Entwicklung von KI-Tools erfordert viel Liebe zum Detail in der Erstellungsphase und bei auftretenden Problemen. Um KI-Systeme effektiv debuggen zu können, benötigen Entwickler eine systematische Umgebung, um die Komplexität von KI-Algorithmen und -Datensätzen zu bewältigen. Die folgenden Techniken unterstützen Sie bei der Einrichtung einer solchen Umgebung und verbessern Ihre Fähigkeit, Probleme innerhalb von KI-Tools zu identifizieren, zu isolieren und zu lösen.

Erstellen Sie zunächst einen versionierten Arbeitsbereich sowohl für Ihren Code als auch für Ihre Datensätze. Versionskontrollsysteme wie Git helfen dabei, Änderungen zu verfolgen und ermöglichen ein Rollback auf frühere Zustände, wenn neue Fehler auftreten. Darüber hinaus können Tools wie DVC (Data Version Control) gezielt für die Verwaltung und Versionierung von Datensätzen eingesetzt werden, was von entscheidender Bedeutung ist, da Daten oft im Mittelpunkt von Problemen in KI-Systemen stehen.

Stellen Sie sicher, dass Ihre Debugging-Umgebung eine Datenvalidierung umfasst. Die Datenqualität ist von größter Bedeutung. Bevor es in das Modell eingespeist wird, sollte es auf Richtigkeit, Konsistenz und Fehlen von Verzerrungen überprüft werden. Ein zuverlässiges Setup umfasst automatisierte Skripte, die die Datenintegrität in regelmäßigen Abständen oder vor jeder Trainingssitzung überprüfen. Diese vorbeugende Maßnahme kann dazu beitragen, viele Probleme im Zusammenhang mit der Datenverarbeitung zu vermeiden.

Ein weiterer wichtiger Faktor ist die Einrichtung der Experimentverfolgung . Die KI-Entwicklung umfasst viele Experimente mit verschiedenen Hyperparametern, Datensätzen und Modellarchitekturen. Mit Tools wie MLflow, Weights & Biases oder TensorBoard können Sie verschiedene Experimente verfolgen, visualisieren und vergleichen. Dieser systematische Ansatz hilft dabei, das Modellverhalten zu verstehen und herauszufinden, warum bestimmte Änderungen möglicherweise zu Fehlern geführt haben.

Nutzen Sie außerdem kontinuierliche Integrations- und Testpraktiken . Diese gelten nicht nur für die traditionelle Softwareentwicklung; Sie sind in der KI gleichermaßen wichtig. Durch automatisierte Tests kann sichergestellt werden, dass kleine Teile des KI-Systems nach Änderungen wie erwartet funktionieren. Continuous-Integration-Server können Ihre Datenvalidierung, Trainingsskripte und Tests automatisch für neue Commits in der Codebasis ausführen und Sie bei Problemen sofort benachrichtigen.

Visualisierungstools sind ein wesentlicher Bestandteil beim Debuggen von KI-Anwendungen. Wenn Sie beispielsweise Tools zur Visualisierung des Rechendiagramms eines neuronalen Netzwerks verwenden, können Sie erkennen, wo möglicherweise etwas schiefläuft. Ebenso kann die Visualisierung der Datenverteilungen, Modellvorhersagen im Vergleich zu tatsächlichen Ergebnissen und Trainingsmetriken Diskrepanzen hervorheben, die auf Fehler hinweisen können.

Ergänzen Sie die technologischen Tools schließlich durch eine umfassende Dokumentation , die Details zu Datenquellen, Modellarchitekturen, Annahmen, Experimentergebnissen und ergriffenen Fehlerbehebungsmaßnahmen enthält. Diese Ressource wird sich für das aktuelle Debugging sowie zukünftige Wartungsarbeiten und Aktualisierungen als unschätzbar wertvoll erweisen und für Klarheit und Kontinuität bei Ihren Entwicklungsbemühungen sorgen.

In Verbindung mit diesen Strategien und den no-code Funktionen von AppMaster können Entwickler KI-Systemfehler erheblich reduzieren. Die visuellen Tools und die automatisierte Codegenerierung der Plattform vereinfachen Aspekte der KI-Entwicklung, die ansonsten fehleranfällig sein könnten, und unterstützen Entwickler bei der einfachen Erstellung, Bereitstellung und Wartung hochwertiger KI-Anwendungen.

Debugging-Strategien für Modelle des maschinellen Lernens

Modelle des maschinellen Lernens (ML) können manchmal wie Black Boxes wirken und stellen besondere Herausforderungen beim Debuggen dar. Im Gegensatz zu systematischen Logikfehlern, die herkömmliche Software oft plagen, leiden ML-Modelle unter Problemen, die in der Datenqualität, der Modellarchitektur und den Trainingsverfahren wurzeln. Um ML-Modelle effektiv zu debuggen, müssen Entwickler einen strategischen Ansatz verfolgen, der diese einzigartigen Komplexitäten angeht.

Beginnen Sie mit einer soliden Grundlage: Datenüberprüfung

Bevor Sie sich mit den rechnerischen Aspekten des Debuggens befassen, müssen Sie unbedingt sicherstellen, dass Ihre Daten korrekt und gut vorbereitet sind. Probleme wie fehlende Werte, inkonsistente Formatierung und Ausreißer können die Leistung Ihres Modells erheblich beeinträchtigen. Dieser erste Schritt umfasst strenge Datenbereinigungs-, Normalisierungs- und Erweiterungspraktiken sowie Plausibilitätsprüfungen für die Datenverteilung, die potenzielle Verzerrungen oder Fehler im Datensatz aufzeigen könnten.

Vereinfachen zum Verdeutlichen: Modellreduktion

Wenn Sie mit einem problematischen Modell konfrontiert werden, reduzieren Sie dessen Komplexität, um Probleme zu isolieren. Indem Sie die Anzahl der Funktionen reduzieren oder die Architektur vereinfachen, können Sie oft genau erkennen, wo etwas schief geht. Wenn bei einem reduzierten Modell immer noch Probleme auftreten, liegt der Fehler möglicherweise an den Daten oder den verwendeten Funktionen. Wenn umgekehrt eine Vereinfachung das Problem löst, könnte die Komplexität des ursprünglichen Modells die Ursache sein.

Visualisieren, um zu verstehen: Fehleranalyse

Nutzen Sie Visualisierungstools, um Fehlermuster zu analysieren. Das Zeichnen von Lernkurven kann auf Probleme mit der Modellkapazität wie Über- oder Unteranpassung hinweisen. Die Untersuchung von Verwirrungsmatrizen und ROC-Kurven (Receiver Operating Characteristic) für Klassifizierungsaufgaben hilft dabei, Klassen zu identifizieren, mit denen das Modell Probleme hat, und schlägt Bereiche vor, die möglicherweise differenziertere Funktionen oder zusätzliche Daten erfordern, um die Leistung zu verbessern.

Stellen Sie die Reproduzierbarkeit sicher: Versionskontrolle und Experimentverfolgung

Damit das Debuggen effektiv ist, muss jedes Experiment reproduzierbar sein. Versionskontrollsysteme wie Git sollten nicht nur für Code, sondern auch zum Verfolgen von Änderungen in Ihren Datensätzen und Modellkonfigurationen verwendet werden. Tools zur Experimentverfolgung sind unerlässlich, um verschiedene Durchläufe zu vergleichen, die Auswirkungen von Änderungen zu verstehen und die Modellverbesserung systematisch anzugehen.

Traditionelle Techniken: Unit-Tests und kontinuierliche Integration

Die Anwendung bewährter Software-Engineering-Methoden auf die ML-Entwicklung wird oft übersehen, ist aber von entscheidender Bedeutung. Implementieren Sie Komponententests für Datenverarbeitungspipelines und einzelne Modellkomponenten, um sicherzustellen, dass sie wie erwartet funktionieren. Continuous-Integration-Pipelines (CI) helfen bei der automatischen Ausführung dieser Tests und erkennen Fehler frühzeitig im Entwicklungszyklus.

Debuggen durch Sondieren: Verwendung von Diagnosetools

Diagnosetools sind wertvoll, um tiefer in das Modellverhalten einzutauchen. Techniken wie die Merkmalswichtigkeitsanalyse und partielle Abhängigkeitsdiagramme geben Aufschluss darüber, welche Merkmale die Vorhersagen des Modells am stärksten beeinflussen. Darüber hinaus kann die Modelldestillation, bei der ein einfacheres Modell trainiert wird, um die Vorhersagen eines komplexen Modells anzunähern, hervorheben, auf welche Aspekte der Trainingsdaten sich das ursprüngliche Modell konzentriert, was dazu führen kann, dass falsch gekennzeichnete Daten oder überbetonte Merkmale entdeckt werden.

Die Kraft von Ensembles: Modelle für Einblicke kombinieren

Das Debuggen kann auch von Modellensembles ausgehen. Durch die Kombination verschiedener Modelle können Sie deren Konsens bewerten und jedes einzelne Modell identifizieren, das erheblich von anderen abweicht und möglicherweise ein Symptom für ein Problem bei der Schulung oder Datenverarbeitung dieses bestimmten Modells ist.

Menschenzentriertes Debugging: Binden Sie Fachexperten ein

Menschen sollten beim Debuggen von KI nicht außen vor bleiben. Arbeiten Sie mit Fachexperten zusammen, die die Daten verstehen und wertvolle Erkenntnisse darüber liefern können, ob Modellausgaben sinnvoll sind. Sie können dabei helfen, Ungenauigkeiten zu erkennen, die durch rein datengesteuerte Metriken möglicherweise unbemerkt bleiben.

Iterative Verbesserung ist der Schlüssel

Letztendlich ist das Debuggen von ML-Modellen ein iterativer Prozess. Jede Schleife vermittelt Ihnen ein tieferes Verständnis Ihres Modells und der Daten, aus denen es lernt. Diese Strategien bieten Richtlinien, müssen jedoch an den Kontext Ihres spezifischen Projekts und die Art des ML-Modells, das Sie entwickeln, angepasst werden. Denken Sie daran, no-code Plattformen wie AppMaster zu verwenden, die Tools bieten, die dabei helfen, die Anfangsphasen der Modellentwicklung zu rationalisieren und eine Grundlage für weiteres Debuggen und Verfeinern bieten.

Häufige Fallstricke und wie man sie vermeidet

Da die KI immer komplexer und vielfältiger wird, stehen Entwickler häufig vor einzigartigen Herausforderungen, die den Debugging-Prozess zum Scheitern bringen können. Das Erkennen und Umgehen dieser Fallstricke ist für die Entwicklung und Wartung effektiver KI-Tools von entscheidender Bedeutung. Hier gehen wir auf einige der häufigsten Fallstricke beim Debuggen von KI-Tools ein und stellen Strategien vor, um diese zu vermeiden.

Ignorieren der Modellverallgemeinerung

Eines der häufigsten Probleme bei der KI-Entwicklung ist die Erstellung eines Modells, das mit Ihren Trainingsdaten außergewöhnlich gut funktioniert, sich aber nicht auf neue, unsichtbare Daten übertragen lässt – Überanpassung. Um dies zu vermeiden , ist es wichtig:

- Nutzen Sie einen umfassenden Datensatz, der die realen Situationen widerspiegelt, denen das Modell begegnen wird.

- Setzen Sie Techniken wie Kreuzvalidierung und Regularisierung ein.

- Testen Sie Ihre Modelle ständig anhand von Validierungs- und Testdatensätzen.

Übersehen der Datenqualität

Müll rein, Müll raus; Diese Binsenweisheit ist in der KI besonders relevant. Eine schlechte Datenqualität kann die Leistung Ihres Modells völlig beeinträchtigen. Um diese Falle zu umgehen:

- Sorgen Sie für eine gründliche Datenbereinigung und Vorverarbeitung.

- Implementieren Sie die Anomalieerkennung, um Ausreißer und falsche Werte zu erkennen.

- Konzentrieren Sie sich auf die Erhebung vielfältiger und repräsentativer Daten, um Verzerrungen zu vermeiden.

Fehlende Versionskontrolle

Ohne eine sorgfältige Versionskontrolle Ihrer KI-Modelle und Datensätze wird die Reproduktion von Ergebnissen und die Nachverfolgung von Änderungen mühsam. Nutzen Sie Tools zur Versionierung und Experimentverwaltung, um:

- Führen Sie ein detailliertes Protokoll über Datenrevisionen, Modellparameter und Codeänderungen.

- Organisieren Sie Ihren Entwicklungsprozess, um die Konsistenz über alle Debugging-Sitzungen hinweg aufrechtzuerhalten.

Unterschätzung der Komplexität des Modells

Komplexe Modelle sind nicht immer überlegen – manchmal sind sie nur schwieriger zu debuggen. Beginnen Sie einfach und steigern Sie die Komplexität schrittweise nur bei Bedarf. Der Rückgriff auf einfachere Modelle kann häufig zu transparenteren und besser interpretierbaren Ergebnissen führen, wodurch der Debugging-Prozess einfacher zu verwalten ist.

Debugging-Tools vernachlässigen

Der Verzicht auf den Einsatz spezieller Debugging-Tools kann zu deutlich längeren Fehlerbehebungszeiten führen. Nutzen Sie Plattformen wie AppMaster, um die Entwicklung mit ihren visuellen Debugging-Tools und -Funktionen zu optimieren, die es Entwicklern ermöglichen, Geschäftsprozesse und Datenflüsse zu visualisieren, ohne sich in den Code zu vertiefen.

Durch die Antizipation dieser häufigen Fallstricke und die Implementierung von Strategien, um ihnen entgegenzuwirken, können Entwickler viele der Frustrationen abmildern, die häufig mit dem Debuggen von KI-Tools verbunden sind, und den Weg für reibungslosere und effizientere Debugging-Sitzungen ebnen.

Automatisierte Tools vs. menschliche Intuition beim KI-Debugging

In der KI geht das Debuggen über systematische Logikfehler hinaus und umfasst die differenzierte Interpretation von Daten und Modellverhalten. Der Aufstieg automatisierter Debugging-Tools deutet auf einen Wandel in der Herangehensweise von Entwicklern an die Problemlösung in der KI hin. Doch trotz hochentwickelter Fortschritte bleibt die menschliche Intuition während des gesamten Debugging-Prozesses ein unverzichtbarer Vorteil. Dieser Abschnitt befasst sich mit dem dynamischen Zusammenspiel zwischen automatisierten Tools und menschlicher Intuition im Bereich des KI-Debuggings.

Automatisierte Tools beim KI-Debugging dienen als erste Verteidigungslinie. Sie sind in der Lage, einfache Fehler wie Syntaxfehler, Ausnahmen und Laufzeitfehler zu identifizieren, die bei manueller Behebung ansonsten wertvolle Zeit in Anspruch nehmen könnten. Diese Tools, die selbst auf KI basieren, können Tests rationalisieren, indem sie große Codemengen schnell analysieren, um Anomalien zu lokalisieren. Technologien wie Predictive Analytics und Anomalieerkennungsalgorithmen bergen das Potenzial, Muster zu erkennen und Probleme vorherzusagen, bevor sie sich vollständig manifestieren, und wirken so effektiv als vorbeugende Maßnahme im Fehlerbehebungsprozess.

Allerdings zeichnen sich KI-Systeme durch ihre Komplexität und Einzigartigkeit aus; Sie lernen und passen sich auf der Grundlage von Daten an. Automatisierte Tools können ins Stocken geraten, wenn sie mit der abstrakten Natur von KI-Problemen konfrontiert werden, etwa solchen im Zusammenhang mit der Datenqualität, der Modellarchitektur oder den Feinheiten der Hyperparameter-Optimierung. Hier kommen menschliche Intuition und Fachwissen ins Spiel. Menschliche Entwickler bringen ihr technisches Wissen, ihr differenziertes Verständnis des Kontexts, ihre Fähigkeit, Hypothesen über unstrukturierte Probleme aufzustellen, und ihre kreativen Fähigkeiten zur Problemlösung ein.

Manchmal erfordert die schiere Unvorhersehbarkeit der KI das fundierte Raten eines Menschen, um weniger offensichtliche Unstimmigkeiten auszumerzen. Wenn beispielsweise ein KI-Modell unerwartete Ergebnisse generiert, können automatisierte Tools die Anomalie melden, aber oft ist es die Intuition der Entwickler, die sie zur zugrunde liegenden Ursache führt – sei es ein Problem mit Trainingsdaten, eine Überanpassung des Modells oder etwas Heimlicheres wie ein subtiler Logikfehler in der Datenvorverarbeitungsphase.

Darüber hinaus ist die menschliche Aufsicht bei der Interpretation der Ergebnisse des automatisierten Debuggings von entscheidender Bedeutung. Es ist menschliches Urteilsvermögen erforderlich, um anhand ihrer potenziellen Auswirkungen auf das System zu priorisieren, welche Fehler es wert sind, verfolgt zu werden. Darüber hinaus kann das Debuggen von KI-Systemen ethische Überlegungen aufwerfen – etwa Datenschutzverletzungen oder voreingenommene Ergebnisse –, für deren Bewältigung automatisierte Tools von Natur aus nicht geeignet sind. Mit ihrem menschlichen Einfühlungsvermögen und ihrem ethischen Denken sind Entwickler am besten in der Lage, sich in diesen sensiblen Bereichen zurechtzufinden.

Es ist wichtig zu erkennen, dass automatisierte Tools nicht darauf abzielen, menschliche Entwickler zu ersetzen, sondern ihre Fähigkeiten zu erweitern. Innerhalb der AppMaster Plattform vereinfachen beispielsweise automatisierte Tools den no-code Entwicklungs- und Debugging-Prozess. Die Funktionen der Plattform ermöglichen visuelles Debugging und ermöglichen es Entwicklern, Datenflüsse und Logikpfade intuitiver zu beobachten und mit ihnen zu interagieren. Somit ist AppMaster ein Beweis für die Synergie zwischen automatisierten Systemen und menschlichen Erkenntnissen und präsentiert ein kooperatives Problemlösungsmodell, das die Stärken beider Welten nutzt.

Während automatisierte Tools für Effizienz und Geschwindigkeit bei routinemäßigen Debugging-Aufgaben sorgen, machen sie die menschliche Intuition nicht überflüssig, die für den Umgang mit den Feinheiten von KI-Systemen nach wie vor von entscheidender Bedeutung ist. Eine harmonische Mischung aus automatisierter Software und menschlichem Fachwissen beschleunigt nicht nur den Debugging-Prozess, sondern gewährleistet auch ein zuverlässigeres und leistungsfähigeres KI-Tool als Endergebnis. Mit der Weiterentwicklung der KI entwickeln sich auch die Methoden und Repositories der Tools weiter, die darauf abzielen, ihre Komplexität zu entmystifizieren – immer mit dem menschlichen Element im Mittelpunkt.

Fallstudien: Debuggen von KI in Aktion

Selbst die sorgfältigsten KI-Systeme können unerwartetes Verhalten oder Fehler zeigen, wenn sie mit realen Daten und Szenarien interagieren. Durch die Untersuchung von Fallstudien können Entwickler Einblicke in erfolgreiche Debugging-Strategien gewinnen und so ihren Ansatz zur Entwicklung zuverlässigerer und leistungsfähigerer KI-Tools verfeinern. Schauen wir uns einige bemerkenswerte Fallstudien an, die die Komplexität des KI-Debuggings beleuchten.

- Fallstudie 1: Diagnose von Überanpassung in einem Vorhersagemodell: Ein Einzelhandelsunternehmen hat ein maschinelles Lernmodell entwickelt, um die zukünftige Produktnachfrage auf der Grundlage historischer Verkaufsdaten vorherzusagen. Die Vorhersagen des Modells stimmten jedoch nicht mit den tatsächlichen Ergebnissen überein. Die Entwickler stellten fest, dass das Modell während der Trainingsphase überangepasst war und Rauschen und Anomalien in den Trainingsdaten und nicht in den zugrunde liegenden Mustern lernte. Sie nutzten Techniken wie die Kreuzvalidierung und führten einen Regularisierungsparameter ein, um eine Überanpassung abzuschwächen, was zu einem Modell führte, das besser auf unsichtbare Daten verallgemeinert.

- Fallstudie 2: Bekämpfung von Datenverzerrungen in Gesichtserkennungssoftware: Ein KI-Unternehmen sah sich öffentlicher Kritik ausgesetzt, als seine Gesichtserkennungssoftware Verzerrungen aufwies und bei bestimmten demografischen Gruppen schlecht abschnitt. Beim Debuggen stellte das Team fest, dass es den Trainingsdaten an Diversität mangelte. Durch das Sammeln repräsentativerer Daten und den Einsatz von Fairness-Algorithmen verbesserten sie die Genauigkeit und reduzierten Verzerrungen in ihrer Software, was die Bedeutung von Datenqualität und -vielfalt beim Training von KI-Modellen demonstrierte.

- Fallstudie 3: Verbesserung der Genauigkeit der Verarbeitung natürlicher Sprache: Ein Startup entwickelte ein Tool zur Verarbeitung natürlicher Sprache (NLP) , das Kundenfeedback nicht genau klassifizierte. Der Debugging-Prozess ergab, dass die im Modell verwendeten Worteinbettungen nicht ausreichten, um den Kontext bestimmter branchenspezifischer Begriffe zu erfassen. Das Startup verbesserte die Genauigkeit des Tools beim Verständnis der Kundenstimmung erheblich, indem es die Worteinbettungen individuell anpasste und domänenspezifische Daten in seine Trainingssätze einbezog.

- Fallstudie 4: Debuggen von Algorithmen für autonome Fahrzeuge: Ein auf autonome Fahrzeuge spezialisiertes Unternehmen stieß auf kritische Probleme, bei denen das Auto bei bestimmten Wetterbedingungen Stoppschilder falsch interpretierte. Beim Debuggen stellte sich heraus, dass sich die Bildverarbeitungsalgorithmen zu stark auf die Farberkennung verließen. Durch die Integration kontextbezogener Hinweise und Sensorfusionstechniken konnten die Ingenieure die Interpretation von Verkehrszeichen durch die KI deutlich zuverlässiger machen.

Jede Fallstudie betont einen einzigartigen Aspekt des KI-Debuggings und verdeutlicht die vielfältigen Herausforderungen, denen Entwickler begegnen können. Ob es um die Qualität von Datensätzen, die Komplexität des Modells, Algorithmusverzerrungen oder die Anpassungsfähigkeit eines Systems geht, das Erkennen und Beheben dieser Probleme durch strategisches Debugging ist von entscheidender Bedeutung. Während Fallstudien wertvolle Erkenntnisse liefern, unterstützen Plattformen wie AppMaster Entwickler, indem sie die Komplexität beim Erstellen und Debuggen von KI-Tools reduzieren, sodass selbst diejenigen mit wenig Programmiererfahrung die Lehren aus realen KI-Herausforderungen lernen und anwenden können.

Integration von Debugging-Techniken mit AppMaster

Bei der Entwicklung von KI-Tools ist ein ordnungsgemäßes Debugging unerlässlich, um die Leistung, Zuverlässigkeit und Genauigkeit Ihrer Anwendungen sicherzustellen. Mittlerweile verfügen Entwickler über viele Techniken zur Bewältigung herkömmlicher Debugging-Szenarien. Allerdings bringt KI aufgrund ihres datenzentrierten Charakters und der oft undurchsichtigen Entscheidungsprozesse komplexe Herausforderungen mit sich. Angesichts des enormen Potenzials zur Vereinfachung und Verbesserung des Entwicklungsprozesses bietet die Integration des KI-Debuggings in no-code Plattformen wie AppMaster einen nahtlosen und effizienten Weg zur Lösung der komplizierten Probleme, die sich aus der inhärenten Komplexität der KI ergeben können.

AppMaster ist eine no-code Entwicklungsplattform, die sich durch die Rationalisierung der Erstellung von Web-, Mobil- und Backend-Anwendungen auszeichnet. Durch die Verwendung von AppMaster erhalten Entwickler eine Reihe leistungsstarker Tools, die ihre KI-Debugging-Strategien unterstützen können:

- Visualisierung: Das Debuggen von KI erfordert oft ein Verständnis der Datenbeziehungen und des Modellverhaltens. AppMaster stellt Entwicklern visuelle Tools wie den Business Process (BPs) Designer zur Verfügung, mit denen komplexe Logik in verständliche und modifizierbare visuelle Komponenten übersetzt werden kann. Dies ist besonders nützlich bei KI-Anwendungen, bei denen Arbeitsabläufe und Entscheidungspunkte visualisiert werden müssen, um die Korrektheit der Datenverarbeitung und der KI-Modellinferenz zu beurteilen.

- Automatisiertes Testen: Das Debuggen ist kein einmaliger Prozess – es erfordert eine kontinuierliche Neubewertung. Die Plattform bietet automatisierte Testfunktionen, die es Entwicklern ermöglichen, Tests nach jeder Änderung effizient zu erstellen und auszuführen und so sicherzustellen, dass die Kernfunktionalität der KI intakt bleibt und mögliche Rückschritte frühzeitig erkannt werden.

- Modularität: Das KI-Debugging erfordert möglicherweise eine iterative Überarbeitung bestimmter Anwendungsteile, während andere unberührt bleiben. AppMaster fördert die Modularität durch seine Fähigkeit, Anwendungen in verschiedene Microservices zu segmentieren. Cockpitbereiche eines KI-Tools können für gezieltes Debuggen isoliert werden, ohne den Betrieb der gesamten Anwendung zu beeinträchtigen.

- Datenintegrität: Die datenbasierten KI-Tools müssen streng validiert werden. Fehler in den Daten führen unweigerlich zu fehlerhaftem KI-Verhalten. AppMaster umfasst Mechanismen zur Gewährleistung der Datenintegrität, einschließlich integrierter Validierungsregeln, die typischen datenbezogenen Problemen vorbeugen können, bevor sie zu größeren, komplexeren Problemen führen.

- Funktionen für die Zusammenarbeit: Das Debuggen eines KI-Tools ist oft eine Teamarbeit. Die kollaborative Umgebung der Plattform ermöglicht es mehreren Entwicklern, gleichzeitig an dem Projekt zu arbeiten, was die Fehlerbehebung bei auftauchenden Problemen und die gemeinsame Validierung von Korrekturen erleichtert.

- Bereitstellung und Hosting: Mit AppMaster können Entwickler ihre Anwendungen per Knopfdruck bereitstellen. Diese schnelle Bereitstellung ermöglicht schnelle Iterationszyklen zum Testen und Debuggen von KI-Anwendungen in einer Staging- oder produktionsähnlichen Umgebung und stellt so sicher, dass reale Szenarien berücksichtigt werden.

- Analyse und Überwachung: Nach der Bereitstellung ist es wichtig, die Leistung einer KI-Anwendung im Auge zu behalten, um Anomalien zu erkennen, die auf Fehler hinweisen können. AppMaster kann Analyse- und Überwachungslösungen anbieten, um das Verhalten der Anwendung zu verfolgen und empirische Daten bereitzustellen, die für laufende Debugging-Bemühungen nützlich sind.

Darüber hinaus beschleunigt die no-code Natur von AppMaster den Debugging-Prozess durch die Abstraktion der Feinheiten des Codes, sodass sich Entwickler auf die Logik und Leistung ihrer KI-Tools konzentrieren können, anstatt sich durch Syntax- oder Strukturfehler zu verzetteln. Die Fähigkeit der Plattform, Dokumentation und Open-API-Spezifikationen automatisch zu generieren, hilft auch beim Debugging-Prozess, indem sie sicherstellt, dass das gesamte Team hinsichtlich des aktuellen Builds und Verhaltens des Tools immer auf dem gleichen Stand ist.

Auf dem Weg der KI-Tool-Entwicklung ist die Einbindung von Plattformen wie AppMaster ein Beweis für die harmonische Mischung aus no-code Agilität und ausgefeilten KI-Debugging-Ansätzen. Es veranschaulicht die Zukunft der Softwareentwicklung, in der die Feinheiten des Debuggens kein Flaschenhals, sondern vielmehr ein orchestrierter Teil der Entwicklungssymphonie sind.

Tipps für effiziente Debugging-Workflows

Optimieren Sie Ihre Debugging-Tools

Einer der ersten Schritte zu einem effizienten Debugging-Workflow besteht darin, sich mit den richtigen Tools auszustatten. Sie benötigen Programme, die mit komplexen Datensätzen und Algorithmen umgehen können, z. B. interaktive Debugger, visuelle Datenanalysetools und automatisierte Testsuiten. Eine integrierte Entwicklungsumgebung (IDE), die KI-spezifische Plugins und Erweiterungen bietet, kann Zeit sparen und die Produktivität steigern. Wenn Tools in einem nahtlosen Workflow konsolidiert werden, ermöglichen sie eine schnellere Identifizierung und Behebung von Fehlern.

Nutzen Sie die Versionskontrolle

Bei der Versionskontrolle geht es nicht nur darum, Codeänderungen zu verfolgen; Es ist auch wichtig für die Verwaltung der Datensätze, mit denen Ihre KI arbeitet. Plattformen wie Git können zum Verwalten von Code und Daten verwendet werden, was eine bessere Verfolgung von Änderungen und die Möglichkeit ermöglicht, bei einem Fehler auf einen früheren Zustand zurückzusetzen. Darüber hinaus können Sie experimentelle Funktionen oder Datentransformationen verzweigen, damit diese die Hauptentwicklungslinie nicht beeinträchtigen.

Priorisieren Sie Fehler effektiv

Nicht alle Fehler sind gleich. Einige wirken sich erheblich auf die Funktionalität aus, während andere nur minimale Auswirkungen auf die KI-Anwendung haben. Die Bewertung und Priorisierung von Fehlern basierend auf ihrer Schwere und Auswirkung auf die Leistung der Software ist für die Aufrechterhaltung eines effizienten Arbeitsablaufs von entscheidender Bedeutung. Die Verwendung der Eisenhower-Matrix, die Aufgaben in dringende/wichtige Matrizen unterteilt, kann dabei helfen, Probleme zu kategorisieren und zu priorisieren.

Automatisieren Sie sich wiederholende Aufgaben mit Skripten

Das Debuggen umfasst häufig sich wiederholende Tests und Überprüfungen. Durch das Schreiben von Skripten zur Automatisierung dieser Aufgaben können Sie wertvolle Zeit sparen und menschliche Fehler reduzieren. Skripte können vordefinierte Debugging-Prozeduren durchlaufen, sodass Sie sich auf die komplexeren und einzigartigeren Debugging-Herausforderungen konzentrieren können. Mit Tools für die kontinuierliche Integration können Sie solche Skripte automatisch auf der Grundlage von Code- oder Daten-Commits auslösen.

Dokumentieren Sie alles sorgfältig

Die Dokumentation wird oft als nachträglicher Gedanke behandelt, aber detaillierte Aufzeichnungen darüber, was jeder Teil Ihres KI-Systems tun sollte, zusammen mit Notizen zu früheren Fehlern und Korrekturen, können beim Debuggen lebensrettend sein. Diese Vorgehensweise ermöglicht es jedem Entwickler, Entscheidungen, die zu einem früheren Zeitpunkt im Entwicklungszyklus getroffen wurden, schnell zu verstehen. Darüber hinaus kann die Dokumentation von Debugging-Sitzungen dabei helfen, wiederkehrende Probleme zu erkennen und das langfristige Verhalten Ihrer KI-Tools zu verstehen.

Richten Sie klare Kommunikationskanäle ein

In einer Teamumgebung ist effektive Kommunikation von größter Bedeutung. Es müssen klare Kanäle für die Meldung, Diskussion und Lösung von Fehlern eingerichtet werden. Dazu gehören regelmäßige Meetings, prägnante Berichtsformate und gemeinsame Dashboards. Darüber hinaus kann die Schaffung einer Kultur, die eine offene Diskussion über Fehler fördert, einen kollaborativeren und effizienteren Ansatz zur Lösung dieser Fehler fördern.

Nutzen Sie automatisierte Protokollierung und Überwachung

Die Implementierung automatisierter Protokollierungs- und Überwachungstools kann konsistente und objektive Einblicke in das Verhalten Ihrer KI liefern. Diese Tools können Anomalien und Leistungsprobleme in Echtzeit erkennen, was sowohl für die sofortige Fehlerbehebung als auch für die langfristige Wartung von entscheidender Bedeutung ist. Darüber hinaus kann eine erweiterte Überwachung dabei helfen, Muster zu erkennen, die zu Fehlern führen, und wertvolle Daten liefern, um diese in zukünftigen Entwicklungszyklen zu verhindern.

Verwenden Sie Feature Flags für eine sicherere Bereitstellung

Durch die Einführung von Feature-Flags können Sie neue Funktionen schrittweise einführen und steuern, wer Zugriff darauf erhält. Diese Vorgehensweise kann die Auswirkungen unentdeckter Fehler eindämmen, indem sie zunächst einer kleinen Benutzerbasis zugänglich gemacht werden. Wenn nach der Veröffentlichung ein Fehler festgestellt wird, können Sie mithilfe von Feature-Flags außerdem problemlos ein Rollback durchführen, ohne andere Aspekte der KI-Anwendung zu beeinträchtigen.

Kontinuierliches Lernen und Anpassung

Beim Debuggen geht es nicht nur darum, Fehler zu beheben. Es geht darum, aus Fehlern zu lernen und Prozesse zu verbessern. Ein effizienter Debugger hält sich über neue Tools, Techniken und Plattformen auf dem Laufenden, die seinen Arbeitsablauf vereinfachen und verbessern können. Plattformen wie AppMaster bieten beispielsweise eine no-code Lösung für die schnelle Entwicklung und Bereitstellung von KI-Tools mit integrierten Funktionen für Debugging und Überwachung, wodurch die für diese Aufgaben aufgewendeten Ressourcen erheblich reduziert werden.

Aufrechterhaltung einer gesunden Debugging-Denkweise

Behalten Sie schließlich eine positive und neugierige Einstellung bei. Fehler als Herausforderungen und nicht als Probleme zu sehen, kann motivierend sein. Denken Sie daran, dass jeder Fehler eine Gelegenheit ist, das KI-System besser zu verstehen und seine Robustheit zu verbessern. Bleiben Sie geduldig und gehen Sie beim Debuggen immer methodisch und dennoch kreativ vor.

Indem Sie diese Tipps umsetzen und Ihre Debugging-Prozesse kontinuierlich verfeinern, können Sie einen reibungsloseren und effizienteren Arbeitsablauf gewährleisten, der letztendlich zur Entwicklung zuverlässiger und leistungsstarker KI-Anwendungen führt.

Wartung der KI-Tools nach dem Debuggen

Nachdem Sie das Labyrinth des Debuggens Ihrer KI-Tools erfolgreich bewältigt haben, endet die Reise hier nicht. Wie eine fein gearbeitete Uhr erfordern KI-Tools eine kontinuierliche Wartung und Überwachung, um sicherzustellen, dass sie mit Höchstleistung funktionieren. Hier befassen wir uns mit einem sinnvollen Ansatz für die Wartung von KI-Tools nach dem strengen Debugging-Prozess und bieten Ihnen Strategien, um Ihre Investition zukunftssicher zu machen und dauerhafte, konsistente Ergebnisse sicherzustellen.

Kontinuierliche Überwachung der Modellleistung

KI-Modelle sind anfällig für „Modelldrift“, da sich Daten und reale Umstände im Laufe der Zeit weiterentwickeln. Die Implementierung eines Mechanismus zur kontinuierlichen Leistungsüberwachung ist zwingend erforderlich. Solche Systeme machen Entwickler auf potenzielle Einbußen bei der Genauigkeit oder Effektivität aufmerksam und ermöglichen so zeitnahe Anpassungen. Dieser wachsame Ansatz bedeutet, dass Modelle ihre Relevanz behalten und weiterhin wertvolle Erkenntnisse liefern.

Regelmäßige Aktualisierungen von Modellen und Datensätzen

Der Datenhunger der KI ist unstillbar und ihre Leistung hängt untrennbar mit der Qualität und dem Umfang der aufgenommenen Informationen zusammen. Daher ist es von entscheidender Bedeutung, ihm frische, qualitativ hochwertige Daten zuzuführen und Modelle zu überarbeiten und zu verfeinern. Wenn neue Muster entstehen und alte verschwinden, sollten sich Ihre KI-Tools weiterentwickeln, um auf diese Veränderungen eingestellt zu bleiben. Regelmäßige Nachschulungen mit aktuellen Daten werden nicht nur empfohlen; Es ist erforderlich, wettbewerbsfähig und effektiv zu bleiben.

Laufende Tests und Validierung

Obwohl Sie die Probleme während der Debug-Phase behoben haben, gibt es keinen Grund, das Test-Toolkit aus der Hand zu legen. Wie ein wachsamer Wächter müssen Sie Ihre KI-Modelle kontinuierlich anhand neuer Szenarien, Randfälle und Datensätze testen und validieren. Automatisierte Testpipelines können hier eine große Hilfe sein und zu Ihren unermüdlichen Verbündeten bei der Aufrechterhaltung der Belastbarkeit und Zuverlässigkeit Ihrer KI-Tools werden.

Dokumentation und Versionsverfolgung

Die Aufrechterhaltung einer sorgfältigen Dokumentation ist nicht nur eine Übung der gebotenen Sorgfalt – sie ist ein Hinweis für jeden, der in Zukunft mit Ihrem System interagieren wird. Klare Aufzeichnungen von Änderungen, Entscheidungen und Architekturänderungen erstellen eine Roadmap, die Wartungsteams leiten, die Einarbeitungszeit für neue Entwickler verkürzen und bei unerwarteten Problemen erheblich helfen kann.

Anpassung an Benutzerfeedback und Marktveränderungen

Ein KI-Tool, so technisch ausgereift es auch sein mag, muss letztendlich die Bedürfnisse seiner Benutzer erfüllen und die Probleme lösen. Um sicherzustellen, dass die KI relevant und benutzerzentriert bleibt, ist es von größter Bedeutung, Benutzerfeedback einzuholen und darauf zu reagieren. Ebenso ist der Markt, in dem sie tätig ist, dynamisch, und um an der Spitze zu bleiben, muss sich Ihre KI an regulatorische Änderungen, Wettbewerbsdruck und technologische Fortschritte anpassen.

Durchführung von Ethik- und Voreingenommenheitsprüfungen

Der tiefgreifende Einfluss von KI erstreckt sich noch weiter auf ethische Bereiche und potenzielle Vorurteile. Laufende Audits und Kontrollen zur Korrektur von Datenungleichgewichten, zur Beseitigung von Vorurteilen und zur Gewährleistung fairer und ethischer Ergebnisse sind für die Verwalter von KI-Tools eine nicht verhandelbare Verantwortung.

Die Rolle von AppMaster

Plattformen wie AppMaster können als wertvolle Ressourcen dienen, indem sie eine Grundlage für die schnelle Anwendungsentwicklung no-code und eine einfache Iteration bei der Wartung von KI-Tools nach dem Debuggen bieten. Die nahtlose Integration von KI-Funktionalitäten mit herkömmlichen App-Komponenten trägt dazu bei, Innovation und Stabilität in Einklang zu bringen. Mit seiner automatisierten Codegenerierung trägt AppMaster dazu bei, den Wartungsaufwand zu minimieren, sodass sich Teams auf wertschöpfende Aktivitäten wie Modellverbesserung und Leistungsoptimierung konzentrieren können.

Durch die Beachtung dieser Strategien können Sie ein konsistentes Leistungsniveau Ihrer KI-Tools fördern und gleichzeitig agil bleiben und auf die kontinuierliche Weiterentwicklung des KI-Bereichs vorbereitet sein. Bei diesem proaktiven Wartungsplan geht es nicht nur um den Erhalt der Funktionalität, sondern auch darum, Ihre KI-Tools weiterzuentwickeln und zu verbessern, um den Anforderungen von morgen gerecht zu werden und diese zu übertreffen.

Fazit: Eine Roadmap für fehlerfreie KI-Anwendungen

Bei der Entwicklung von KI-Tools ist das Debuggen ein unverzichtbarer Bestandteil der Erstellung intelligenter und zuverlässiger Anwendungen. Es ist ein Prozess, der sowohl eine sorgfältige Beachtung technischer Details als auch ein umfassendes Verständnis komplexer Systeme erfordert. Als wir in die anspruchsvolle Welt des KI-Debuggings eingetaucht sind, haben wir gesehen, dass es nicht nur um die Behebung von Fehlern geht. Es ist vielmehr eine Gelegenheit, die Leistung zu optimieren, die Genauigkeit zu verbessern und letztendlich den von uns entwickelten KI-Lösungen zu vertrauen.

Der Weg zu fehlerfreien KI-Anwendungen ist klar, erfordert jedoch Hingabe und strategische Umsetzung. Beginnen Sie mit einem Verständnis der einzigartigen Herausforderungen, die KI-Systeme mit sich bringen. Machen Sie sich mit den Feinheiten datengesteuerter Verhaltensweisen vertraut, behalten Sie die Modellleistung im Auge und nutzen Sie das Debugging als Linse, um die Nuancen Ihrer KI zu verfeinern und zu verstehen. Die in diesem Diskurs vorgestellten Taktiken, von der Einrichtung einer zuverlässigen Umgebung bis zur Auswahl der richtigen Debugging-Strategien, führen Sie zu einem effizienten Arbeitsablauf.

KI-Tools können sehr komplex sein und keine Debugging-Reise gleicht der anderen. Daher ist es wichtig, ein Gefühl der Flexibilität und des kontinuierlichen Lernens zu bewahren. Bleiben Sie über die neuesten Trends, Tools und Methoden beim KI-Debugging auf dem Laufenden. Und denken Sie daran, dass der menschliche Faktor – Ihre Intuition und Ihr Fachwissen – in Kombination mit der Intelligenz und Automatisierung, die Plattformen wie AppMaster bieten, immer ein wertvolles Gut sein wird. Hier finden Sie ein Gleichgewicht zwischen den erweiterten Fähigkeiten automatisierter Tools und dem Urteilsvermögen eines erfahrenen Entwicklers.

Schließlich sollte die Wartung von KI-Anwendungen nach dem Debuggen nicht unterschätzt werden. Sie haben hart daran gearbeitet, einen Zustand mit minimalen Fehlern und reibungslosen Abläufen zu erreichen, und es ist von entscheidender Bedeutung, diesen Zustand aufrechtzuerhalten, indem Sie Ihre Systeme konsequent überwachen, aktualisieren und testen.

Der Weg zur Beherrschung des Debuggens von KI-Tools ist kein linearer Weg, sondern ein kontinuierlicher Verbesserungszyklus. Es erfordert eine Synergie aus modernster Technologie, wie etwa den no-code -Lösungen von AppMaster, und den unersetzlichen kreativen Fähigkeiten der Entwickler zur Problemlösung. Durch die Befolgung dieser Roadmap können Entwickler sicherstellen, dass ihre KI-Anwendungen nicht nur funktionieren, sondern ihr volles Potenzial entfalten und in einer technologisch dynamischen Welt Mehrwert und Innovation bieten.

FAQ

Das Debuggen von KI-Tools beinhaltet die Feinheiten datengesteuerten Verhaltens, was bedeutet, dass Sie beim Debuggen die Qualität der Daten, die Modellarchitektur und die Trainingsprozesse berücksichtigen müssen.

Zu den häufigsten Herausforderungen gehören Überanpassung, Unteranpassung, Datenverzerrung und der Umgang mit nicht deterministischen Ergebnissen.

Eine zuverlässige KI-Debugging-Umgebung umfasst Versionskontrolle für Code und Daten, gründliche Datenvalidierung und Tools zur Experimentverfolgung und -visualisierung.

Zu den Strategien gehören die Verwendung eines modularen Ansatzes, die Vereinfachung des Modells, die Visualisierung des Modellverhaltens und der Einsatz von Techniken wie Unit-Tests und kontinuierlicher Integration.

Während automatisierte Tools den Prozess erheblich unterstützen können, spielt die menschliche Intuition eine Schlüsselrolle beim Verständnis des Kontexts, der Interpretation von Daten und dem Treffen strategischer Entscheidungen.

AppMaster bietet eine no-code Plattform, die die Entwicklung und das Debuggen von KI-Anwendungen mit visuellen Debugging-Tools und automatisierter Codegenerierung vereinfacht.

Sie können die Effizienz aufrechterhalten, indem Sie sich auf die Reproduzierbarkeit konzentrieren, bei der Dokumentation organisiert bleiben und der Fehlerbehebung schwerwiegender Fehler Priorität einräumen.

Die Wartung nach dem Debuggen sollte eine kontinuierliche Überwachung, regelmäßige Aktualisierungen des Modells und des Datensatzes sowie fortlaufende Tests umfassen, um neue Probleme zu verhindern.

Ja, KI-Techniken können eingesetzt werden, um bestimmte Aspekte des Debugging-Prozesses zu automatisieren, beispielsweise die Erkennung von Anomalien und die vorausschauende Wartung.

Die Analyse realer Fallstudien kann Einblicke in wirksame Strategien und häufige Fehler liefern und Ihnen praktisches Wissen zum Debuggen von KI-Tools vermitteln.

Zu den häufigsten Fallstricken gehören die Vernachlässigung der Datenqualität, das Ignorieren von Modellverzerrungen, die Überkomplizierung des Modells und das Versäumnis, Ergebnisse anhand realer Szenarien zu validieren.