Debug dell'intelligenza: suggerimenti e trucchi per la codifica degli strumenti di intelligenza artificiale

Padroneggia l'arte del debug degli strumenti di intelligenza artificiale con suggerimenti e trucchi degli esperti per codificare gli strumenti di intelligenza artificiale. Migliora le prestazioni e la precisione delle tue applicazioni IA.

Il debug è un componente critico dello sviluppo del software , un processo sistematico per diagnosticare e correggere bug, colli di bottiglia delle prestazioni e altri problemi che impediscono il corretto funzionamento del software. Quando si tratta di strumenti di intelligenza artificiale (AI), la complessità del debug aumenta notevolmente a causa delle sfide uniche poste da questi sistemi basati sui dati.

A differenza del software tradizionale, gli strumenti di intelligenza artificiale si basano in gran parte sulla qualità e sulla complessità dei dati su cui vengono addestrati. Coinvolgono algoritmi sofisticati che apprendono da questi dati e fanno previsioni o intraprendono azioni in base al loro apprendimento. Di conseguenza, il debug dell’IA richiede una conoscenza tecnica della programmazione e dell’ingegneria del software e una conoscenza del particolare dominio dell’IA, che si tratti di machine learning, deep learning, elaborazione del linguaggio naturale o altri.

Al centro del debug degli strumenti IA c’è la ricerca di trasparenza e affidabilità. Gli sviluppatori e gli ingegneri dell'intelligenza artificiale si sforzano di demistificare la natura della "scatola nera" delle applicazioni di intelligenza artificiale per garantire che funzionino come previsto e possano essere affidate alle attività per cui sono progettate. Ciò comporta test rigorosi dei modelli di intelligenza artificiale, ispezione approfondita delle pipeline di dati, convalida dei risultati e monitoraggio continuo delle applicazioni di intelligenza artificiale implementate.

Per eseguire il debug efficace degli strumenti di intelligenza artificiale, è necessario navigare attraverso complessi livelli di astrazione, che vanno dalla preelaborazione dei dati grezzi, all'estrazione delle funzionalità e all'addestramento del modello, all'ottimizzazione degli iperparametri e all'implementazione del modello. È essenziale rintracciare metodicamente la fonte di qualsiasi comportamento o risultato imprevisto, che potrebbe derivare da numerosi fattori come errori algoritmici, corruzione dei dati o adattamento eccessivo del modello.

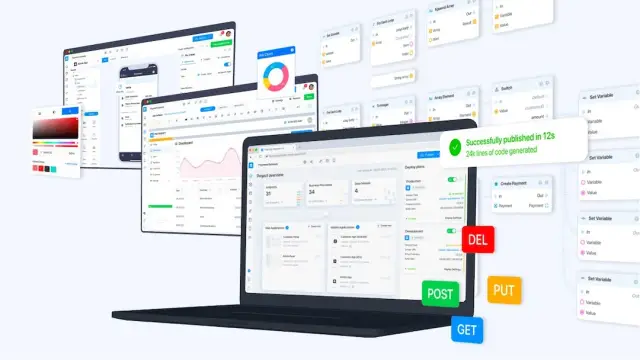

In questo intricato processo di rilevamento e correzione, strumenti e pratiche come il controllo della versione, ambienti di sviluppo interattivi, strumenti di visualizzazione e codifica modulare svolgono un ruolo fondamentale. Inoltre, l’adozione di una piattaforma senza codice come AppMaster può facilitare lo sviluppo rapido e il debug degli strumenti di intelligenza artificiale fornendo un ambiente di sviluppo visivo e automatizzando molte attività di codifica di routine.

Mentre approfondiamo le sfumature del debug degli strumenti di intelligenza artificiale, è fondamentale capire che si tratta di uno sforzo iterativo e spesso complesso, che richiede pazienza, abilità e un'acuta mente analitica. Le sezioni successive esploreranno le sfide particolari dell'intelligenza artificiale, le strategie per un debug efficace, il ruolo dell'automazione e dell'intuizione umana e casi di studio del mondo reale che evidenziano le applicazioni pratiche di queste tecniche.

Comprendere le sfide di debug specifiche dell'intelligenza artificiale

I sistemi di intelligenza artificiale possiedono caratteristiche uniche che rendono il debugging una faccenda particolarmente complessa. A differenza del software tradizionale, dove i bug derivano tipicamente da errori logici o problemi nella base di codice, i sistemi di intelligenza artificiale intrecciano il codice con dati e algoritmi di apprendimento. Questa combinazione introduce una serie complessa di sfide che richiedono tecniche di debug specializzate.

I dati determinano in gran parte il comportamento di un modello di intelligenza artificiale su cui è addestrato. Pertanto, il debug specifico dell’intelligenza artificiale spesso inizia con un esame approfondito di questi dati. Un problema comune è la presenza di distorsioni nel training set, che possono portare a previsioni distorte o ingiuste. Il debug richiede quindi l’identificazione di questi pregiudizi e la comprensione delle loro cause profonde e delle loro ramificazioni per correggere il problema senza introdurre nuovi problemi.

Un’altra sfida significativa nel debugging dell’IA riguarda la natura stocastica di molti algoritmi AI. I risultati possono variare anche con gli stessi dati di input, a causa di inizializzazioni casuali o di variabilità intrinseca nei processi di training come la discesa del gradiente stocastico. Di conseguenza, replicare i problemi può essere frustrantemente difficile ed è necessario utilizzare metodi statistici o fissare i semi iniziali per garantire un comportamento coerente per un’indagine approfondita.

Overfitting e underfitting sono due facce della stessa medaglia che complicano il processo di debug. L'overfitting si verifica quando un modello è troppo complesso e impara a memorizzare i dati di addestramento, inclusi rumore e valori anomali, anziché generalizzare dai modelli. Al contrario, l’underfitting deriva da modelli eccessivamente semplicistici che non riescono a catturare la struttura sottostante nei dati. Il debug di questi problemi comporta la modifica della complessità del modello, spesso eseguita attraverso tecniche di convalida incrociata e regolarizzazione.

Anche l’interpretabilità del modello rappresenta una sfida sostanziale. Alcuni modelli di intelligenza artificiale, come le reti neurali profonde, sono spesso chiamati “scatole nere” a causa della difficoltà di comprendere esattamente come prendono le decisioni. Questo può rappresentare un grave ostacolo nel debug, poiché è fondamentale comprendere il motivo dietro l'output di un modello per risolvere il problema di fondo. Tecniche come l'analisi dell'importanza delle caratteristiche, la distillazione del modello e la visualizzazione degli strati di rete possono talvolta far luce sugli angoli oscuri di questi modelli complessi.

Infine, la natura in rapida evoluzione degli strumenti e dei framework di intelligenza artificiale può rendere il debug un obiettivo in continua evoluzione. Con aggiornamenti frequenti e best practice emergenti, gli sviluppatori devono stare costantemente all'erta per assicurarsi di non dover affrontare problemi già risolti nelle versioni più recenti o che i loro strumenti di debug siano in linea con gli ultimi progressi nel campo.

Il debug degli strumenti di intelligenza artificiale richiede una combinazione di competenze nel settore, analisi metodica e spesso un po' di creatività. In qualità di sviluppatore di intelligenza artificiale, comprendere queste sfide specifiche dell'intelligenza artificiale e prepararsi ad affrontarle metodicamente può migliorare notevolmente il processo di debug, portando ad applicazioni di intelligenza artificiale più affidabili.

Configurazione di un ambiente di debug affidabile

Lo sviluppo di strumenti di intelligenza artificiale richiede un'attenzione meticolosa ai dettagli durante la fase di creazione e quando sorgono problemi. Per eseguire il debug efficace dei sistemi di intelligenza artificiale, gli sviluppatori necessitano di un ambiente sistematico per gestire la complessità degli algoritmi e dei set di dati di intelligenza artificiale. Le seguenti tecniche ti guideranno nella creazione di tale ambiente, migliorando la tua capacità di identificare, isolare e risolvere i problemi all'interno degli strumenti di intelligenza artificiale.

Innanzitutto, crea un'area di lavoro controllata dalla versione sia per il tuo codice che per i tuoi set di dati. I sistemi di controllo della versione come Git aiutano a tenere traccia delle modifiche e consentono il rollback agli stati precedenti se vengono introdotti nuovi bug. Inoltre, strumenti come DVC (Data Version Control) possono essere utilizzati specificamente per la gestione e il controllo delle versioni dei set di dati, il che è fondamentale poiché i dati sono spesso al centro dei problemi nei sistemi di intelligenza artificiale.

Assicurati che il tuo ambiente di debug includa la convalida dei dati . La qualità dei dati è fondamentale; dovrebbe essere verificata la correttezza, la coerenza e l'assenza di errori prima di essere inseriti nel modello. Una configurazione affidabile incorporerà script automatizzati che controllano l'integrità dei dati a intervalli regolari o prima di ogni sessione di formazione. Questa misura preventiva può aiutare a prevenire molti problemi legati alla gestione dei dati.

Un altro fattore chiave è l'impostazione del monitoraggio degli esperimenti . Lo sviluppo dell'intelligenza artificiale prevede molti esperimenti con diversi iperparametri, set di dati e architetture di modelli. Strumenti come MLflow, Weights & Biases o TensorBoard ti consentono di monitorare, visualizzare e confrontare diversi esperimenti. Questo approccio sistematico aiuta a comprendere il comportamento del modello e a identificare il motivo per cui determinati cambiamenti potrebbero aver portato a bug.

Inoltre, sfruttare l’integrazione continua e le pratiche di test . Questi non riguardano solo lo sviluppo di software tradizionale; sono ugualmente importanti nell’intelligenza artificiale. I test automatizzati possono garantire che piccole parti del sistema di intelligenza artificiale funzionino come previsto dopo le modifiche. I server di integrazione continua possono eseguire automaticamente la convalida dei dati, gli script di training e i test sui nuovi commit sulla base di codice, avvisandoti immediatamente dei problemi.

Gli strumenti di visualizzazione costituiscono parte integrante del debug delle applicazioni AI. Ad esempio, l'utilizzo di strumenti per visualizzare il grafico computazionale di una rete neurale può aiutarti a vedere dove le cose potrebbero andare storte. Allo stesso modo, visualizzare le distribuzioni dei dati, le previsioni del modello rispetto ai risultati effettivi e le metriche di training possono evidenziare discrepanze che potrebbero indicare bug.

Infine, completa gli strumenti tecnologici con una documentazione completa che includa dettagli su origini dati, architetture dei modelli, ipotesi, risultati degli esperimenti e misure di risoluzione dei problemi adottate. Questa risorsa si rivelerà preziosa per il debug corrente, la manutenzione e gli aggiornamenti futuri, offrendo chiarezza e continuità nelle attività di sviluppo.

Insieme a queste strategie e alle funzionalità no-code di AppMaster, gli sviluppatori possono ridurre significativamente i bug del sistema AI. Gli strumenti visivi della piattaforma e la generazione automatizzata di codice semplificano gli aspetti dello sviluppo dell'intelligenza artificiale che altrimenti potrebbero essere soggetti a errori, aiutando gli sviluppatori a creare, distribuire e mantenere con facilità applicazioni IA di alta qualità.

Strategie di debug per modelli di machine learning

I modelli di machine learning (ML) a volte possono sembrare scatole nere, presentando sfide uniche quando si tratta di debug. A differenza degli errori logici sistematici che spesso affliggono il software tradizionale, i modelli ML soffrono di problemi radicati nella qualità dei dati, nell’architettura del modello e nelle procedure di training. Per eseguire il debug efficace dei modelli ML, gli sviluppatori devono adottare un approccio strategico che affronti queste complessità uniche.

Inizia con una base solida: verifica dei dati

Prima di approfondire gli aspetti computazionali del debug, è fondamentale assicurarsi che i dati siano corretti e ben preparati. Problemi come valori mancanti, formattazione incoerente e valori anomali possono distorcere in modo significativo le prestazioni del modello. Questo primo passaggio prevede pratiche rigorose di pulizia, normalizzazione e aumento dei dati, nonché controlli di integrità per la distribuzione dei dati che potrebbero evidenziare potenziali distorsioni o errori nel set di dati.

Semplificare per chiarire: riduzione del modello

Di fronte a un modello problematico, ridurne la complessità per isolare i problemi. Riducendo il numero di funzionalità o semplificando l'architettura, spesso è possibile individuare dove le cose vanno storte. Se un modello ridotto presenta ancora problemi, il problema potrebbe risiedere nei dati o nelle funzionalità utilizzate. Al contrario, se la semplificazione risolvesse il problema, la complessità del modello originale potrebbe esserne la colpevole.

Visualizzare per Comprendere: Analisi degli Errori

Sfrutta gli strumenti di visualizzazione per analizzare i modelli di errore. Tracciare le curve di apprendimento può indicare problemi di capacità del modello come overfitting o underfitting. L'esame delle matrici di confusione e delle curve delle caratteristiche operative del ricevitore (ROC) per le attività di classificazione aiuta a identificare le classi con cui il modello ha difficoltà, suggerendo aree che potrebbero richiedere caratteristiche più sfumate o dati aggiuntivi per migliorare le prestazioni.

Garantire la riproducibilità: controllo della versione e monitoraggio degli esperimenti

Affinché il debug sia efficace, ogni esperimento deve essere riproducibile. I sistemi di controllo della versione come Git dovrebbero essere utilizzati non solo per il codice, ma anche per tenere traccia delle modifiche nei set di dati e nelle configurazioni dei modelli. Gli strumenti di monitoraggio degli esperimenti sono essenziali per confrontare diverse esecuzioni, comprendere l'impatto delle modifiche e avvicinarsi sistematicamente al miglioramento del modello.

Tecniche tradizionali: unit test e integrazione continua

L'applicazione delle migliori pratiche di ingegneria del software allo sviluppo ML è spesso trascurata ma cruciale. Implementare test unitari per le pipeline di elaborazione dati e i singoli componenti del modello per garantire che funzionino come previsto. Le pipeline di integrazione continua (CI) aiutano a eseguire questi test automaticamente, rilevando gli errori nelle prime fasi del ciclo di sviluppo.

Debug mediante sondaggio: utilizzo di strumenti diagnostici

Gli strumenti diagnostici sono preziosi per scavare più a fondo nel comportamento del modello. Tecniche come l'analisi dell'importanza delle caratteristiche e i grafici delle dipendenze parziali rivelano informazioni su quali caratteristiche influenzano in modo più significativo le previsioni del modello. Inoltre, la distillazione del modello, in cui un modello più semplice viene addestrato per approssimare le previsioni di uno complesso, può evidenziare su quali aspetti dei dati di addestramento si sta concentrando il modello originale, il che potrebbe portare alla scoperta di dati etichettati erroneamente o di caratteristiche eccessivamente enfatizzate.

Il potere degli insiemi: combinazione di modelli per l'intuizione

Il debug può provenire anche da insiemi di modelli. Combinando vari modelli, è possibile valutare il loro consenso e identificare qualsiasi modello individuale che si discosta in modo significativo dagli altri, il che potrebbe essere sintomatico di un problema nell'addestramento o nell'elaborazione dei dati di quel particolare modello.

Debug incentrato sull'uomo: coinvolgere esperti di dominio

Gli esseri umani non dovrebbero essere esclusi dal debug dell’intelligenza artificiale. Collabora con esperti del settore che comprendano i dati e possano fornire informazioni preziose sulla validità degli output del modello. Possono aiutare a identificare le imprecisioni che potrebbero passare inosservate da metriche puramente basate sui dati.

Il miglioramento iterativo è fondamentale

Alla fine, il debug dei modelli ML è un processo iterativo. Ogni ciclo ti offre una comprensione più approfondita del tuo modello e dei dati da cui apprende. Queste strategie forniscono linee guida, ma devono essere adattate al contesto del tuo progetto specifico e al tipo di modello ML che stai sviluppando. Ricorda di utilizzare piattaforme no-code come AppMaster, che offrono strumenti per semplificare le fasi iniziali dello sviluppo del modello e fornire una base per ulteriori debug e perfezionamenti.

Insidie comuni e come evitarle

Man mano che l’intelligenza artificiale cresce in complessità e diversità, gli sviluppatori spesso affrontano sfide uniche che possono far deragliare il processo di debug. Riconoscere ed aggirare queste insidie è fondamentale per creare e mantenere strumenti di intelligenza artificiale efficaci. Qui, approfondiamo alcune delle insidie più comuni nel debug degli strumenti di intelligenza artificiale e presentiamo strategie per evitarle.

Ignorare la generalizzazione del modello

Uno dei problemi più diffusi nello sviluppo dell'intelligenza artificiale è la creazione di un modello che funzioni eccezionalmente bene sui dati di addestramento ma non riesca a generalizzare a dati nuovi e invisibili: adattamento eccessivo. Per evitare ciò è fondamentale:

- Utilizza un set di dati completo che rifletta le situazioni del mondo reale che il modello incontrerà.

- Impiegare tecniche come la convalida incrociata e la regolarizzazione.

- Testa costantemente i tuoi modelli sulla convalida e testa i set di dati.

Trascurare la qualità dei dati

Immondizia dentro, spazzatura fuori; questa verità è particolarmente rilevante nell’intelligenza artificiale. Una scarsa qualità dei dati può distorcere completamente le prestazioni del modello. Per evitare questa trappola:

- Garantire un'accurata pulizia e preelaborazione dei dati.

- Implementare il rilevamento delle anomalie per individuare valori anomali e errati.

- Concentrarsi sulla raccolta di dati diversificati e rappresentativi per evitare pregiudizi.

Mancanza di controllo della versione

Senza un meticoloso controllo delle versioni dei modelli e dei set di dati IA, la riproduzione dei risultati e il monitoraggio delle modifiche diventano gravosi. Adotta strumenti per il controllo delle versioni e la gestione degli esperimenti per:

- Conserva un registro dettagliato delle revisioni dei dati, dei parametri del modello e delle modifiche al codice.

- Organizza il tuo processo di sviluppo per mantenere la coerenza tra le sessioni di debug.

Sottovalutare la complessità del modello

I modelli complessi non sono sempre superiori: a volte sono semplicemente più difficili da eseguire il debug. Inizia in modo semplice e aumenta gradualmente la complessità solo se necessario. Affidarsi a modelli più semplici può spesso portare a risultati più trasparenti e interpretabili, rendendo il processo di debug più gestibile.

Trascurare gli strumenti di debug

Rinunciare all'uso di strumenti di debug specializzati può portare a tempi di risoluzione dei problemi significativamente più lunghi. Utilizza piattaforme come AppMaster per semplificare lo sviluppo con i suoi strumenti e funzionalità di debug visivo che consentono agli sviluppatori di visualizzare i processi aziendali e il flusso di dati senza approfondire il codice.

Anticipando queste insidie comuni e implementando strategie per contrastarle, gli sviluppatori possono mitigare molte delle frustrazioni comunemente associate al debug degli strumenti di intelligenza artificiale e aprire la strada a sessioni di debug più fluide ed efficienti.

Strumenti automatizzati vs intuizione umana nel debug dell'intelligenza artificiale

Nell’intelligenza artificiale, il debug si estende oltre gli errori logici sistematici per comprendere le interpretazioni sfumate dei dati e dei comportamenti dei modelli. L’ascesa degli strumenti di debug automatizzati suggerisce una trasformazione nel modo in cui gli sviluppatori affrontano la risoluzione dei problemi nell’intelligenza artificiale. Tuttavia, nonostante i sofisticati progressi, l’intuizione umana rimane una risorsa indispensabile durante tutto il processo di debug. Questa sezione approfondisce l'interazione dinamica tra strumenti automatizzati e intuizione umana nell'arena del debugging dell'intelligenza artificiale.

Gli strumenti automatizzati nel debugging dell'intelligenza artificiale fungono da prima linea di difesa. Sono abili nell'identificare bug semplici, come errori di sintassi, eccezioni ed errori di runtime, che altrimenti potrebbero consumare tempo prezioso se risolti manualmente. Questi strumenti, alimentati dall’intelligenza artificiale stessa, possono semplificare i test analizzando rapidamente vaste matrici di codice per individuare anomalie. Tecnologie come l’analisi predittiva e gli algoritmi di rilevamento delle anomalie hanno il potenziale per discernere modelli e prevedere problemi prima che si manifestino completamente, agendo efficacemente come misura preventiva nel processo di risoluzione dei problemi.

Tuttavia, i sistemi di intelligenza artificiale sono definiti dalla loro complessità e unicità; imparano e si adattano in base ai dati. Gli strumenti automatizzati possono vacillare di fronte alla natura astratta dei problemi dell’intelligenza artificiale, come quelli relativi alla qualità dei dati, all’architettura del modello o alle sottigliezze dell’ottimizzazione degli iperparametri. È qui che entrano in gioco l’intuizione e la competenza umane. Gli sviluppatori umani mettono sul tavolo le loro conoscenze tecniche, la comprensione sfumata del contesto, la capacità di ipotizzare problemi non strutturati e le capacità creative di risoluzione dei problemi.

A volte, l’assoluta imprevedibilità dell’intelligenza artificiale richiede le congetture informate di un essere umano per sradicare discrepanze meno evidenti. Ad esempio, quando un modello di intelligenza artificiale genera risultati inaspettati, gli strumenti automatizzati possono segnalare l'anomalia, ma spesso è l'intuito degli sviluppatori che li guida alla causa sottostante, che si tratti di un problema con i dati di addestramento, di un adattamento eccessivo del modello o di qualcosa di più nascosto come un errore. sottile bug logico nella fase di pre-elaborazione dei dati.

Inoltre, la supervisione umana è fondamentale quando si interpretano i risultati del debug automatico. È necessario il giudizio umano per stabilire la priorità su quali bug vale la pena perseguire in base al loro potenziale impatto sul sistema. Inoltre, il debug dei sistemi di intelligenza artificiale può introdurre considerazioni etiche – come violazioni della privacy o risultati distorti – che gli strumenti automatizzati non sono intrinsecamente attrezzati per gestire. Grazie alla loro empatia umana e al ragionamento etico, gli sviluppatori sono nella posizione migliore per affrontare queste aree sensibili.

È importante riconoscere che gli strumenti automatizzati non mirano a sostituire gli sviluppatori umani ma ad aumentare le loro capacità. Ad esempio, all'interno della piattaforma AppMaster, gli strumenti automatizzati semplificano il processo di sviluppo e debug no-code. Le funzionalità della piattaforma consentono il debug visivo, consentendo agli sviluppatori di osservare e interagire con i flussi di dati e i percorsi logici in modo più intuitivo. Pertanto, AppMaster è una testimonianza della sinergia tra sistemi automatizzati e intuizioni umane, presentando un modello cooperativo di risoluzione dei problemi che sfrutta i punti di forza di entrambi i mondi.

Sebbene gli strumenti automatizzati forniscano efficienza e velocità nelle attività di debug di routine, non annullano la necessità dell’intuizione umana che rimane cruciale per gestire le complessità dei sistemi di intelligenza artificiale. Una miscela armoniosa di software automatizzato e competenze umane non solo accelera il processo di debug, ma garantisce anche uno strumento AI più affidabile e performante come risultato finale. Man mano che l’intelligenza artificiale continua ad evolversi, lo faranno anche le metodologie e gli archivi di strumenti volti a demistificare le sue complessità, sempre con l’elemento umano al centro.

Casi di studio: debug dell'intelligenza artificiale in azione

Anche i sistemi di intelligenza artificiale progettati più meticolosamente possono mostrare comportamenti o errori imprevisti una volta che interagiscono con dati e scenari del mondo reale. Attraverso l'esame di casi di studio, gli sviluppatori possono acquisire informazioni sulle strategie di debug di successo e quindi perfezionare il loro approccio alla creazione di strumenti di intelligenza artificiale più affidabili e potenti. Esaminiamo alcuni casi di studio degni di nota che fanno luce sulle complessità del debugging dell'intelligenza artificiale.

- Caso di studio 1: diagnosi di overfitting in un modello predittivo: un'azienda di vendita al dettaglio ha sviluppato un modello di machine learning per prevedere la futura domanda di prodotti sulla base dei dati storici di vendita. Tuttavia, le previsioni del modello non erano in linea con i risultati effettivi. Gli sviluppatori hanno scoperto che il modello si adattava eccessivamente durante la fase di addestramento, apprendendo rumore e anomalie nei dati di addestramento piuttosto che nei modelli sottostanti. Hanno utilizzato tecniche come la convalida incrociata e hanno introdotto un parametro di regolarizzazione per mitigare l’overfitting, il che ha prodotto un modello che generalizza meglio ai dati invisibili.

- Caso di studio 2: Affrontare la distorsione dei dati nel software di riconoscimento facciale: un'azienda di intelligenza artificiale ha dovuto affrontare una reazione negativa da parte del pubblico quando il suo software di riconoscimento facciale mostrava pregiudizi, ottenendo scarsi risultati con determinati gruppi demografici. Durante il debug, il team si è reso conto che i dati di addestramento mancavano di diversità. Raccogliendo dati più rappresentativi e impiegando algoritmi di equità, hanno migliorato la precisione e ridotto i bias nel loro software, dimostrando l’importanza della qualità e della diversità dei dati nell’addestramento dei modelli di intelligenza artificiale.

- Caso di studio 3: Migliorare la precisione dell'elaborazione del linguaggio naturale: una startup ha sviluppato uno strumento di elaborazione del linguaggio naturale (NLP) che non classificava accuratamente il feedback dei clienti. Il processo di debug ha rivelato che gli incorporamenti di parole utilizzati nel modello non erano sufficienti a catturare il contesto di alcuni termini specifici del settore. La startup ha migliorato in modo significativo la precisione dello strumento nel comprendere le opinioni dei clienti personalizzando gli incorporamenti di parole e includendo dati specifici del dominio nei set di formazione.

- Caso di studio 4: debug degli algoritmi dei veicoli autonomi: un'azienda specializzata in veicoli autonomi ha riscontrato problemi critici in cui l'auto interpretava erroneamente i segnali di stop in determinate condizioni meteorologiche. Il debug ha rivelato che gli algoritmi di visione facevano troppo affidamento sul rilevamento del colore. Integrando più segnali contestuali e tecniche di fusione dei sensori, gli ingegneri sono stati in grado di rendere l'interpretazione dei segnali stradali da parte dell'intelligenza artificiale molto più affidabile.

Ogni caso di studio enfatizza un aspetto unico del debugging dell'intelligenza artificiale, evidenziando le diverse sfide che gli sviluppatori possono incontrare. Che si tratti della qualità del set di dati, della complessità del modello, dei bias degli algoritmi o dell’adattabilità di un sistema, riconoscere e affrontare questi problemi attraverso il debug strategico è essenziale. Mentre i casi di studio forniscono lezioni preziose, piattaforme come AppMaster potenziano gli sviluppatori riducendo la complessità della creazione e del debug degli strumenti di intelligenza artificiale, consentendo anche a chi ha poca esperienza di programmazione di apprendere e applicare le lezioni dalle sfide dell'intelligenza artificiale del mondo reale.

Integrazione delle tecniche di debug con AppMaster

Quando si sviluppano strumenti di intelligenza artificiale, un debug adeguato è essenziale per garantire prestazioni, affidabilità e precisione delle applicazioni. Ormai gli sviluppatori dispongono di molte tecniche per affrontare gli scenari di debug tradizionali. Tuttavia, l’intelligenza artificiale introduce sfide complesse a causa della sua natura incentrata sui dati e dei processi decisionali spesso opachi. Considerato il suo immenso potenziale nel semplificare e migliorare il processo di sviluppo, l'integrazione del debugging dell'intelligenza artificiale con piattaforme no-code come AppMaster offre un percorso semplice ed efficiente per risolvere quelle complesse questioni che potrebbero derivare dalla complessità intrinseca dell'intelligenza artificiale.

AppMaster è una piattaforma di sviluppo no-code che eccelle nel semplificare la creazione di applicazioni web, mobili e backend. Utilizzando AppMaster, agli sviluppatori viene fornito un potente set di strumenti in grado di rafforzare le loro strategie di debug dell'intelligenza artificiale:

- Visualizzazione: il debug dell'intelligenza artificiale spesso richiede la comprensione delle relazioni tra i dati e del comportamento del modello. AppMaster fornisce agli sviluppatori strumenti visivi, come i designer di processi aziendali (BP) , che possono tradurre la logica complessa in componenti visivi comprensibili e modificabili. Ciò è particolarmente utile nelle applicazioni IA in cui è necessario visualizzare flussi di lavoro e punti decisionali per valutare la correttezza dell'elaborazione dei dati e dell'inferenza del modello AI.

- Test automatizzati: il debug non è un processo unico: richiede una rivalutazione continua. La piattaforma fornisce funzionalità di test automatizzati che consentono agli sviluppatori di creare ed eseguire test in modo efficiente dopo ogni modifica, garantendo che le funzionalità principali dell'intelligenza artificiale rimangano intatte e che qualsiasi potenziale regressione venga rilevata tempestivamente.

- Modularità: il debug dell'intelligenza artificiale può richiedere una revisione iterativa in alcune parti dell'applicazione lasciandone altre intatte. AppMaster promuove la modularità attraverso la sua capacità di segmentare le applicazioni in diversi microservizi. Le aree della cabina di pilotaggio di uno strumento AI possono essere isolate per un debug mirato senza ostacolare il funzionamento dell'intera applicazione.

- Integrità dei dati: i dati che alimentano gli strumenti di intelligenza artificiale devono essere convalidati rigorosamente. Errori nei dati porteranno inevitabilmente a comportamenti errati dell’IA. AppMaster incorpora meccanismi per garantire l'integrità dei dati, comprese regole di convalida integrate che possono prevenire i tipici problemi relativi ai dati prima che si trasformino in problemi più ampi e complessi.

- Funzionalità di collaborazione: spesso, il debug di uno strumento di intelligenza artificiale è un lavoro di squadra. L'ambiente collaborativo della piattaforma consente a più sviluppatori di lavorare sul progetto contemporaneamente, facilitando la risoluzione dei problemi man mano che emergono e convalidando collettivamente le soluzioni.

- Distribuzione e hosting: con AppMaster, gli sviluppatori possono distribuire le proprie applicazioni con un semplice clic. Questa rapida implementazione consente cicli di iterazione rapidi per testare ed eseguire il debug delle applicazioni AI in un ambiente di staging o di produzione, garantendo che vengano presi in considerazione gli scenari del mondo reale.

- Analisi e monitoraggio: dopo la distribuzione, tenere sotto controllo le prestazioni di un'applicazione AI è fondamentale per individuare anomalie che potrebbero indicare bug. AppMaster può offrire soluzioni di analisi e monitoraggio per tenere traccia del comportamento dell'applicazione, fornendo dati empirici utili per le attività di debug continue.

Inoltre, la natura no-code di AppMaster accelera il processo di debug astraendo le complessità del codice, consentendo agli sviluppatori di concentrarsi sulla logica e sulle prestazioni dei propri strumenti di intelligenza artificiale anziché essere impantanati da errori di sintassi o strutturali. La capacità della piattaforma di generare automaticamente la documentazione e le specifiche Open API aiuta inoltre nel processo di debug garantendo che l'intero team sia sempre sulla stessa lunghezza d'onda riguardo alla build e al comportamento attuali dello strumento.

Nel percorso di sviluppo di strumenti di intelligenza artificiale, l'integrazione di piattaforme come AppMaster testimonia l'armoniosa combinazione di agilità no-code e sofisticati approcci di debugging dell'intelligenza artificiale. Illustra il futuro dello sviluppo software, dove le complessità del debug non sono un collo di bottiglia ma piuttosto una parte orchestrata della sinfonia dello sviluppo.

Suggerimenti per flussi di lavoro di debug efficienti

Semplifica i tuoi strumenti di debug

Uno dei primi passi verso un flusso di lavoro di debug efficiente è dotarsi degli strumenti giusti. Avrai bisogno di programmi in grado di gestire set di dati e algoritmi complessi, come debugger interattivi, strumenti di analisi visiva dei dati e suite di test automatizzati. Un ambiente di sviluppo integrato (IDE) che offre plug-in ed estensioni specifici per l'intelligenza artificiale può far risparmiare tempo e migliorare la produttività. Quando gli strumenti vengono consolidati in un flusso di lavoro continuo, consentono un'identificazione e una risoluzione più rapida dei bug.

Abbraccia il controllo della versione

Il controllo della versione non consiste solo nel tenere traccia delle modifiche al codice; è anche essenziale per gestire i set di dati su cui opera la tua intelligenza artificiale. Piattaforme come Git possono essere utilizzate per gestire sia codice che dati, consentendo un migliore tracciamento delle modifiche e la possibilità di tornare a uno stato precedente quando qualcosa va storto. Inoltre, puoi ramificare funzionalità sperimentali o trasformazioni di dati, in modo che non interferiscano con la linea di sviluppo principale.

Dai la priorità ai bug in modo efficace

Non tutti i bug sono uguali. Alcuni influiscono in modo significativo sulla funzionalità, mentre altri hanno un impatto minimo sull'applicazione AI. Valutare e dare priorità ai bug in base alla loro gravità e all'impatto sulle prestazioni del software è fondamentale per mantenere un flusso di lavoro efficiente. L’uso della matrice Eisenhower, che divide le attività in matrici urgenti/importanti, può aiutare a classificare e dare priorità ai problemi.

Automatizza le attività ripetitive con gli script

Il debug spesso comporta test e controlli ripetitivi. Scrivendo script per automatizzare queste attività, puoi risparmiare tempo prezioso e ridurre l'errore umano. Gli script possono essere eseguiti attraverso procedure di debug predefinite, consentendoti di concentrare la tua attenzione sulle sfide di debug più complesse e uniche. Gli strumenti di integrazione continua possono aiutarti ad attivare automaticamente tali script in base al codice o ai commit dei dati.

Documenta tutto rigorosamente

La documentazione viene spesso considerata un ripensamento, ma avere registrazioni dettagliate di ciò che ogni parte del tuo sistema di intelligenza artificiale dovrebbe fare, insieme a note su bug e correzioni precedenti, può essere un vero toccasana durante il debug. Questa pratica consente a qualsiasi sviluppatore di comprendere rapidamente le decisioni prese nelle prime fasi del ciclo di sviluppo. Inoltre, documentare le sessioni di debug può aiutare a identificare i problemi ricorrenti e comprendere il comportamento a lungo termine dei tuoi strumenti di intelligenza artificiale.

Stabilire canali di comunicazione chiari

In un ambiente di squadra, la comunicazione efficace è fondamentale. Devono essere stabiliti canali chiari per segnalare, discutere e risolvere i bug. Ciò include riunioni regolari, formati di reporting concisi e dashboard condivisi. Inoltre, la creazione di una cultura che incoraggi la discussione aperta sui bug può promuovere un approccio più collaborativo ed efficiente per risolverli.

Sfrutta la registrazione e il monitoraggio automatizzati

L'implementazione di strumenti di registrazione e monitoraggio automatizzati può fornire informazioni coerenti e obiettive sul comportamento della tua intelligenza artificiale. Questi strumenti sono in grado di rilevare anomalie e problemi di prestazioni in tempo reale, il che è essenziale sia per la risoluzione immediata dei problemi che per la manutenzione a lungo termine. Inoltre, il monitoraggio avanzato può aiutare a identificare i modelli che portano a bug, fornendo dati preziosi per prevenirli nei futuri cicli di sviluppo.

Utilizza i flag di funzionalità per una distribuzione più sicura

L'introduzione dei flag di funzionalità consente di implementare gradualmente nuove funzionalità e controllare chi può accedervi. Questa pratica può contenere l'impatto dei bug non rilevati esponendoli inizialmente a una piccola base di utenti. Inoltre, se viene identificato un bug dopo il rilascio, i flag di funzionalità consentono di eseguire facilmente il rollback senza influenzare altri aspetti dell'applicazione AI.

Apprendimento e adattamento continui

Il debug non riguarda solo la correzione di ciò che è rotto. Si tratta di imparare dagli errori e di migliorare i processi. Un debugger efficiente si terrà al passo con i nuovi strumenti, tecniche e piattaforme che possono semplificare e migliorare il flusso di lavoro. Ad esempio, piattaforme come AppMaster offrono una soluzione no-code per sviluppare e distribuire rapidamente strumenti di intelligenza artificiale con funzionalità integrate per il debug e il monitoraggio, riducendo significativamente le risorse spese per queste attività.

Mantenere una sana mentalità di debug

Infine, mantieni una mentalità positiva e curiosa. Vedere i bug come sfide piuttosto che come problemi può essere motivante. Ricorda che ogni bug è un'opportunità per comprendere meglio il sistema AI e migliorarne la robustezza. Mantieni la pazienza e affronta sempre il debug in modo metodico ma creativo.

Implementando questi suggerimenti e perfezionando continuamente i processi di debug, puoi garantire un flusso di lavoro più fluido ed efficiente, che porta infine allo sviluppo di applicazioni IA affidabili e ad alte prestazioni.

Manutenzione degli strumenti AI dopo il debug

Dopo aver attraversato con successo il labirinto del debug degli strumenti di intelligenza artificiale, il viaggio non termina qui. Come un orologio finemente realizzato, gli strumenti di intelligenza artificiale richiedono manutenzione e supervisione continue per garantire che funzionino al massimo delle prestazioni. Qui, approfondiamo un approccio sensato per il mantenimento degli strumenti di intelligenza artificiale dopo il rigoroso processo di debug, offrendoti strategie per rendere il tuo investimento a prova di futuro e garantire risultati persistenti e coerenti.

Monitoraggio continuo delle prestazioni del modello

I modelli di intelligenza artificiale sono suscettibili alla “deriva del modello” poiché i dati e le circostanze del mondo reale si evolvono nel tempo. È fondamentale implementare un meccanismo per il monitoraggio continuo delle prestazioni. Tali sistemi avvisano gli sviluppatori di potenziali diminuzioni di precisione o efficacia, consentendo aggiustamenti tempestivi. Questo approccio vigile fa sì che i modelli mantengano la loro rilevanza e continuino a fornire informazioni preziose.

Aggiornamenti regolari a modelli e set di dati

L'appetito dell'intelligenza artificiale per i dati è insaziabile e le sue prestazioni sono intrinsecamente legate alla qualità e al volume delle informazioni acquisite. Pertanto, è fondamentale fornire dati nuovi e di alta qualità e rivisitare e perfezionare i modelli. Man mano che emergono nuovi modelli e quelli vecchi svaniscono, i tuoi strumenti di intelligenza artificiale dovrebbero evolversi per rimanere in sintonia con questi cambiamenti. La riqualificazione periodica con dati aggiornati non è solo consigliata; è necessario per rimanere competitivi ed efficaci.

Test e validazioni continui

Sebbene tu abbia risolto i problemi durante la fase di debug, non c'è motivo di abbandonare il toolkit di test. Come una sentinella vigile, devi testare e convalidare continuamente i tuoi modelli di intelligenza artificiale rispetto a nuovi scenari, casi limite e set di dati. Le pipeline di test automatizzati possono essere di grande aiuto in questo caso, diventando i tuoi implacabili alleati nel mantenere la resilienza e l'affidabilità dei tuoi strumenti di intelligenza artificiale.

Documentazione e monitoraggio delle versioni

Mantenere una documentazione meticolosa non è semplicemente un esercizio di due diligence: è un faro per chiunque interagirà con il tuo sistema in futuro. Registrazioni chiare di modifiche, decisioni e alterazioni dell'architettura creano una roadmap in grado di guidare i team di manutenzione, ridurre i tempi di onboarding per i nuovi sviluppatori e aiutare in modo significativo quando si verificano problemi imprevisti.

Adattarsi al feedback degli utenti e ai cambiamenti del mercato

Uno strumento di intelligenza artificiale, per quanto tecnicamente competente, deve in definitiva soddisfare le esigenze e risolvere i problemi dei suoi utenti. Ottenere e agire in base al feedback degli utenti è fondamentale per garantire che l'intelligenza artificiale rimanga pertinente e incentrata sull'utente. Allo stesso modo, il mercato in cui opera è dinamico e per restare al passo è necessario che l’intelligenza artificiale si adatti ai cambiamenti normativi, alle pressioni competitive e ai progressi tecnologici.

Implementazione di controlli di etica e pregiudizi

Il profondo impatto dell’intelligenza artificiale si estende ulteriormente ai territori etici e ai potenziali pregiudizi. Audit e controlli continui per correggere gli squilibri dei dati, eliminare i pregiudizi e garantire risultati equi ed etici sono responsabilità non negoziabili per i custodi degli strumenti di intelligenza artificiale.

Il ruolo di AppMaster

Piattaforme come AppMaster possono fungere da risorse preziose fornendo una base per lo sviluppo rapido di applicazioni no-code e una facile iterazione nel mantenimento degli strumenti di intelligenza artificiale dopo il debug. La perfetta integrazione delle funzionalità AI con i componenti tradizionali delle app aiuta a bilanciare innovazione e stabilità. Con la generazione automatizzata del codice, AppMaster aiuta a ridurre al minimo i costi di manutenzione, consentendo ai team di concentrarsi su attività a valore aggiunto come il miglioramento del modello e l'ottimizzazione delle prestazioni.

Seguendo queste strategie, puoi promuovere un livello coerente di prestazioni per i tuoi strumenti di intelligenza artificiale rimanendo agile e preparato per la continua evoluzione del campo dell'intelligenza artificiale. Questo piano di manutenzione proattivo non mira solo a preservare la funzionalità, ma anche a far avanzare e migliorare i tuoi strumenti di intelligenza artificiale per soddisfare e superare le richieste di domani.

Conclusione: una tabella di marcia verso applicazioni IA impeccabili

Nello sviluppo di strumenti di intelligenza artificiale, il debug è una parte indispensabile per creare applicazioni intelligenti e affidabili. È un processo che richiede sia un'attenzione meticolosa ai dettagli tecnici sia un'ampia comprensione dei sistemi complessi. Addentrandoci nel sofisticato mondo del debugging dell'intelligenza artificiale, abbiamo visto che non si tratta solo di correggere gli errori. Piuttosto, è un'opportunità per ottimizzare le prestazioni, migliorare la precisione e, in definitiva, avere fiducia nelle soluzioni di intelligenza artificiale che creiamo.

La tabella di marcia verso applicazioni IA impeccabili è chiara ma richiede dedizione ed esecuzione strategica. Inizia con la comprensione delle sfide uniche presentate dai sistemi di intelligenza artificiale. Abbraccia la complessità dei comportamenti basati sui dati, mantieni un occhio vigile sulle prestazioni del modello e utilizza il debug come obiettivo per perfezionare e comprendere le sfumature della tua intelligenza artificiale. Le tattiche condivise in questo discorso, dalla creazione di un ambiente affidabile alla selezione delle giuste strategie di debug, ti guidano verso un flusso di lavoro efficiente.

Gli strumenti di intelligenza artificiale possono essere estremamente complessi e nessun singolo percorso di debug sarà uguale. Pertanto, è essenziale mantenere un senso di flessibilità e di apprendimento continuo. Tieniti aggiornato con le tendenze, gli strumenti e le metodologie più recenti nel debug dell'intelligenza artificiale. E ricorda, l'elemento umano, ovvero la tua intuizione e competenza, sarà sempre una risorsa preziosa se combinato con l'intelligenza e l'automazione fornite da piattaforme come AppMaster. Qui troverai un equilibrio tra le capacità avanzate degli strumenti automatizzati e il discernimento di uno sviluppatore esperto.

Infine, non è da sottovalutare la manutenzione delle applicazioni AI post-debug. Hai lavorato duramente per raggiungere uno stato di bug minimi e operazioni fluide, ed è fondamentale preservarlo monitorando, aggiornando e testando i tuoi sistemi in modo coerente.

La tabella di marcia per padroneggiare il debug degli strumenti di intelligenza artificiale non è un percorso lineare ma un ciclo di miglioramento continuo. Richiede una sinergia tra tecnologie all'avanguardia, come le soluzioni no-code fornite da AppMaster, e le insostituibili capacità creative di risoluzione dei problemi degli sviluppatori. Seguendo questa tabella di marcia, gli sviluppatori possono garantire che le loro applicazioni di intelligenza artificiale non solo funzionino, ma operino al massimo del loro potenziale, fornendo valore e innovazione in un mondo tecnologicamente dinamico.

FAQ

Il debug degli strumenti di intelligenza artificiale implica la complessità dei comportamenti basati sui dati, il che significa che è necessario considerare la qualità dei dati, l'architettura del modello e i processi di formazione durante il debug.

Alcune delle sfide più comuni includono l’overfitting, l’underfitting, la distorsione dei dati e la gestione di risultati non deterministici.

Un ambiente di debug AI affidabile include il controllo della versione per codice e dati, una convalida approfondita dei dati e strumenti per il monitoraggio e la visualizzazione degli esperimenti.

Le strategie includono l'utilizzo di un approccio modulare, la semplificazione del modello, la visualizzazione del comportamento del modello e l'impiego di tecniche come test unitari e integrazione continua.

Sebbene gli strumenti automatizzati possano aiutare notevolmente il processo, l’intuizione umana gioca un ruolo chiave nella comprensione del contesto, nell’interpretazione dei dati e nel prendere decisioni strategiche.

AppMaster fornisce una piattaforma no-code che semplifica lo sviluppo e il debug di applicazioni IA con strumenti di debug visivo e generazione automatizzata di codice.

Puoi mantenere l'efficienza concentrandoti sulla riproducibilità, rimanendo organizzato con la documentazione e dando priorità al debug dei bug di maggiore impatto.

La manutenzione post-debug dovrebbe comportare un monitoraggio continuo, aggiornamenti regolari del modello e del set di dati e test continui per prevenire nuovi problemi.

Sì, le tecniche di intelligenza artificiale possono essere applicate per automatizzare alcuni aspetti del processo di debug, come il rilevamento delle anomalie e la manutenzione predittiva.

L'analisi di casi di studio del mondo reale può fornire approfondimenti su strategie efficaci ed errori comuni, fornendo conoscenze pratiche per il debug degli strumenti di intelligenza artificiale.

Le insidie comuni includono trascurare la qualità dei dati, ignorare le distorsioni del modello, complicare eccessivamente il modello e non riuscire a convalidare i risultati rispetto agli scenari del mondo reale.