デバッグ インテリジェンス: AI ツールのコーディングに関するヒントとコツ

AI ツールをコーディングするための専門的なヒントとコツを活用して、AI ツールのデバッグ技術をマスターしましょう。 AI アプリケーションのパフォーマンスと精度を強化します。

デバッグは ソフトウェア開発 の重要なコンポーネントであり、ソフトウェアの正常な機能を妨げるバグ、パフォーマンスのボトルネック、その他の問題を診断して修正する体系的なプロセスです。人工知能 (AI) ツールに関しては、これらのデータ駆動型システムによってもたらされる特有の課題により、デバッグの複雑さは大幅に増加します。

従来のソフトウェアとは異なり、AI ツールはトレーニングの対象となるデータの品質と複雑さに大きく依存しています。これらには、このデータから学習し、学習に基づいて予測を行ったりアクションを実行したりする高度なアルゴリズムが含まれます。したがって、AI をデバッグするには、プログラミングとソフトウェア エンジニアリングの技術的な理解と、機械学習、深層学習、自然言語処理などの特定の AI ドメインの把握が必要です。

AI ツールのデバッグの中心となるのは、透明性と信頼性の追求です。 AI 開発者とエンジニアは、AI アプリケーションが期待どおりに動作し、設計されたタスクを信頼できるものにするために、AI アプリケーションの「ブラック ボックス」の性質をわかりやすく理解するよう努めています。これには、AI モデルの厳密なテスト、データ パイプラインの徹底的な検査、結果の検証、展開された AI アプリケーションの継続的な監視が含まれます。

AI ツールを効果的にデバッグするには、生データの前処理、特徴抽出、モデルのトレーニングからハイパーパラメーターの調整とモデルのデプロイに至るまで、複雑な抽象化レイヤーをナビゲートする必要があります。予期せぬ動作や結果の原因を系統的に追跡することが重要です。予期せぬ動作や結果は、アルゴリズム エラー、データ破損、モデルの過剰適合などのさまざまな要因に起因する可能性があります。

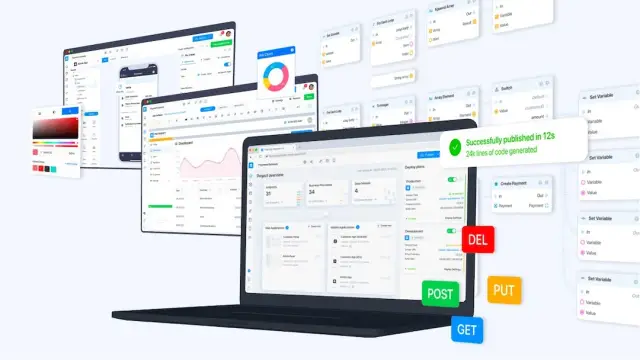

この複雑な検出と修正のプロセスでは、バージョン管理、インタラクティブな開発環境、視覚化ツール、モジュール式コーディングなどのツールと実践が極めて重要な役割を果たします。さらに、 AppMaster のような ノーコード プラットフォームを採用すると、ビジュアルな開発環境が提供され、多くの日常的なコーディング タスクが自動化されるため、AI ツールの迅速な開発とデバッグが容易になります。

AI ツールのデバッグの微妙なニュアンスをさらに深く掘り下げる場合、これは反復的で多くの場合複雑な作業であり、忍耐、スキル、鋭い分析心が必要とされる作業であることを理解することが重要です。次のセクションでは、AI に特有の課題、効果的なデバッグのための戦略、自動化と人間の洞察の役割、およびこれらの技術の実際の応用例に焦点を当てた実世界のケーススタディを検討します。

AI 固有のデバッグの課題を理解する

AI システムには独特の特性があり、デバッグが特に複雑になります。通常、バグはコードベースの論理エラーや問題に起因する従来のソフトウェアとは異なり、AI システムはコードをデータおよび学習アルゴリズムと結びつけます。このブレンドにより、特殊なデバッグ技術を必要とする一連の複雑な課題が生じます。

データは、トレーニングに使用される AI モデルの動作を主に決定します。したがって、AI 固有のデバッグは、多くの場合、このデータを徹底的に調べることから始まります。よくある問題は、トレーニング セットにバイアスが存在することです。これにより、歪んだ予測や不公平な予測が生じる可能性があります。デバッグでは、これらのバイアスを特定し、その根本原因と影響を理解し、新しい問題を引き起こすことなく問題を修正する必要があります。

AI デバッグにおけるもう 1 つの重要な課題は、多くの AI アルゴリズムの確率的性質に対処することです。ランダムな初期化や確率的勾配降下法などのトレーニング プロセスの固有の変動により、同じ入力データであっても結果が異なる場合があります。そのため、問題を再現することはイライラするほど難しい場合があり、徹底した調査のために一貫した動作を保証するには、統計的手法を採用するか、初期シードを修正する必要があります。

オーバーフィッティングとアンダーフィッティングは表裏の関係にあり、デバッグ プロセスを複雑にします。過学習は、モデルが複雑すぎる場合に発生し、パターンから一般化するのではなく、ノイズや外れ値を含むトレーニング データを記憶することを学習します。逆に、過小適合は、データの基礎となる構造を捕捉できない単純すぎるモデルから生じます。これらの問題をデバッグするには、モデルの複雑さを微調整する必要があり、多くの場合、相互検証や正則化手法によって行われます。

モデルの解釈可能性も大きな課題となります。ディープ ニューラル ネットワークなどの一部の AI モデルは、意思決定方法を正確に理解することが難しいため、「ブラック ボックス」と呼ばれることがあります。根本的な問題に対処するには、モデルの出力の背後にある理由を理解することが重要であるため、これはデバッグにおいて重大な障害となる可能性があります。特徴重要度分析、モデルの蒸留、ネットワーク層の視覚化などの手法により、これらの複雑なモデルの暗い部分に光を当てることができることがあります。

最後に、AI ツールとフレームワークの急速に進化する性質により、デバッグは常に移動するターゲットになる可能性があります。頻繁なアップデートと新しいベスト プラクティスにより、開発者は、新しいリリースですでに解決されている問題に直面していないか、デバッグ ツールがこの分野の最新の進歩に沿っているかどうかを確認するために、常に注意を払う必要があります。

AI ツールのデバッグには、ドメインの専門知識、体系的な分析、そして多くの場合、少しの創造性の組み合わせが必要です。 AI 開発者として、これらの AI 固有の課題を理解し、体系的に取り組む準備をすることで、デバッグ プロセスを大幅に強化し、より信頼性の高い AI アプリケーションを実現できます。

信頼性の高いデバッグ環境のセットアップ

AI ツールの開発では、作成段階や問題が発生した場合に、細部にまで細心の注意を払う必要があります。 AI システムを効果的にデバッグするには、開発者は AI アルゴリズムとデータセットの複雑さを処理する体系的な環境を必要とします。次のテクニックは、そのような環境を確立し、AI ツール内で問題を特定、分離、解決する能力を強化するためのガイドとなります。

まず、コードとデータセットの両方に対して バージョン管理されたワークスペース を作成します。 Git などのバージョン管理システムは、変更を追跡し、新しいバグが導入された場合に以前の状態にロールバックできるようにします。さらに、DVC (データ バージョン コントロール) のようなツールは、データセットの管理とバージョン管理に特に使用できます。これは、データが AI システムの問題の中心となることが多いため、非常に重要です。

デバッグ環境に データ検証が 含まれていることを確認してください。データ品質は最も重要です。モデルに入力する前に、正確性、一貫性、バイアスがないことを検証する必要があります。信頼性の高いセットアップには、定期的に、または各トレーニング セッションの前にデータの整合性をチェックする自動スクリプトが組み込まれます。この予防策は、データ処理に関連する多くの問題を防ぐのに役立ちます。

もう 1 つの重要な要素は、 実験の追跡 を設定することです。 AI の開発には、さまざまなハイパーパラメーター、データセット、モデル アーキテクチャを使用した多くの実験が含まれます。 MLflow、Weights & Biases、TensorBoard などのツールを使用すると、さまざまな実験を追跡、視覚化、比較できます。この体系的なアプローチは、モデルの動作を理解し、特定の変更がバグにつながった理由を特定するのに役立ちます。

さらに、 継続的な統合とテストの 実践を活用します。これらは従来のソフトウェア開発だけではありません。これらは AI においても同様に重要です。自動テストにより、AI システムの小さな部分が変更後に期待どおりに動作することを確認できます。継続的インテグレーション サーバーは、コードベースへの新しいコミットでデータ検証、トレーニング スクリプト、テストを自動的に実行し、問題があればすぐに警告します。

視覚化ツールは、 AI アプリケーションのデバッグに不可欠な部分を形成します。たとえば、ツールを使用してニューラル ネットワークの計算グラフを視覚化すると、どこで問題が発生しているかを確認するのに役立ちます。同様に、データの分布、モデルの予測と実際の結果、およびトレーニング メトリクスを視覚化すると、バグを示す可能性のある不一致を浮き彫りにすることができます。

最終的には、データ ソース、モデル アーキテクチャ、仮定、実験結果、および実行されたトラブルシューティング手段に関する詳細を含む 包括的なドキュメント で技術ツールを補完します。このリソースは、現在のデバッグと将来のメンテナンスと更新にとって非常に貴重であることが判明し、開発作業の明確さと継続性を提供します。

これらの戦略とAppMasterのno-code機能を組み合わせることで、開発者は AI システムのバグを大幅に減らすことができます。このプラットフォームのビジュアル ツールと自動コード生成により、エラーが発生しやすい AI 開発の側面が簡素化され、開発者が高品質の AI アプリケーションを簡単に作成、展開、保守できるようになります。

機械学習モデルのデバッグ戦略

機械学習 (ML) モデルはブラック ボックスのように見える場合があり、デバッグの際に特有の課題が生じます。従来のソフトウェアを悩ませることが多い系統的な論理エラーとは異なり、ML モデルはデータ品質、モデル アーキテクチャ、トレーニング手順に根ざした問題に悩まされています。 ML モデルを効果的にデバッグするには、開発者はこれらの独特の複雑さに対処する戦略的アプローチを採用する必要があります。

強固な基盤から始める: データ検証

デバッグの計算面を詳しく調べる前に、データが正しく、十分に準備されていることを確認することが重要です。欠損値、一貫性のない書式設定、異常値などの問題により、モデルのパフォーマンスが大きく歪む可能性があります。この最初のステップには、厳密なデータのクリーニング、正規化、拡張の実践に加えて、データセット内の潜在的なバイアスやエラーを浮き彫りにする可能性のあるデータ分散の健全性チェックが含まれます。

明確化のための単純化: モデルの削減

問題のあるモデルに直面した場合は、その複雑さを軽減して問題を切り分けます。機能の数を減らしたり、アーキテクチャを簡素化したりすることで、問題が発生している箇所を特定できることがよくあります。縮小モデルでも引き続き問題が表示される場合は、使用されているデータまたは機能に問題がある可能性があります。逆に、単純化によって問題が解決する場合は、元のモデルの複雑さが原因である可能性があります。

視覚化して理解する: エラー分析

視覚化ツールを活用してエラー パターンを分析します。学習曲線をプロットすると、過学習や過小学習などのモデルの能力の問題が示される可能性があります。分類タスクの混同行列と受信者動作特性 (ROC) 曲線を調べることは、モデルが問題を抱えているクラスを特定するのに役立ち、パフォーマンスを向上させるためにより微妙な特徴や追加データが必要な領域を示唆します。

再現性の確保: バージョン管理と実験の追跡

デバッグを効果的に行うには、それぞれの実験が再現可能である必要があります。 Gitのようなバージョン管理システムは、コードだけでなく、データセットやモデル構成の変更を追跡するためにも使用する必要があります。実験追跡ツールは、さまざまな実行を比較し、変更の影響を理解し、モデルの改善に体系的にアプローチするために不可欠です。

従来の手法: 単体テストと継続的インテグレーション

ソフトウェア エンジニアリングのベスト プラクティスを ML 開発に適用することは見落とされがちですが、非常に重要です。データ処理パイプラインと個々のモデル コンポーネントの単体テストを実装して、それらが期待どおりに機能することを確認します。継続的インテグレーション (CI) パイプラインは、これらのテストを自動的に実行し、開発サイクルの早い段階でエラーを検出するのに役立ちます。

プロービングによるデバッグ: 診断ツールの使用

診断ツールは、モデルの動作をさらに詳しく調べるのに役立ちます。特徴量重要度分析や部分依存プロットなどの手法により、どの特徴量がモデルの予測に最も大きな影響を与えるかについての洞察が明らかになります。さらに、より単純なモデルが複雑なモデルの予測に近似するようにトレーニングされるモデルの蒸留では、元のモデルがトレーニング データのどの側面に焦点を当てているかが強調表示されるため、誤ったラベルが付けられたデータや強調されすぎた特徴の発見につながる可能性があります。

アンサンブルの力: モデルを組み合わせて洞察を得る

デバッグはモデル アンサンブルから行うこともできます。さまざまなモデルを組み合わせることで、それらのコンセンサスを評価し、他のモデルから大きく逸脱している個々のモデルを特定できます。これは、その特定のモデルのトレーニングまたはデータ処理内の問題の兆候である可能性があります。

人間中心のデバッグ: ドメインの専門家と協力する

AI をデバッグするときに人間が蚊帳の外に置かれるべきではありません。データを理解し、モデルの出力が意味があるかどうかについて貴重な洞察を提供できる分野の専門家と協力してください。これらは、純粋にデータ駆動型のメトリクスでは気づかれない可能性のある不正確さを特定するのに役立ちます。

反復的な改善が鍵

結局のところ、ML モデルのデバッグは反復的なプロセスです。各ループにより、モデルとモデルが学習するデータについてより深く理解できます。これらの戦略はガイドラインを提供しますが、特定のプロジェクトのコンテキストと開発している ML モデルの種類に適応させる必要があります。 AppMasterのようなno-codeプラットフォームを使用することを忘れないでください。これは、モデル開発の初期段階を合理化し、さらなるデバッグと改良のための基盤を提供するツールを提供します。

よくある落とし穴とその回避方法

AI の複雑さと多様性が増すにつれ、開発者はデバッグ プロセスを狂わせる可能性のある固有の課題に頻繁に直面します。効果的な AI ツールを作成および維持するには、これらの落とし穴を認識して回避することが重要です。ここでは、AI ツールのデバッグにおける最も一般的な落とし穴のいくつかを掘り下げ、それらを回避する戦略を紹介します。

モデルの一般化を無視する

AI 開発で最も一般的な問題の 1 つは、トレーニング データに対して非常に優れたパフォーマンスを発揮するモデルを作成しても、新しいまだ見たことのないデータに一般化できない、つまり過剰学習に失敗するモデルを作成することです。 これを回避するには、次のことが重要です。

- モデルが遭遇する現実世界の状況を反映する包括的なデータセットを利用します。

- 相互検証や正則化などの手法を採用します。

- 検証データセットとテスト データセットでモデルを継続的にテストします。

データ品質の見落とし

ゴミが入って、ゴミが出る。この自明の理は、特に AI に当てはまります。 データ品質が低いと、 モデルのパフォーマンスが完全に歪む可能性があります。この落とし穴を回避するには:

- データのクリーニングと前処理を徹底的に行います。

- 異常検出を実装して、異常値や不正な値を検出します。

- 偏見を避けるために、多様で代表的なデータを収集することに重点を置きます。

バージョン管理の欠如

AI モデルとデータセットのバージョン管理を綿密に行わないと、結果の再現と変更の追跡が煩雑になります。バージョン管理と実験管理用のツールを活用すると、次のことが可能になります。

- データの改訂、モデルのパラメーター、コードの変更の詳細なログを保存します。

- 開発プロセスを整理して、デバッグ セッション間で一貫性を維持します。

モデルの複雑さを過小評価する

複雑なモデルが常に優れているわけではありません。単にデバッグが難しいだけの場合もあります。単純なものから始めて、必要な場合にのみ徐々に複雑さを増していきます。より単純なモデルに依存すると、多くの場合、より透明性が高く解釈可能な結果が得られ、デバッグ プロセスがより管理しやすくなります。

デバッグツールの無視

特殊なデバッグ ツールを使用しないと、トラブルシューティングにかかる時間が大幅に長くなる可能性があります。 AppMasterのようなプラットフォームを利用すると、開発者がコードを深く掘り下げることなくビジネス プロセスとデータ フローを視覚化できるビジュアル デバッグ ツールと機能により、開発を合理化できます。

これらの一般的な落とし穴を予測し、それに対抗する戦略を実装することで、開発者は AI ツールのデバッグによく伴うフラストレーションの多くを軽減し、よりスムーズで効率的なデバッグ セッションへの道を開くことができます。

AI デバッグにおける自動化ツールと人間の直感

AI では、デバッグは体系的な論理エラーを超えて、データとモデルの動作の微妙な解釈を含みます。自動デバッグ ツールの台頭は、開発者が AI の問題解決に取り組む方法の変革を示唆しています。しかし、高度な進歩にもかかわらず、デバッグ プロセス全体を通じて人間の直感は依然として不可欠な資産です。このセクションでは、AI デバッグの分野における自動化ツールと人間の直感の間の動的な相互作用について詳しく説明します。

AI デバッグの自動ツールは防御の第一線として機能します。彼らは、手動で対処すると貴重な時間を費やす可能性がある、構文エラー、例外、実行時エラーなどの単純なバグを特定することに熟達しています。 AI 自体を活用したこれらのツールは、膨大なコードを迅速に分析して異常を特定することでテストを効率化できます。予測分析や異常検出アルゴリズムなどのテクノロジーは、パターンを識別して問題が完全に顕在化する前に予測する可能性を秘めており、トラブルシューティング プロセスにおける予防策として効果的に機能します。

ただし、AI システムはその複雑さと独自性によって定義されます。彼らはデータに基づいて学習し、適応します。自動化ツールは、データ品質、モデル アーキテクチャ、ハイパーパラメータ調整の微妙な点など、AI の問題の抽象的な性質に直面するとたじろぐ可能性があります。ここで人間の直感と専門知識が役に立ちます。人間の開発者は、技術的な知識、コンテキストの微妙な理解、構造化されていない問題について仮説を立てる能力、創造的な問題解決スキルを発揮します。

場合によっては、AI のまったくの予測不可能性により、明らかではない矛盾を取り除くために、人間の情報に基づいた推測が必要になります。たとえば、AI モデルが予期しない結果を生成した場合、自動化ツールは異常を報告できますが、多くの場合、開発者は直観によって根本的な原因を導きます。それがトレーニング データの問題であれ、モデルの過剰適合であれ、あるいはもっと隠蔽された問題であれ、データの前処理段階における微妙なロジックのバグ。

さらに、自動デバッグの結果を解釈する際には、人間による監視が非常に重要です。システムへの潜在的な影響に基づいて、どのバグを追求する価値があるかを優先するには、人間の判断が必要です。さらに、AI システムのデバッグでは、自動化ツールでは本質的に対処できない倫理的考慮事項 (プライバシー侵害や偏った結果など) が発生する可能性があります。開発者は、人間的な共感と倫理的推論を備えているため、これらのデリケートな領域をナビゲートするのに最適な立場にあります。

自動化ツールは人間の開発者に取って代わることではなく、その能力を強化することを目的としているということを認識することが重要です。たとえば、 AppMasterプラットフォーム内では、自動化ツールによりno-code開発とデバッグのプロセスが簡素化されます。このプラットフォームの機能により視覚的なデバッグが可能になり、開発者はデータ フローとロジック パスをより直観的に観察および操作できるようになります。このように、 AppMaster自動化システムと人間の洞察力の間の相乗効果を証明しており、両方の強みを活用する協力的な問題解決モデルを示しています。

自動化ツールは日常的なデバッグタスクの効率と速度を提供しますが、AI システムの複雑さを処理するために依然として重要である人間の直感の必要性を否定するものではありません。自動化されたソフトウェアと人間の専門知識が調和して融合することで、デバッグ プロセスが高速化されるだけでなく、最終結果としてより信頼性が高くパフォーマンスの高い AI ツールが保証されます。 AI が進化し続けるにつれて、その複雑さを解明することを目的とした方法論やツールのリポジトリも進化し、その中心には常に人間の要素が含まれます。

ケーススタディ: AI の動作をデバッグする

最も綿密に設計された AI システムであっても、実際のデータやシナリオと対話すると、予期しない動作やエラーが発生する可能性があります。ケーススタディを検討することで、開発者は成功するデバッグ戦略について洞察を得ることができ、より信頼性が高く強力な AI ツールを作成するためのアプローチを洗練させることができます。 AI デバッグの複雑さを明らかにする注目すべき事例をいくつか掘り下げてみましょう。

- ケーススタディ 1: 予測モデルでの過学習の診断: ある小売会社は、過去の販売データに基づいて将来の製品需要を予測するための機械学習モデルを開発しました。ただし、モデルの予測は実際の結果と一致していませんでした。開発者は、トレーニング段階でモデルが過剰適合し、基礎となるパターンではなくトレーニング データ内のノイズと異常を学習していることを発見しました。彼らは相互検証などの手法を使用し、過学習を軽減するために正則化パラメータを導入しました。その結果、目に見えないデータをより適切に一般化するモデルが生まれました。

- ケーススタディ 2: 顔認識ソフトウェアにおけるデータ バイアスへの取り組み: ある AI 企業は、自社の顔認識ソフトウェアにバイアスがあり、特定の人口統計グループでのパフォーマンスが低かったため、世間の反発に直面しました。デバッグ中に、チームはトレーニング データに多様性が欠けていることに気付きました。より代表的なデータを収集し、公平性アルゴリズムを採用することで、ソフトウェアの精度が向上し、バイアスが減少し、AI モデルのトレーニングにおけるデータの品質と多様性の重要性が実証されました。

- ケーススタディ 3: 自然言語処理の精度の向上: 新興企業が開発した 自然言語処理 (NLP) ツールは、顧客のフィードバックを正確に分類していませんでした。デバッグ プロセスにより、モデルで使用されている単語の埋め込みが、特定の業界固有の用語のコンテキストを捉えるには不十分であることが明らかになりました。このスタートアップは、単語の埋め込みをカスタマイズし、トレーニング セットにドメイン固有のデータを含めることで、顧客の感情を理解するツールの精度を大幅に向上させました。

- ケーススタディ 4: 自動運転車のアルゴリズムのデバッグ: 自動運転車を専門とする会社は、特定の気象条件で自動車が一時停止標識を誤って解釈するという重大な問題に遭遇しました。デバッグの結果、視覚アルゴリズムが色の検出に過度に依存していることが判明しました。エンジニアは、より状況に応じた手がかりとセンサー フュージョン技術を統合することで、AI による交通標識の解釈の信頼性をさらに高めることができました。

各ケーススタディでは AI デバッグの独特な側面を強調し、開発者が遭遇する可能性のあるさまざまな課題を浮き彫りにしています。データセットの品質、モデルの複雑さ、アルゴリズムの偏り、システムの適応性など、戦略的なデバッグを通じてこれらの問題を認識し、対処することが不可欠です。ケーススタディは貴重な教訓を提供しますが、 AppMasterなどのプラットフォームは、AI ツールの構築とデバッグの複雑さを軽減することで開発者を支援し、コーディングの経験がほとんどない開発者でも、現実世界の AI の課題から教訓を学び、応用できるようにします。

デバッグ手法とAppMasterの統合

AI ツールを開発する場合、アプリケーションのパフォーマンス、信頼性、精度を確保するには、適切なデバッグが不可欠です。現在、開発者は従来のデバッグ シナリオに取り組むための多くのテクニックを習得しています。ただし、AI はデータ中心の性質と、多くの場合不透明な意思決定プロセスにより、複雑な課題をもたらします。開発プロセスを簡素化し強化する計り知れない可能性を考えると、AI デバッグをAppMasterのようなno-codeプラットフォームと統合することで、AI 固有の複雑さから生じる可能性のある複雑な問題を解決するためのシームレスで効率的な道が提供されます。

AppMaster Web、モバイル、バックエンド アプリケーションの作成の合理化に優れたno-code開発プラットフォームです。 AppMasterを利用することで、開発者には AI デバッグ戦略を強化できる強力なツール セットが提供されます。

- 視覚化: AI をデバッグするには、多くの場合、データの関係とモデルの動作を理解する必要があります。 AppMaster 、複雑なロジックを理解しやすく変更可能なビジュアル コンポーネントに変換できる ビジネス プロセス (BP) デザイナー などのビジュアル ツールを開発者に提供します。これは、データ処理と AI モデル推論の正確さを評価するためにワークフローと意思決定ポイントを視覚化する必要がある AI アプリケーションで特に役立ちます。

- 自動テスト: デバッグは一度だけで完了するプロセスではなく、継続的な再評価が必要です。このプラットフォームは、開発者が変更のたびにテストを効率的に作成して実行できるようにする自動テスト機能を提供し、AI のコア機能が損なわれず、潜在的な回帰が早期に検出されることを保証します。

- モジュール性: AI のデバッグでは、アプリケーションの特定の部分を反復的にオーバーホールし、他の部分はそのままにしておく必要がある場合があります。 AppMasterアプリケーションをさまざまなマイクロサービスにセグメント化する機能を通じてモジュール性を促進します。 AI ツールのコックピット領域は、アプリケーション全体の動作を妨げることなく、集中的なデバッグのために分離できます。

- データの整合性: AI ツールを支えるデータは厳密に検証される必要があります。データのエラーは必然的に AI の誤った動作につながります。 AppMaster 、典型的なデータ関連の問題がより大規模で複雑な問題に発展する前に事前に回避できる組み込みの検証ルールなど、データの整合性を確保するためのメカニズムが組み込まれています。

- コラボレーション機能: AI ツールのデバッグは多くの場合、チームの作業です。このプラットフォームの共同環境により、複数の開発者が同時にプロジェクトに取り組むことができるため、問題が表面化したときのトラブルシューティングや修正の共同検証が容易になります。

- デプロイメントとホスティング: AppMasterを使用すると、開発者はボタンをクリックするだけでアプリケーションをデプロイできます。この迅速な導入により、ステージング環境または運用環境に似た環境で AI アプリケーションのテストとデバッグを高速に繰り返すことができ、現実世界のシナリオが確実に考慮されます。

- 分析と監視: デプロイ後、AI アプリケーションのパフォーマンスを監視することは、バグを示す可能性のある異常を特定するために不可欠です。 AppMasterアプリケーションの動作を追跡するための分析および監視ソリューションを提供し、継続的なデバッグ作業に役立つ経験的データを提供します。

さらに、 AppMasterのno-code性質により、コードの複雑さを抽象化することでデバッグ プロセスが迅速化され、開発者は構文や構造上のエラーに悩まされることなく、AI ツールのロジックとパフォーマンスに集中できるようになります。ドキュメントとオープン API 仕様を自動生成するプラットフォームの機能は、ツールの現在のビルドと動作に関してチーム全体が常に同じ認識を持っていることを保証することで、デバッグ プロセスにも役立ちます。

AI ツール開発の過程において、 AppMasterのようなプラットフォームを組み込むことはno-codeの俊敏性と洗練された AI デバッグ アプローチが調和して融合していることの証となります。これは、デバッグの複雑さがボトルネックではなく、開発の交響曲の調整された部分となるソフトウェア開発の未来を示しています。

効率的なデバッグワークフローのためのヒント

デバッグツールを合理化する

効率的なデバッグ ワークフローへの最初のステップの 1 つは、適切なツールを用意することです。インタラクティブなデバッガー、ビジュアル データ分析ツール、自動テスト スイートなど、複雑なデータ セットとアルゴリズムを処理できるプログラムが必要です。 AI 固有のプラグインと拡張機能を提供する統合開発環境 (IDE) は、時間を節約し、生産性を向上させることができます。ツールがシームレスなワークフローに統合されると、バグをより迅速に特定して解決できるようになります。

バージョン管理を採用する

バージョン管理は、コードの変更を追跡するだけではありません。 AI が動作するデータセットを管理するためにも不可欠です。 Git などのプラットフォームを使用すると、コードとデータの両方を管理できるため、変更をより適切に追跡したり、問題が発生したときに以前の状態にロールバックしたりすることができます。さらに、主要な開発ラインを妨げないように、実験的な機能やデータ変換を分岐させることができます。

バグに効果的に優先順位を付ける

すべてのバグが同じように作成されるわけではありません。機能に大きな影響を与えるものもありますが、AI アプリケーションへの影響が最小限のものもあります。バグの重大度とソフトウェアのパフォーマンスへの影響に基づいてバグを評価し、優先順位を付けることは、効率的なワークフローを維持するために非常に重要です。タスクを緊急/重要のマトリックスに分割するアイゼンハワー マトリックスを使用すると、問題を分類して優先順位を付けるのに役立ちます。

スクリプトを使用して反復的なタスクを自動化する

デバッグには、繰り返しのテストとチェックが含まれることがよくあります。これらのタスクを自動化するスクリプトを作成すると、貴重な時間を節約し、人的エラーを減らすことができます。スクリプトは事前定義されたデバッグ手順に従って実行できるため、より複雑で独特なデバッグの課題に集中することができます。継続的統合ツールを使用すると、コードまたはデータのコミットに基づいてこのようなスクリプトを自動的にトリガーできます。

すべてを厳密に文書化する

ドキュメントは後付けとして扱われることがよくありますが、過去のバグや修正に関するメモと併せて、AI システムの各部分が何をすべきかについての詳細な記録があれば、デバッグ中の救世主となる可能性があります。これにより、開発者は開発サイクルの早い段階で行われた決定を迅速に理解できるようになります。さらに、デバッグ セッションを文書化すると、繰り返し発生する問題を特定し、AI ツールの長期的な動作を理解するのに役立ちます。

明確なコミュニケーションチャネルを確立する

チーム環境では、効果的なコミュニケーションが最も重要です。バグを報告、議論、解決するための明確なチャネルを確立する必要があります。これには、定期的な会議、簡潔なレポート形式、共有ダッシュボードが含まれます。さらに、バグについてのオープンな議論を奨励する文化を築くことで、バグを解決するためのより協力的で効率的なアプローチを促進できます。

自動化されたロギングとモニタリングを活用する

自動ログおよび監視ツールを実装すると、AI の動作について一貫した客観的な洞察が得られます。これらのツールは、異常やパフォーマンスの問題をリアルタイムで検出できます。これは、即時のトラブルシューティングと長期的なメンテナンスの両方に不可欠です。さらに、高度な監視はバグにつながるパターンを特定するのに役立ち、将来の開発サイクルでバグを防ぐための貴重なデータを提供します。

より安全な展開のために機能フラグを使用する

機能フラグを導入すると、新しい機能を段階的にロールアウトし、それらの機能に誰がアクセスできるかを制御できます。この方法では、最初は小規模なユーザー ベースにバグを公開することで、未検出のバグの影響を抑えることができます。さらに、リリース後にバグが特定された場合、機能フラグを使用すると、AI アプリケーションの他の側面に影響を与えることなく簡単にロールバックできます。

継続的な学習と適応

デバッグは、壊れたものを直すだけではありません。それは間違いから学び、プロセスを改善することです。効率的なデバッガは、ワークフローを簡素化し強化できる新しいツール、テクニック、プラットフォームを常に把握します。たとえば、 AppMasterのようなプラットフォームは、デバッグと監視のための統合機能を備えた AI ツールを迅速に開発および展開するためのno-codeソリューションを提供し、これらのタスクに費やされるリソースを大幅に削減します。

健全なデバッグの考え方を維持する

最後に、前向きで好奇心旺盛な考え方を維持してください。バグを問題ではなく課題として捉えると、モチベーションが高まります。それぞれのバグは、AI システムをより深く理解し、その堅牢性を向上させる機会であることを忘れないでください。忍耐力を維持し、常に体系的かつ創造的にデバッグに取り組んでください。

これらのヒントを実装し、デバッグ プロセスを継続的に改良することで、よりスムーズで効率的なワークフローを確保でき、最終的には信頼性が高くパフォーマンスの高い AI アプリケーションの開発につながります。

デバッグ後の AI ツールのメンテナンス

AI ツールのデバッグという迷宮を無事に乗り越えた後も、旅はそこで終わりません。精巧に作られた時計と同様に、AI ツールが最高のパフォーマンスで動作するようにするには、継続的なメンテナンスと監視が必要です。ここでは、厳密なデバッグ プロセス後に AI ツールを保守するための賢明なアプローチを詳しく掘り下げ、将来の投資を保証し、永続的で一貫した結果を保証する戦略を提供します。

モデルのパフォーマンスを継続的に監視

データや現実世界の状況が時間の経過とともに進化するにつれて、AI モデルは「モデル ドリフト」の影響を受けやすくなります。継続的なパフォーマンス監視のメカニズムの実装は不可欠です。このようなシステムは、精度や効率が低下する可能性があることを開発者に警告し、タイムリーな調整を可能にします。この慎重なアプローチは、モデルがその関連性を維持し、貴重な洞察を提供し続けることを意味します。

モデルとデータセットの定期的な更新

AI のデータに対する飽くなき欲求とそのパフォーマンスは、取り込まれる情報の質と量に本質的に関連しています。したがって、新鮮で高品質のデータを供給し、モデルを再検討して改良することが重要です。新しいパターンが出現し、古いパターンが消えていくにつれて、AI ツールもこうした変化に対応できるように進化する必要があります。最新のデータを使用した定期的な再トレーニングは、単に推奨されるだけではありません。競争力と効果を維持するために必要です。

継続的なテストと検証

デバッグ段階で問題を解決したとしても、テスト ツールキットを停止する理由はありません。警戒心のある番兵のように、新しいシナリオ、エッジケース、データセットに対して AI モデルを継続的にテストし、検証する必要があります。自動テスト パイプラインはここで非常に役立ち、AI ツールの回復力と信頼性を維持するための絶え間ない味方になります。

ドキュメントとバージョン追跡

細心の注意を払って文書を維持することは、単なるデューデリジェンスの実践ではなく、将来システムを操作するすべての人にとっての目印となります。変更、意思決定、アーキテクチャ変更の明確な記録により、メンテナンス チームの指針となるロードマップが作成され、新規開発者のオンボーディング時間が短縮され、予期せぬ問題が発生した場合に大幅に役立ちます。

ユーザーのフィードバックと市場の変化への適応

AI ツールは、たとえ技術的に熟練していても、最終的にはユーザーのニーズに応え、問題を解決する必要があります。ユーザーのフィードバックを取得し、それに基づいて行動することは、AI が適切でユーザー中心であり続けるために最も重要です。同様に、AI が活動する市場は動的であり、AI が優位を維持するには、規制の変更、競争圧力、技術の進歩に適応する必要があります。

倫理と偏見のチェックの実施

AI の重大な影響は、倫理領域と潜在的な偏見にさらに広がります。データの不均衡を修正し、偏見を取り除き、公正かつ倫理的な出力を確保するための継続的な監査とチェックは、AI ツール管理者にとって交渉の余地のない責任です。

AppMasterの役割

AppMasterのようなプラットフォームはno-code迅速なアプリケーション開発と、デバッグ後の AI ツールのメンテナンスの簡単な反復のための基盤を提供することで、貴重な資産として機能します。 AI 機能を従来のアプリ コンポーネントとシームレスに統合することで、イノベーションと安定性のバランスをとることができます。 AppMasterは自動化されたコード生成により、メンテナンスのオーバーヘッドを最小限に抑え、チームがモデルの強化やパフォーマンスの最適化などの付加価値活動に集中できるようにします。

これらの戦略に留意することで、俊敏性を維持し、AI 分野の継続的な進化に備えながら、AI ツールの一貫したレベルのパフォーマンスを促進できます。このプロアクティブなメンテナンス プランは、機能を維持するだけでなく、AI ツールを進化させて向上させ、将来の需要に応え、それを超えることも目的としています。

結論: 完璧な AI アプリケーションへのロードマップ

AI ツールの開発において、デバッグはインテリジェントで信頼性の高いアプリケーションを作成するために不可欠な部分です。これは、技術的な詳細に対する細心の注意と、複雑なシステムに対する幅広い理解の両方を必要とするプロセスです。 AI デバッグの洗練された世界を掘り下げていくと、単にエラーを修正するだけではないことがわかりました。むしろ、これはパフォーマンスを最適化し、精度を高め、最終的には私たちが作成する AI ソリューションを信頼する機会です。

完璧な AI アプリケーションへのロードマップは明確ですが、献身的な努力と戦略的な実行が必要です。 AI システムによってもたらされる特有の課題を理解することから始めます。データ駆動型の動作の複雑さを受け入れ、モデルのパフォーマンスを常に監視し、デバッグをレンズとして使用して AI の微妙なニュアンスを調整し、理解します。信頼性の高い環境のセットアップから適切なデバッグ戦略の選択まで、この講演で共有された戦術は、効率的なワークフローへの導きとなります。

AI ツールは非常に複雑になる場合があり、デバッグ作業は 1 つとして同じではありません。したがって、柔軟性の感覚を維持し、継続的に学習することが不可欠です。 AI デバッグの最新のトレンド、ツール、方法論を常に最新の状態に保ちます。そして、人間の要素である直感や専門知識は、 AppMasterのようなプラットフォームによって提供されるインテリジェンスや自動化と組み合わせることで、常に貴重な資産となることを忘れないでください。ここでは、自動化ツールの高度な機能と経験豊富な開発者の洞察力の間のバランスを見つけることができます。

最後に、デバッグ後の AI アプリケーションのメンテナンスを過小評価すべきではありません。最小限のバグとスムーズな操作の状態を達成するために懸命に取り組んできました。システムを一貫して監視、更新、テストすることによって、この状態を維持することが重要です。

AI ツールのデバッグをマスターするためのロードマップは、直線的なパスではなく、継続的な改善サイクルです。それには、 AppMasterが提供するno-codeソリューションなどの最先端のテクノロジーと、開発者のかけがえのない創造的な問題解決スキルの相乗効果が必要です。このロードマップに従うことで、開発者は AI アプリケーションが機能するだけでなく、潜在能力の頂点でパフォーマンスを発揮し、技術的にダイナミックな世界で価値と革新を提供できるようになります。

よくある質問

AI ツールのデバッグには、複雑なデータ駆動型の動作が含まれるため、デバッグ中にデータの品質、モデル アーキテクチャ、トレーニング プロセスを考慮する必要があります。

一般的な課題には、過学習、過小学習、データの偏り、非決定的な出力の処理などがあります。

信頼性の高い AI デバッグ環境には、コードとデータのバージョン管理、徹底的なデータ検証、実験の追跡と視覚化のためのツールが含まれています。

戦略には、モジュール型アプローチの使用、モデルの簡素化、モデルの動作の視覚化、単体テストや継続的統合などの手法の採用が含まれます。

自動化ツールはプロセスを大いに支援しますが、コンテキストの理解、データの解釈、戦略的な意思決定には人間の直感が重要な役割を果たします。

AppMasterビジュアル デバッグ ツールと自動コード生成により、AI アプリケーションの開発とデバッグを簡素化するno-codeプラットフォームを提供します。

再現性に重点を置き、ドキュメントを整理し、影響のあるバグのデバッグを優先することで、効率を維持できます。

デバッグ後のメンテナンスには、継続的なモニタリング、モデルとデータセットの定期的な更新、および新たな問題を防ぐための継続的なテストが含まれる必要があります。

はい、AI 技術を適用して、異常検出や予知メンテナンスなどのデバッグ プロセスの特定の側面を自動化できます。

実際のケーススタディを分析すると、効果的な戦略と一般的なエラーについての洞察が得られ、AI ツールをデバッグするための実践的な知識が得られます。

一般的な落とし穴には、データ品質の無視、モデルのバイアスの無視、モデルの過度の複雑化、現実世界のシナリオに対する結果の検証の失敗などが含まれます。