Intelligentie voor foutopsporing: tips en trucs voor het coderen van AI-tools

Beheers de kunst van het debuggen van AI-tools met deskundige tips en trucs voor het coderen van AI-tools. Verbeter de prestaties en nauwkeurigheid van uw AI-applicaties.

Debuggen is een cruciaal onderdeel van softwareontwikkeling , een systematisch proces voor het diagnosticeren en oplossen van bugs, prestatieknelpunten en andere problemen die voorkomen dat software correct functioneert. Als het gaat om hulpmiddelen voor kunstmatige intelligentie (AI), neemt de complexiteit van het debuggen enorm toe vanwege de unieke uitdagingen die deze datagestuurde systemen met zich meebrengen.

In tegenstelling tot traditionele software zijn AI-tools grotendeels afhankelijk van de kwaliteit en complexiteit van de gegevens waarop ze zijn getraind. Het gaat om geavanceerde algoritmen die van deze gegevens leren en op basis van hun kennis voorspellingen doen of acties ondernemen. Bijgevolg vereist het debuggen van AI een technisch inzicht in programmeren en software-engineering en inzicht in het specifieke AI-domein – of het nu machine learning, deep learning, natuurlijke taalverwerking of andere is.

De kern van het debuggen van AI-tools is het streven naar transparantie en betrouwbaarheid. AI-ontwikkelaars en -ingenieurs streven ernaar het 'black box'-karakter van AI-toepassingen te demystificeren om ervoor te zorgen dat ze presteren zoals verwacht en dat ze kunnen worden vertrouwd met de taken waarvoor ze zijn ontworpen. Dit omvat het rigoureus testen van de AI-modellen, grondige inspectie van de datapijplijnen, validatie van resultaten en continue monitoring van de ingezette AI-toepassingen.

Om AI-tools effectief te debuggen, moet je door complexe abstractielagen navigeren – variërend van de voorverwerking van onbewerkte gegevens, extractie van functies en modeltraining tot afstemming van hyperparameters en modelimplementatie. Het is essentieel om methodisch de bron op te sporen van onverwacht gedrag of onverwachte uitkomsten, die kunnen voortkomen uit tal van factoren, zoals algoritmische fouten, datacorruptie of overfitting van modellen.

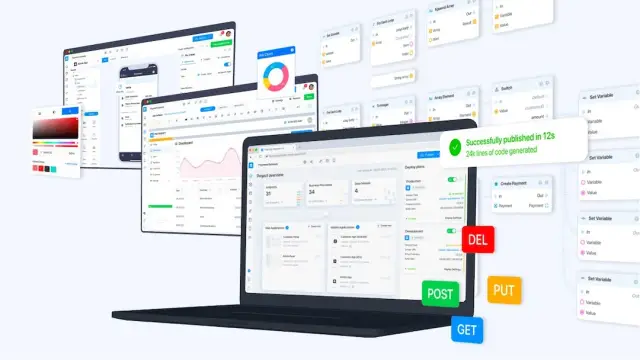

In dit ingewikkelde detectie- en correctieproces spelen tools en praktijken zoals versiebeheer, interactieve ontwikkelomgevingen, visualisatietools en modulaire codering een cruciale rol. Bovendien kan het omarmen van een no-code- platform als AppMaster de snelle ontwikkeling en het debuggen van AI-tools vergemakkelijken door een visuele ontwikkelomgeving te bieden en veel routinematige codeertaken te automatiseren.

Terwijl we dieper ingaan op de nuances van het debuggen van AI-tools, is het van cruciaal belang om te begrijpen dat het een iteratieve en vaak complexe onderneming is, een onderneming die geduld, vaardigheid en een scherpe analytische geest vereist. In de volgende paragrafen zullen de uitdagingen met betrekking tot AI worden onderzocht, strategieën voor effectief debuggen, de rol van automatisering en menselijk inzicht, en praktijkcasestudies die de praktische toepassingen van deze technieken benadrukken.

AI-specifieke debugging-uitdagingen begrijpen

AI-systemen beschikken over unieke kenmerken die het debuggen tot een bijzonder ingewikkelde aangelegenheid maken. In tegenstelling tot traditionele software, waar bugs doorgaans voortkomen uit logische fouten of problemen in de codebase, verweven AI-systemen code met data en leeralgoritmen. Deze combinatie introduceert een complexe reeks uitdagingen die gespecialiseerde foutopsporingstechnieken vereisen.

De gegevens bepalen grotendeels het gedrag van een AI-model waarop het is getraind. AI-specifieke foutopsporing begint dus vaak met een grondig onderzoek van deze gegevens. Een veelvoorkomend probleem is de aanwezigheid van vooroordelen in de trainingsset, wat kan leiden tot vertekende of oneerlijke voorspellingen. Debuggen vereist vervolgens het identificeren van deze vooroordelen en het begrijpen van de grondoorzaken en gevolgen ervan om het probleem recht te zetten zonder nieuwe problemen te introduceren.

Een andere belangrijke uitdaging bij het debuggen van AI is het omgaan met de stochastische aard van veel AI-algoritmen. Resultaten kunnen variëren, zelfs met dezelfde invoergegevens, als gevolg van willekeurige initialisaties of inherente variabiliteit in trainingsprocessen, zoals stochastische gradiëntdaling. Bijgevolg kan het repliceren van problemen frustrerend moeilijk zijn, en moet men statistische methoden gebruiken of de initiële kiemen herstellen om consistent gedrag voor een grondig onderzoek te garanderen.

Overfitting en underfitting zijn twee kanten van dezelfde medaille die het foutopsporingsproces bemoeilijken. Overfitting treedt op wanneer een model te complex is en leert de trainingsgegevens, inclusief ruis en uitschieters, te onthouden in plaats van te generaliseren op basis van patronen. Omgekeerd is onderaanpassing het gevolg van te simplistische modellen die er niet in slagen de onderliggende structuur van de gegevens vast te leggen. Het debuggen van deze problemen impliceert het aanpassen van de complexiteit van het model, vaak gedaan door middel van kruisvalidatie- en regularisatietechnieken.

De interpreteerbaarheid van modellen vormt ook een aanzienlijke uitdaging. Sommige AI-modellen, zoals diepe neurale netwerken, worden vaak ‘zwarte dozen’ genoemd vanwege de moeilijkheid om precies te begrijpen hoe ze beslissingen nemen. Dit kan een ernstig obstakel zijn bij het debuggen, omdat het van cruciaal belang is om de reden achter de uitvoer van een model te begrijpen om het onderliggende probleem aan te pakken. Technieken als analyse van de belangrijkheid van kenmerken, modeldestillatie en visualisatie van netwerklagen kunnen soms licht werpen op de donkere hoeken van deze complexe modellen.

Ten slotte kan de snel evoluerende aard van AI-tools en -frameworks ervoor zorgen dat het debuggen een voortdurend bewegend doelwit wordt. Met frequente updates en opkomende best practices moeten ontwikkelaars voortdurend alert blijven om ervoor te zorgen dat ze niet met problemen worden geconfronteerd die al in nieuwere releases zijn opgelost, of dat hun debugging-tools in lijn zijn met de nieuwste ontwikkelingen op dit gebied.

Het debuggen van AI-tools vereist een combinatie van domeinexpertise, methodische analyse en vaak een beetje creativiteit. Als AI-ontwikkelaar kan het begrijpen van deze AI-specifieke uitdagingen en het voorbereiden om deze methodisch aan te pakken het foutopsporingsproces aanzienlijk verbeteren, wat leidt tot betrouwbaardere AI-toepassingen.

Een betrouwbare foutopsporingsomgeving opzetten

Het ontwikkelen van AI-tools vereist nauwgezette aandacht voor detail tijdens de creatiefase en wanneer zich problemen voordoen. Om AI-systemen effectief te kunnen debuggen, hebben ontwikkelaars een systematische omgeving nodig om met de complexiteit van AI-algoritmen en datasets om te gaan. De volgende technieken zullen u begeleiden bij het opzetten van een dergelijke omgeving, waardoor uw vermogen om problemen binnen AI-tools te identificeren, isoleren en op te lossen wordt vergroot.

Creëer eerst een versiegestuurde werkruimte voor zowel uw code als uw datasets. Versiebeheersystemen zoals Git helpen bij het bijhouden van wijzigingen en maken het terugdraaien naar eerdere statussen mogelijk als er nieuwe bugs worden geïntroduceerd. Bovendien kunnen tools als DVC (Data Version Control) specifiek worden gebruikt voor het beheren en versiebeheer van datasets, wat cruciaal is omdat data vaak de kern vormen van problemen in AI-systemen.

Zorg ervoor dat uw foutopsporingsomgeving gegevensvalidatie omvat. Datakwaliteit staat voorop; het moet worden geverifieerd op juistheid, consistentie en afwezigheid van vooringenomenheid voordat het in het model wordt ingevoerd. Een betrouwbare installatie omvat geautomatiseerde scripts die de gegevensintegriteit met regelmatige tussenpozen of vóór elke trainingssessie controleren. Deze preventieve maatregel kan veel problemen met betrekking tot gegevensverwerking helpen voorkomen.

Een andere belangrijke factor is het opzetten van experimenttracking . AI-ontwikkeling omvat veel experimenten met verschillende hyperparameters, datasets en modelarchitecturen. Met tools als MLflow, Weights & Biases of TensorBoard kunt u verschillende experimenten volgen, visualiseren en vergelijken. Deze systematische aanpak helpt bij het begrijpen van modelgedrag en het identificeren waarom bepaalde veranderingen tot bugs kunnen hebben geleid.

Maak bovendien gebruik van continue integratie- en testpraktijken . Deze zijn niet alleen bedoeld voor traditionele softwareontwikkeling; ze zijn even belangrijk in AI. Geautomatiseerd testen kan ervoor zorgen dat kleine onderdelen van het AI-systeem na wijzigingen werken zoals verwacht. Doorlopende integratieservers kunnen uw gegevensvalidatie, trainingsscripts en tests automatisch uitvoeren op nieuwe commits aan de codebase, waardoor u onmiddellijk op de hoogte wordt gesteld van problemen.

Visualisatietools vormen een integraal onderdeel van het debuggen van AI-toepassingen. Als u bijvoorbeeld tools gebruikt om de computationele grafiek van een neuraal netwerk te visualiseren, kunt u zien waar er mogelijk iets misgaat. Op dezelfde manier kan het visualiseren van de gegevensdistributies, modelvoorspellingen versus daadwerkelijke resultaten en trainingsstatistieken discrepanties aan het licht brengen die op bugs kunnen wijzen.

Vul uiteindelijk de technologische hulpmiddelen aan met uitgebreide documentatie die details bevat over gegevensbronnen, modelarchitecturen, aannames, experimentresultaten en genomen maatregelen voor probleemoplossing. Deze hulpbron zal van onschatbare waarde blijken voor huidige foutopsporing en toekomstig onderhoud en updates, en biedt duidelijkheid en continuïteit in uw ontwikkelingsinspanningen.

In combinatie met deze strategieën en de no-code mogelijkheden van AppMaster kunnen ontwikkelaars het aantal AI-systeembugs aanzienlijk verminderen. De visuele tools van het platform en de geautomatiseerde codegeneratie vereenvoudigen aspecten van AI-ontwikkeling die anders foutgevoelig zouden kunnen zijn, waardoor ontwikkelaars gemakkelijk AI-applicaties van hoge kwaliteit kunnen creëren, implementeren en onderhouden.

Foutopsporingsstrategieën voor machine learning-modellen

Machine learning (ML) -modellen kunnen soms aanvoelen als zwarte dozen, wat unieke uitdagingen met zich meebrengt als het gaat om foutopsporing. In tegenstelling tot systematische logische fouten waar traditionele software vaak last van heeft, kampen ML-modellen met problemen die hun oorsprong vinden in de datakwaliteit, modelarchitectuur en trainingsprocedures. Om ML-modellen effectief te kunnen debuggen, moeten ontwikkelaars een strategische aanpak hanteren die deze unieke complexiteiten aanpakt.

Begin met een solide basis: gegevensverificatie

Voordat u zich verdiept in de computationele aspecten van foutopsporing, is het van cruciaal belang ervoor te zorgen dat uw gegevens correct en goed voorbereid zijn. Problemen zoals ontbrekende waarden, inconsistente opmaak en uitschieters kunnen de prestaties van uw model aanzienlijk beïnvloeden. Deze eerste stap omvat rigoureuze praktijken voor het opschonen, normaliseren en vergroten van gegevens, evenals controles op de gegevensdistributie die mogelijke vooroordelen of fouten in de dataset aan het licht kunnen brengen.

Vereenvoudigen om te verduidelijken: modelreductie

Wanneer u met een problematisch model wordt geconfronteerd, verminder dan de complexiteit ervan om problemen te isoleren. Door het aantal functies terug te brengen of de architectuur te vereenvoudigen, kun je vaak vaststellen waar het misgaat. Als een gereduceerd model nog steeds problemen vertoont, kan de fout liggen in de gegevens of de gebruikte functies. Omgekeerd, als vereenvoudiging het probleem oplost, kan de complexiteit van het oorspronkelijke model de boosdoener zijn.

Visualiseer om te begrijpen: foutanalyse

Maak gebruik van visualisatietools om foutpatronen te analyseren. Het uitzetten van leercurven kan problemen met de modelcapaciteit aangeven, zoals overfitting of underfitting. Het onderzoeken van verwarringsmatrices en ROC-curven (Receiver Operating Characteristic) voor classificatietaken helpt bij het identificeren van klassen waarmee het model worstelt, waardoor gebieden worden gesuggereerd die mogelijk meer genuanceerde kenmerken of aanvullende gegevens vereisen om de prestaties te verbeteren.

Zorg voor reproduceerbaarheid: versiebeheer en het bijhouden van experimenten

Om debuggen effectief te laten zijn, moet elk experiment reproduceerbaar zijn. Versiebeheersystemen zoals Git moeten niet alleen voor code worden gebruikt, maar ook voor het bijhouden van wijzigingen in uw datasets en modelconfiguraties. Tools voor het volgen van experimenten zijn essentieel voor het vergelijken van verschillende runs, het begrijpen van de impact van wijzigingen en het systematisch benaderen van modelverbeteringen.

Traditionele technieken: unit-testen en continue integratie

Het toepassen van best practices op het gebied van software-engineering op ML-ontwikkeling wordt vaak over het hoofd gezien, maar is cruciaal. Implementeer unit-tests voor pijplijnen voor gegevensverwerking en individuele modelcomponenten om ervoor te zorgen dat ze naar verwachting functioneren. Continuous Integration (CI)-pijplijnen helpen bij het automatisch uitvoeren van deze tests, waardoor fouten al vroeg in de ontwikkelingscyclus worden opgemerkt.

Foutopsporing door middel van sonderen: gebruik van diagnostische hulpmiddelen

Diagnostische hulpmiddelen zijn waardevol om dieper in modelgedrag te duiken. Technieken zoals analyse van de belangrijkheid van kenmerken en plots van gedeeltelijke afhankelijkheid onthullen inzichten in welke kenmerken de voorspellingen van het model het meest significant beïnvloeden. Bovendien kan modeldistillatie, waarbij een eenvoudiger model wordt getraind om de voorspellingen van een complex model te benaderen, benadrukken op welke aspecten van de trainingsgegevens het oorspronkelijke model zich richt, wat kan leiden tot het ontdekken van verkeerd gelabelde gegevens of te sterk benadrukte kenmerken.

De kracht van ensembles: modellen combineren voor inzicht

Foutopsporing kan ook afkomstig zijn van modelensembles. Door verschillende modellen te combineren, kunt u hun consensus evalueren en elk afzonderlijk model identificeren dat aanzienlijk afwijkt van andere, wat symptomatisch zou kunnen zijn voor een probleem binnen de training of gegevensverwerking van dat specifieke model.

Mensgerichte foutopsporing: schakel domeinexperts in

Mensen mogen niet buiten beschouwing worden gelaten bij het debuggen van AI. Werk samen met domeinexperts die de gegevens begrijpen en waardevolle inzichten kunnen bieden in de vraag of modelresultaten zinvol zijn. Ze kunnen helpen bij het identificeren van onnauwkeurigheden die mogelijk onopgemerkt blijven door puur datagestuurde statistieken.

Iteratieve verbetering is de sleutel

Uiteindelijk is het debuggen van ML-modellen een iteratief proces. Elke lus geeft u een dieper inzicht in uw model en de gegevens waarvan het leert. Deze strategieën bieden richtlijnen, maar ze moeten worden aangepast aan de context van uw specifieke project en het type ML-model dat u ontwikkelt. Vergeet niet om platforms no-code te gebruiken, zoals AppMaster, die tools bieden om de beginfasen van de modelontwikkeling te stroomlijnen en een basis te bieden voor verdere foutopsporing en verfijning.

Veelvoorkomende valkuilen en hoe u ze kunt vermijden

Naarmate AI groeit in complexiteit en diversiteit, worden ontwikkelaars vaak geconfronteerd met unieke uitdagingen die het foutopsporingsproces kunnen laten ontsporen. Het herkennen en omzeilen van deze valkuilen is cruciaal voor het creëren en onderhouden van effectieve AI-tools. Hier duiken we in enkele van de meest voorkomende valkuilen bij het debuggen van AI-tools en presenteren we strategieën om deze te vermijden.

Modelgeneralisatie negeren

Een van de meest voorkomende problemen bij de ontwikkeling van AI is het creëren van een model dat uitzonderlijk goed presteert op basis van uw trainingsgegevens, maar er niet in slaagt te generaliseren naar nieuwe, onzichtbare gegevens – overfitting. Om dit te voorkomen is het essentieel om:

- Maak gebruik van een uitgebreide dataset die de situaties uit de praktijk weerspiegelt die het model tegenkomt.

- Gebruik technieken als kruisvalidatie en regularisatie.

- Test uw modellen voortdurend op validatie en test datasets.

Gegevenskwaliteit uit het oog verliezen

Afval erin, afval eruit; deze waarheid is vooral relevant bij AI. Een slechte gegevenskwaliteit kan de prestaties van uw model volledig verstoren. Om deze valkuil te omzeilen:

- Zorg voor een grondige opschoning en voorverwerking van gegevens.

- Implementeer anomaliedetectie om uitschieters en onjuiste waarden op te sporen.

- Focus op het verzamelen van diverse en representatieve gegevens om vooroordelen te voorkomen.

Gebrek aan versiebeheer

Zonder nauwgezet versiebeheer voor uw AI-modellen en datasets wordt het reproduceren van resultaten en het volgen van wijzigingen lastig. Omarm tools voor versiebeheer en experimentbeheer om:

- Houd een gedetailleerd logboek bij van gegevensrevisies, modelparameters en codewijzigingen.

- Organiseer uw ontwikkelingsproces om de consistentie tussen de foutopsporingssessies te behouden.

De complexiteit van het model onderschatten

Complexe modellen zijn niet altijd superieur; soms zijn ze gewoon moeilijker te debuggen. Begin eenvoudig en verhoog de complexiteit geleidelijk, alleen als dat nodig is. Het vertrouwen op eenvoudigere modellen kan vaak leiden tot transparantere en interpreteerbare resultaten, waardoor het foutopsporingsproces beter beheersbaar wordt.

Het verwaarlozen van foutopsporingstools

Het achterwege laten van het gebruik van gespecialiseerde foutopsporingstools kan leiden tot aanzienlijk langere probleemoplossingstijden. Gebruik platforms zoals AppMaster om de ontwikkeling te stroomlijnen met visuele foutopsporingstools en functies waarmee ontwikkelaars bedrijfsprocessen en gegevensstromen kunnen visualiseren zonder zich in code te hoeven verdiepen.

Door te anticiperen op deze veelvoorkomende valkuilen en strategieën te implementeren om deze tegen te gaan, kunnen ontwikkelaars veel van de frustraties die vaak gepaard gaan met het debuggen van AI-tools verzachten en de weg vrijmaken voor soepelere, efficiëntere debugging-sessies.

Geautomatiseerde tools versus menselijke intuïtie bij AI-foutopsporing

Bij AI gaat het debuggen verder dan systematische logische fouten en omvat het ook de genuanceerde interpretaties van gegevens en modelgedrag. De opkomst van geautomatiseerde debugging-tools suggereert een transformatie in de manier waarop ontwikkelaars probleemoplossing in AI benaderen. Maar ondanks geavanceerde ontwikkelingen blijft de menselijke intuïtie een onmisbare troef tijdens het debugproces. In dit gedeelte wordt dieper ingegaan op de dynamische wisselwerking tussen geautomatiseerde tools en menselijke intuïtie op het gebied van AI-foutopsporing.

Geautomatiseerde tools bij AI-foutopsporing dienen als de eerste verdedigingslinie. Ze zijn bedreven in het identificeren van eenvoudige bugs, zoals syntaxisfouten, uitzonderingen en runtimefouten, die anders kostbare tijd zouden kunnen kosten als ze handmatig worden opgelost. Deze tools, aangedreven door AI zelf, kunnen het testen stroomlijnen door snel grote reeksen code te analyseren om afwijkingen op te sporen. Technologieën zoals voorspellende analyses en algoritmen voor het detecteren van afwijkingen hebben het potentieel om patronen te onderscheiden en problemen te voorspellen voordat ze zich volledig manifesteren, waardoor ze effectief kunnen fungeren als een preventieve maatregel in het probleemoplossingsproces.

AI-systemen worden echter gedefinieerd door hun complexiteit en uniciteit; ze leren en passen zich aan op basis van data. Geautomatiseerde tools kunnen haperen als ze worden geconfronteerd met de abstracte aard van AI-problemen, zoals problemen die verband houden met datakwaliteit, modelarchitectuur of de subtiliteiten van het afstemmen van hyperparameters. Hier komen menselijke intuïtie en expertise om de hoek kijken. Menselijke ontwikkelaars brengen hun technische kennis, genuanceerd begrip van de context, het vermogen om hypothesen te stellen over ongestructureerde problemen en creatieve probleemoplossende vaardigheden ter tafel.

Soms vereist de pure onvoorspelbaarheid van AI het geïnformeerde giswerk van een mens om minder voor de hand liggende discrepanties uit te roeien. Wanneer een AI-model bijvoorbeeld onverwachte resultaten genereert, kunnen geautomatiseerde tools de anomalie rapporteren, maar het is vaak de intuïtie van de ontwikkelaars die hen naar de onderliggende oorzaak leidt – of het nu gaat om een probleem met trainingsgegevens, overfitting van modellen of iets meer heimelijks, zoals een subtiele logische bug in de fase van gegevensvoorverwerking.

Bovendien is menselijk toezicht van cruciaal belang bij het interpreteren van de resultaten van geautomatiseerde foutopsporing. Menselijk oordeel is nodig om prioriteit te geven aan welke bugs de moeite waard zijn om te onderzoeken, op basis van hun potentiële impact op het systeem. Bovendien kan het debuggen van AI-systemen ethische overwegingen met zich meebrengen – zoals privacyschendingen of bevooroordeelde uitkomsten – waar geautomatiseerde tools inherent niet op toegerust zijn. Met hun menselijke empathie en ethische redenering zijn ontwikkelaars het best gepositioneerd om door deze gevoelige gebieden te navigeren.

Het is belangrijk om te erkennen dat geautomatiseerde tools niet bedoeld zijn om menselijke ontwikkelaars te vervangen, maar om hun capaciteiten te vergroten. Binnen het AppMaster platform vereenvoudigen geautomatiseerde tools bijvoorbeeld het ontwikkelings- en foutopsporingsproces no-code. De functies van het platform maken visuele foutopsporing mogelijk, waardoor ontwikkelaars gegevensstromen en logische paden intuïtiever kunnen observeren en ermee kunnen communiceren. AppMaster is dus een bewijs van de synergie tussen geautomatiseerde systemen en menselijke inzichten, en presenteert een coöperatief probleemoplossend model dat de sterke punten van beide werelden benut.

Hoewel geautomatiseerde tools efficiëntie en snelheid bieden bij routinematige foutopsporingstaken, doen ze niets af aan de behoefte aan menselijke intuïtie, die cruciaal blijft voor het omgaan met de complexiteit van AI-systemen. Een harmonieuze mix van geautomatiseerde software en menselijke expertise versnelt niet alleen het foutopsporingsproces, maar zorgt ook voor een betrouwbaardere en performantere AI-tool als eindresultaat. Naarmate AI blijft evolueren, zullen ook de methodologieën en verzamelingen van tools die gericht zijn op het demystificeren van de complexiteit ervan – altijd met het menselijke element centraal staan.

Casestudies: foutopsporing in AI in actie

Zelfs de meest zorgvuldig ontworpen AI-systemen kunnen onverwacht gedrag of fouten vertonen zodra ze interactie hebben met gegevens en scenario's uit de echte wereld. Door casestudies te onderzoeken kunnen ontwikkelaars inzicht krijgen in succesvolle foutopsporingsstrategieën en zo hun aanpak verfijnen om betrouwbaardere en krachtigere AI-tools te creëren. Laten we ons verdiepen in enkele opmerkelijke casestudies die licht werpen op de complexiteit van AI-foutopsporing.

- Casestudy 1: Diagnose van overfitting in een voorspellend model: Een detailhandelsbedrijf ontwikkelde een machine learning-model om de toekomstige productvraag te voorspellen op basis van historische verkoopgegevens. De voorspellingen van het model kwamen echter niet overeen met de werkelijke resultaten. Ontwikkelaars ontdekten dat het model tijdens de trainingsfase overfit was, waardoor er ruis en afwijkingen in de trainingsgegevens ontstonden in plaats van de onderliggende patronen. Ze gebruikten technieken zoals kruisvalidatie en introduceerden een regularisatieparameter om overfitting te verminderen, wat resulteerde in een model dat beter generaliseert naar ongeziene gegevens.

- Casestudy 2: Databias in gezichtsherkenningssoftware aanpakken: Een AI-bedrijf kreeg te maken met publieke reacties toen hun gezichtsherkenningssoftware vooringenomenheid vertoonde en slecht presteerde bij bepaalde demografische groepen. Bij het debuggen realiseerde het team zich dat de trainingsgegevens niet divers waren. Door meer representatieve gegevens te verzamelen en eerlijkheidsalgoritmen te gebruiken, verbeterden ze de nauwkeurigheid en verminderden ze de vooringenomenheid in hun software, wat het belang aantoonde van gegevenskwaliteit en diversiteit in de training van AI-modellen.

- Casestudy 3: Verbetering van de nauwkeurigheid van natuurlijke taalverwerking: Een startup ontwikkelde een hulpmiddel voor natuurlijke taalverwerking (NLP) dat de feedback van klanten niet nauwkeurig classificeerde. Uit het foutopsporingsproces bleek dat de in het model gebruikte woordinsluitingen onvoldoende waren om de context van bepaalde branchespecifieke termen vast te leggen. De startup verbeterde de nauwkeurigheid van de tool bij het begrijpen van de gevoelens van klanten aanzienlijk door de woordinsluitingen aan te passen en domeinspecifieke gegevens op te nemen in hun trainingssets.

- Casestudy 4: Debuggen van algoritmen voor autonome voertuigen: Een bedrijf dat gespecialiseerd is in autonome voertuigen ondervond kritieke problemen waarbij de auto onder bepaalde weersomstandigheden stopborden verkeerd interpreteerde. Uit debugging bleek dat de vision-algoritmen te sterk afhankelijk waren van kleurdetectie. Door meer contextuele aanwijzingen en sensorfusietechnieken te integreren, konden de ingenieurs de interpretatie van verkeersborden door de AI veel betrouwbaarder maken.

Elke casestudy benadrukt een uniek aspect van AI-foutopsporing en benadrukt de diverse uitdagingen waarmee ontwikkelaars te maken kunnen krijgen. Of het nu gaat om de kwaliteit van datasets, de complexiteit van modellen, biases in algoritmen of het aanpassingsvermogen van een systeem: het herkennen en aanpakken van deze problemen door middel van strategische debugging is essentieel. Hoewel casestudy's waardevolle lessen opleveren, geven platforms zoals AppMaster ontwikkelaars meer mogelijkheden door de complexiteit van het bouwen en debuggen van AI-tools te verminderen, waardoor zelfs mensen met weinig codeerervaring de lessen uit echte AI-uitdagingen kunnen leren en toepassen.

Integratie van foutopsporingstechnieken met AppMaster

Bij het ontwikkelen van AI-tools is goede foutopsporing essentieel om de prestaties, betrouwbaarheid en nauwkeurigheid van uw applicaties te garanderen. Ontwikkelaars beschikken inmiddels over veel technieken om traditionele foutopsporingsscenario's aan te pakken. AI brengt echter complexe uitdagingen met zich mee vanwege het datacentrische karakter en de vaak ondoorzichtige besluitvormingsprocessen. Gezien het enorme potentieel om het ontwikkelingsproces te vereenvoudigen en te verbeteren, biedt de integratie van AI-foutopsporing met no-code -platforms zoals AppMaster een naadloos en efficiënt traject om de ingewikkelde problemen op te lossen die zouden kunnen voortkomen uit de inherente complexiteit van AI.

AppMaster is een ontwikkelingsplatform no-code dat uitblinkt in het stroomlijnen van de creatie van web-, mobiele en backend-applicaties. Door AppMaster te gebruiken, krijgen ontwikkelaars een krachtige set tools ter beschikking die hun AI-foutopsporingsstrategieën kunnen versterken:

- Visualisatie: Het debuggen van AI vereist vaak inzicht in datarelaties en modelgedrag. AppMaster voorziet ontwikkelaars van visuele hulpmiddelen, zoals de ontwerper van bedrijfsprocessen (BP's) , die complexe logica kunnen vertalen naar begrijpelijke en aanpasbare visuele componenten. Dit is met name handig in AI-toepassingen waarbij workflows en beslissingspunten moeten worden gevisualiseerd om de juistheid van de gegevensverwerking en de gevolgtrekking van AI-modellen te beoordelen.

- Geautomatiseerd testen: Foutopsporing is geen eenmalig proces; het vereist voortdurende herevaluatie. Het platform biedt geautomatiseerde testmogelijkheden waarmee ontwikkelaars na elke wijziging efficiënt tests kunnen maken en uitvoeren, waardoor de kernfunctionaliteit van de AI intact blijft en elke mogelijke achteruitgang vroegtijdig wordt opgemerkt.

- Modulariteit: AI-foutopsporing kan een iteratieve revisie van bepaalde applicatieonderdelen vereisen, terwijl andere onaangeroerd blijven. AppMaster bevordert de modulariteit door zijn vermogen om applicaties in verschillende microservices te segmenteren. Cockpitgebieden van een AI-tool kunnen worden geïsoleerd voor gerichte foutopsporing zonder de volledige werking van de applicatie te belemmeren.

- Gegevensintegriteit: De gegevens die AI-tools voeden, moeten rigoureus worden gevalideerd. Fouten in gegevens zullen onvermijdelijk leiden tot foutief AI-gedrag. AppMaster bevat mechanismen om de data-integriteit te garanderen, inclusief ingebouwde validatieregels die typische datagerelateerde problemen kunnen voorkomen voordat ze uitmonden in grotere, complexere problemen.

- Samenwerkingsfuncties: Vaak is het debuggen van een AI-tool een teamprestatie. Dankzij de samenwerkingsomgeving van het platform kunnen meerdere ontwikkelaars tegelijkertijd aan het project werken, waardoor het oplossen van problemen zodra deze zich voordoen en het gezamenlijk valideren van oplossingen eenvoudiger wordt.

- Implementatie en hosting: Met AppMaster kunnen ontwikkelaars hun applicaties met één klik op de knop implementeren. Deze snelle implementatie maakt snelle iteratiecycli mogelijk voor het testen en debuggen van AI-applicaties in een staging- of productie-achtige omgeving, waardoor er rekening wordt gehouden met scenario's uit de echte wereld.

- Analyse en monitoring: Na de implementatie is het in de gaten houden van de prestaties van een AI-applicatie essentieel om afwijkingen op te sporen die op bugs kunnen duiden. AppMaster kan analyse- en monitoringoplossingen bieden om het gedrag van de applicatie te volgen, waardoor empirische gegevens worden verstrekt die nuttig zijn voor voortdurende foutopsporingsinspanningen.

Bovendien versnelt het no-code karakter van AppMaster het foutopsporingsproces door de complexiteit van code te abstraheren, waardoor ontwikkelaars zich kunnen concentreren op de logica en prestaties van hun AI-tools in plaats van vast te lopen door syntaxis of structurele fouten. De mogelijkheid van het platform om automatisch documentatie en Open API-specificaties te genereren, helpt ook bij het foutopsporingsproces door ervoor te zorgen dat het hele team altijd op dezelfde pagina zit met betrekking tot de huidige constructie en het gedrag van de tool.

In het traject van de ontwikkeling van AI-tools is het integreren van platforms als AppMaster een bewijs van de harmonieuze mix van flexibiliteit no-code en geavanceerde AI-foutopsporingsbenaderingen. Het illustreert de toekomst van softwareontwikkeling, waar de fijne kneepjes van het debuggen geen knelpunt vormen, maar eerder een georkestreerd onderdeel van de ontwikkelingssymfonie.

Tips voor efficiënte foutopsporingsworkflows

Stroomlijn uw foutopsporingstools

Een van de eerste stappen op weg naar een efficiënte debugging-workflow is jezelf uitrusten met de juiste tools. Je hebt programma's nodig die met complexe datasets en algoritmen overweg kunnen, zoals interactieve debuggers, tools voor visuele data-analyse en geautomatiseerde testsuites. Een geïntegreerde ontwikkelomgeving (IDE) die AI-specifieke plug-ins en uitbreidingen biedt, kan tijd besparen en de productiviteit verhogen. Wanneer tools worden geconsolideerd in een naadloze workflow, maken ze een snellere identificatie en oplossing van bugs mogelijk.

Omarm versiebeheer

Versiebeheer gaat niet alleen over het bijhouden van codewijzigingen; het is ook essentieel voor het beheer van de datasets waarop uw AI werkt. Platforms zoals Git kunnen worden gebruikt om zowel code als gegevens te beheren, waardoor wijzigingen beter kunnen worden gevolgd en de mogelijkheid wordt geboden om terug te keren naar een vorige staat als er iets misgaat. Bovendien kunt u experimentele functies of gegevenstransformaties uitbreiden, zodat deze de hoofdontwikkelingslijn niet verstoren.

Geef bugs effectief prioriteit

Niet alle bugs zijn gelijk gemaakt. Sommige hebben een aanzienlijke invloed op de functionaliteit, terwijl andere een minimale impact hebben op de AI-toepassing. Het evalueren en prioriteren van bugs op basis van hun ernst en impact op de prestaties van de software is cruciaal voor het behouden van een efficiënte workflow. Het gebruik van de Eisenhower-matrix, die taken verdeelt in urgente/belangrijke matrices, kan helpen bij het categoriseren en prioriteren van problemen.

Automatiseer repetitieve taken met scripts

Bij het debuggen zijn vaak herhaalde tests en controles nodig. Door scripts te schrijven om deze taken te automatiseren, kunt u kostbare tijd besparen en menselijke fouten verminderen. Scripts kunnen vooraf gedefinieerde foutopsporingsprocedures doorlopen, zodat u uw aandacht kunt richten op de meer ingewikkelde en unieke foutopsporingsuitdagingen. Tools voor continue integratie kunnen u helpen dergelijke scripts automatisch te activeren op basis van code of data-commits.

Documenteer alles nauwkeurig

Documentatie wordt vaak als een bijzaak beschouwd, maar het hebben van gedetailleerde gegevens over wat elk onderdeel van uw AI-systeem zou moeten doen, naast aantekeningen over eerdere bugs en oplossingen, kan een redder in nood zijn tijdens het debuggen. Deze praktijk stelt elke ontwikkelaar in staat snel beslissingen te begrijpen die eerder in de ontwikkelingscyclus zijn genomen. Bovendien kan het documenteren van foutopsporingssessies helpen bij het identificeren van terugkerende problemen en het begrijpen van het langetermijngedrag van uw AI-tools.

Zorg voor duidelijke communicatiekanalen

In een teamomgeving is effectieve communicatie van cruciaal belang. Er moeten duidelijke kanalen worden gecreëerd voor het melden, bespreken en oplossen van bugs. Dit omvat regelmatige bijeenkomsten, beknopte rapportageformaten en gedeelde dashboards. Bovendien kan het creëren van een cultuur die een open discussie over bugs aanmoedigt, een meer collaboratieve en efficiënte aanpak bevorderen om deze op te lossen.

Maak gebruik van geautomatiseerde logboekregistratie en monitoring

Het implementeren van geautomatiseerde tools voor logboekregistratie en monitoring kan consistente en objectieve inzichten bieden in het gedrag van uw AI. Deze tools kunnen afwijkingen en prestatieproblemen in realtime detecteren, wat essentieel is voor zowel onmiddellijke probleemoplossing als langdurig onderhoud. Bovendien kan geavanceerde monitoring helpen bij het identificeren van patronen die tot bugs leiden, en waardevolle gegevens opleveren om deze in toekomstige ontwikkelingscycli te voorkomen.

Gebruik functievlaggen voor een veiligere implementatie

Door functievlaggen te introduceren, kunt u nieuwe functionaliteiten geleidelijk uitrollen en bepalen wie er toegang toe krijgt. Deze praktijk kan de impact van niet-gedetecteerde bugs beperken door ze in eerste instantie bloot te stellen aan een klein gebruikersbestand. Als er na de release een bug wordt geïdentificeerd, kunt u bovendien met functievlaggen eenvoudig terugdraaien zonder andere aspecten van de AI-toepassing te beïnvloeden.

Continu leren en aanpassing

Debuggen gaat niet alleen over het repareren van wat kapot is. Het gaat om het leren van de fouten en het verbeteren van processen. Een efficiënte debugger blijft op de hoogte van nieuwe tools, technieken en platforms die hun workflow kunnen vereenvoudigen en verbeteren. Platformen als AppMaster bieden bijvoorbeeld een oplossing no-code voor het snel ontwikkelen en inzetten van AI-tools met geïntegreerde mogelijkheden voor foutopsporing en monitoring, waardoor de middelen die aan deze taken worden besteed aanzienlijk worden verminderd.

Een gezonde foutopsporingsmentaliteit behouden

Ten slotte: zorg voor een positieve en nieuwsgierige instelling. Bugs zien als uitdagingen in plaats van problemen kan motiverend werken. Vergeet niet dat elke bug een kans is om het AI-systeem beter te begrijpen en de robuustheid ervan te verbeteren. Behoud geduld en benader foutopsporing altijd methodisch en toch creatief.

Door deze tips te implementeren en uw foutopsporingsprocessen voortdurend te verfijnen, kunt u zorgen voor een soepelere en efficiëntere workflow, die uiteindelijk leidt tot de ontwikkeling van betrouwbare en goed presterende AI-applicaties.

Onderhoud van AI-tools na het opsporen van fouten

Nadat u met succes door het labyrint van het debuggen van uw AI-tools bent genavigeerd, eindigt de reis daar niet. Net als een zorgvuldig vervaardigd uurwerk vereisen AI-tools voortdurend onderhoud en toezicht om ervoor te zorgen dat ze optimaal presteren. Hier verdiepen we ons in een verstandige aanpak voor het onderhouden van AI-tools na het rigoureuze foutopsporingsproces, waarbij we u strategieën bieden om uw investering toekomstbestendig te maken en blijvende, consistente resultaten te garanderen.

Continue monitoring van modelprestaties

AI-modellen zijn gevoelig voor 'modeldrift' naarmate gegevens en omstandigheden in de echte wereld in de loop van de tijd evolueren. Het implementeren van een mechanisme voor continue prestatiemonitoring is absoluut noodzakelijk. Dergelijke systemen waarschuwen ontwikkelaars voor mogelijke afname van de nauwkeurigheid of effectiviteit, waardoor tijdige aanpassingen mogelijk zijn. Deze waakzame aanpak zorgt ervoor dat modellen hun relevantie behouden en waardevolle inzichten blijven leveren.

Regelmatige updates van modellen en datasets

De honger van AI naar data is onverzadigbaar en de prestaties ervan zijn intrinsiek verbonden met de kwaliteit en het volume van de ingenomen informatie. Daarom zijn het van cruciaal belang om nieuwe, hoogwaardige gegevens aan te voeren en modellen opnieuw te bekijken en te verfijnen. Naarmate nieuwe patronen ontstaan en oude vervagen, moeten uw AI-tools evolueren om op deze verschuivingen afgestemd te blijven. Periodieke herscholing met up-to-date gegevens wordt niet alleen aanbevolen; het is nodig om concurrerend en effectief te blijven.

Voortdurend testen en valideren

Hoewel je de problemen tijdens de debug-fase hebt opgelost, is er geen reden om de testtoolkit neer te leggen. Als een waakzame schildwacht moet u uw AI-modellen voortdurend testen en valideren aan de hand van nieuwe scenario's, edge cases en datasets. Geautomatiseerde testpijplijnen kunnen hier enorm bij helpen en uw meedogenloze bondgenoten worden bij het behouden van de veerkracht en betrouwbaarheid van uw AI-tools.

Documentatie en versietracking

Het bijhouden van nauwgezette documentatie is niet alleen een oefening in due diligence; het is een baken voor iedereen die in de toekomst met uw systeem te maken krijgt. Duidelijke registraties van wijzigingen, beslissingen en architectuurwijzigingen creëren een routekaart die onderhoudsteams kan begeleiden, de onboardingtijd voor nieuwe ontwikkelaars kan verkorten en aanzienlijk kan helpen wanneer zich onverwachte problemen voordoen.

Aanpassing aan gebruikersfeedback en marktveranderingen

Een AI-tool, hoe technisch ook bekwaam, moet uiteindelijk in de behoeften voorzien en de problemen van zijn gebruikers oplossen. Het verkrijgen van en reageren op gebruikersfeedback is van cruciaal belang om ervoor te zorgen dat de AI relevant en gebruikersgericht blijft. Op dezelfde manier is de markt waarin zij opereert dynamisch, en om voorop te blijven is het noodzakelijk dat uw AI zich aanpast aan veranderingen in de regelgeving, concurrentiedruk en technologische vooruitgang.

Ethische en bias-checks implementeren

De diepgaande impact van AI strekt zich verder uit tot ethische terreinen en potentiële vooroordelen. Voortdurende audits en controles om onevenwichtigheden in gegevens te corrigeren, vooroordelen weg te nemen en eerlijke en ethische resultaten te garanderen, zijn niet-onderhandelbare verantwoordelijkheden voor beheerders van AI-tools.

De rol van AppMaster

Platformen zoals AppMaster kunnen als waardevolle troeven dienen door een basis te bieden voor snelle applicatieontwikkeling no-code en eenvoudige iteratie bij het onderhouden van AI-tools na het debuggen. Het naadloos integreren van AI-functionaliteiten met traditionele app-componenten helpt innovatie en stabiliteit in evenwicht te brengen. Met de geautomatiseerde codegeneratie helpt AppMaster de onderhoudsoverhead te minimaliseren, waardoor teams zich kunnen concentreren op activiteiten met toegevoegde waarde, zoals modelverbetering en prestatie-optimalisatie.

Door deze strategieën in acht te nemen, kunt u een consistent prestatieniveau voor uw AI-tools bevorderen, terwijl u flexibel blijft en voorbereid bent op de voortdurende evolutie van het AI-veld. Dit proactieve onderhoudsplan gaat niet alleen over het behoud van functionaliteit, maar gaat ook over het bevorderen en verbeteren van uw AI-tools om aan de eisen van morgen te voldoen en deze zelfs te overtreffen.

Conclusie: een routekaart naar vlekkeloze AI-toepassingen

Bij het ontwikkelen van AI-tools is debuggen een onmisbaar onderdeel van het maken van intelligente en betrouwbare applicaties. Het is een proces dat zowel nauwgezette aandacht voor technische details als een breed begrip van complexe systemen vereist. Terwijl we ons verdiepten in de geavanceerde wereld van AI-foutopsporing, hebben we gezien dat het niet alleen om het oplossen van fouten gaat. Het is eerder een kans om de prestaties te optimaliseren, de nauwkeurigheid te verbeteren en uiteindelijk te vertrouwen op de AI-oplossingen die we creëren.

De routekaart naar vlekkeloze AI-toepassingen is duidelijk, maar vereist toewijding en strategische uitvoering. Begin met inzicht in de unieke uitdagingen die AI-systemen met zich meebrengen. Omarm de complexiteit van datagestuurd gedrag, houd de prestaties van modellen nauwlettend in de gaten en gebruik debugging als lens om de nuances van uw AI te verfijnen en te begrijpen. De tactieken die in deze verhandeling worden gedeeld, van het opzetten van een betrouwbare omgeving tot het selecteren van de juiste foutopsporingsstrategieën, begeleiden u naar een efficiënte workflow.

AI-tools kunnen zeer complex zijn en geen enkel debugging-traject zal hetzelfde zijn. Daarom is het behouden van een gevoel van flexibiliteit en continu leren essentieel. Blijf op de hoogte van de nieuwste trends, tools en methodologieën op het gebied van AI-foutopsporing. En vergeet niet dat het menselijke element (uw intuïtie en expertise) altijd een waardevol bezit zal zijn in combinatie met de intelligentie en automatisering van platforms als AppMaster. Hier vindt u een balans tussen de geavanceerde mogelijkheden van geautomatiseerde tools en het onderscheidingsvermogen van een doorgewinterde ontwikkelaar.

Ten slotte mag het onderhoud van AI-applicaties na het debuggen niet worden onderschat. U heeft hard gewerkt om een staat van minimale bugs en soepele werking te bereiken, en het is van cruciaal belang om dit te behouden door uw systemen consequent te monitoren, bij te werken en te testen.

De routekaart naar het beheersen van het debuggen van AI-tools is geen lineair pad, maar een cyclus van voortdurende verbetering. Het vereist een synergie van geavanceerde technologie, zoals de no-code oplossingen van AppMaster, en de onvervangbare creatieve probleemoplossende vaardigheden van ontwikkelaars. Door deze routekaart te volgen, kunnen ontwikkelaars ervoor zorgen dat hun AI-toepassingen niet alleen functioneren, maar ook op de top van hun potentieel presteren en waarde en innovatie bieden in een technologisch dynamische wereld.

FAQ

Het debuggen van AI-tools brengt de complexiteit van datagestuurd gedrag met zich mee, wat betekent dat u tijdens het debuggen rekening moet houden met de kwaliteit van de data, de modelarchitectuur en de trainingsprocessen.

Enkele van de meest voorkomende uitdagingen zijn onder meer overfitting, underfitting, data bias en het omgaan met niet-deterministische output.

Een betrouwbare AI-foutopsporingsomgeving omvat versiebeheer voor code en gegevens, grondige gegevensvalidatie en tools voor het volgen en visualiseren van experimenten.

Strategieën omvatten het gebruik van een modulaire aanpak, het vereenvoudigen van het model, het visualiseren van modelgedrag en het gebruik van technieken zoals unit-testen en continue integratie.

Hoewel geautomatiseerde tools dit proces enorm kunnen ondersteunen, speelt de menselijke intuïtie een sleutelrol bij het begrijpen van de context, het interpreteren van gegevens en het nemen van strategische beslissingen.

AppMaster biedt een platform no-code dat de ontwikkeling en foutopsporing van AI-applicaties vereenvoudigt met visuele foutopsporingstools en geautomatiseerde codegeneratie.

U kunt de efficiëntie behouden door u te concentreren op reproduceerbaarheid, georganiseerd te blijven met documentatie en prioriteit te geven aan het opsporen van fouten in impactvolle bugs.

Onderhoud na het debuggen zou continue monitoring, regelmatige updates van het model en de dataset en voortdurende tests moeten omvatten om nieuwe problemen te voorkomen.

Ja, AI-technieken kunnen worden toegepast om bepaalde aspecten van het foutopsporingsproces te automatiseren, zoals detectie van afwijkingen en voorspellend onderhoud.

Het analyseren van casestudy's uit de praktijk kan inzicht verschaffen in effectieve strategieën en veelvoorkomende fouten, waardoor u praktische kennis krijgt voor het debuggen van AI-tools.

Veelvoorkomende valkuilen zijn onder meer het verwaarlozen van de gegevenskwaliteit, het negeren van modelvooroordelen, het te ingewikkeld maken van het model en het niet valideren van de uitkomsten aan de hand van scenario's uit de echte wereld.