Utilizzo di Docker per l'architettura a microservizi

Esplora i vantaggi dell'utilizzo di Docker in un'architettura a microservizi, comprese le strategie di containerizzazione e distribuzione, per accelerare lo sviluppo delle applicazioni e migliorare la scalabilità.

Docker e i microservizi

L'architettura a microservizi è diventata sempre più popolare negli ultimi anni, in quanto offre vantaggi significativi in termini di scalabilità, flessibilità e manutenzione delle applicazioni software. Nel suo nucleo, i microservizi sono un modello architettonico in cui una singola applicazione è composta da un insieme di piccoli servizi indipendenti, ognuno dei quali è responsabile di una specifica funzionalità e comunica tra loro tramite API. Questa modularità consente di sviluppare e distribuire rapidamente le applicazioni, di testarle più facilmente e di scalarle comodamente.

In questo contesto, Docker emerge come un potente strumento per lavorare con i microservizi. Docker è una piattaforma open-source che facilita lo sviluppo, la distribuzione e la gestione delle applicazioni attraverso la containerizzazione. Consente agli sviluppatori di impacchettare le applicazioni e le loro dipendenze in contenitori leggeri e portatili, assicurando che le applicazioni vengano eseguite in modo coerente in ambienti e fasi di sviluppo diversi. Sfruttando Docker, gli sviluppatori possono semplificare in modo efficiente il processo di creazione, gestione e scalabilità dei microservizi.

Perché usare Docker per l'architettura a microservizi?

Docker e i microservizi sono una combinazione naturale per diversi motivi.

Ambiente standardizzato

Docker consente agli sviluppatori di creare un ambiente applicativo standardizzato impacchettando tutti i componenti necessari, tra cui l'applicazione stessa, le librerie e le dipendenze, in un'unica unità autonoma chiamata container. Questa standardizzazione riduce il rischio di incongruenze ambientali che possono verificarsi tra gli ambienti di sviluppo, staging e produzione, assicurando che i microservizi si comportino in modo coerente come previsto.

Sviluppo accelerato

L'uso dei container Docker accelera notevolmente i processi di sviluppo dei microservizi. Poiché ogni contenitore è un ambiente isolato, gli sviluppatori possono lavorare sui singoli servizi senza preoccuparsi di dipendenze o librerie in conflitto. Inoltre, le immagini Docker possono essere facilmente condivise tra i membri del team, consentendo loro di distribuire ed eseguire rapidamente le applicazioni sulle loro macchine locali, accelerando lo sviluppo e la collaborazione.

Portabilità migliorata

I container creati con Docker sono altamente portabili, consentendo agli sviluppatori di spostare facilmente le applicazioni tra ambienti e piattaforme diverse. Questa portabilità garantisce che i microservizi possano essere distribuiti ed eseguiti in modo coerente su sistemi diversi, indipendentemente dall'infrastruttura sottostante. Di conseguenza, i team di sviluppo possono concentrarsi sulla creazione delle migliori applicazioni possibili senza preoccuparsi delle sfumature specifiche del sistema.

Riduzione dell'utilizzo delle risorse di sistema

L'architettura a microservizi può potenzialmente portare a un aumento del consumo di risorse, poiché ogni servizio può essere eseguito su macchine separate, con conseguente sovraccarico delle risorse di sistema. Docker risolve questo problema creando contenitori leggeri che condividono le risorse sottostanti del sistema host, riducendo il consumo complessivo di risorse rispetto all'esecuzione di più macchine virtuali.

Gestione semplificata dei microservizi

Docker semplifica la gestione e il monitoraggio dei microservizi fornendo un ambiente coerente per la distribuzione e l'esecuzione dei container. Gli sviluppatori possono utilizzare strumenti come Docker Compose per definire l'intero stack applicativo, compresi i singoli microservizi e le loro dipendenze, semplificando la distribuzione e la gestione dei servizi in modo coerente.

Containerizzazione di microservizi con Docker

La containerizzazione di microservizi con Docker comporta la creazione di un file Docker contenente le istruzioni per la creazione di un'immagine Docker. Questa sezione vi guiderà attraverso il processo di containerizzazione di un microservizio campione con Docker.

Creare un file Docker

Un Dockerfile è uno script contenente le istruzioni per costruire un'immagine Docker. Il Dockerfile definisce l'immagine di base, il codice sorgente dell'applicazione, le dipendenze e le configurazioni necessarie per l'esecuzione del servizio. Creare un nuovo file chiamato `Dockerfile` nella directory principale del microservizio.

Definire l'immagine di base

Specificate l'immagine di base del vostro microservizio aggiungendo il comando `FROM` al vostro Dockerfile. L'immagine di base è la base del contenitore e fornisce l'ambiente di esecuzione necessario. La scelta di un'immagine di base appropriata per il proprio microservizio è essenziale, come un'immagine ufficiale e minimale fornita da Docker o un'immagine personalizzata, adattata alle proprie esigenze. Ad esempio, se il vostro microservizio è sviluppato in Node.js, potreste usare la seguente riga nel vostro file Docker:

FROM node:14

Impostare la directory di lavoro

Impostare la directory di lavoro del contenitore usando il comando `WORKDIR`. Questa directory sarà usata per memorizzare il codice sorgente e le dipendenze dell'applicazione.

WORKDIR /app

Copiare il codice sorgente e le dipendenze

Copiare il codice sorgente e tutti i file necessari dal computer locale al contenitore usando il comando `COPY`. Inoltre, installare le dipendenze necessarie usando gestori di pacchetti come npm, pip o Maven.

COPIA pacchetto*.json ./ ESEGUIRE npm install COPIA .

Esporre la porta del servizio

Esporre la porta su cui il microservizio sarà accessibile usando il comando `EXPOSE`. Questo permetterà di comunicare con il microservizio da altri contenitori o servizi esterni.

ESPOSIZIONE 8080

Eseguire l'applicazione

Avviare il microservizio con il comando `CMD`, specificando il comando necessario per eseguire l'applicazione.

CMD ["npm", "start"]

Dopo aver creato il file Docker, costruire l'immagine Docker eseguendo il seguente comando nella stessa directory del file Docker:

docker build -t your-image-name .

Infine, eseguire il contenitore Docker utilizzando l'immagine appena creata:

docker run -p 8080:8080 your-image-name

Il microservizio è ora containerizzato ed eseguito in un contenitore Docker. Questo processo può essere ripetuto per ogni microservizio della vostra applicazione, consentendovi di sviluppare, testare e distribuire i vostri microservizi in modo snello, efficiente e coerente.

Distribuzione e orchestrazione dei contenitori Docker

Il deploy e l'orchestrazione dei container Docker sono una parte essenziale della gestione delle architetture di microservizi. Gli strumenti di orchestrazione dei container automatizzano la distribuzione, la gestione e la scalabilità dei singoli container, assicurando che i microservizi lavorino insieme in modo efficiente. Due piattaforme di orchestrazione dei container molto diffuse sono Kubernetes e Docker Swarm.

Kubernetes

Kubernetes è una piattaforma di orchestrazione di container open-source che automatizza la distribuzione, la scalatura e la gestione delle applicazioni containerizzate. È ampiamente adottata grazie alle sue potenti funzionalità e al suo potente ecosistema. Alcuni vantaggi chiave di Kubernetes sono:

- Scalabilità: Kubernetes utilizza una configurazione dichiarativa per gestire la scalabilità dei container, rendendo più facile scalare le applicazioni in base alla domanda.

- Alta disponibilità: Kubernetes garantisce un'elevata disponibilità distribuendo i container su diversi nodi e gestendo automaticamente il riavvio dei container in caso di guasti.

- Bilanciamento del carico: Kubernetes può bilanciare le richieste tra più istanze di un microservizio, migliorando le prestazioni e la tolleranza ai guasti.

- Registrazione e monitoraggio: Kubernetes si integra con diversi strumenti di registrazione e monitoraggio, semplificando il monitoraggio della salute e delle prestazioni delle applicazioni.

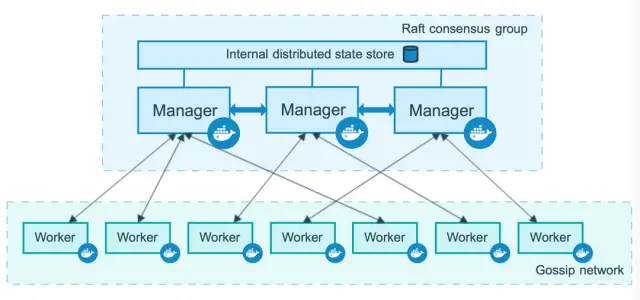

Docker Swarm

Docker Swarm è una soluzione nativa di clustering e orchestrazione per i container Docker. È integrato direttamente nella piattaforma Docker, il che lo rende una scelta semplice e intuitiva per gli utenti di Docker. Docker Swarm offre i seguenti vantaggi:

- Semplicità di configurazione: Docker Swarm non richiede un'ampia installazione o configurazione. Funziona perfettamente con la CLI e l'API di Docker, rendendo semplice la distribuzione e la gestione dei container.

- Scalabilità: Docker Swarm consente agli utenti di scalare i servizi in modo rapido ed efficiente, regolando il numero di repliche dei container per ciascun servizio.

- Bilanciamento del carico: Docker Swarm distribuisce automaticamente le richieste tra i container, migliorando le prestazioni e la resilienza delle applicazioni.

- Rilevamento dei servizi: Docker Swarm include un server DNS incorporato per la scoperta dei servizi, consentendo ai container di scoprire e comunicare tra loro.

Fonte immagine: Documenti Docker

Sia Kubernetes che Docker Swarm sono strumenti di orchestrazione molto diffusi per la gestione dei container Docker nelle architetture a microservizi. La scelta dello strumento più adatto dipende dai requisiti specifici dell'applicazione, dall'infrastruttura esistente e dalle competenze del team.

Creare un'applicazione a microservizi Dockerizzata

Vediamo i passaggi per creare un'applicazione a microservizi Dockerizzata:

- Progettare i microservizi: Suddividere l'applicazione in più servizi piccoli e modulari che possono essere sviluppati, distribuiti e scalati in modo indipendente. Ogni microservizio deve avere una responsabilità ben definita e comunicare con gli altri tramite API o code di messaggistica.

- Creare file Docker: Per ogni microservizio, creare un Dockerfile che specifichi l'immagine di base, il codice dell'applicazione, le dipendenze e la configurazione necessaria per creare un'immagine Docker. Questa immagine viene usata per distribuire i microservizi come contenitori.

- Costruire le immagini Docker: Eseguire il comando Docker build per creare immagini Docker per ogni microservizio, seguendo le istruzioni definite nei file Docker corrispondenti.

- Creare la rete: Stabilire la rete tra i contenitori per consentire la comunicazione tra i microservizi. Il collegamento in rete può essere fatto usando Docker Compose o uno strumento di orchestrazione di container come Kubernetes o Docker Swarm.

- Configurare il bilanciamento del carico: Configurare un bilanciatore di carico per distribuire le richieste tra le istanze dei microservizi, garantendo prestazioni ottimali e tolleranza agli errori. Utilizzate strumenti come Kubernetes Ingress o il bilanciamento del carico integrato di Docker Swarm.

- Distribuire i microservizi: Distribuite i microservizi come contenitori Docker utilizzando la piattaforma di orchestrazione dei contenitori di vostra scelta. In questo modo si crea un ambiente in cui i microservizi possono essere eseguiti, comunicare tra loro e scalare su richiesta.

Una volta completati tutti questi passaggi, l'applicazione a microservizi sarà attiva e funzionante, con ogni microservizio distribuito come contenitore Docker.

Monitoraggio e scalabilità dei microservizi Dockerizzati

Il monitoraggio e la scalabilità sono essenziali per garantire le prestazioni, l'affidabilità e l'efficienza di un'applicazione a microservizi Dockerizzata. Ecco alcune strategie chiave da considerare:

Monitoraggio

Gli strumenti di monitoraggio aiutano a monitorare la salute e le prestazioni dei container Docker, assicurando che i microservizi funzionino in modo ottimale. Tra gli strumenti di monitoraggio più diffusi vi sono:

- Prometheus: Un potente toolkit open-source per il monitoraggio e gli avvisi per ambienti containerizzati, che include integrazioni con Grafana per la visualizzazione e gli avvisi.

- Datadog: Una piattaforma di osservabilità completa in grado di aggregare metriche, log e tracce dei container, fornendo approfondimenti in tempo reale sulle prestazioni delle applicazioni.

- ELK Stack: Una combinazione di Elasticsearch, Logstash e Kibana, utilizzata per la ricerca, l'analisi e la visualizzazione centralizzata dei log dei container Docker.

Assicuratevi che la vostra configurazione di monitoraggio raccolga metriche, log e dati sulle prestazioni per identificare potenziali problemi e risolverli efficacemente.

Scalare

La scalabilità dei microservizi Dockerizzati comporta la regolazione del numero di container che eseguono ciascun servizio per adattarsi a carichi di lavoro e richieste variabili. Le piattaforme di orchestrazione dei container come Kubernetes e Docker Swarm facilitano il ridimensionamento automatico, consentendo di concentrarsi sul miglioramento delle funzionalità dell'applicazione.

- Scalabilità orizzontale: La scalatura orizzontale comporta l'aumento o la diminuzione del numero di istanze per ogni microservizio in base alla domanda. Ciò può essere ottenuto regolando le repliche desiderate per ogni servizio nella configurazione della piattaforma di orchestrazione.

- Scalabilità verticale: Il vertical scaling comporta la regolazione delle risorse assegnate ai singoli container, come i limiti di CPU e memoria. Questo assicura un utilizzo ottimale delle risorse e può essere gestito attraverso la configurazione della piattaforma di orchestrazione.

Monitorando e scalando in modo efficace le applicazioni a microservizi Dockerizzate, è possibile massimizzare l'efficienza e garantire alta disponibilità, prestazioni e resilienza.

Le migliori pratiche per Docker e i microservizi

L'uso di Docker in un'architettura a microservizi offre numerosi vantaggi, ma per massimizzare il suo potenziale e garantire un processo di sviluppo e distribuzione senza interruzioni, è essenziale seguire alcune best practice:

- Ridurre al minimo le dimensioni dell'immagine Docker: Mantenere le immagini Docker di dimensioni ridotte aiuta a ridurre i tempi di creazione e il consumo di risorse, il che è particolarmente importante in un'architettura a microservizi. Utilizzate build multi-stage, usate immagini di base piccole e appropriate e rimuovete i file non necessari dall'immagine finale.

- Architettura a strati per le immagini Docker: Strutturate le immagini Docker utilizzando un'architettura a strati per accelerare i tempi di creazione. I livelli vengono memorizzati nella cache da Docker durante il processo di creazione, il che significa che se il contenuto di un livello non è cambiato, non verrà ricostruito. Organizzate il vostro file Docker per sfruttare questa caratteristica, posizionando i livelli modificati di frequente verso la fine del file.

- Tagging e versioning coerenti delle immagini: Etichettare e versionare correttamente le immagini per tracciare facilmente le modifiche e tornare alle versioni precedenti, se necessario. Questo aiuta a mantenere la stabilità dell'applicazione e semplifica la risoluzione dei problemi.

- Implementare la registrazione e il monitoraggio: Incorporare soluzioni di logging e monitoraggio per gestire e osservare efficacemente i microservizi containerizzati. Docker fornisce driver nativi per il logging, ma è possibile integrare anche strumenti di terze parti progettati per le architetture a microservizi, come Elasticsearch, Logstash e Kibana (ELK Stack) o Prometheus.

- Adottare piattaforme di orchestrazione dei container: Utilizzate strumenti di orchestrazione dei container come Kubernetes o Docker Swarm per automatizzare le attività di distribuzione, scalabilità e gestione. Questi strumenti gestiscono attività complesse come il bilanciamento del carico, gli aggiornamenti periodici e lo scaling automatico, assicurando che i microservizi funzionino in modo efficiente ed efficace.

- Migliorare la sicurezza: Migliorate la sicurezza dei vostri microservizi containerizzati applicando il principio del minimo privilegio, utilizzando immagini di base sicure e riducendo al minimo la superficie di attacco limitando il numero di pacchetti installati. Abilitate la segmentazione di rete tra i servizi e scansionate le vulnerabilità nelle immagini Docker.

- Usare le variabili d'ambiente per la configurazione: Disaccoppiate la configurazione dalle immagini Docker e usate le variabili d'ambiente per separare meglio i problemi. Questo assicura che una singola immagine Docker possa essere configurata in modo diverso per vari ambienti, migliorando la flessibilità e riducendo la duplicazione.

Conclusione

L'utilizzo di Docker in un'architettura a microservizi consente agli sviluppatori e alle organizzazioni di sfruttare appieno i vantaggi della containerizzazione, portando ad applicazioni più agili, efficienti e scalabili. Seguendo le best practice descritte in precedenza, è possibile integrare perfettamente Docker nei processi di sviluppo e distribuzione in un'architettura a microservizi, trasformando il modo di costruire e mantenere le applicazioni.

Inoltre, l'integrazione di Docker con piattaforme no-code come AppMaster può contribuire a migliorare l'esperienza di sviluppo delle applicazioni. AppMaster consente agli utenti di creare visivamente applicazioni web, mobili e backend, e il codice sorgente generato può essere containerizzato e gestito con Docker per una distribuzione fluida e scalabile. La combinazione di Docker e AppMaster può migliorare notevolmente il processo di sviluppo delle applicazioni, rendendolo più efficiente, economico e veloce che mai.

FAQ

Docker è una piattaforma open-source per la containerizzazione delle applicazioni, che facilita la creazione e la distribuzione di sistemi distribuiti, compresi i microservizi. Automatizza la distribuzione delle applicazioni in contenitori leggeri e portatili, facilitando la collaborazione e garantendo la coerenza tra gli ambienti.

I microservizi sono un modello di architettura software in cui una singola applicazione è progettata come un insieme di servizi piccoli, modulari e distribuibili in modo indipendente. Ogni servizio esegue una funzionalità specifica, comunica con altri servizi tramite API e può essere aggiornato, distribuito e scalato in modo indipendente.

Docker semplifica lo sviluppo, la distribuzione e la scalabilità dei microservizi fornendo un ambiente standardizzato per la containerizzazione delle applicazioni. Questo accelera lo sviluppo, migliora la portabilità, riduce la richiesta di risorse di sistema e semplifica la gestione e l'orchestrazione dei microservizi.

Per containerizzare un microservizio usando Docker, si scrive un Dockerfile che contiene le istruzioni per costruire un'immagine Docker del servizio. Il file Docker definisce l'immagine di base, il codice sorgente dell'applicazione, le dipendenze e le configurazioni. Le immagini Docker vengono eseguite come contenitori, fornendo un ambiente coerente per i microservizi nelle diverse fasi di sviluppo e distribuzione.

La distribuzione e l'orchestrazione dei container Docker possono essere effettuate utilizzando strumenti di orchestrazione dei container, come Kubernetes o Docker Swarm. Questi strumenti automatizzano le attività di distribuzione, scalatura e gestione dei container, facilitando il funzionamento continuo ed efficiente dei microservizi containerizzati.

Alcune best practice per l'uso di Docker con i microservizi includono: 1. Ridurre al minimo le dimensioni dell'immagine utilizzando immagini di base adeguate e rimuovendo i file non necessari. 2. Utilizzare un'architettura a strati per le immagini Docker per accelerare i tempi di creazione. 3. Applicare tag e versioning coerenti per le immagini. 4. Implementare soluzioni di registrazione e monitoraggio. 5. Adottare strumenti di orchestrazione dei container per gestire e scalare i container.

Sì, Docker può essere utilizzato con le piattaforme no-code come AppMaster per distribuire applicazioni backend e web scalabili ed efficienti. AppMaster consente agli utenti di creare visivamente le applicazioni e di generare il codice sorgente, che può essere containerizzato con Docker per uno sviluppo e una distribuzione senza interruzioni.

Docker semplifica il monitoraggio e lo scaling dei microservizi, consentendo una perfetta integrazione degli strumenti di monitoraggio, offrendo un migliore utilizzo delle risorse e facilitando lo scaling automatico attraverso le piattaforme di orchestrazione dei container. Docker può anche contribuire a garantire le prestazioni e la coerenza delle applicazioni, fornendo un ambiente standardizzato per l'esecuzione e la gestione dei microservizi.