マイクロサービス・アーキテクチャにDockerを活用する

アプリケーション開発を加速し、スケーラビリティを向上させるためのコンテナ化やデプロイ戦略など、マイクロサービス・アーキテクチャでDockerを活用するメリットを探ります。

Dockerとマイクロサービス

マイクロサービス・アーキテクチャは、ソフトウェア・アプリケーションのスケーラビリティ、柔軟性、およびメンテナンスに関して大きな利点を提供するため、近年ますます人気が高まっています。その中核となるマイクロサービスは、1つのアプリケーションが、それぞれが特定の機能を担当し、 APIを通じて 相互に通信する、小規模で独立したサービスの集まりで構成されるアーキテクチャパターンです。このモジュール性により、アプリケーションの迅速な開発、デプロイ、容易なテスト、便利なスケーリングが可能になる。

この文脈において、 Dockerは マイクロサービスを扱うための強力なツールとして浮上している。Dockerは、コンテナ化によってアプリケーションの開発、デプロイ、管理を容易にするオープンソースのプラットフォームです。開発者はアプリケーションとその依存関係を軽量でポータブルなコンテナにパッケージ化することができ、異なる環境や開発段階でも一貫してアプリケーションを実行することができます。Dockerを活用することで、開発者はマイクロサービスの構築、管理、スケーリングのプロセスを効率的に合理化できます。

なぜマイクロサービス・アーキテクチャにDockerを使うのか?

Dockerとマイクロサービスは、いくつかの重要な理由から自然にフィットします。

標準化された環境

Dockerは、アプリケーション自体、ライブラリ、依存関係を含むすべての必要なコンポーネントを、コンテナと呼ばれる単一の自己完結型ユニットにパッケージ化することで、開発者が標準化されたアプリケーション環境を作成することを可能にします。この標準化により、開発環境、ステージング環境、本番環境の間で起こりうる環境の不整合のリスクを低減し、マイクロサービスが一貫して期待通りに動作することを保証します。

開発の加速

Dockerコンテナの使用は、マイクロサービスの開発プロセスを大幅に加速します。各コンテナは分離された環境であるため、開発者は競合する依存関係やライブラリを気にすることなく、個々のサービスに取り組むことができます。さらに、Dockerイメージはチームメンバー間で簡単に共有できるため、ローカルマシン上でアプリケーションを迅速にデプロイして実行することができ、開発とコラボレーションが加速します。

移植性の向上

Dockerで作成されたコンテナは移植性が高いため、開発者は異なる環境やプラットフォーム間でアプリケーションを簡単に移動できます。この移植性により、基礎となるインフラに関係なく、異なるシステム上で一貫してマイクロサービスをデプロイし、実行することができます。その結果、 開発チームは システム固有のニュアンスを気にすることなく、最高のアプリケーションを構築することに集中できます。

システム・リソース使用量の削減

マイクロサービスアーキテクチャは、各サービスが別々のマシン上で実行され、システムリソースにオーバーヘッドが発生するため、リソース消費の増加につながる可能性があります。Dockerは、ホストシステムの基本リソースを共有する軽量コンテナを作成することでこの問題に対処し、複数の仮想マシンを実行する場合と比較して、全体的なリソース消費を削減します。

簡素化されたマイクロサービス管理

Dockerはコンテナのデプロイと実行に一貫した環境を提供することで、マイクロサービスの管理と監視を簡素化します。開発者は Docker Composeの ようなツールを使って、個々のマイクロサービスとその依存関係を含むアプリケーションスタック全体を定義することができ、サービスの一貫したデプロイと管理が容易になります。

Dockerによるマイクロサービスのコンテナ化

Dockerでマイクロサービスをコンテナ化するには、Dockerイメージの構築手順を含むDockerfileを作成する必要があります。このセクションでは、Dockerを使ってサンプルのマイクロサービスをコンテナ化するプロセスを説明します。

Dockerfileの作成

DockerfileはDockerイメージをビルドするための指示を含むスクリプトです。Dockerfileはベースイメージ、アプリケーションのソースコード、依存関係、サービスの実行に必要な設定を定義します。マイクロサービスのルートディレクトリに`Dockerfile`という名前の新しいファイルを作成します。

ベースイメージの定義

Dockerfileに `FROM` コマンドを追加して、マイクロサービスのベースイメージを指定します。ベースイメージはコンテナの基盤となり、必要な実行環境を提供します。Dockerが提供する公式の最小限のイメージや、ニーズに合わせたカスタムイメージなど、マイクロサービスに適切なベースイメージを選択することが重要です。例えば、あなたのマイクロサービスがNode.jsで開発されている場合、Dockerfileで以下の行を使うかもしれません:

FROM node:14

作業ディレクトリの設定

WORKDIR`コマンドを使ってコンテナの作業ディレクトリを設定する。このディレクトリは、アプリケーションのソースコードと依存関係を格納するために使用される。

WORKDIR /app

ソースコードと依存関係をコピーする

COPY` コマンドを使用して、ソースコードと必要なファイルをローカルマシンからコンテナにコピーする。さらに、npm、pip、Mavenなどのパッケージマネージャを使用して、必要な依存関係をインストールする。

COPY package*.json ./ RUN npm install COPY .

サービスポートの公開

EXPOSE`コマンドを使用して、マイクロサービスにアクセスできるポートを公開します。これにより、他のコンテナや外部サービスからマイクロサービスと通信できるようになる。

EXPOSE 8080

アプリケーションの実行

アプリケーションの実行に必要なコマンドを指定して、`CMD` コマンドでマイクロサービスを起動する。

CMD ["npm", "start"] を実行する。

Dockerfileを作成したら、Dockerfileと同じディレクトリで以下のコマンドを実行してDockerイメージをビルドします:

docker build -t your-image-name .

最後に、新しく作成したイメージを使ってDockerコンテナを実行する:

docker run -p 8080:8080 your-image-name .

これでマイクロサービスがコンテナ化され、Dockerコンテナ内で実行されるようになりました。このプロセスをアプリケーションの各マイクロサービスで繰り返すことで、合理的、効率的、かつ一貫性のある方法でマイクロサービスを開発、テスト、デプロイすることができます。

Dockerコンテナのデプロイとオーケストレーション

Dockerコンテナのデプロイとオーケストレーションは、マイクロサービスアーキテクチャを管理する上で不可欠な要素です。コンテナオーケストレーションツールは、個々のコンテナのデプロイ、管理、スケーリングを自動化し、マイクロサービスが効率的に連携するようにします。2つの人気のあるコンテナオーケストレーションプラットフォームは、KubernetesとDocker Swarmです。

Kubernetes

Kubernetesは オープンソースのコンテナ・オーケストレーション・プラットフォームで、コンテナ化されたアプリケーションのデプロイ、スケーリング、管理を自動化する。その強力な機能と強力なエコシステムにより、広く採用されている。Kubernetesの主なメリットは以下の通り:

- スケーラビリティ: Kubernetesは宣言型コンフィギュレーションを使用してコンテナのスケーリングを管理するため、需要に応じたアプリケーションのスケーリングが容易になる。

- 高い可用性: Kubernetesは、コンテナを異なるノードに分散し、障害発生時にコンテナの再起動を自動的に管理することで、高い可用性を確保します。

- ロードバランシング: Kubernetesは、マイクロサービスの複数のインスタンス間でリクエストのバランスをとり、パフォーマンスとフォールトトレランスを向上させます。

- ロギングとモニタリング: Kubernetesは様々なロギングやモニタリングツールと統合され、アプリケーションのヘルスとパフォーマンスのトラッキングを簡素化します。

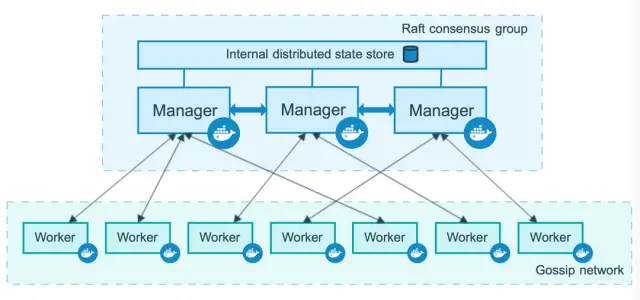

Docker Swarm

Docker Swarmは、Dockerコンテナ向けのネイティブなクラスタリングとオーケストレーションのソリューションです。Dockerプラットフォームに直接統合されているため、Dockerユーザーにとってシンプルで直感的な選択肢となっています。Docker Swarmには以下のような利点があります:

- 簡単なセットアップ: Docker Swarmは大規模なインストールや設定を必要としません。Docker CLIやAPIとシームレスに動作するため、コンテナのデプロイや管理が簡単になります。

- スケーリング: Docker Swarmでは、サービスごとにコンテナレプリカの数を調整することで、迅速かつ効率的にサービスをスケールさせることができます。

- ロードバランシング: Docker Swarmはコンテナ間でリクエストを自動的に分散し、アプリケーションのパフォーマンスと耐障害性を向上させます。

- サービスディスカバリー: Docker Swarmには、サービスディスカバリのための組み込みDNSサーバーが含まれており、コンテナ同士のディスカバリと通信を可能にします。

画像ソースDocker Docs

KubernetesとDocker Swarmの両方は、マイクロサービスアーキテクチャでDockerコンテナを管理するための一般的なオーケストレーションツールです。適切なツールの選択は、アプリケーションの特定の要件と、既存のインフラストラクチャとチームの専門知識に依存します。

Docker化されたマイクロサービス・アプリケーションの作成

Docker化されたマイクロサービスアプリケーションを作成する手順を説明しましょう:

- マイクロサービスを設計する: アプリケーションを、独立して開発、デプロイ、スケーリングできる複数の小さなモジュール化されたサービスに分解します。各マイクロサービスは明確に定義された責任を持ち、APIやメッセージングキューを介して他のサービスと通信する必要があります。

- Dockerfileを作成する: 各マイクロサービスについて、ベースイメージ、アプリケーションコード、依存関係、Dockerイメージの構築に必要な設定を指定するDockerfileを作成します。このイメージはマイクロサービスをコンテナとしてデプロイするために使用されます。

- Dockerイメージをビルドする: Docker buildコマンドを実行して、対応するDockerfileに定義されている指示に従って、各マイクロサービスのDockerイメージを作成します。

- ネットワーキングを作成する: マイクロサービス間の通信を可能にするために、コンテナ間のネットワーキングを確立します。ネットワーキングは、Docker Composeや、KubernetesやDocker Swarmのようなコンテナオーケストレーションツールを使用して行うことができます。

- ロードバランシングを設定する: ロードバランサーをセットアップして、リクエストをマイクロサービスのインスタンス間で分散し、最適なパフォーマンスとフォールトトレランスを確保します。Kubernetes IngressやDocker Swarmのビルトインロードバランシングのようなツールを使いましょう。

- マイクロサービスをデプロイする: お好みのコンテナ・オーケストレーション・プラットフォームを使用して、マイクロサービスをDockerコンテナとしてデプロイします。これにより、マイクロサービスが動作し、互いに通信し、オンデマンドでスケールできる環境が構築されます。

これらのステップがすべて完了すると、各マイクロサービスがDockerコンテナとしてデプロイされ、マイクロサービス・アプリケーションが稼働します。

Docker化されたマイクロサービスのモニタリングとスケーリング

モニタリングとスケーリングは、Docker化されたマイクロサービスアプリケーションのパフォーマンス、信頼性、効率を確保するために不可欠です。以下は検討すべき重要な戦略です:

モニタリング

監視ツールはDockerコンテナの健全性とパフォーマンスを追跡するのに役立ち、マイクロサービスが最適に動作していることを保証します。一般的な監視ツールには次のようなものがあります:

- Prometheus:Prometheus:コンテナ環境のための強力なオープンソースのモニタリングとアラートツールキットで、可視化とアラートのためのGrafanaとの統合を含む。

- Datadog:コンテナのメトリクス、ログ、トレースを集約し、アプリケーションのパフォーマンスをリアルタイムで把握できる包括的な観測可能プラットフォーム。

- ELKスタック:Elasticsearch、Logstash、Kibanaの組み合わせで、Dockerコンテナからのログの一元的な検索、分析、可視化に使用されます。

潜在的な問題を特定し、効果的にトラブルシューティングを行うために、監視セットアップが関連するメトリクス、ログ、パフォーマンスデータを収集していることを確認します。

スケーリング

Docker化されたマイクロサービスのスケーリングには、ワークロードと需要の変化に適応するために、各サービスを実行するコンテナの数を調整することが含まれます。KubernetesやDocker Swarmのようなコンテナ・オーケストレーション・プラットフォームは自動スケーリングを容易にし、アプリケーションの機能強化に集中できるようにします。

- 水平スケーリング: 水平スケーリングでは、各マイクロサービスのインスタンス数を需要に応じて増減します。これは、オーケストレーション・プラットフォームの設定で、各サービスに必要なレプリカを調整することで実現できます。

- 垂直スケーリング: 垂直スケーリングでは、CPUやメモリの上限など、個々のコンテナに割り当てられるリソースを調整します。これは最適なリソース利用を保証するもので、オーケストレーション・プラットフォームの設定で管理できます。

Docker化されたマイクロサービス・アプリケーションを効果的に監視しスケーリングすることで、効率を最大化し、高い可用性、パフォーマンス、回復力を確保することができます。

Dockerとマイクロサービスのベストプラクティス

マイクロサービスアーキテクチャでDockerを使用することは多くのメリットをもたらしますが、その可能性を最大限に引き出し、シームレスな開発とデプロイプロセスを保証するためには、いくつかのベストプラクティスに従うことが不可欠です:

- Dockerイメージサイズを最小化する: Dockerイメージを小さく保つことは、ビルド時間とリソース消費を削減するのに役立ち、これはマイクロサービスアーキテクチャでは特に重要です。多段階ビルドを利用し、小さく適切なベースイメージを使用し、最終イメージから不要なファイルを削除します。

- Dockerイメージのレイヤードアーキテクチャ: ビルド時間を短縮するために、レイヤーアーキテクチャを使ってDockerイメージを構成しましょう。レイヤはビルドプロセス中にDockerによってキャッシュされるため、レイヤの内容が変更されていなければ、再構築されることはありません。この機能を利用するためにDockerfileを整理し、頻繁に変更されるレイヤーをファイルの末尾に配置しましょう。

- 一貫した画像のタグ付けとバージョン管理: 変更を簡単に追跡し、必要に応じて以前のバージョンにロールバックするために、イメージに適切なタグ付けとバージョン管理を行います。これにより、アプリケーションの安定性を維持し、トラブルシューティングを簡素化できます。

- ロギングとモニタリングの導入: コンテナ化されたマイクロサービスを効果的に管理・監視するために、ロギングとモニタリングのソリューションを組み込みましょう。Dockerはネイティブのロギングドライバを提供しますが、Elasticsearch、Logstash、Kibana(ELK Stack)やPrometheusなど、マイクロサービスアーキテクチャ向けに設計されたサードパーティのツールを統合することもできます。

- コンテナ・オーケストレーション・プラットフォームを採用する: KubernetesやDocker Swarmのようなコンテナ・オーケストレーション・ツールを使用して、デプロイ、スケーリング、管理タスクを自動化する。これらのツールは、ロードバランシング、ローリングアップデート、自動スケーリングなどの複雑なタスクを処理し、マイクロサービスが効率的かつ効果的に機能するようにします。

- セキュリティの強化: 最小特権の原則を適用し、安全なベースイメージを使用し、インストールされるパッケージの数を制限して攻撃対象領域を最小化することで、コンテナ化されたマイクロサービスのセキュリティを向上させます。サービス間のネットワークセグメンテーションを有効にし、Dockerイメージの脆弱性をスキャンします。

- コンフィギュレーションに環境変数を使用する: Dockerイメージからコンフィギュレーションを切り離し、環境変数を使用することで、より良い分離を実現します。これにより、1つのDockerイメージを様々な環境で異なるように設定できるようになり、柔軟性が向上し、重複が減ります。

結論

マイクロサービスアーキテクチャでDockerを活用することで、開発者や組織はコンテナ化のメリットを最大限に享受でき、より俊敏で効率的、スケーラブルなアプリケーションを実現できます。上記で説明したベストプラクティスに従うことで、Dockerをマイクロサービスアーキテクチャの開発・デプロイプロセスにシームレスに統合し、アプリケーションの構築・保守方法を変革することができます。

さらに、 AppMasterの ような ノーコード・ プラットフォームとDockerを統合することで、アプリケーション開発エクスペリエンスを向上させることができます。AppMaster 、ユーザはウェブ、モバイル、バックエンドのアプリケーションを視覚的に作成することができ、生成されたソースコードはDockerを使ってコンテナ化・管理することで、スムーズでスケーラブルなデプロイが可能になります。DockerとAppMaster のパワーを組み合わせることで、アプリケーション開発プロセスを大幅に強化することができ、これまで以上に効率的で費用対効果が高く、迅速な開発が可能になります。

よくある質問

Dockerはアプリケーションをコンテナ化するオープンソースのプラットフォームで、マイクロサービスを含む分散システムの構築とデプロイを容易にします。軽量でポータブルなコンテナへのアプリケーションのデプロイを自動化し、コラボレーションを促進し、環境間の一貫性を確保します。

マイクロサービスとは、1つのアプリケーションを小規模でモジュール化され、独立してデプロイ可能なサービスの集合体として設計するソフトウェア・アーキテクチャ・パターンである。各サービスは特定の機能を実行し、APIを通じて他のサービスと通信し、独立して更新、デプロイ、拡張することができる。

Dockerは、アプリケーションをコンテナ化するための標準化された環境を提供することで、マイクロサービスの開発、デプロイ、スケーリングを合理化します。これにより、開発が加速し、移植性が向上し、システムリソースの要求が削減され、マイクロサービスの管理とオーケストレーションが簡素化されます。

Dockerを使用してマイクロサービスをコンテナ化するには、サービスのDockerイメージをビルドする手順を含むDockerfileを記述します。Dockerfileはベースイメージ、アプリケーションのソースコード、依存関係、設定を定義します。Dockerイメージはコンテナとして実行され、開発とデプロイの異なる段階にわたってマイクロサービスに一貫した環境を提供します。

Dockerコンテナのデプロイとオーケストレーションは、KubernetesやDocker Swarmなどのコンテナオーケストレーションツールを使って行うことができます。これらのツールはコンテナのデプロイ、スケーリング、管理タスクを自動化し、コンテナ化されたマイクロサービスのシームレスで効率的な運用を促進します。

マイクロサービスでDockerを使うためのベスト・プラクティスには、以下のようなものがある:1.適切なベースイメージを使用し、不要なファイルを削除することで、イメージサイズを最小化する。2.ビルド時間を短縮するために、Dockerイメージにレイヤーアーキテクチャを使用する。3.イメージに一貫したタグ付けとバージョン管理を適用する。4.ロギングとモニタリングのソリューションを導入する。5.コンテナの管理とスケーリングにコンテナ・オーケストレーション・ツールを採用する。

AppMaster スケーラブルで効率的なバックエンドやウェブ・アプリケーションをデプロイするために、Dockerはno-code AppMaster のようなプラットフォームで使用することができます。ユーザは視覚的にアプリケーションを作成し、ソースコードを生成することができ、Dockerを使用してシームレスな開発とデプロイのためにコンテナ化することができます。

Dockerは、監視ツールのシームレスな統合を可能にし、より良いリソース利用を提供し、コンテナオーケストレーションプラットフォームを通じて自動スケーリングを容易にすることで、マイクロサービスの監視とスケーリングを簡素化します。Dockerはまた、マイクロサービスの実行と管理に標準化された環境を提供することで、アプリケーションのパフォーマンスと一貫性を確保するのに役立ちます。