Rise ChatGPT pobudza debaty na temat plagiatu, halucynacji i przejrzystości w sztucznej inteligencji

Ponieważ ChatGPT OpenAI zyskuje na popularności, opracowywane są nowe narzędzia, takie jak GPTZero i narzędzie do sprawdzania prawdy Got It AI, aby przeciwdziałać plagiatom i halucynacjom.

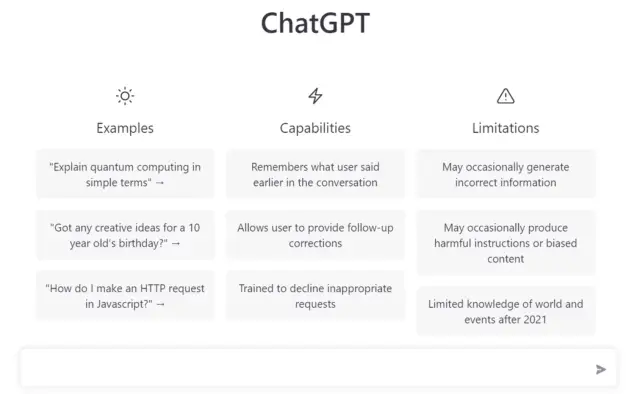

Szybkie pojawienie się ChatGPT OpenAI w centrum uwagi sztucznej inteligencji w ciągu zaledwie siedmiu tygodni wywołało dyskusje na temat potencjału tej technologii w zakresie powodowania plagiatu, halucynacji i późniejszego wpływu na środowisko akademickie. Jako model języka sztucznej inteligencji, biegły w generowaniu wysoce przekonujących odpowiedzi tekstowych, ChatGPT wykazuje znaczną zdolność do rapowania, rymowania, rozwiązywania złożonych problemów matematycznych, a nawet pisania kodu komputerowego.

Artykuł Stephen Marche's, The College Essay Is Dead, podkreśla nieprzygotowanie środowiska akademickiego na to, jak sztuczna inteligencja zmieni krajobraz edukacyjny. Jednak pierwsze kroki przeciwko zagrożeniu plagiatem ChatGPT zostały już podjęte w okręgach szkół publicznych w Seattle i Nowym Jorku. Ponadto postęp technologiczny zapewnia możliwość wykrywania generatywnego wykorzystania sztucznej inteligencji.

W ciągu Nowego Roku Edward Tian, główny informatyk Uniwersytetu Princeton, opracował GPTZero, aplikację przeznaczoną do skutecznego wykrywania, czy dany fragment tekstu został napisany przez ChatGPT, czy przez człowieka. GPTZero analizuje dwie cechy tekstu: zakłopotanie i wybuchowość. Tian odkrył, że ChatGPT generuje mniej złożone i bardziej spójne teksty niż literatura ludzka.

Chociaż GPTZero nie jest doskonały, wykazuje obiecujące wyniki. Tian prowadzi rozmowy z zarządami szkół i funduszami stypendialnymi w celu dostarczenia GPTZeroX do 300 000 szkół i instytucji finansujących. Oprócz GPTZero programiści tworzą narzędzia do walki z halucynacjami, co jest kolejnym problemem wynikającym z znaczenia ChatGPT.

Peter Relan z Got It AI, firmy specjalizującej się w niestandardowych rozwiązaniach sztucznej inteligencji do konwersacji, podkreśla, że duże modele językowe, takie jak ChatGPT, nieuchronnie wywołują halucynacje. Współczynnik halucynacji ChatGPT wynosi obecnie od 15% do 20%, ale wykrycie, kiedy model ma halucynacje, doprowadzi do dostarczenia dokładniejszych odpowiedzi.

W zeszłym tygodniu firma Got It AI ogłosiła prywatną wersję zapoznawczą nowego komponentu Autonomous Articlebot do sprawdzania prawdy, który wykorzystuje duży model językowy przeszkolony do identyfikowania nieprawdy opowiadanej przez ChatGPT i inne modele. Ten weryfikator prawdy ma obecnie wskaźnik dokładności na poziomie 90%, skutecznie podnosząc ogólny wskaźnik dokładności ChatGPT do 98%.

Chociaż całkowite wyeliminowanie halucynacji z konwersacyjnych systemów sztucznej inteligencji jest nierealne, zminimalizowanie ich występowania jest prawdopodobne. OpenAI, twórca ChatGPT, nie wydał jeszcze interfejsu API dla dużego modelu językowego. Jednak podstawowy model, GPT-3, ma dostępny interfejs API. Narzędzie do sprawdzania prawdy Got It AI może być używane z najnowszą wersją GPT-3, davinci-003.

Relan wierzy, że OpenAI zaradzi tendencji do halucynacji podstawowej platformy, z zauważalną poprawą już widoczną w zmniejszeniu wskaźnika błędów ChatGPT. Nadrzędnym wyzwaniem dla OpenAI jest zmniejszenie częstości halucynacji w czasie.

Dzięki narzędziom takim jak GPTZero i narzędzie do sprawdzania prawdy Got It AI można złagodzić zagrożenie ze strony sztucznej inteligencji w przypadku plagiatu i halucynacji. W miarę postępów w przejrzystości i dokładności sztucznej inteligencji platformy takie jak AppMaster i inne nadal pomagają w przyspieszaniu rozwoju aplikacji backendowych, internetowych i mobilnych dla szerokiego grona użytkowników, od małych firm po przedsiębiorstwa.