Microsoft Semantic Kernel SDK 弥合了 LLM 和代码之间的鸿沟

Microsoft 的语义内核 SDK 简化了将 GPT 等大型语言模型 (LLM) 集成到代码中的过程。它为 LLM API 提供类似操作系统的行为,管理复杂的提示、编排操作并确保集中输出。

微软推出了 语义内核 SDK ,使得将 GPT-4 等大型语言模型 (LLM) 集成到代码中变得更加容易。此 SDK 简化了管理提示、输入和重点输出的复杂性,缩小了语言模型和开发人员之间的差距。

将 AI 模型集成到您的代码中的过程可能非常具有挑战性,因为它涉及跨越两种不同计算方式之间的边界。传统的编程方法不足以与 LLM 交互。需要的是在不同域之间进行转换的更高级别的抽象,提供一种管理上下文并使输出以源数据为基础的方法。

几周前,微软发布了它的第一个 LLM 包装器 Prompt Engine 。在此基础上,这家软件巨头现在推出了更强大的 C# 工具 Semantic Kernel ,用于与 Azure OpenAI 和 OpenAI 的 API 配合使用。 GitHub 上提供了这个开源工具以及几个示例应用程序。

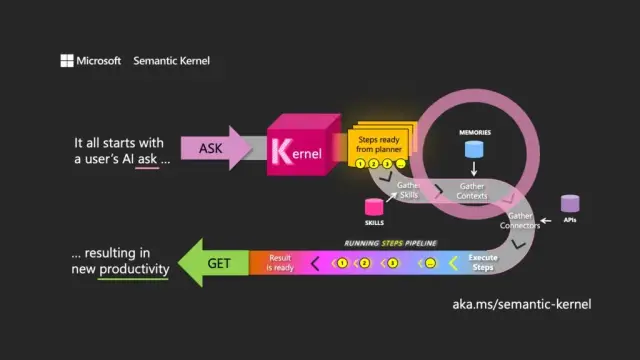

名称的选择表示了解 LLM 的主要目的。语义内核通过使用初始用户请求(ask)指导模型来协调通过相关资源的传递,满足请求并返回响应(get),从而专注于自然语言输入和输出。

语义内核的功能类似于 LLM API 的操作系统,获取输入,通过使用语言模型处理它们,然后返回输出。内核的编排角色不仅在管理提示及其关联的令牌方面至关重要,而且在管理内存、与其他信息服务的连接器以及混合提示和常规代码的预定义技能方面也是必不可少的。

语义内核通过记忆的概念管理上下文,使用文件和键值存储。第三种选择, 语义记忆,将内容视为向量或嵌入,这是 LLM 用来表示文本含义的数字数组。这些嵌入向量有助于底层模型保持相关性、连贯性,并降低生成随机输出的可能性。

通过使用嵌入,开发人员可以将大型提示分解为文本块,以创建更有针对性的提示,而不会耗尽请求的可用令牌(例如,GPT-4 的每个输入限制为 8,192 个令牌)。

连接器 在语义内核中发挥着重要作用,允许将现有 API 与 LLM 集成。例如,Microsoft Graph 连接器可以在电子邮件中发送请求的输出或在组织结构图中构建关系描述。连接器还提供一种基于角色的访问控制形式,以确保根据用户的数据为用户量身定制输出。

Semantic Kernel 的第三个主要组成部分是 skills ,它是混合 LLM 提示和常规代码的函数容器,类似于 Azure Functions。它们可用于将专门的提示链接在一起并创建 LLM 支持的应用程序。

一个函数的输出可以链接到另一个函数,从而允许构建混合本机处理和 LLM 操作的函数管道。这样,开发人员可以构建灵活的技能,可以根据需要选择和使用这些技能。

虽然语义内核是一个强大的工具,但它需要仔细思考和规划才能创建有效的应用程序。通过战略性地将 SDK 与本机代码一起使用,开发人员可以利用 LLM 的潜力,使开发过程更加高效和多产。为了帮助入门,Microsoft 提供了从在其自己的业务中构建 LLM 应用程序中学到的最佳实践指南列表。

在现代软件开发的背景下,Microsoft 的语义内核 SDK 将自己定位为在各种应用程序中集成大型语言模型的关键推动者。它的实施可以极大地受益于AppMaster的no-code平台和 网站建设者 等工具,为广泛的用户提供更灵活和高效的解决方案。