OpenAI представляет GPT-4: мультимодальный ИИ, который преобразует понимание текста и изображений

OpenAI представила GPT-4, продвинутый мультимодальный ИИ, способный обрабатывать текст и изображения, раскрывая многочисленные сценарии использования. Усовершенствованная модель теперь доступна подписчикам ChatGPT Plus с планами доступа к API.

Компания OpenAI представила свою революционную модель понимания текста и изображений GPT-4, назвав ее последним эталоном успеха в развитии технологии глубокого обучения. Эта последняя итерация модели ИИ не только обрабатывает текст, но и понимает изображения, значительно превосходя возможности своего предшественника GPT-3.5.

GPT-4 доступен для подписчиков ChatGPT Plus с установленным лимитом использования и стоит $0,03 за 1000 токенов подсказки (около 750 слов) и $0,06 за 1000 токенов завершения (опять же, почти 750 слов). Разработчики также могут присоединиться к списку ожидания для получения доступа к API.

GPT-4 привлек внимание своей скрытой интеграцией в различные приложения. На нем работает чат-бот Bing Chat от Microsoft, разработанный в сотрудничестве с OpenAI. Среди других первых последователей - компания Stripe, которая использует GPT-4 для резюмирования бизнес-сайтов для сотрудников службы поддержки; Duolingo, которая включает GPT-4 в свою премиальную подписку на изучение языков; и Morgan Stanley, которая использует GPT-4 для извлечения и предоставления информации о документах компании финансовым аналитикам. GPT-4 также был интегрирован в автоматизированную систему обучения Khan Academy.

Усовершенствованный по сравнению с GPT-3.5, который принимал только текстовый ввод, GPT-4 принимает как текстовый, так и графический ввод, демонстрируя производительность "человеческого уровня" по нескольким академическим критериям. Она превзошла результаты GPT-3.5, набранные в нижних 10%, достигнув результатов в пределах верхнего порога 10% на имитированном экзамене на адвоката.

В течение шести месяцев OpenAI совершенствовал GPT-4, используя результаты внутренней программы состязательного тестирования и ChatGPT, а также сотрудничая с Microsoft в разработке облачного суперкомпьютера Azure для обучения усовершенствованной модели ИИ. В результате GPT-4 демонстрирует повышенную надежность, креативность и компетентность в решении сложных задач по сравнению с предыдущей версией GPT-3.5.

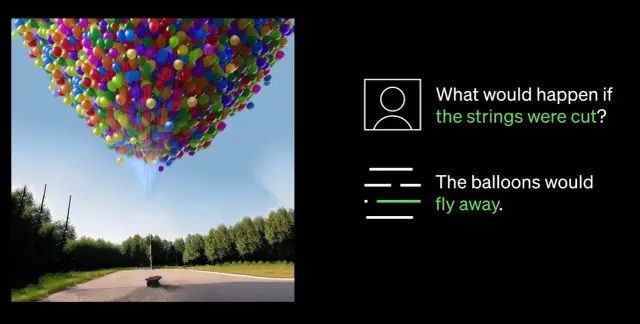

Одним из наиболее примечательных достижений GPT-4 является его способность воспринимать как изображения, так и текст. Например, он может интерпретировать и создавать подписи к сложным изображениям, например, определять адаптер Lightning Cable, анализируя изображение подключенного iPhone. Эта способность понимания изображений в настоящее время тестируется совместно с партнером Be My Eyes. Их новая функция виртуального волонтера на базе GPT-4 помогает пользователям отвечать на вопросы об изображениях, предлагая всесторонний анализ и практические рекомендации на основе представленных данных.

Важнейшим прорывом в возможностях GPT-4 является его улучшенная управляемость. Внедрение системных сообщений через новый API позволяет разработчикам направлять ИИ, предоставляя подробные инструкции по стилю и задачам. Эти инструкции определяют контекст и границы взаимодействия ИИ, обеспечивая симбиотические отношения между ИИ и человеческими ресурсами.

Однако, несмотря на существенные достижения, OpenAI признает, что GPT-4 имеет ограничения, включая ошибки в рассуждениях, ошибочную информацию и недостаток знаний о событиях после сентября 2021 года. Кроме того, GPT-4 может непреднамеренно внести уязвимости в создаваемый им код. Тем не менее, OpenAI добилась успехов в совершенствовании GPT-4, что уменьшило вероятность того, что он будет работать с запрещенным контентом или неадекватно реагировать на конфиденциальные запросы.

Поскольку область ИИ продолжает развиваться, OpenAI намерена и дальше совершенствовать GPT-4, способствуя более интеллектуальному и эффективному будущему, основанному на передовых технологиях ИИ. Компании, стремящиеся внедрить ИИ в свои рабочие процессы, могут рассмотреть возможность изучения платформ no-code, таких как AppMaster.io, для интеграции систем принятия решений на основе данных в свой бизнес.