AI Prompt Engineering: Hoe u AI-modellen kunt instrueren om de gewenste resultaten te krijgen

Ontdek de kunst van AI-prompt engineering en leer hoe u effectieve instructies voor AI-modellen kunt opstellen, wat leidt tot nauwkeurige resultaten en verbeterde softwareoplossingen.

Inleiding tot AI Prompt Engineering

Het snel evoluerende veld van kunstmatige intelligentie (AI) heeft nieuwe kansen geopend in sectoren en industrieën, wat heeft geresulteerd in een toegenomen afhankelijkheid van AI-systemen om problemen op te lossen en organisatiedoelstellingen te bereiken. Om het ware potentieel van AI-modellen te benutten, is het echter van cruciaal belang om een proces te begrijpen en te implementeren dat bekendstaat als prompt engineering. Deze techniek omvat het maken van nauwkeurige en effectieve invoer of "prompts" die AI-modellen begeleiden naar het genereren van de gewenste uitvoer.

AI-modellen, zoals taalmodellen, zijn ontworpen om te reageren op prompts door mensachtige tekst te produceren op basis van patronen die zijn afgeleid van uitgebreide trainingsgegevens. Helaas worden deze modellen inherent beperkt door de kwaliteit en duidelijkheid van de verstrekte prompts. Daarom speelt prompt engineering een cruciale rol bij het verbeteren van de prestaties van AI-modellen en het garanderen dat de uitvoer aansluit bij de verwachtingen van de gebruiker.

Om aan de slag te gaan met AI-prompt engineering, moet men eerst de basisbeginselen begrijpen van hoe AI-modellen werken en de informatie die ze ontvangen interpreteren. Het gaat om het formuleren van vragen, richtlijnen of taken op een manier die ervoor zorgt dat het AI-model ze duidelijk begrijpt, zodat het optimaal kan functioneren.

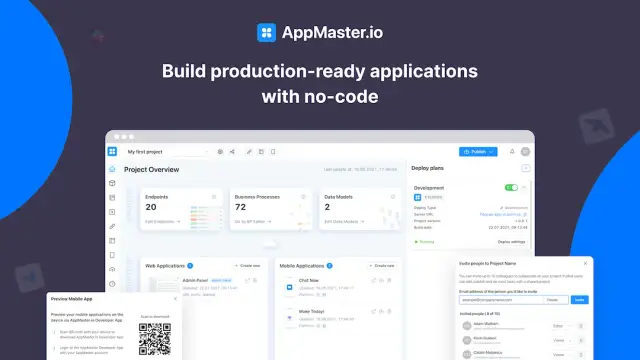

No-code-platforms hebben aanzienlijk bijgedragen aan het toegankelijker maken van AI-tools voor een breder publiek. Met dergelijke tools kunnen zelfs mensen met beperkte technische kennis experimenteren met AI-prompt-engineering, waarbij AI-integratie wordt afgestemd op specifieke zakelijke behoeften.

De belofte die AI biedt, is groot en verandert onze interactie met technologie van een tool in een interactieve partner die in staat is om behoeften vloeiend te begrijpen en erop te reageren. Het beheersen van AI-prompt-engineering is essentieel voor professionals die voorop willen blijven lopen in deze innovatieve ruimte, en vooruitgang willen boeken via geïnformeerde en nauwkeurige instructies die de effectiviteit van de output maximaliseren.

De basisprincipes van AI-modellen begrijpen

Artificial Intelligence (AI)-modellen vormen de ruggengraat van veel moderne technologische ontwikkelingen en voeden alles van spraakherkenningssystemen tot complexe besluitvormingsprocessen. Om de kracht van AI te benutten, is het essentieel om de onderliggende basisprincipes van AI-modellen te begrijpen, die in wezen algoritmen zijn die zijn ontworpen om waar te nemen, te redeneren, te leren en problemen op te lossen als een mens.

AI-modellen ondergaan aanvankelijk een trainingsfase, waarin ze enorme hoeveelheden data-input verwerken. Deze data wordt nauwkeurig gelabeld en dient als basis voor leerpatronen, functies en relaties die de AI kan generaliseren. De effectiviteit van een AI-model hangt grotendeels af van de kwaliteit en kwantiteit van de data waarop het is getraind, evenals de verfijning van de gebruikte algoritmen.

Data en algoritmen

De kern van AI-modellen bestaat uit twee fundamentele componenten: data en algoritmen. Gegevens voeden het begrip van de AI van verschillende contexten en situaties, terwijl algoritmen bepalen hoe het model deze gegevens interpreteert en verwerkt. Algoritmen, vaak geïnspireerd door biologische neurale netwerken, vergemakkelijken het vermogen van het model om conclusies te trekken, voorspellingen te doen en trends te identificeren.

Veelgebruikte algoritmen in AI zijn beslissingsbomen, neurale netwerken, ondersteunende vectormachines en clusters. Elk van deze algoritmen heeft verschillende kenmerken en is geschikt voor verschillende soorten taken. Neurale netwerken zijn bijvoorbeeld cruciaal in deep learning-praktijken, die uitblinken in taken voor beeld- en spraakherkenning vanwege hun ingewikkelde lagen die de structuur van het menselijk brein nabootsen.

Training en testen

Het trainingsproces van een AI-model omvat het voeden van gegevens, zodat het model ervan kan leren. Tijdens deze fase worden de interne parameters van het model aangepast en verfijnd door middel van talloze iteraties, waardoor fouten worden geminimaliseerd en de nauwkeurigheid wordt verbeterd. Deze finetuning wordt bereikt door middel van verschillende optimalisatietechnieken, zoals gradiëntafdaling, die het model helpen optimale prestatieniveaus te bereiken.

Nadat het is getraind, moet het AI-model worden getest om de effectiviteit ervan in real-world scenario's te evalueren. De testfase zorgt ervoor dat wanneer de AI nieuwe, ongeziene gegevens tegenkomt, deze nauwkeurig de taken kan uitvoeren waarvoor deze is ontworpen. Een veelvoorkomende valkuil in deze fase is overfitting, waarbij een model buitengewoon goed presteert op trainingsgegevens, maar hapert bij nieuwe gegevens vanwege de te complexe kenmerkextractie.

Modeltypen

Er bestaan verschillende typen AI-modellen, elk met unieke kenmerken die inspelen op verschillende use cases:

- Supervised Learning-modellen: Deze modellen vereisen gelabelde trainingsgegevens, die het algoritme begeleiden om te leren van input-outputparen. Het model leert om invoer toe te wijzen aan de gewenste uitvoer, wat dient als een krachtig hulpmiddel voor regressie- en classificatietaken.

- Niet-begeleide leermodellen: Deze modellen werken zonder gelabelde gegevens en identificeren patronen en relaties via dataclustering en technieken voor dimensionaliteitsreductie. Een voorbeeld is het gebruik van clusteralgoritmen om klanten met vergelijkbaar gedrag te groeperen.

- Reinforcement Learning-modellen: Deze verwijzen naar een categorie AI-modellen die leren door vallen en opstaan. Door interactie met hun omgeving ontwikkelen deze modellen een beleid dat de beste handelwijze bepaalt om een beloningssignaal te maximaliseren.

De rol van feedback

Feedback is van cruciaal belang bij het verfijnen van AI-modellen. Met continue feedback kunnen modellen hun algoritmen aanpassen om de nauwkeurigheid en efficiëntie te verbeteren. Deze feedbackloop zorgt ervoor dat AI-modellen zich in de loop van de tijd kunnen ontwikkelen en verbeteren, zodat ze aansluiten bij de behoeften en verwachtingen van eindgebruikers.

Door deze fundamentele concepten te begrijpen, kan men de complexiteit en het potentieel van AI-modellen waarderen. Naarmate de technologie vordert, biedt kennis over AI-fundamenten een kritische lens waardoor de toekomst van AI-toepassingen en -innovaties kan worden gemeten.

Het belang van effectieve, snelle engineering

In het groeiende domein van kunstmatige intelligentie (AI) is prompting veel meer dan alleen het geven van instructies. Het is een essentiële brug tussen menselijke intentie en machine-uitvoering, en vergroot de uitkomsten van intelligente systemen. Effectieve prompt-engineering vormt de interactiekwaliteit van AI en definieert hoe goed AI-modellen gebruikersopdrachten waarnemen en nauwkeurige, zinvolle reacties genereren. Het speelt een cruciale rol bij het optimaliseren van AI-toepassingen, het verbeteren van hun bruikbaarheid en het verzekeren van hun aanpasbaarheid in verschillende domeinen.

Verbetering van de prestaties van AI-modellen

De belangrijkste reden om te focussen op prompt-engineering is de directe impact op de prestaties van AI-modellen. Goed opgestelde prompts stellen modellen in staat hun volledige potentieel te benutten, wat resulteert in outputs die nauw aansluiten bij de verwachtingen van de gebruiker. Een zorgvuldig opgestelde prompt kan verborgen mogelijkheden binnen een model belichten, wat leidt tot consistent nauwkeurige resultaten.

Door prompts te verankeren aan specifieke doelen en contexten, slagen engineers erin om dubbelzinnigheid te verminderen, wat de duidelijkheid verbetert waarmee een model instructies interpreteert. Deze gestroomlijnde focus voorkomt dat AI-modellen afdwalen naar niet-gerelateerde of ongepaste gebieden bij het genereren van content, waardoor een gerichte output wordt gegarandeerd die het beoogde doel dient.

Gebruikerservaring verbeteren

Effectieve prompts spelen een belangrijke rol bij het verbeteren van de gebruikerservaring door de wrijving tussen menselijke interactie en machinerespons te minimaliseren. Gebruikers hebben waarschijnlijk minder last van misverstanden of irrelevante outputs wanneer prompts goed zijn opgesteld, wat het vertrouwen en de tevredenheid van de gebruiker bevordert.

Door gebruikersbehoeften te anticiperen en deze te vertalen in gestroomlijnde prompts, worden AI-modellen intuïtiever in hun reacties, waardoor gebruikers het inzicht of de oplossingen krijgen die ze actief zoeken. Deze symbiotische interactie resulteert in een verrijkte betrokkenheid, waardoor gebruikers het AI-potentieel kunnen benutten zonder overweldigende technische complexiteit.

Iteratieve werklast verminderen

Wanneer prompts geen relevante output leveren, nemen gebruikers vaak hun toevlucht tot het herzien en opnieuw indienen van verschillende variaties totdat de gewenste informatie is verkregen, wat tijdrovend en inefficiënt is. Effectieve prompt engineering helpt deze iteratieve werklast aanzienlijk te verminderen door de kans te vergroten dat er vanaf het begin geschikte reacties worden geproduceerd.

Aanpasbaarheid op platforms en use-cases

AI-modellen zijn bruikbaar voor talloze branches en doeleinden, van klantenservicebots tot gegevensverwerkingssystemen. De veelzijdigheid van prompt engineering zorgt ervoor dat AI-modellen zich naadloos aanpassen aan verschillende omgevingen en contextueel nauwkeurige reacties bieden, ongeacht de verschillende vereisten.

Concluderend kan de kunst van prompt engineering niet over het hoofd worden gezien bij het nastreven van geavanceerde AI-oplossingen. Het is een essentiële vaardigheid die de modelprecisie, gebruikerstevredenheid en toepassingsflexibiliteit aanzienlijk verbetert. Door te investeren in effectieve prompt engineering, ontsluiten bedrijven nieuwe dimensies in AI-innovatie, wat leidt tot intelligente oplossingen die aansluiten bij dynamische gebruikerseisen.

Belangrijkste werkwijzen voor het opstellen van succesvolle prompts

AI-promptengineering is een cruciaal onderdeel bij het benutten van het volledige potentieel van AI-modellen om de gewenste resultaten te behalen. Naarmate de AI-technologie zich blijft ontwikkelen, wordt het steeds belangrijker om te begrijpen hoe je effectieve prompts kunt maken. Hier verkennen we belangrijke praktijken die bijdragen aan succesvolle promptengineering en uiteindelijk leiden tot het bereiken van precieze en gewenste resultaten van AI-modellen.

Definieer de doelstellingen duidelijk

Een succesvolle prompt begint met een duidelijk begrip van de beoogde uitkomst. Dit betekent het definiëren van specifieke doelstellingen voor wat u wilt dat het AI-model bereikt. Of het nu gaat om het genereren van creatieve content, het leveren van gedetailleerde analyses of het aanbieden van feitelijke informatie, duidelijkheid in doelstellingen helpt bij het vormgeven van prompts die het AI-model effectief begeleiden.

Gebruik nauwkeurige taal

Precieze taal is cruciaal bij het maken van prompts. Dubbelzinnigheden of vage bewoordingen kunnen leiden tot onjuiste interpretaties door AI-modellen, wat resulteert in onbedoelde uitkomsten. Het is essentieel om eenvoudige taal te gebruiken, met goed gedefinieerde termen en zinnen die uw bedoeling overbrengen zonder ruimte voor verkeerde interpretatie.

Contextuele informatie opnemen

Context is een krachtig hulpmiddel bij AI-prompt engineering. Door relevante context naast uw prompt te bieden, kunnen AI-modellen het onderliggende scenario begrijpen en de kans op nauwkeurige resultaten vergroten. Dit kan het toevoegen van achtergronddetails of het specificeren van het formaat of de toon van de gewenste uitvoer omvatten, waardoor de AI de omgeving waarin deze opereert beter kan begrijpen.

Complexe taken opsplitsen

Bij complexe taken is het vaak nuttig om ze op te splitsen in kleinere, beter beheersbare componenten. Door prompts te maken die afzonderlijke facetten van een probleem aanpakken, kunt u het proces voor het AI-model vereenvoudigen, wat leidt tot beter geïnformeerde reacties en de kans op fouten verkleint.

Prompts herhalen en verfijnen

Prompt engineering is zelden een eenmalige inspanning. Iteratie en verfijning zijn belangrijke componenten van het ontwikkelen van succesvolle prompts. Door AI-gegenereerde outputs te analyseren en feedback te verzamelen, kunnen engineers gebieden identificeren die aanpassing en finetuning vereisen. Regelmatig testen en tweaken van prompts helpt hun effectiviteit te vergroten, wat uiteindelijk de modelprestaties verbetert.

Testvariabiliteit in reacties

Door AI-modellen te testen op meerdere prompts en scenario's, kunt u variabiliteit in reacties ontdekken, zodat u het modelgedrag beter kunt begrijpen. Inzicht krijgen in hoe veranderingen in formulering of structuur resultaten beïnvloeden, biedt waardevolle informatie voor het verfijnen en verbeteren van promptconstructie.

Maak gebruik van voorbeelden en sjablonen

Voorbeelden en sjablonen zijn praktische hulpmiddelen bij promptengineering en helpen bij het consistent maken van prompts. Het gebruik van gestandaardiseerde frameworks zorgt voor uniformiteit in de invoerstructuur, wat kan helpen de nauwkeurigheid en betrouwbaarheid van het model te behouden in verschillende use cases. Deze instrumenten dienen als benchmarks en signaleren effectieve promptfuncties voor vergelijkbare doelen.

Omarm feedbackloops

Feedbackloops zijn van onschatbare waarde op weg naar het maken van succesvolle prompts. Betrokkenheid bij door AI gegenereerde resultaten en het begrijpen van gebruikersreacties bieden cruciale aanwijzingen voor verbetering. Feedback helpt prompts te verfijnen door middel van voortdurende prestatiebeoordelingen, wat leidt tot progressieve verbetering en uiteindelijk tot nauwkeurigere en betrouwbaardere resultaten.

Veelvoorkomende uitdagingen en hoe deze te overwinnen

AI prompt engineering is een cruciaal onderdeel om het volledige potentieel van AI-modellen te benutten, maar het brengt ook zijn eigen uitdagingen met zich mee. Het begrijpen van deze obstakels en leren hoe je er effectief mee omgaat, kan de kwaliteit van je AI-gestuurde oplossingen aanzienlijk verbeteren.

Uitdaging 1: Dubbelzinnigheid in prompts

Een van de meest voorkomende uitdagingen is de dubbelzinnigheid die inherent is aan menselijke taal. Vage instructies kunnen leiden tot onbedoelde interpretaties door AI-modellen, wat resulteert in outputs die het doel missen. Om dit probleem aan te pakken, moeten engineers duidelijke en ondubbelzinnige taal gebruiken bij het ontwerpen van prompts. Het is cruciaal om de context en intentie expliciet te specificeren, zodat er geen ruimte is voor meerdere interpretaties.

Uitdaging 2: Variabiliteit in AI-reacties

AI-modellen produceren vaak verschillende reacties, zelfs wanneer ze vergelijkbare prompts krijgen. Deze variabiliteit kan het proces van het bereiken van consistente resultaten compliceren. Om deze uitdaging te overwinnen, moet je itereren op promptontwerpen en uitgebreid testen om te bepalen welke structuren de meest betrouwbare resultaten opleveren. Consistente feedbackloops zijn hierbij cruciaal, zodat prompt engineers instructies kunnen verfijnen en verbeteren totdat ze de gewenste consistentie bereiken.

Uitdaging 3: Afstemmen op AI-modelmogelijkheden

Elk AI-model heeft specifieke mogelijkheden en beperkingen. Niet alle modellen zijn goed in het interpreteren van complexe of genuanceerde prompts. Daarom is het essentieel om de specifieke sterke en zwakke punten van het gebruikte AI-model te begrijpen. Engineers moeten hun prompts aanpassen zodat ze binnen deze parameters passen, waardoor het vermogen van de AI om effectief te interpreteren en te reageren wordt geoptimaliseerd.

Uitdaging 4: Omgaan met overfitting

Overfitting treedt op wanneer een AI-model te veel wordt afgestemd op de trainingsgegevens, waardoor het vermogen om te generaliseren naar nieuwe gegevens wordt beperkt. Om overfitting tegen te gaan, kunnen prompt engineers technieken gebruiken zoals promptvariatie en ervoor zorgen dat diverse trainingsgegevens worden gebruikt om het model te trainen. Dit helpt bij het behouden van de flexibiliteit en aanpasbaarheid van het model bij nieuwe scenario's.

Uitdaging 5: De effectiviteit van prompts evalueren

Het bepalen van de effectiviteit van een prompt kan subjectief en complex zijn. Ingenieurs moeten statistieken en benchmarks definiëren om het succes objectief te evalueren. Dit omvat het stellen van duidelijke doelen voor wat de prompt moet bereiken en het meten van de output ten opzichte van deze doelen. Continue beoordeling en aanpassing van prompts op basis van deze evaluaties leiden tot verbeterde modellen.

Uitdaging 6: Feedback integreren voor verbetering

Feedback is onmisbaar bij het verfijnen van AI-prompts. Het verzamelen en integreren van feedback kan echter ontmoedigend zijn zonder gestructureerde processen. Het opzetten van een feedbacklus is essentieel wanneer input van eindgebruikers, testfases en analyses voortdurende promptaanpassingen informeren. Deze iteratieve aanpak zorgt ervoor dat het AI-model afgestemd blijft op de behoeften en verwachtingen van de gebruiker.

Door deze uitdagingen rechtstreeks aan te pakken, wordt niet alleen de effectiviteit van AI-promptengineering verbeterd, maar wordt ook de weg vrijgemaakt voor de ontwikkeling van geavanceerde AI-oplossingen. Door deze veelvoorkomende barrières te begrijpen en aan te pakken, kunnen prompt engineers het ware potentieel van AI-modellen ontsluiten, wat leidt tot nauwkeurigere en praktischere resultaten in verschillende toepassingen.

De rol van feedback bij het verfijnen van prompts

In de voortdurend evoluerende sfeer van AI-prompt engineering, dient feedback als een hoeksteen voor het verfijnen en optimaliseren van prompts om de effectiviteit van AI-modellen te verbeteren. Dit iteratieve proces bevordert een collaboratieve interactie tussen menselijke input en machine learning-systemen, wat leidt tot verbeterde nauwkeurigheid en gebruikerstevredenheid.

Het belang van feedback in AI-prompt engineering

Feedback is van onschatbare waarde omdat het duidelijkheid verschaft over hoe AI-modellen input interpreteren. Wanneer een AI-model een prompt verwerkt, biedt de resulterende output inzicht in de interpretatie van de bedoeling van de prompt. Door deze output te analyseren, kunnen prompt engineers vaststellen of de respons van de AI overeenkomt met de verwachte uitkomst. Als er discrepanties of inefficiënties worden opgemerkt, wordt feedback een essentieel hulpmiddel om het ontwerp van de prompt opnieuw te kalibreren en te verbeteren.

Als een AI-model dat is belast met klantenservice bijvoorbeeld een prompt aanvult met irrelevante informatie, kan feedback aangeven op welke gebieden verfijning nodig is. Deze feedback wordt gebruikt om de formulering, focus of context van prompts aan te passen om ervoor te zorgen dat het AI-model nauwkeuriger reageert bij toekomstige interacties.

Soorten feedback die worden gebruikt bij het verfijnen van prompts

Feedback voor het verfijnen van AI-prompts kan worden onderverdeeld in verschillende typen:

- Directe feedback: Directe gebruikersinvoer met betrekking tot de relevantie en nauwkeurigheid van door AI gegenereerde reacties kan technici helpen bij het aanpassen van promptstructuren.

- Prestatiestatistieken: Analyse- en prestatiegegevens die succespercentages, responstijden en foutfrequentie aangeven, kunnen kwantitatief inzicht bieden in de doeltreffendheid van prompts.

- Foutanalyse: Onderzoek naar veelvoorkomende fouten of misverstanden kan zwakke punten van prompts identificeren en gerichte verbeteringen mogelijk maken.

- Gebruikersgedrag: Het observeren van interactiepatronen en voorkeuren van gebruikers kan indirect promptverfijningen informeren door praktische bruikbaarheidsaspecten te onthullen.

Implementeren Feedback voor verbeterde prompt engineering

Het succesvol integreren van feedback in prompt engineering vereist een methodische aanpak. Ten eerste moeten er mechanismen voor het verzamelen van feedback worden opgezet, waaronder gebruikersenquêtes, monitoringsystemen en analytische tools. Zodra feedback is verzameld, moet de focus liggen op het identificeren van belangrijke gebieden die aandacht behoeven.

Iteratie is essentieel: stel incrementele wijzigingen voor aan prompts, werk ze bij op basis van verzamelde inzichten en evalueer de resultaten opnieuw. Deze cyclus van wijziging en beoordeling zorgt voor continue verbetering. Op deze manier kunnen prompt engineers de kwaliteit en effectiviteit van AI-prompts in de loop van de tijd systematisch verbeteren.

Feedback is integraal aan de vooruitgang van AI-prompt engineering. Naarmate AI-modellen geavanceerder worden, bepaalt het vermogen om prompts aan te passen en te verfijnen door middel van constructieve feedback de kwaliteit van de interactie tussen gebruikers en AI-systemen. Door de inzichten uit feedback te benutten, kunnen prompt engineers ervoor zorgen dat AI-uitkomsten relevant, nauwkeurig en waardevol blijven voor de eindgebruikerservaring.

Gebruikmaken van No-Code-tools in Prompt Engineering

Naarmate kunstmatige intelligentie (AI) evolueert, is het belang van het garanderen dat de implementatie ervan zowel naadloos als efficiënt is, aanzienlijk toegenomen. De opkomst van no-code-platforms heeft nieuwe mogelijkheden geopend voor het automatiseren en optimaliseren van taken die traditioneel werden bereikt door middel van complexe codering. Als het gaat om AI prompt engineering, zijn deze no-code-oplossingen onmisbaar voor degenen die mogelijk geen uitgebreide programmeervaardigheden hebben, maar toch de kracht van AI willen benutten voor verschillende toepassingen.

Gebruikers machtigen met visuele interfaces

No-code-platforms zijn ontworpen om softwareontwikkeling toegankelijk te maken door intuïtieve, visuele interfaces te bieden in plaats van op tekst gebaseerde code. Deze bevoegdheid strekt zich uit tot AI-promptengineering, waarbij gebruikers instructies voor AI-modellen kunnen construeren en aanpassen zonder dat ze diepgaande kennis van de onderliggende programmeercomplexiteit nodig hebben.

Zo kunnen gebruikers met AppMaster visueel datamodellen maken en bedrijfslogica ontwerpen met behulp van een drag-and-drop-methode. Deze gebruiksvriendelijke interface zorgt ervoor dat zelfs personen met minimale technische achtergrond effectieve AI-oplossingen kunnen bouwen door zich te richten op de weergave van bedrijfslogica en applicatieontwerp.

Geïntegreerde AI-mogelijkheden

No-code-platforms integreren AI-mogelijkheden steeds vaker rechtstreeks in hun ecosystemen, waardoor het snelle engineeringproces verder wordt vereenvoudigd. Door AI-tools te integreren, zoals NLP-engines (Natural Language Processing) en machine learning-frameworks, stellen deze platforms gebruikers in staat om te experimenteren met AI-instructies en deze te verfijnen binnen dezelfde omgeving die ze gebruiken om hun applicaties te ontwikkelen.

Snel prototypen en testen

Een van de grootste voordelen van het gebruik van no-code-platforms in prompt engineering is de mogelijkheid om snel prototypen te maken en verschillende AI-prompts te testen. Deze snelle cyclus stelt gebruikers in staat om hun prompts te herhalen en verschillende versies in realtime te testen om te evalueren hoe effectief ze AI-modellen begeleiden.

Door de kloof tussen het idee en de praktische toepassing te minimaliseren, stellen no-code-tools prompt engineers in staat om een veelvoud aan instructiesets te verkennen en hun benaderingen te verfijnen op basis van directe feedback en resultaten.

Toegang en samenwerking vergroten

No-code-platforms dragen ook bij aan het democratiseren van AI-gebruik door bredere toegang binnen organisaties te garanderen. Wanneer technische barrières worden verlaagd, kunnen teams effectiever samenwerken en inzichten van verschillende afdelingen zoals marketing, operations en klantenservice bundelen om AI-prompts te verfijnen die verder gaan dan alleen het technische team.

Veelvoorkomende uitdagingen bij prompt engineering aanpakken

Het benutten van no-code-tools helpt bij het aanpakken van veelvoorkomende uitdagingen bij AI-prompt engineering. Deze platforms bieden bijvoorbeeld bronnen voor contextbeheer, waarmee AI-modellen de omgeving kunnen begrijpen waarin gebruikersprompts worden gegeven. Door duidelijkere context te bieden via visueel ontworpen bedrijfslogica, kunnen prompts nauwkeuriger worden opgesteld, wat leidt tot betere AI-uitvoer.

Bovendien betekent het gemak waarmee nieuwe functies kunnen worden geïntegreerd en getest op no-code-platforms dat aanpassingen aan AI-prompts, op basis van projectfeedback en prestatiemetingen, snel en effectief kunnen worden geïmplementeerd.

Uiteindelijk betekent het gebruik van no-code-tools in AI-promptengineering een verschuiving naar meer inclusieve en efficiënte AI-modelimplementaties. Naarmate meer organisaties no-code-oplossingen omarmen, blijft de methodologie voor het opstellen en herhalen van AI-prompts evolueren, wat de weg vrijmaakt voor veelzijdigere en impactvollere AI-gestuurde toepassingen.

Conclusie: Toekomst van AI Prompt Engineering

Naarmate AI-technologie zich blijft ontwikkelen, zal het gebied van prompt engineering steeds belangrijker worden in het ontwikkelingsproces. Nu AI-modellen geavanceerder worden in het begrijpen en genereren van genuanceerde reacties, zal de rol van prompt engineering zich uitbreiden om ervoor te zorgen dat deze modellen aansluiten bij specifieke gebruikersbehoeften en -doelstellingen.

De toekomst van AI prompt engineering zal waarschijnlijk een meer integratieve benadering zien door inzichten uit verschillende industrieën en disciplines samen te voegen. Dit zal prompt engineers helpen om innovatievere en veelzijdigere prompts te creëren, waardoor AI-modellen traditionele grenzen kunnen overstijgen en veelzijdige toepassingen in verschillende sectoren kunnen verkennen. De voortdurende vooruitgang in AI-modelmogelijkheden zal nauwkeurigere, contextbewuste en genuanceerdere prompts vereisen, waardoor prompt engineering wordt gedwongen om geavanceerdere technieken en tools te gebruiken.

No-code en low-code-platformen zullen een cruciale rol spelen bij het democratiseren van AI-prompt engineering. Deze platforms bieden gebruikers de mogelijkheid om AI-modellen naadloos te integreren met minimale codeerinspanning, waardoor AI-technologie toegankelijker wordt voor een breder publiek. Als gevolg hiervan kunnen meer individuen, inclusief niet-technische gebruikers, deelnemen aan het proces van het maken en testen van AI-prompts, wat innovatie stimuleert en nieuwe mogelijkheden mogelijk maakt.

Bovendien zal de nadruk op continu leren en feedbackloops essentieel zijn bij het verfijnen van prompt engineering-praktijken. Door iteratief testen en optimaliseren te omarmen, kunnen prompt engineers ervoor zorgen dat AI-modellen consistent nauwkeurige en relevante resultaten opleveren. De opname van feedbackmechanismen zal realtime verbeteringen van promptstructuren mogelijk maken, wat aanzienlijk bijdraagt aan het optimaliseren van AI-prestaties.

Naarmate AI-technologie vordert, zal de vraag naar ethische overwegingen en verantwoorde AI-implementatie ongetwijfeld van invloed zijn op prompt engineering. Prompt engineers moeten ervoor zorgen dat de taal en context die in prompts worden gebruikt, aansluiten bij de principes van eerlijkheid, transparantie en verantwoording, en vertrouwen en betrouwbaarheid in AI-systemen bevorderen.

Kortom, de toekomst van AI prompt engineering ziet er rooskleurig uit, met kansen voor groei en innovatie aan de horizon. Door technologische vooruitgang te benutten, no-code-oplossingen te omarmen en ethische overwegingen te prioriteren, zullen prompt engineers goed toegerust zijn om AI-modellen te begeleiden naar het bereiken van hun volledige potentieel, industrieën te transformeren en de manier waarop we omgaan met technologie opnieuw vorm te geven.

FAQ

AI prompt engineering omvat het opstellen van effectieve instructies, of 'prompts', om AI-modellen te begeleiden bij het genereren van gewenste outputs. Dit proces is cruciaal om ervoor te zorgen dat AI-systemen nauwkeurig reageren op specifieke gebruikersbehoeften.

Effectieve prompt engineering verbetert de prestaties van AI-modellen door ervoor te zorgen dat de verstrekte instructies resulteren in de gewenste, precieze en nauwkeurige resultaten.

Belangrijke werkwijzen zijn onder meer het begrijpen van het gedrag van AI-modellen, het duidelijk definiëren van doelstellingen, het herhalen van prompts op basis van feedback en het consistent testen en verfijnen van promptstructuren.

Uitdagingen zijn onder meer het verwerken van dubbelzinnige of vage prompts, het overwinnen van variabiliteit in AI-modelreacties en het afstemmen van prompts op de specifieke mogelijkheden van verschillende AI-modellen.

Feedback helpt bij het identificeren van tekortkomingen in door AI gegenereerde uitvoer, waardoor engineers direct instructies kunnen aanpassen en optimaliseren, wat de algehele nauwkeurigheid van het model verbetert.

Ja, no-code-tools, zoals AppMaster, maken het mogelijk om applicaties te maken die gebruikmaken van AI-modellen, waardoor gebruikers prompts eenvoudig kunnen integreren en testen zonder uitgebreide programmeerkennis.

AI-modellen interpreteren prompts op basis van trainingsgegevens en algoritmen en proberen de bedoelingen van de gebruiker binnen de geboden context te begrijpen om relevante antwoorden te genereren.

Context speelt een cruciale rol in hoe AI prompts interpreteert en outputs genereert. Het bieden van een duidelijke en relevante context vergroot de kans op het behalen van gewenste resultaten van AI-modellen.

Om dubbelzinnigheid tegen te gaan, moeten snelle engineers precieze taal gebruiken, aannames vermijden en voldoende context bieden om het AI-model naar het beoogde resultaat te leiden.

Ja, verschillende platforms bieden omgevingen om AI-prompts te testen en ermee te experimenteren, waardoor prompt-engineers hun prompts kunnen verfijnen en verbeteren voor betere prestaties.

AppMaster vereenvoudigt AI-integratie door ontwikkelaars in staat te stellen datamodellen en bedrijfslogica visueel te ontwerpen, waardoor het eenvoudiger wordt om AI-prompts te testen en te implementeren naast app-ontwikkeling.

De toekomst van AI-promptengineering omvat geavanceerdere technieken voor het maken van prompts, beter begrip van AI en grotere toegankelijkheid via no-code-platformen.