Erweiterte Debugging-Techniken für X86-64-Anwendungen

Dieser Artikel befasst sich eingehend mit anspruchsvollen Debugging-Techniken und untersucht erweiterte Strategien für x86-64-Anwendungen, um Entwicklern bei der Bewältigung komplexer Softwarefehler zu helfen.

Einführung in das erweiterte Debugging

Beim Debuggen handelt es sich um den sorgfältigen Prozess der Identifizierung, Isolierung und Behebung von Problemen innerhalb von Softwareanwendungen. Das erweiterte Debugging geht noch einen Schritt weiter und nutzt hochentwickelte Techniken, um komplexe Softwareprobleme zu lösen, die in großen, komplizierten oder leistungsstarken x86-64-Anwendungen auftreten. Dieses proaktive Eintauchen in das komplexe Netz des Softwareverhaltens ist besonders wichtig, wenn Standard-Debugging-Methoden bei der Diagnose schwer fassbarer Fehler, die unter ganz bestimmten Umständen auftreten oder tief in Interaktionen auf Systemebene verwurzelt sind, nicht ausreichen.

Ein vielseitiges Arsenal an fortschrittlichen Debugging-Strategien ist für Entwickler und Softwareentwickler, die in der x86-64-Architektur verankert sind, von größter Bedeutung. Das bedeutet, über das herkömmliche Debugging in der Druckzeile oder IDE-basierte Tools hinauszugehen und leistungsstarke Dienstprogramme wie Speicheranalyse, automatisierte Debugging-Skripts, Reverse Engineering und mehr zu nutzen. Mit diesen Fähigkeiten können Entwickler nicht nur Fehler beheben, sondern auch tiefere Einblicke in die Funktionsweise ihrer Software gewinnen – Wissen, das sowohl für die sofortige Problemlösung als auch für die langfristige Verbesserung der Softwarequalität von unschätzbarem Wert ist.

Zum fortgeschrittenen Debuggen gehört auch eine Denkweise unermüdlicher Neugier und analytischen Denkens. Debugger müssen durch Code auf Assembly-Ebene navigieren, komplexe Thread-Interaktionen entwirren und Leistungsengpässe mit der Präzision analysieren, die Geduld und Fachwissen erfordert. Während der Weg zur Beherrschung des fortgeschrittenen Debuggings am Rande von Kunst und Wissenschaft schwankt, verspricht es Entwicklern die Möglichkeit, die hartnäckigsten Fehler selbstbewusst anzugehen und die Belastbarkeit und Zuverlässigkeit ihrer Software auf der leistungsstarken x86-64-Plattform zu verbessern.

In den kommenden Abschnitten werden wir uns mit den Einzelheiten dieser fortgeschrittenen Techniken befassen und praktisches Wissen präsentieren, das für den Weg der Entwickler zum Meister des Debuggens kuratiert wurde. Jede besprochene Strategie und jedes besprochene Tool wird für Ihre Toolbox wertvoll sein, Ihre Fähigkeiten erweitern und Ihr Handwerk in der x86-64-Anwendungsentwicklung verbessern.

Verständnis der x86-64-Architektur beim Debuggen

Das Verständnis der Feinheiten der Hardware ist für das Debuggen von Anwendungen von unschätzbarem Wert, insbesondere auf der x86-64-Architektur. Der x86-64, auch bekannt als AMD64 oder Intel 64, ist eine 64-Bit-Version des x86-Befehlssatzes und führt gegenüber seinem 32-Bit-Vorgänger mehrere Verbesserungen ein, die Fehler in Softwareanwendungen aufdecken und verschleiern können.

Erstens ermöglicht die x86-64-Architektur den Zugriff auf einen viel größeren Adressraum, was bedeutet, dass Entwickler mit großen Speichermengen arbeiten können – theoretisch bis zu 16 Exabyte. Während diese Kapazität für große Anwendungen von Vorteil ist, bedeutet sie auch, dass die Zeiger von 32 Bit auf 64 Bit erweitert werden, was möglicherweise zu einer neuen Klasse von Fehlern im Zusammenhang mit der Zeigerarithmetik und der Speicheradressierung führt. Beim Debuggen von Software auf x86-64 muss daher auf Fehler geachtet werden, die sich aus falschen Annahmen zur Speicheradressierung oder dem Missbrauch von Zeigertypen ergeben können.

Die x86-64-Architektur umfasst außerdem zusätzliche Allzweckregister und neue Anweisungen, die die Leistung optimieren und neue Möglichkeiten für Fehler schaffen können. Im Debugging-Kontext ist es wichtig zu verstehen, wie eine Anwendung diese Register während der Ausführung verwendet. Register können kritische Werte enthalten, die bei falscher Verwaltung zu Segmentierungsfehlern und anderen subtileren kritischen Problemen als in 32-Bit-Umgebungen führen können. Ein Debugger, der den Zustand dieser Register klar anzeigen und ihre Nutzung während der Ausführung einer Anwendung verfolgen kann, ist daher unverzichtbar.

Ein weiterer zu berücksichtigender Aspekt ist die Aufrufkonvention, die sich bei x86-64 im Vergleich zu seinen Vorgängern unterscheidet. In x86-64 werden die ersten paar Funktionsargumente nicht wie traditionell in 32-Bit-x86 auf dem Stapel übergeben, sondern in Registern. Es ist wichtig zu wissen, welche Register beim Debuggen überprüft werden müssen, und wenn Sie die Parameter einer Funktion verstehen möchten. Eine Fehlinterpretation der Aufrufkonvention könnte zu falschen Schlussfolgerungen über die Funktionsausführung und die Ursachen von Fehlern führen.

Auch SIMD-Anweisungen (Single Instruction, Multiple Data), die mehrere Datenpunkte mit einer einzigen Anweisung verarbeiten können, werden in der x86-64-Architektur erweitert. Debugger müssen in der Lage sein, den Status der SIMD-Register und die Ergebnisse von SIMD-Anweisungen zu interpretieren, um ein klares Bild davon zu liefern, wie eine Anwendung Daten parallel verarbeitet. Eine falsche Verwendung dieser Anweisungen kann leicht zu Fehlern führen, die zu falschen Ausgaben oder Abstürzen führen.

Angesichts dieser Feinheiten geht es beim x86-64-Debugging oft darum, die subtilen Wechselwirkungen zwischen Hardwarefunktionen und Softwarelogik zu verstehen. In vielen Szenarien können Fehler dadurch entstehen, dass ein Entwickler falsche Annahmen darüber hat, wie sein Code auf der Hardware ausgeführt wird. Tools, die die Ausführung von Code simulieren und sein Verhalten auf dem CPU-Kern vorhersagen können, indem sie den sich ändernden Zustand von Registern und Speicher anzeigen, werden zu wichtigen Bestandteilen des Debugging-Toolkits.

Für Entwickler, die auf der AppMaster- Plattform arbeiten, ist ein Verständnis von x86-64 nicht so wichtig, da die Plattform die zugrunde liegende Architekturkomplexität beherrscht. Dennoch können Entwickler durch fundiertes Wissen in die Lage versetzt werden, die Funktionen der Plattform besser zu nutzen und die durchgeführten Vorgänge bei Bedarf auf einer niedrigeren Ebene zu verstehen.

Einrichten Ihrer Debugging-Umgebung

Der Beginn einer Reise zum Debuggen von x86-64-Anwendungen beginnt mit der Schaffung einer soliden Grundlage: einer leistungsstarken Debugging-Umgebung. Selbst erfahrene Entwickler können sich ohne diese kritische Konfiguration im komplexen Netz von Softwareproblemen verlieren. Die ideale Umgebung stattet Sie nicht nur mit den richtigen Widgets und Gadgets aus, sondern optimiert auch Ihren Prozess und sorgt für Klarheit bei der Diagnose Ihres Codes. So gestalten Sie einen effektiven Debugging-Schmelztiegel für Ihre x86-64-Bemühungen:

Wählen Sie Ihren Debugger

Der Debugger ist der Dreh- und Angelpunkt Ihres Debugging-Toolkits. Für x86-64-Anwendungen werden aufgrund ihres umfangreichen Funktionsumfangs und ihrer Flexibilität häufig beliebte Debugger wie GDB (GNU Debugger) verwendet. Andere entscheiden sich möglicherweise für LLDB , Teil des LLVM-Projekts, das für sein modernes Design und die Integration mit Tools wie dem Clang Compiler bekannt ist. Stellen Sie bei der Auswahl eines Debuggers sicher, dass er alle Facetten der x86-64-Architektur unterstützt, von SSE-Vektoranweisungen bis hin zur Hardware-Ausnahmebehandlung.

Integration mit einer IDE

Eine integrierte Entwicklungsumgebung (Integrated Development Environment, IDE) kann den Debugging-Prozess vereinfachen, indem Codebearbeitung, Erstellung und Debugging in einer Schnittstelle kombiniert werden. Für einige sind Visual Studio oder JetBrains Rider mit ihrer Intelligenz und intuitiven Benutzeroberfläche die erste Wahl. Sie bieten eine nahtlose Debugger-Integration und bieten einen visuellen Ansatz zum Setzen von Haltepunkten, zum schrittweisen Durchlaufen des Codes und zum Überprüfen von Variablen.

Die Konsole umarmen

Für die Seele der alten Schule, die einen praktischen Ansatz bevorzugt, vermittelt die Beherrschung von Konsolenbefehlen in Debuggern wie GDB ein tieferes Verständnis der Programmausführung und kann in komplexen Szenarien flexibler sein. Ein Konsolen-Setup profitiert erheblich von benutzerdefinierten Skripten und Aliasen, um häufige Aufgaben und Überprüfungen zu automatisieren.

Überwachungssysteme und Protokolle

Ein scharfes Auge auf Ereignisse auf Systemebene kann Probleme aufdecken, die außerhalb der direkten Reichweite des Debuggers liegen. Daher sind die Integration von Systemüberwachungstools und der Zugriff auf Protokolle von entscheidender Bedeutung. dmesg , journalctl oder plattformspezifische Überwachungsdienstprogramme können Einblicke in Ereignisse auf Kernelebene liefern, die sich möglicherweise auf das Verhalten Ihrer Anwendung auswirken.

Vorbereitung auf Profiling und Leistungsanalyse

Bei Problemen in x86-64-Anwendungen geht es nicht immer um Abstürze oder falsches Verhalten. Leistungsengpässe können ebenso kritisch sein, insbesondere bei Anwendungen, die rechenintensive Aufgaben ausführen. Integrieren Sie daher Leistungsprofilierungstools wie perf , Valgrind oder Intel VTune Profiler in Ihre Debugging-Suite, um Effizienzprobleme zu erkennen und zu beheben.

Betonung der Bedeutung der Versionskontrolle

Mit jedem neuen Commit können sich Fehler einschleichen, und ein Versionskontrollsystem ist unerlässlich, um Änderungen zu verfolgen und sie mit neuen Problemen zu korrelieren. Dienste wie git können mit Debugging-Tools zusammenarbeiten, um festzustellen, wann und wo Fehler aufgetreten sind.

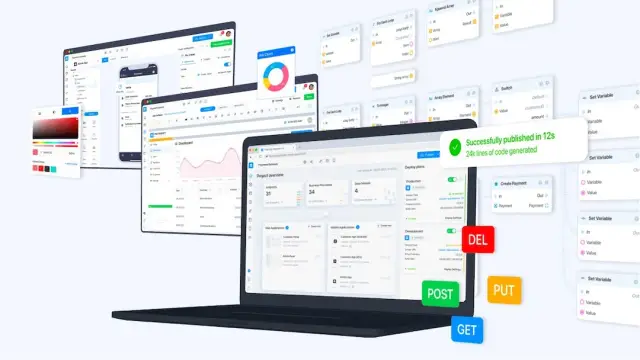

Die Rolle von No-code Plattformen

Inmitten des Labyrinths des Code-Debuggings können No-Code- Lösungen wie AppMaster eine Oase der Einfachheit bieten. Mit seiner visuellen Darstellung von Datenflüssen und Geschäftslogik kann AppMaster den Bedarf an detailliertem Code-Debugging verringern und in bestimmten Szenarien das Auftreten von Fehlern in der Anfangsphase der Entwicklung verhindern.

Entwickler können die Verstrickungen beim Debuggen von x86-64-Anwendungen mithilfe einer speziell entwickelten Debugging-Umgebung geschickt bewältigen. Die oben genannten Tools und Praktiken sind nur ein Ausgangspunkt, und die Weisheit liegt darin, diese Umgebung kontinuierlich zu verbessern und zu personalisieren, um den Anforderungen Ihrer Projekte und den Nuancen der x86-64-Architektur bestmöglich zu entsprechen.

Breakpoints und Watchpoints intelligent nutzen

Das Debuggen komplexer x86-64-Anwendungen erfordert ein gründliches Verständnis des Codes und eine intuitive Beherrschung der Ihnen zur Verfügung stehenden Debugging-Tools. Unter diesen ragen Haltepunkte und Watchpoints als einige der wirksamsten Funktionen moderner Debugger heraus. Sie ermöglichen es Ihnen, die Programmausführung unter bestimmten Bedingungen anzuhalten und den Status der Anwendung und die Werte von Variablen in Echtzeit zu untersuchen.

Haltepunkte werden traditionell an bestimmten Codezeilen oder Adressen in der ausführbaren Datei platziert, an denen Entwickler Fehler vermuten oder eine Überprüfung erfordern. Bei einer erweiterten Nutzung geht es jedoch um mehr als nur das Anhalten der Ausführung. Bedingte Haltepunkte stellen einen Schritt nach oben dar, da sie die Anwendung nur dann anhalten, wenn bestimmte Bedingungen erfüllt sind, wodurch der Zeitaufwand für das Durchsuchen irrelevanter Daten minimiert wird. Wenn Sie beispielsweise einen bedingten Haltepunkt festlegen, der aktiviert wird, wenn eine Variable einen bestimmten Wert erreicht, können Sie den genauen Zeitpunkt bestimmen, zu dem ein anomales Verhalten auftritt. Dies ist äußerst hilfreich bei der Identifizierung von Grenzfällen, die zu Abstürzen oder logischen Fehlern führen.

Eine weitere fortschrittliche Technik besteht darin, Haltepunkte zu verwenden, die Aktionen wie das Protokollieren von Daten in einer Konsole oder Datei ausführen, ohne die Anwendung anzuhalten. Diese Technik kann Informationen über mehrere Ausführungen eines Programms oder während langfristiger Ausführungsszenarien sammeln. Es ist besonders nützlich, um Probleme zu identifizieren und zu lösen, die sich im Laufe der Zeit oder bei bestimmten Nutzungsmustern manifestieren und in einer herkömmlichen Debugging-Sitzung nicht einfach reproduziert werden können.

Watchpoints, auch Daten-Breakpoints genannt, sind eine weitere leistungsstarke Funktion zum Debuggen von x86-64-Anwendungen. Sie können den Entwickler benachrichtigen, wenn sich der Inhalt eines bestimmten Speicherorts ändert. Dies ist wichtig, um genau den Moment zu erfassen, in dem einer Variablen ein falscher Wert zugewiesen wird. Watchpoints können der Schlüssel zur Lösung des Rätsels sein, wenn Sie eine Heap-Beschädigung oder ein ähnliches Speicherproblem untersuchen. Wenn Sie mit großen, leistungsempfindlichen Anwendungen arbeiten, ist es wichtig, dass einige Debugger das Programm bei Verwendung von Watchpoints möglicherweise erheblich verlangsamen, hardwareunterstützte Watchpoints jedoch dieselbe Aufgabe mit viel weniger Overhead ausführen können.

Um das volle Potenzial von Breakpoints und Watchpoints auszuschöpfen, ist ein strategischer Ansatz unerlässlich. Integrieren Sie sie in den Debugging-Prozess, indem Sie die richtigen Momente und Bedingungen für die Aktivierung wählen, die oft die tieferen Probleme aufdecken können, die die Anwendung betreffen. Mit Intuition, Erfahrung und diesen fortschrittlichen Debugging-Techniken können Sie die schwer fassbaren und komplexesten Fehler beheben, die in x86-64-Anwendungen auftreten können.

Eintauchen in Disassembler und Decompiler

Wenn es um erweitertes Debugging geht, insbesondere für x86-64-Anwendungen, sind Disassembler und Dekompiler zwei der mächtigsten Verbündeten eines Entwicklers. Diese Tools sind für die Untersuchung der ausführbaren Binärdateien unerlässlich, wenn das Debuggen des Quellcodes nicht ausreicht oder wenn es um optimierten oder verschleierten Code geht, der sich unvorhersehbar verhält.

Ein Disassembler ist ein Tool, das Maschinencode – die rohen Binäranweisungen, die die CPU ausführt – zurück in Assembler übersetzt. Dieser Prozess ermöglicht es Entwicklern, eine Textdarstellung der Anweisungen zu sehen, die ihr Programm ausführt. Dies ist von entscheidender Bedeutung, wenn sie versuchen, untergeordnete Probleme wie Speicherbeschädigung, unerwartete Ausführung von CPU-Anweisungen oder die Ausnutzung von Sicherheitslücken zu verstehen.

Mithilfe eines Disassemblers können Entwickler:

- Verfolgen Sie den Ausführungspfad einer Anwendung detailliert.

- Untersuchen Sie die Interaktion zwischen verschiedenen Codeteilen und verstehen Sie, wie Konstrukte auf hoher Ebene in Anweisungen auf niedrigerer Ebene übersetzt werden.

- Identifizieren Sie Bereiche, in denen der Compiler möglicherweise Optimierungen eingeführt hat, die zu Fehlern führen könnten.

Dekompilierer gehen noch einen Schritt weiter, indem sie versuchen, den Kompilierungsprozess umzukehren und Maschinencode wieder in einen Code einer höheren Ebene wie C oder C++ umzuwandeln. Es handelt sich nicht immer um einen perfekten Prozess, und der resultierende Code ist möglicherweise nicht so lesbar oder wartbar wie die Originalquelle. Dennoch bietet es unschätzbare Einblicke in die Funktionsweise der Anwendung auf konzeptioneller Ebene.

Ein Dekompiler ermöglicht Entwicklern Folgendes:

- Verstehen Sie den Ablauf komplexer Algorithmen, für die der ursprüngliche Quellcode nicht mehr existiert.

- Analysieren Sie Bibliotheken oder Komponenten von Drittanbietern, deren Quelle nicht verfügbar ist.

- Stellen Sie verlorenen Quellcode wieder her, um ältere Anwendungen zu patchen und zu aktualisieren.

- Erkennen Sie, ob die Binärdatei manipuliert wurde oder versteckten Schadcode enthält.

Bei der Verwendung von Disassemblern und Dekompilern ist es wichtig, mehrere Faktoren zu berücksichtigen, um sie optimal zu nutzen:

- Auswahl der richtigen Tools: Nicht alle Disassembler und Dekompiler unterstützen alle Funktionen oder funktionieren gut mit dem vielfältigen Ökosystem an Entwicklungstools. Identifizieren Sie diejenigen, die sich effektiv in Ihren vorhandenen Debugger und andere Entwicklungsplattformen integrieren lassen.

- Verstehen der Assemblersprache: Um einen Disassembler effektiv nutzen zu können, müssen Sie die Assemblersprache für die x86-64-Architektur verstehen. Dies erfordert möglicherweise zusätzliches Lernen, zahlt sich jedoch aus, wenn es darum geht, tiefsitzende Fehler zu diagnostizieren.

- Rechtliche und ethische Aspekte: Stellen Sie sicher, dass Sie gesetzlich dazu berechtigt sind, die betreffende Binärdatei zurückzuentwickeln. Das Dekompilieren proprietärer Software ohne Genehmigung könnte rechtliche Risiken bergen.

- Patientenanalyse: Das Durchsuchen von Assemblercode oder dekompilierter Ausgabe, um die Grundursache eines Fehlers zu finden, ist eine Fähigkeit, deren Entwicklung Zeit erfordert. Geduld und ein methodisches Vorgehen sind der Schlüssel.

- Kombination mit anderen Techniken: Verwenden Sie Disassembler und Dekompiler in Verbindung mit anderen Debugging-Techniken wie Protokollierung und Profilerstellung, um ein vollständigeres Bild des Problems zu erhalten.

Wenn Sie mit einer no-code Plattform wie AppMaster arbeiten, müssen Sie normalerweise nicht mit Disassemblern oder Dekompilern interagieren, da die Plattform die Codegenerierung und -ausführung für Sie verwaltet. Dennoch kann es hilfreich sein, die Funktionsweise dieser Tools zu verstehen, um komplexere Probleme zu beheben, selbst in einer no-code -Umgebung oder bei der Integration der no-code Plattform in andere bestehende Systeme.

Egal, ob Sie Legacy-Systeme warten, Abstürze in optimierten Builds analysieren oder einfach nur Ihre Neugier auf das Innenleben Ihrer Binärdateien befriedigen, Disassembler und Dekompiler sind unverzichtbare Werkzeuge im Toolkit des erweiterten Debuggers.

Verwenden der Speicheranalyse zur Erkennung von Fehlern

Die Speicheranalyse ist eine wichtige Komponente des Debugging-Toolkits, insbesondere für komplexe Anwendungen, die auf der x86-64-Architektur ausgeführt werden. Anspruchsvolle Anwendungen beschäftigen sich oft mit großen Datensätzen, dynamischer Zuordnung und gleichzeitigen Ausführungsthreads und schaffen so viel Raum für subtile und schwer zu verfolgende Speicherprobleme. Hier erfahren Sie, wie die Speicheranalyse effektiv genutzt werden kann, um diese schwer fassbaren Fehler zu erkennen und zu beheben.

Verständnis des Speicherlayouts in x86-64-Anwendungen

Bevor Sie sich mit Speicheranalysetechniken befassen, ist es wichtig zu verstehen, wie Speicher von x86-64-Anwendungen strukturiert und genutzt wird. Die x86-64-Architektur unterstützt einen virtuellen 64-Bit-Adressraum, der es Anwendungen ermöglicht, eine große Menge an Speicher zu nutzen. Mit diesem riesigen Speicherplatz geht jedoch auch die Komplexität einer effektiven Verwaltung einher – Probleme wie Pufferüberläufe, baumelnde Zeiger, Speicherlecks und andere Arten von Korruption können weitaus heimtückischer sein und weitreichendere Auswirkungen haben als in eingeschränkteren Umgebungen.

Tools zur Speicheranalyse

Zur Analyse der Speichernutzung stehen einem Entwickler mehrere Tools zur Verfügung:

- Valgrind: Ein Instrumentierungs-Framework, das bei der Erkennung von Speicherverwaltungs- und Threading-Fehlern hilft.

- GDB: Der GNU Debugger kann mit verschiedenen Befehlen verwendet werden, um den Heap und den Stack zu untersuchen und auf Speicheränderungen zu achten.

- AddressSanitizer: Ein schneller Speicherfehlerdetektor, der Out-of-Bounds-Zugriffe und Use-After-Free-Bugs erkennen kann.

Jedes Tool kann eingesetzt werden, um bestimmte Arten von Speicherproblemen zu identifizieren. Valgrind eignet sich beispielsweise hervorragend zum Erkennen von Lecks und undefinierter Speichernutzung, während AddressSanitizer Pufferüberläufe und ähnliche Zugriffsfehler schnell lokalisieren kann.

Praktische Strategien zur Gedächtnisanalyse

Berücksichtigen Sie bei der Verwendung von Speicheranalysetools die folgenden Strategien:

- Nutzen Sie automatisierte Tests mit in den Entwicklungszyklus integrierten Speicheranalysetools, um Fehler frühzeitig zu erkennen.

- Führen Sie eine Laufzeitanalyse unter realistischen Arbeitslasten durch, um das Speicherverhalten bei typischer Anwendungsnutzung zu beobachten.

- Integrieren Sie statische Analysetools, um potenzielle Fehler vor der Laufzeit zu erkennen.

- Analysieren Sie Speicherzuordnungsmuster auf ungewöhnliche Aktivitäten, die auf Lecks oder andere Anomalien hinweisen können.

- Verwenden Sie benutzerdefinierte Skripte, um die Erkennung zu automatisieren und sich auf die relevantesten Speicherbereiche zu konzentrieren.

Als ehemaliger Softwareentwickler kann ich bestätigen, wie wichtig es ist, den Speicher regelmäßig zu analysieren – insbesondere in Umgebungen mit mehreren Threads, in denen das Zusammenspiel zwischen Threads zu komplexen Synchronisierungsproblemen und Rennbedingungen führen kann.

Rolle von No-Code Plattformen

No-code Plattformen wie AppMaster beheben auch einige Aspekte speicherbezogener Fehler, indem sie die zugrunde liegende Speicherverwaltung bis zu einem gewissen Grad abstrahieren. Sie bieten eine Ebene der Fehlerprüfung und automatisierten Tests, mit denen einige Standardspeicherprobleme präventiv behoben werden können. Dennoch bleibt die direkte Speicheranalyse eine wesentliche Fähigkeit im Arsenal eines Entwicklers für Low-Level-Debugging und Leistungsoptimierung.

Denken Sie daran, dass die Speicheranalyse keine einmalige Aktivität ist, sondern ein kontinuierlicher Prozess über den gesamten Lebenszyklus der Anwendung hinweg. Durch die regelmäßige Integration dieser Techniken wird sichergestellt, dass Anwendungen leistungsstark, zuverlässig und sicher bleiben und der großzügige, aber komplexe Speicherraum, den die x86-64-Architektur bietet, effektiv verwaltet wird.

Profilerstellung für Anwendungen bei Leistungsengpässen

Die Erstellung von Leistungsprofilen ist ein entscheidender Schritt bei der Optimierung von x86-64-Anwendungen, da sie dabei hilft, Teile der Software zu identifizieren, die möglicherweise nicht so effizient wie möglich funktionieren. Die Profilerstellung geht Hand in Hand mit dem Debuggen, da sie nicht nur Ineffizienzen, sondern auch latente Fehler aufdecken kann, die zu diesen Leistungsproblemen beitragen.

Um mit der Profilerstellung zu beginnen, müssen Entwickler zunächst die geeigneten Tools auswählen. Es stehen verschiedene Profilierungstools zur Verfügung, die speziell für x86-64-Anwendungen entwickelt wurden, wie z. B. gprof , die Tool-Suite von Valgrind und Intels VTune Amplifier. Jedes dieser Tools hat seine eigenen Stärken und Anwendungsbereiche, von allgemeinen Übersichten über die Ausführungszeit aller Funktionen bis hin zu detaillierten Analysen von Cache-Hits und -Misses.

Sobald ein Tool ausgewählt ist, besteht der nächste Schritt darin, die Anwendung im Profilerstellungsmodus auszuführen. Während dieser Phase sammelt der Profiler Daten zu verschiedenen Aspekten der Anwendungsleistung, wie z. B. verbrauchte CPU-Zyklen, Speicherzugriffsmuster und durchgeführte Systemaufrufe. Einige Profiler bieten die Möglichkeit, die Ausführung der Anwendung in Echtzeit zu verfolgen und so sofortiges Feedback zu den Auswirkungen aller von Ihnen vorgenommenen Änderungen zu geben.

Ein entscheidender Aspekt der Profilerstellung ist die Identifizierung von Hotspots, den Codeabschnitten, die die meisten Ressourcen verbrauchen. Hotspots sind oft das Ergebnis ineffizienter Algorithmen, unnötiger Datenverarbeitung oder schlechter Speicherverwaltung. Durch die Neuausrichtung der Optimierungsbemühungen auf diese Hotspots können Entwickler mit weniger Aufwand erhebliche Leistungsverbesserungen erzielen.

Entwickler können für eine detailliertere Analyse in die Aufrufdiagramme des Profilers eintauchen, um die Beziehungen und Abhängigkeiten zwischen verschiedenen Funktionen und Modulen zu verstehen. Diese Aufrufdiagramme helfen dabei, indirekte Quellen von Leistungsproblemen zu identifizieren, bei denen die Lösung das Refactoring oder die Neugestaltung bestimmter Teile des Codes umfassen kann.

Eine der größten Herausforderungen beim Profiling ist der Umgang mit der riesigen Menge an generierten Daten. Effektives Profiling erfordert einen methodischen Ansatz, der oft mit einem umfassenden Überblick beginnt und schrittweise auf bestimmte Bereiche eingeht. Darüber hinaus ist die Korrelation von Profiling-Daten mit dem Quellcode unerlässlich, um sinnvolle Verbesserungen zu erzielen. Moderne Profiler lassen sich in IDEs integrieren, um die direkte Navigation von Profilerstellungsausgaben zu den entsprechenden Codezeilen zu erleichtern.

Nach der Identifizierung von Leistungsengpässen können Entwickler verschiedene Maßnahmen ergreifen, wie z. B. die Optimierung von Algorithmen, die Verbesserung von Datenstrukturen, die Reduzierung von E/A-Vorgängen oder die Nutzung paralleler Programmiertechniken. In Multithread-Anwendungen kann die Profilerstellung auch dabei helfen, Synchronisierungsprobleme zu erkennen und zu beheben, die zu Deadlocks oder Race Conditions führen.

Im Kontext von no-code Plattformen wie AppMaster gelten weiterhin die allgemeinen Profiling-Grundsätze. AppMaster bietet eine visuelle Ebene, die den zugrunde liegenden Code abstrahiert. Dies kann dabei hilfreich sein, Bereiche zu identifizieren, in denen die Leistung verbessert werden könnte – insbesondere beim Umgang mit Web- und Mobilanwendungen, die komplexe Interaktionen wie API-Aufrufe oder Datenbankabfragen beinhalten können.

Schließlich sollte die Profilerstellung kein einmaliges Ereignis sein, sondern Teil eines laufenden Wartungsprozesses. Wenn sich Anwendungen und ihre Arbeitslasten weiterentwickeln, können neue Engpässe auftreten, die eine weitere Profilerstellungssitzung erfordern. Kontinuierliche Profilerstellung und Optimierung werden in einer skalierten Umgebung, in der die Leistung direkt mit der Benutzererfahrung und den Betriebskosten korreliert, noch wichtiger.

Profiling ist eine Kunst, die technische Fähigkeiten und einen strategischen Ansatz erfordert, um das komplexe Geflecht der Softwareleistung zu entwirren. Mit dem richtigen Toolkit und einer fundierten Methodik kann die Profilerstellung eine träge Anwendung in eine Anwendung verwandeln, die schnell auf Benutzerinteraktionen reagiert und effizient arbeitet.

Implementieren des automatisierten Debuggens mit Skripten

Durch die Automatisierung von Teilen des Debugging-Prozesses kann die Zeit, die Entwickler für die Suche und Behebung von Problemen aufwenden, drastisch reduziert werden, insbesondere bei komplexen x86-64-Anwendungen. Debugging-Skripte können automatisch eine Reihe von Befehlen ausführen, Ausgaben analysieren und Routineprüfungen durchführen, sodass Sie sich auf komplexere Probleme konzentrieren können. Lassen Sie uns untersuchen, wie Sie automatisiertes Debugging mit Skripts implementieren und diese Technik in Ihren Workflow integrieren können.

Überlegen Sie zunächst, welche sich wiederholenden Aufgaben Sie während der Debugging-Sitzungen ausführen: Haltepunkte setzen, Code schrittweise durchgehen, Variablen überprüfen usw. Hierbei kann es sich häufig um skriptfähige Aktionen handeln. Angenommen, Sie überprüfen häufig bestimmte Bedingungen oder Variablen an bestimmten Stellen im Code. In diesem Fall kann ein Skript verwendet werden, um die Ausführung automatisch zu unterbrechen und die relevanten Informationen zu protokollieren, damit Sie sie später überprüfen können.

Erstellen benutzerdefinierter Skripte zum Debuggen

Das Erstellen eines benutzerdefinierten Debugging-Skripts beginnt mit der Definition des Umfangs Ihres Ziels. Denken Sie über die häufigsten Fehler nach, die auftreten, und darüber, wie Sie sie im Allgemeinen erkennen. Die meisten Debugging-Tools, die x86-64-Anwendungen unterstützen (wie GDB oder WinDbg), verfügen über Skriptfunktionen und nutzen Python , Lua oder ihre proprietären Skriptsprachen. Sie können Skripte schreiben für:

- Bedingte Haltepunkte festlegen: Lösen Sie Haltepunkte nur aus, wenn bestimmte Bedingungen erfüllt sind, sodass Sie nicht unzählige Iterationen manuell durchlaufen müssen.

- Variablenzustände protokollieren: Automatisieren Sie die Protokollierung von Variablenzuständen an bestimmten Punkten der Ausführung für eine spätere Analyse.

- Speicherauszüge analysieren: Verarbeiten Sie Speicherauszüge automatisch, um nach Anzeichen von Beschädigung oder Speicherlecks zu suchen.

- Ausgabe validieren: Überprüfen Sie, ob die Ausgabe der Anwendung den erwarteten Benchmarks entspricht oder Fehler enthält.

- Regressionstests: Stellen Sie sicher, dass die jüngsten Änderungen die vorhandene Funktionalität nicht beeinträchtigt haben.

Durch die Erstellung von Skripts für diese Aktionen können Sie sie als Batch-Prozess ausführen, sie in großem Maßstab ausführen oder sie sogar so planen, dass sie zu bestimmten Zeiten ausgeführt werden.

Skripterstellung für Continuous Integration (CI)

Im Zeitalter der kontinuierlichen Integration und Bereitstellung spielen Debugging-Skripte eine wichtige Rolle in der automatisierten Pipeline. Sie können so eingestellt werden, dass sie nach jedem Commit oder Build ausgeführt werden, um Regressionen oder neue Fehler zu erkennen, sobald sie auftreten. Diese Skripte können in CI-Tools wie Jenkins, CircleCI oder GitHub Actions integriert werden, die dann Entwickler sofort benachrichtigen können, wenn ein Problem erkannt wird.

Automatisierte Analyse und Berichterstattung

Ihre Skripte sollten nicht nur Aktionen ausführen; Sie sollten auch Einblick geben. Durch die Ausgabe formatierter Protokolle, die Erstellung von Fehlerberichten oder sogar visuelle Diagramme von Leistungsmetriken können Rohdaten in umsetzbares Wissen umgewandelt werden. Ziehen Sie Tools in Betracht, die Protokolldateien verarbeiten und allgemeine Zusammenfassungen des Zustands oder der Leistung der Anwendung im Laufe der Zeit präsentieren.

Integration mit No-code Plattformen

No-code Lösungen wie AppMaster erfreuen sich aufgrund ihrer Fähigkeit, Arbeitsabläufe zu automatisieren und zu optimieren, immer größerer Beliebtheit. Obwohl sie für die Anwendungsentwicklung konzipiert sind, können ihre Prinzipien auf das Debuggen ausgedehnt werden, indem mithilfe visueller Programmierung definiert wird, wie automatisierte Skripte funktionieren sollen. Sie könnten beispielsweise ein System einrichten, bei dem Trigger in einer no-code Plattform Debugging-Skripte ausführen und die Ergebnisse verarbeiten, wodurch der Überwachungsprozess vereinfacht wird.

Für die Bereitstellung von Skripten muss man wissen, wann und wie sie verwendet werden sollen. Übermäßiges Vertrauen in die Automatisierung kann zu einem falschen Sicherheitsgefühl führen, und nicht jede Situation kann per Skript gesteuert werden. Erfahrene Entwickler wissen, wie man automatisierte Skripte mit praktischem Debugging in Einklang bringt, um die einzigartigen Herausforderungen ihrer x86-64-Anwendungen zu bewältigen.

Best Practices für die Skripterstellung

Bei der Implementierung des automatisierten Debuggings mit Skripten ist es wichtig, die Best Practices einzuhalten:

- Halten Sie Skripte modular: Schreiben Sie kleine Skripte, die eine Aufgabe gut ausführen. Dieser Ansatz verbessert die Wartbarkeit und ermöglicht die Kombination in komplexen Arbeitsabläufen.

- Versionskontrolle Ihrer Skripte: Behandeln Sie Ihre Debugging-Skripte als Teil Ihrer Codebasis und halten Sie sie unter Versionskontrolle, um Änderungen zu verfolgen und mit Ihrem Team zusammenzuarbeiten.

- Behandeln Sie Ausnahmen und falsche Zustände: Stellen Sie sicher, dass Ihre Skripte leistungsstark genug sind, um unerwartete Ergebnisse oder Zustände zu verarbeiten, ohne abzustürzen oder irreführende Informationen bereitzustellen.

- Dokumentieren Sie Ihre Skripte: Stellen Sie sicher, dass andere Entwickler Ihre Skripte verstehen und verwenden können, indem Sie eine gründliche Dokumentation bereitstellen und den Code kommentieren.

Die Implementierung des automatisierten Debuggings in x86-64-Anwendungen spart nicht nur Zeit, sondern verleiht einem ansonsten manuellen Prozess auch ein höheres Maß an Präzision und Wiederholbarkeit. Indem Sie Skripte nutzen, sie in CI/CD-Pipelines integrieren und Ihre Debugging-Bemühungen mit hochentwickelten Toolsets wie AppMaster unterstützen, sind Sie in der Lage, Fehler effizienter und effektiver als je zuvor zu beheben.

Reverse Engineering für Debugging-Zwecke

Reverse Engineering ist eine leistungsstarke Technik, die häufig mit dem Verständnis proprietärer Systeme oder der Verbesserung von Sicherheitsprotokollen verbunden ist. Es ist auch ein äußerst wertvolles Tool für Entwickler beim Debuggen komplexer x86-64-Anwendungen. Durch die Zerlegung von Software in ihre Bestandteile ermöglicht Reverse Engineering Entwicklern, Einblicke in das Verhalten und die Struktur einer Anwendung unter der Haube zu gewinnen.

Reverse Engineering kann besonders effektiv sein, wenn der Quellcode nicht zugänglich ist oder wenn es um Altsysteme geht. In diesen Fällen werden Tools wie Disassembler verwendet, um Binärcode in eine besser lesbare Form – Assembler – umzuwandeln. Im Kontext der x86-64-Architektur liefert dieser übersetzte Code Hinweise auf Anwendungslogik, Speichernutzung und sogar potenzielle Sicherheitslücken.

Für Entwickler, die mit der x86-64-Architektur arbeiten, ist das Verständnis der Assemblierung von entscheidender Bedeutung, da sie sich direkt auf die Art und Weise auswirkt, wie der Prozessor Anweisungen ausführt. Dieses Bewusstsein ermöglicht es ihnen, problematische Codesequenzen zu lokalisieren und unerwartete Verhaltensweisen auf eine Weise zu begründen, die mit High-Level-Debugging allein nicht möglich ist. Darüber hinaus kann Reverse Engineering in Kombination mit dynamischen Analysetools wie Debuggern Laufzeitprobleme wie Race Conditions und Deadlocks aufdecken, die den ordnungsgemäßen Ablauf einer Multithread-Anwendung stören.

Ein weiterer Aspekt ist die Verwendung von Dekompilern, die versuchen, die Low-Level-Assembly zurück in eine höhere Sprache zu übersetzen. Obwohl dekompilierter Code möglicherweise nicht immer perfekt ist, bietet er Entwicklern eine Plattform, um Hypothesen über die mögliche Ursache eines Fehlers aufzustellen und ihre Annahmen durch weiteres gezieltes Debuggen zu validieren.

Darüber hinaus ist Reverse Engineering im Sicherheitskontext unverzichtbar. Entwickler können den Ansatz eines Hackers simulieren, um Schwachstellen innerhalb der Anwendung aufzudecken, etwa Pufferüberläufe oder unsachgemäße Verschlüsselung. Dieser Präventivschlag kann beim Debuggen Zeit sparen und die Sicherheit und Integrität der Anwendung verbessern.

Die Einbeziehung von Reverse Engineering in das Debugging-Arsenal vertieft das Verständnis eines Entwicklers sowohl für die Anwendung als auch für die Architektur, auf der sie ausgeführt wird. Als Ergänzung zu herkömmlichen Debugging-Techniken kann es oft der Schlüssel zum Aufdecken schwer fassbarer Fehler sein, die Standardmethoden möglicherweise übersehen.

Sogar Plattformen wie AppMaster mit ihrem no-code Fokus erkennen die Komplexität hinter der Anwendungsentwicklung an. Ihr Ziel ist es, diese Komplexität zu vereinfachen, indem sie abstrahiert wird. Für diejenigen, die sich mit den Interna von x86-64-Anwendungen befassen, bleibt Reverse Engineering jedoch eine unschätzbare Fähigkeit, diese tiefsitzenden Probleme zu lokalisieren und zu beheben.

Integrieren Sie erweiterte Tools in Ihren Workflow

Eine effektive Debugging-Strategie integriert fortschrittliche Tools, die Fehler aufspüren und die Produktivität und Codequalität verbessern. Da Anwendungen immer komplexer werden, insbesondere auf der x86-64-Architektur, benötigen Entwickler ein ausgefeiltes Toolkit, um die komplizierten Debugging-Aufgaben zu bewältigen, die auf sie zukommen. Durch die Einbettung dieser fortschrittlichen Tools in ihren täglichen Arbeitsablauf können Entwickler einen Debugging-Prozess erstellen, der gezielt auf bestimmte Probleme abzielt.

Ein solches Tool, das oft unverzichtbar wird, ist eine leistungsstarke integrierte Entwicklungsumgebung (IDE), die die x86-64-Architektur unterstützt. Heutzutage verfügen IDEs häufig über integrierte Debugging-Funktionen, die nahtlose Übergänge zwischen dem Schreiben, Testen und Debuggen von Code ermöglichen. Funktionen wie intelligente Code-Vervollständigung, Code-Navigation und automatisiertes Refactoring können den Zeitaufwand für die Fehlerbehebung erheblich reduzieren.

Der Einsatz von Speicherprofilern wie Valgrind kann bei speicherbezogenen Problemen, die oft schwer zu verfolgen sind, eine entscheidende Rolle spielen. Solche Profiler erkennen Speicherlecks, Pufferüberläufe und andere Speicherfehler bei der Speicherverwaltung, die möglicherweise keine unmittelbaren Symptome hervorrufen, aber später zu erheblichen Problemen führen können.

Eine weitere Ebene fortschrittlicher Tools sind statische Analysetools, die Code untersuchen, ohne ihn auszuführen. Diese Tools können potenzielle Fehler und Schwachstellen frühzeitig erkennen, indem sie Codierungsstandards durchsetzen und Anti-Patterns identifizieren. Statische Analysatoren können automatisch als Teil eines Continuous Integration (CI)-Workflows ausgeführt werden und stellen so sicher, dass Fehler erkannt werden, bevor sie in die Produktion gelangen.

Symbolische Debugger wie GDB (GNU Debugger) bieten einen Einblick in die Programmausführung auf der untersten Ebene. Zur erweiterten Verwendung von GDB gehört das Setzen bedingter Haltepunkte, das Untersuchen des Aufrufstapels, das Überwachen von Variablen und sogar das Ändern des Ausführungsstatus, was besonders beim Debuggen komplexer x86-64-Softwareprobleme von Vorteil sein kann.

Beim Debuggen von Anwendungen, die mit Hardware verbunden sind, oder wenn die Simulation bestimmter Bedingungen erforderlich ist, kommen Hardware-Emulatoren oder Simulatoren ins Spiel. Diese Tools bieten eine kontrollierte Umgebung, in der die x86-64-Anwendung ausgeführt werden kann und verschiedene Hardwareszenarien ohne tatsächliche physische Hardware getestet werden können.

Für Entwickler, die mit kompilierten Binärdateien arbeiten, sind Reverse-Engineering-Tools und Disassembler wie IDA Pro oder Ghidra unerlässlich. Sie ermöglichen Ihnen das Entpacken der Anwendung auf Binärebene und bieten Einblicke in das Innenleben von Programmen, wenn der Quellcode nicht verfügbar ist oder wenn Sie mit verschleiertem Code oder Code von Drittanbietern arbeiten.

Im Kontext von no-code Plattformen wie AppMaster kann die Fähigkeit, Probleme zu verstehen und zu lösen, durch visuelle Debugging-Tools integriert werden, die den Fluss von Ausführungen und Daten innerhalb der App anzeigen. Diese Plattformen können automatisch Details auf niedrigerer Ebene verarbeiten und bieten dennoch bei Bedarf Optionen für die Protokollierung oder das Debuggen, wodurch der Debugging-Prozess für Designer und Entwickler zugänglicher wird, die möglicherweise nicht so gut mit x86-64-spezifischen Details vertraut sind.

Zum erweiterten Debugging gehören auch spezielle Netzwerk- und API-Debugging-Tools wie Wireshark für die Analyse des Netzwerkverkehrs und Postman zum Testen von API- endpoints. Sie können Fehler aufspüren, die sich bei Client-Server-Interaktionen manifestieren, und können bei herkömmlichen Debugging-Sitzungen besonders schwer zu erkennen sein.

Der Schlüssel zur erfolgreichen Integration fortschrittlicher Tools liegt in ihrer nahtlosen Einbindung in den Arbeitsablauf des Entwicklers. Dies erfordert ein angemessenes Verständnis der Tools und eine Kultur, die das ständige Lernen und den Austausch von Best Practices fördert. Durch die regelmäßige Überprüfung und Aktualisierung des Toolsets auf die neuesten Versionen wird sichergestellt, dass Entwickler kontinuierlich die von diesen Tools bereitgestellten hochmodernen Funktionen nutzen.

Das Ziel der Integration fortschrittlicher Debugging-Tools in den Workflow besteht nicht nur darin, aktuelle Fehler zu beheben, sondern auch das Auftreten zukünftiger Probleme zu verhindern. Durch die durchdachte Integration dieser Tools können Entwickler einen hohen Standard an Softwarequalität aufrechterhalten, Ausfallzeiten reduzieren und die Benutzererfahrung ihrer x86-64-Anwendungen kontinuierlich verbessern.

Die Rolle von No-code Plattformen beim Debuggen

In einer Zeit, in der Effizienz und schnelle Entwicklung an erster Stelle stehen, haben no-code Plattformen eine bedeutende Nische in der Technologiebranche erobert. Zu ihren vielen Vorzügen gehört, dass diese Plattformen vereinfachte Debugging-Erlebnisse bieten, die den Prozess für Entwickler und Nicht-Entwickler gleichermaßen verändern können. Lassen Sie uns untersuchen, wie no-code Plattformen wie AppMaster eine entscheidende Rolle bei der Vereinfachung des Debuggens von Anwendungen spielen, selbst wenn diese auf komplexen x86-64-Architekturen ausgeführt werden.

In erster Linie standardisieren no-code Umgebungen viele Aspekte des Softwareentwicklungsprozesses. Durch die Bereitstellung eines visuellen Ansatzes für die Anwendungsentwicklung reduzieren diese Plattformen von Natur aus das Potenzial menschlicher Fehler, die zu Fehlern führen können. Wenn Entwickler mit einer herkömmlichen Codebasis arbeiten, insbesondere auf der x86-64-Architektur mit ihrem komplizierten Befehlssatz und der Speicherverwaltung, können sie unbeabsichtigt Fehler einführen, die schwer nachvollziehbar sind. No-code Plattformen beseitigen dieses Problem, indem sie den zugrunde liegenden Code abstrahieren, was ein saubereres und vorhersehbareres Anwendungsverhalten ermöglicht, das das Debuggen vereinfacht.

AppMaster ermöglicht Entwicklern beispielsweise die visuelle Erstellung von Datenmodellen und Geschäftslogik über seinen Business Processes (BP) Designer . Ein solcher Ansatz bedeutet, dass Sie seltener auf unerwartetes Verhalten aufgrund von Syntaxfehlern oder Tippfehlern stoßen, die häufige Stolpersteine bei der herkömmlichen Codierung darstellen. Wenn es ein Problem gibt, ist es oft deutlicher und lokalisierter im visuellen Fluss, was eine schnellere Identifizierung und Behebung ermöglicht.

No-code Plattformen können auch beim Debuggen durch leistungsstarke Protokollierungssysteme und visuelle Hinweise helfen, die den Daten- und Logikfluss in Echtzeit darstellen. Entwickler können Live-Daten beobachten, die die Prozessschritte durchlaufen, und den genauen Punkt identifizieren, an dem etwas schief geht. Darüber hinaus bieten viele dieser Plattformen Simulationsmodi, in denen Sie den Logikfluss und die Eingabedaten replizieren können, ohne die Live-Umgebung zu beeinträchtigen, was für die Isolierung und Behebung von Fehlern äußerst wertvoll sein kann.

In x86-64-Anwendungen, bei denen Leistung und Optimierung von entscheidender Bedeutung sind, bieten no-code Plattformen Profiling-Tools, die Engpässe bei der Anwendungsleistung identifizieren. Obwohl es die detaillierte Profilerstellung auf Architekturebene möglicherweise nicht ersetzt, bietet es einen übergeordneten Überblick, der für eine schnelle Diagnose nützlich ist und es Entwicklern ermöglicht, sich auf die Optimierung der Teile der Anwendung zu konzentrieren, die den größten Einfluss auf die Leistung haben.

Ein weiterer Aspekt, bei dem AppMaster und ähnliche Plattformen glänzen, ist ihre Fähigkeit, sich in bestehende Diagnosetools zu integrieren. Entwickler müssen nicht auf die Vorteile herkömmlicher Debugging-Tools verzichten; Sie können sie mit den Funktionen der no-code Plattform nutzen, um einen gründlicheren und weniger zeitaufwändigen Debugging-Prozess zu erreichen. AppMaster generiert beispielsweise Swagger-Dokumentation (OpenAPI) für endpoints und erleichtert so die Untersuchung und Fehlerbehebung bei API-bezogenen Problemen.

Das Generieren ausführbarer Binärdateien oder Quellcodes durch no-code Plattformen schließt die herkömmlichen Debugging-Praktiken nicht aus. Mit AppMaster können Entwickler beispielsweise den Quellcode für das Hosting vor Ort erhalten und erhalten so die Flexibilität, bei Bedarf x86-64-spezifische Debugging-Techniken und -Tools direkt auf den generierten Code anzuwenden.

Zusammenfassend lässt sich sagen, dass die Rolle von no-code Plattformen beim Debuggen vielfältig ist. Sie minimieren durch Automatisierung und Standardisierung das Risiko, dass sich Fehler in die Anwendung einschleichen, und sorgen gleichzeitig bei Bedarf für Transparenz und Kontrolle. Ihr visueller Charakter und ihre Integrationsfähigkeiten machen sie zu einem leistungsstarken Verbündeten im Debugging-Toolkit, selbst für Anwendungen, die schließlich auf komplexen x86-64-Systemen laufen.

Debuggen von Multithread-Anwendungen auf x86-64

Multithreading bringt Komplexität mit sich, bietet jedoch enorme Leistungsvorteile, insbesondere auf x86-64-Architekturen, die für ihre Parallelitätsfähigkeiten bekannt sind. Das Debuggen von Multithread-Anwendungen erfordert einen methodischen Ansatz und spezielle Techniken, um Parallelitätsprobleme wie Race Conditions, Deadlocks und Thread-Ausfall zu beseitigen. In diesem Abschnitt werden Strategien und Best Practices für die Diagnose und Lösung von Threading-Problemen in x86-64-Anwendungen dargelegt.

Thread-spezifischen Ausführungskontext verstehen

Jeder Thread in einer Multithread-Anwendung arbeitet in seinem eigenen Ausführungskontext, teilt sich jedoch die Ressourcen des Prozesses. Ein ausgeprägtes Verständnis für Kontextwechsel, wie die CPU mehrere Threads verarbeitet und welche Auswirkungen dies auf die Ausführung Ihrer x86-64-Anwendung hat, ist für ein erfolgreiches Debuggen von grundlegender Bedeutung. Entwickler sollten in der Lage sein, kritische Fragen zu beantworten, z. B. welcher Thread zu einem bestimmten Zeitpunkt einen bestimmten Mutex besitzt oder auf eine Bedingungsvariable wartet.

Einsatz threadsicherer Haltepunkte und Überwachungen

Herkömmliche Haltepunkte können die gesamte Anwendung anhalten, aber Entwickler müssen beim Debuggen von Multithread-Code häufig bestimmte Threads anhalten oder Thread-übergreifende Bedingungen überwachen. Verwenden Sie in solchen Fällen threadspezifische Haltepunkte, die die Ausführung nur dann anhalten, wenn der zugehörige Thread sie erreicht. Ebenso können Watchpoints eingerichtet werden, um Entwickler zu benachrichtigen, wenn ein bestimmtes Datenelement gelesen oder geschrieben wird. Dies ist äußerst nützlich, um Datenrennen und unbeabsichtigten Datenzugriff über Threads hinweg aufzuspüren.

Stützt sich auf Synchronization Primitives Logs

Um Parallelitätsprobleme in x86-64-Anwendungen zu bekämpfen, kann die Protokollierung mithilfe von Synchronisierungsprimitiven wie Mutexes, Semaphoren und Bedingungsvariablen Einblicke liefern. Wenn ein Deadlock auftritt, können diese Protokolle dabei helfen, den Punkt zurückzuverfolgen, an dem sich Threads möglicherweise verwickelt haben. Darüber hinaus kann der Einsatz hochentwickelter Lock-Analysetools und Thread-Analysatoren Aufschluss über mögliche Deadlocks oder Konfliktpunkte geben, die durch manuelle Inspektion schwieriger zu erkennen sind.

Simulation von Threading-Szenarien

Eine fortgeschrittene Debugging-Technik besteht darin, bestimmte Thread-Planungsszenarien zu simulieren, um Race Conditions oder Deadlocks zuverlässig zu reproduzieren. Das Festlegen von Thread-Prioritäten, das manuelle Anhalten und Fortsetzen von Threads sowie das Manipulieren der Reihenfolge von Ereignissen können die notwendigen Voraussetzungen für eine gründliche Untersuchung von Parallelitätsfehlern schaffen. Automatisierte Testsuiten, die diese Szenarien simulieren können, können bei der Erkennung und Lösung komplexer Threading-Probleme außerordentlich effektiv sein.

Visualisierung von Thread-Interaktionen

Visuelle Tools, die Threading-Aktivitäten darstellen, können dabei helfen, ein klareres Bild davon zu erhalten, wie Threads interagieren. Diese Tools können Ausführungszeitpläne, Ressourcenzuteilungsdiagramme und andere visuelle Hilfsmittel darstellen, um das Verständnis zu erleichtern, wo Probleme auftreten. Einige integrierte Entwicklungsumgebungen (Integrated Development Environments, IDEs) bieten eine ausgefeilte Visualisierung der Thread-Aktivität und helfen Entwicklern so, bessere Überlegungen zur Multithread-Ausführung anzustellen und Probleme schnell zu erkennen.

Verwenden der bedingten Synchronisierung zum Debuggen

Funktionen zur bedingten Synchronisierung können Entwicklern dabei helfen, Szenarien einzurichten, in denen bestimmte Bedingungen erfüllt sein müssen, damit ein Fehler auftritt. Dazu können erweiterte bedingte Haltepunkte gehören, die den Thread-Status mit Datenbedingungen kombinieren. Beispielsweise könnte ein Haltepunkt spezifisch dafür sein, wann eine bestimmte Variable im Kontext eines bestimmten Threads einen bestimmten Wert erreicht.

Konsequente Verwendung von Fadendesinfektionsmitteln

Thread-Sanitizer sind leistungsstarke Tools, die moderne Compiler und Plattformen bereitstellen, um Race Conditions und andere Probleme im Zusammenhang mit der Parallelität zur Laufzeit zu erkennen. Stellen Sie beim Kompilieren von Anwendungen zum Debuggen sicher, dass Thread-Bereinigungsprogramme oder dynamische Analysetools aktiviert sind. Diese Tools können häufig subtile Threading-Probleme erkennen, die während regelmäßiger Debugging-Sitzungen möglicherweise unbemerkt bleiben.

Optimierung mit No-code -Plattformen für das Debuggen

Während unser Fokus hier auf den Feinheiten des x86-64-Multithread-Debugging liegt, dürfen wir das Potenzial von no-code Plattformen bei der Vereinfachung der Anfangsphasen des Entwicklungslebenszyklus einer Anwendung, einschließlich des Debuggens, nicht außer Acht lassen. Plattformen wie AppMaster abstrahieren einige der mit Multithreading verbundenen Komplexitäten und reduzieren so den anfänglichen Debugging-Overhead. Wenn jedoch die Komplexität zunimmt oder die Anwendung eine komplizierte Thread-Verwaltung erfordert, müssen Entwickler auf praktische Debugging-Techniken zurückgreifen, wie in diesem Abschnitt beschrieben.

Durch die Kombination eines tiefen Verständnisses der x86-64-Architektur und ihres Threading-Modells mit der praktischen Anwendung fortschrittlicher Debugging-Techniken und -Tools können Entwickler in die anspruchsvolle Welt der Multithread-Anwendungen eintauchen. Es handelt sich um einen herausfordernden, aber lohnenden Aspekt der Softwareentwicklung, bei dem Effizienzverbesserungen erhebliche Auswirkungen auf die Leistung und Zuverlässigkeit der Anwendung haben können.

Häufige Fallstricke beim erweiterten Debuggen und wie man sie vermeidet

Das Debuggen von x86-64-Anwendungen ist eine entscheidende Fähigkeit, die Präzision, Geduld und ein tiefes Verständnis sowohl der Software- als auch der Systemarchitektur erfordert. Während viele fortschrittliche Tools und Techniken diesen Prozess unterstützen können, kann es auch leicht passieren, dass Sie in die üblichen Fallen tappen, die Ihren Fortschritt behindern und zu Frustration und Zeitverschwendung führen können. Wenn Sie diese Fallstricke frühzeitig erkennen und lernen, sie zu vermeiden, können Sie Ihre Debugging-Praktiken verbessern und Sie zu einem weitaus effektiveren Entwickler machen.

Eine der ersten großen Fallstricke ist die übermäßige Abhängigkeit von automatisierten Tools . Während diese bei der Bewältigung sich wiederholender Aufgaben unverzichtbar sind, kann es Sie in die Irre führen, wenn Sie ihnen blind vertrauen, ohne zu verstehen, was sie tun. Es ist wichtig, sich daran zu erinnern, dass Werkzeuge nur Hilfsmittel sind; Sie können das kritische Denken und die Problemlösungsfähigkeiten eines Entwicklers nicht ersetzen. Stellen Sie sicher, dass Sie die Ergebnisse automatisierter Tools verstehen, und wenn etwas nicht stimmt, treten Sie einen Schritt zurück und betrachten Sie die Ergebnisse manuell.

Ein weiteres häufig auftretendes Problem ist die Fehlinterpretation von Debugging-Daten . Insbesondere in x86-64-Architekturen, in denen mehrere Abstraktionsebenen vorhanden sind, kann es leicht passieren, dass Sie die Signale eines Debuggers falsch interpretieren. Möglicherweise manifestiert sich der Fehler aufgrund einer Eigenart in der Prozessor-Pipeline oder einer Besonderheit der Speicherverwaltung des Betriebssystems. Stellen Sie immer sicher, dass Sie den Kontext verstehen, in dem Ihre Anwendung betrieben wird, und seien Sie bereit, bei Bedarf in Details auf Systemebene einzutauchen.

Auch die Vernachlässigung architekturspezifischer Merkmale kann zu Fehlleitungen führen. x86-64-Anwendungen können sich unterschiedlich verhalten, je nachdem, ob sie auf einer virtuellen Maschine ausgeführt werden, bestimmte CPU-Erweiterungen verwenden oder auf ungewöhnliche Weise mit Hardware interagieren. Wenn Sie diese Aspekte ignorieren und Ihre Debug-Strategie nicht anpassen, kann dies dazu führen, dass Fehlern nachgejagt wird, die nicht die eigentliche Ursache sind. Um dies zu verhindern, halten Sie Ihr Wissen über die Hardware auf dem neuesten Stand und berücksichtigen Sie deren Eigenschaften beim Debuggen.

Manchmal liegt das Problem in einer unzureichenden Protokollierung . Ohne ausreichend detaillierte Protokolle kann es nahezu unmöglich sein, das Problem zu reproduzieren und zu diagnostizieren, insbesondere wenn der Fehler selten auftritt oder unter bestimmten, schwer zu replizierenden Bedingungen auftritt. Erhöhen Sie die Ausführlichkeit der Protokolle dort, wo es relevant erscheint, und zögern Sie nicht, weitere Protokolle hinzuzufügen, bevor Sie eine Debug-Sitzung starten.

Die Fixierung auf eine vermeintliche Fehlerursache, auch Bestätigungsbias genannt, ist eine weitere Falle. Es ist wichtig, aufgeschlossen zu bleiben und sich nicht zu sehr auf die erste Hypothese einzulassen. Wenn die Beweise Ihre Theorie nicht stützen, seien Sie bereit, sie zu verwerfen und nach alternativen Erklärungen zu suchen.

Eine häufige Gefahr beim Umgang mit Multithread-Programmen besteht darin , dass Timing- und Synchronisationsprobleme wie Race Conditions oder Deadlocks nicht berücksichtigt werden . Diese Fehler können sporadisch auftreten und schwierig zu reproduzieren sein. Um sie zu erkennen, verwenden Sie Thread-Analysetools und überprüfen Sie Ihren Code auf die ordnungsgemäße Verwendung von Synchronisierungsprimitiven. Darüber hinaus kann die Implementierung von Unit- und Integrationstests mit besonderem Fokus auf Parallelität das Auftreten dieser Fehler erheblich reduzieren.

Ein besonders ärgerliches Problem beim fortgeschrittenen Debuggen ist das Verlieren im Unkraut . Es kann sein, dass Sie den Überblick über das Gesamtbild verlieren, wenn Sie tief in der Stapelverfolgung stecken oder die Montageanleitungen durchgehen. Um dies zu verhindern, erinnern Sie sich regelmäßig an das Endziel oder arbeiten Sie mit einem anderen Entwickler zusammen, der eine neue Perspektive bieten kann.

Zu guter Letzt sollte man sich vor dem Missbrauch von Optimierungsflags während der Kompilierung in Acht nehmen. Diese Flags können manchmal dazu führen, dass sich Code anders verhält oder die Fehlerquelle durch Inlining, Code-Neuanordnung oder Eliminierung nicht verwendeter Variablen verschleiert. Beim Debuggen kann es hilfreich sein, Ihre Anwendung mit deaktivierter Optimierung oder auf bestimmten Ebenen, die das unregelmäßige Verhalten deutlicher machen, neu zu kompilieren.

Das fortgeschrittene Debuggen von x86-64-Anwendungen ist ebenso eine Kunst wie eine Wissenschaft. Durch das Erkennen und Vermeiden dieser häufigen Fallstricke können Entwickler ihre Fähigkeiten verbessern und sich bei der Diagnose und Lösung komplexer Softwareprobleme besser auskennen.

Fazit: Ein Debugging-Maestro werden

Der Aufstieg zum „Debugging-Maestro“ erfordert eine Mischung aus Wissen, Übung und Kreativität. Manchmal scheinen Fehler in x86-64-Anwendungen unüberwindbar zu sein, aber mit der richtigen Einstellung und fortschrittlichen Techniken können praktisch alle Probleme entwirrt werden. Ein erfahrener Debugger kennt seine Tools genau und weiß, wie wichtig ein systematischer Ansatz zur Diagnose und Lösung von Problemen ist.

Während Sie Erfahrungen mit verschiedenen Debugging-Szenarien sammeln, verfeinert jede Herausforderung Ihre Fähigkeiten und bringt Ihnen oft etwas Neues über die Architektur, die Anwendung oder sogar die Programmiersprache bei. Sie lernen die Besonderheiten der x86-64-Anwendungsumgebung kennen, von den Nuancen der Speicherverwaltung bis hin zur Multithreading-Komplexität, und jeder behobene Fehler erweitert Ihr Fachwissen.

Denken Sie daran, dass es ein kontinuierlicher Prozess ist, sich mit dem Debuggen vertraut zu machen. Technologien entwickeln sich ständig weiter, und das gilt auch für Ihre Debugging-Techniken und Toolsets. Ganz gleich, ob Sie Reverse Engineering einsetzen, um Einblicke in den Code von Drittanbietern zu gewinnen, oder Routineprüfungen per Skript ausführen, um Zeit zu sparen: Es sind Ihre Beharrlichkeit und Ihre Leidenschaft, sich in das Kaninchenloch komplizierter Fehler einzuarbeiten, die Sie zu einem Meister Ihres Fachs machen.

Ebenso wichtig ist es, den Wandel in der Art und Weise anzuerkennen, wie Anwendungen entwickelt werden. Beim traditionellen Codieren geht es nicht mehr nur um individuelle Fähigkeiten. Moderne Entwicklungsökosysteme wie no-code Plattform von AppMaster vereinfachen viele Aspekte der Anwendungsentwicklung und des Debuggens. Sie ermöglichen es Ihnen, sich auf das Gesamtbild zu konzentrieren, während Sie sich um die zugrunde liegende Codegenerierung kümmern, und stellen so eine neue Grenze für die Problemlösung dar, die sich die Leistungsfähigkeit der visuellen Programmierung und Automatisierung zunutze macht. Wenn Sie es noch nicht getan haben, könnte die Erkundung der Möglichkeiten, die solche Plattformen bieten, Ihr nächster Schritt auf dem Weg zu einem Allround-Debugging-Meister sein.

Akzeptieren Sie die Komplexität, schätzen Sie die Lernmomente und verbessern Sie das Toolkit Ihres Debuggers weiter. Denken Sie daran, dass jede Herausforderung eine Gelegenheit ist, ein wenig Magie zu vollbringen und das scheinbar Unmögliche in einen Beweis Ihrer Problemlösungsfähigkeiten zu verwandeln.

FAQ

Zu den erweiterten Debugging-Techniken gehören die Verwendung von Haltepunkten und Überwachungspunkten, Disassemblern, Speicheranalysatoren, Leistungsprofilern, automatisierter Skripterstellung zum Debuggen und Reverse Engineering. Das richtige Verständnis und die Verwendung dieser Tools kann den Debugging-Prozess für x86-64-Anwendungen erheblich verbessern.

Das Verständnis der x86-64-Architektur bietet Einblicke in die Ausführung von Anwendungen auf dem Prozessor und ermöglicht Ihnen die Optimierung des Debugging-Prozesses durch die Anpassung von Techniken an bestimmte Architekturmerkmale wie Register, Befehlssatz und Speichermodell.

Eine gut konfigurierte Debugging-Umgebung bietet Entwicklern die nötige Kontrolle und Transparenz, um Fehler effizient zu diagnostizieren und zu beheben. Es umfasst einen leistungsstarken Debugger, Zugriff auf Protokolle und andere integrierte Entwicklungstools.

No-code Plattformen wie AppMaster können den Debugging-Prozess vereinfachen, indem sie bestimmte Aspekte automatisieren und den Programmablauf visualisieren, wodurch es einfacher wird, Probleme zu identifizieren und zu lösen, ohne tief in den Code einzutauchen.

Automatisierte Debugging-Skripte können den Debugging-Prozess beschleunigen, indem sie häufig auftretende Probleme wiederholt testen und diagnostizieren, sodass sich Entwickler auf komplexere Fehler konzentrieren können, die eine kreative Problemlösung erfordern.

Die Speicheranalyse hilft bei der Identifizierung von Fehlern im Zusammenhang mit der Speicherverwaltung, wie z. B. Lecks, Beschädigung oder falsche Zuordnung, die in komplexen x86-64-Anwendungen besonders schwierig sind.

Häufige Fallstricke sind das Übersehen architekturspezifischer Details, das Ignorieren subtiler Speicherbeschädigungsprobleme, die unzureichende Nutzung verfügbarer Tools und die fehlende Automatisierung sich wiederholender Debugging-Aufgaben.

Durch die Profilerstellung können Entwickler die Leistungsmerkmale ihrer Anwendungen verstehen, wodurch versteckte Fehler und Engpässe aufgedeckt werden können, die nicht unbedingt zu Abstürzen führen, aber die Gesamtleistung beeinträchtigen.

Reverse Engineering ist der Prozess der Dekonstruktion von Software, um ihre Komponenten und Funktionsweise zu verstehen. Beim Debuggen kann es verwendet werden, um Software zu analysieren, für die der Quellcode nicht verfügbar ist, oder um komplexe Codepfade auf einer tiefen Ebene zu verstehen.

Die intelligente Nutzung von Haltepunkten und Überwachungspunkten umfasst das Unterbrechen von Bedingungen, die Protokollierung ohne Unterbrechung und die Verwendung hardwaregestützter Überwachungspunkte zur Überwachung von Daten ohne nennenswerte Leistungseinbußen.

Disassembler und Decompiler sind Werkzeuge, die Maschinencode zurück in eine Darstellung auf höherer Ebene übersetzen. Sie können von unschätzbarem Wert sein, um zu verstehen, was die CPU ausführt, insbesondere wenn es um Abstürze oder Sicherheitslücken geht.

Ja, das Debuggen von Multithread-Anwendungen kann von bestimmten Strategien profitieren, wie z. B. der Verwendung von Thread-sicheren Haltepunkten, der Analyse von Thread-Interaktionen und der Gewährleistung geeigneter Synchronisierungsmechanismen, um Fehler im Zusammenhang mit der Parallelität zu vermeiden.