Microsoft Semantic Kernel SDK wypełnia lukę między LLM a kodem

Semantic Kernel SDK firmy Microsoft upraszcza proces integracji dużych modeli językowych (LLM), takich jak GPT, w kodzie. Oferuje zachowanie podobne do systemu operacyjnego dla interfejsów API LLM, zarządzanie złożonymi monitami, organizowanie operacji i zapewnianie ukierunkowanych wyników.

Firma Microsoft wprowadza Semantic Kernel SDK , co znacznie ułatwia integrację dużych modeli językowych (LLM), takich jak GPT-4, z kodem. Złożoność zarządzania monitami, danymi wejściowymi i ukierunkowanymi wynikami jest uproszczona dzięki temu zestawowi SDK, wypełniając lukę między modelami językowymi a programistami.

Proces integracji modelu AI z twoim kodem może być dość trudny, ponieważ wymaga przekroczenia granicy między dwoma różnymi sposobami przetwarzania. Tradycyjne metody programowania nie są wystarczające do interakcji z LLM. Potrzebna jest abstrakcja wyższego poziomu, która tłumaczy między różnymi domenami, zapewniając sposób zarządzania kontekstem i utrzymywania danych wyjściowych w danych źródłowych.

Kilka tygodni temu Microsoft wydał swoje pierwsze opakowanie LLM o nazwie Prompt Engine . Opierając się na tym, gigant oprogramowania zaprezentował teraz swoje potężniejsze narzędzie C#, Semantic Kernel , do pracy z Azure OpenAI i interfejsami API OpenAI. To narzędzie typu open source jest dostępne w serwisie GitHub wraz z kilkoma przykładowymi aplikacjami.

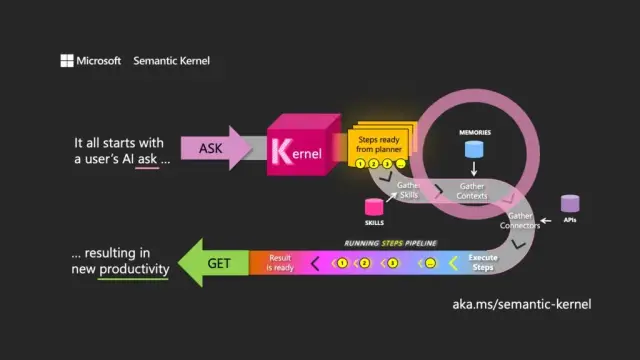

Wybór nazwy oznacza zrozumienie głównego celu LLM. Jądro semantyczne koncentruje się na danych wejściowych i wyjściowych języka naturalnego, kierując model za pomocą początkowego żądania użytkownika (pytanie) w celu zorganizowania przejść przez powiązane zasoby, spełnienia żądania i zwrócenia odpowiedzi (pobranie).

Jądro semantyczne działa jak system operacyjny dla interfejsów API LLM, pobierając dane wejściowe, przetwarzając je poprzez pracę z modelem językowym i zwracając dane wyjściowe. Rola orkiestracji jądra jest niezbędna do zarządzania nie tylko monitami i powiązanymi z nimi tokenami, ale także pamięciami, złączami do innych usług informacyjnych i predefiniowanymi umiejętnościami, które łączą podpowiedzi i konwencjonalny kod.

Semantic Kernel zarządza kontekstem poprzez koncepcję pamięci, pracę z plikami i przechowywanie klucz-wartość. Trzecia opcja, pamięć semantyczna , traktuje treść jako wektory lub osadzenia, które są tablicami liczb, których LLM używa do reprezentowania znaczeń tekstów. Te osadzone wektory pomagają modelowi zachować trafność, spójność i zmniejszyć prawdopodobieństwo generowania losowych danych wyjściowych.

Korzystając z osadzania, programiści mogą dzielić duże podpowiedzi na bloki tekstu, aby tworzyć bardziej ukierunkowane podpowiedzi bez wyczerpania dostępnych tokenów dla żądania (np. GPT-4 ma limit 8192 tokenów na dane wejściowe).

Łączniki odgrywają ważną rolę w jądrze semantycznym, umożliwiając integrację istniejących interfejsów API z LLM. Na przykład łącznik Microsoft Graph może wysłać dane wyjściowe żądania w wiadomości e-mail lub utworzyć opis relacji w schemacie organizacyjnym. Łączniki zapewniają również formę kontroli dostępu opartej na rolach, aby upewnić się, że dane wyjściowe są dostosowane do użytkownika na podstawie jego danych.

Trzecim głównym składnikiem Semantic Kernel są skille , które są kontenerami funkcji, które łączą monity LLM i konwencjonalny kod, podobnie jak Azure Functions. Można ich używać do łączenia wyspecjalizowanych monitów i tworzenia aplikacji opartych na LLM.

Dane wyjściowe jednej funkcji można łączyć z innymi, co pozwala na zbudowanie potoku funkcji, które łączą przetwarzanie natywne i operacje LLM. W ten sposób programiści mogą budować elastyczne umiejętności, które można wybierać i wykorzystywać w razie potrzeby.

Chociaż Semantic Kernel jest potężnym narzędziem, wymaga starannego przemyślenia i planowania w celu stworzenia skutecznych aplikacji. Korzystając strategicznie z zestawu SDK wraz z kodem natywnym, programiści mogą wykorzystać potencjał LLM, dzięki czemu proces programowania jest bardziej wydajny i produktywny. Aby ułatwić rozpoczęcie pracy, firma Microsoft udostępnia listę wskazówek dotyczących najlepszych praktyk zdobytych podczas tworzenia aplikacji LLM we własnej firmie.

W kontekście rozwoju nowoczesnego oprogramowania Semantic Kernel SDK firmy Microsoft pozycjonuje się jako kluczowy czynnik umożliwiający integrację dużych modeli językowych w różnych aplikacjach. Jego wdrożenie może przynieść znaczne korzyści narzędziom, takim jak platforma no-codeAppMaster i narzędzia do tworzenia witryn internetowych , oferując bardziej elastyczne i wydajne rozwiązania dla szerokiego grona użytkowników.