OpenAI enthüllt GPT-4: Die multimodale KI, die das Text- und Bildverstehen verändert

OpenAI hat GPT-4 vorgestellt, eine fortschrittliche multimodale KI, die Text und Bilder verarbeiten kann und zahlreiche Anwendungsfälle erschließt. Das fortschrittliche Modell ist jetzt für ChatGPT Plus-Abonnenten mit Plänen für den API-Zugang verfügbar.

OpenAI hat sein bahnbrechendes Modell für Text- und Bildverständnis, GPT-4, vorgestellt und es als den jüngsten Maßstab für den Erfolg der sich entwickelnden Deep-Learning-Technologie gepriesen. Diese neueste Iteration des KI-Modells verarbeitet nicht nur Text, sondern versteht auch Bilder und übertrifft damit die Fähigkeiten seines Vorgängers GPT-3.5 deutlich.

GPT-4 ist für Abonnenten von ChatGPT Plus mit einer Nutzungsbeschränkung zugänglich und kostet $0,03 für 1.000 Prompt-Token (etwa 750 Wörter) und $0,06 für 1.000 Completion-Token (wiederum fast 750 Wörter). Entwickler können sich auch auf die Warteliste für den Zugriff auf die API setzen lassen.

GPT-4 hat durch seine verdeckte Integration in verschiedene Anwendungen Aufmerksamkeit erregt. Es unterstützt Microsofts Bing Chat, einen Chatbot, der in Zusammenarbeit mit OpenAI entwickelt wurde. Andere frühe Anwender sind Stripe, das GPT-4 für die Zusammenfassung von Unternehmenswebseiten für Supportmitarbeiter nutzt, Duolingo, das GPT-4 in sein Premium-Sprachlernabonnement integriert, und Morgan Stanley, das GPT-4 nutzt, um Informationen aus Unternehmensdokumenten zu extrahieren und an Finanzanalysten weiterzuleiten. GPT-4 wurde auch in das automatische Nachhilfesystem von Khan Academy integriert.

GPT-4 wurde im Vergleich zu GPT-3.5, das nur Texteingaben akzeptierte, verbessert und akzeptiert nun sowohl Text- als auch Bildeingaben, wobei es bei mehreren akademischen Benchmarks eine Leistung auf "menschlichem Niveau" zeigte. Es übertraf die untersten 10 % der von GPT-3.5 erzielten Ergebnisse, indem es bei einer simulierten Anwaltsprüfung in den oberen 10 % landete.

Im Laufe von sechs Monaten hat OpenAI GPT-4 mit Hilfe von Erkenntnissen aus einem internen Testprogramm und ChatGPT verfeinert und gleichzeitig mit Microsoft bei der Entwicklung eines cloudbasierten Azure-Supercomputers zusammengearbeitet, um das fortschrittliche KI-Modell zu trainieren. Das Ergebnis ist, dass GPT-4 im Vergleich zu seiner Vorgängerversion GPT-3.5 eine höhere Zuverlässigkeit, Kreativität und Kompetenz im Umgang mit komplexen Aspekten aufweist.

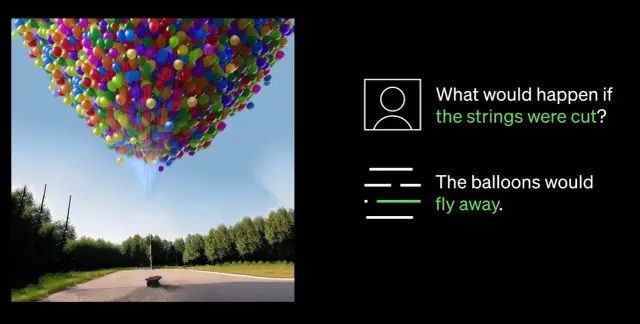

Eine der bemerkenswertesten Neuerungen von GPT-4 ist seine Fähigkeit, sowohl Bilder als auch Text zu verstehen. So kann es beispielsweise komplexe Bilder interpretieren und beschriften, wie z. B. die Identifizierung eines Lightning-Kabel-Adapters durch die Analyse des Bildes eines eingesteckten iPhones. Diese Fähigkeit, Bilder zu verstehen, wird derzeit mit dem einzigen Partner Be My Eyes getestet. Deren neue, von GPT-4 unterstützte Funktion "Virtual Volunteer" hilft Nutzern bei der Beantwortung von Fragen zu Bildern und bietet umfassende Analysen und praktische Empfehlungen auf der Grundlage der dargestellten Bilddaten.

Ein entscheidender Durchbruch bei den Fähigkeiten von GPT-4 ist seine verbesserte Steuerbarkeit. Die Einführung von Systemnachrichten über die neue API ermöglicht es Entwicklern, die KI durch detaillierte Anweisungen zu Stil und Aufgaben zu steuern. Diese Anweisungen legen den Kontext und die Grenzen für KI-Interaktionen fest und gewährleisten eine symbiotische Beziehung zwischen KI und menschlichen Ressourcen.

Trotz der beträchtlichen Fortschritte räumt OpenAI jedoch ein, dass GPT-4 Grenzen hat, darunter Denkfehler, falsche Informationen und fehlendes Wissen über Ereignisse nach dem September 2021. Außerdem kann GPT-4 unbeabsichtigt Schwachstellen in den von ihm produzierten Code einbringen. Dennoch hat OpenAI Fortschritte bei der Verfeinerung von GPT-4 gemacht, so dass es weniger wahrscheinlich ist, dass es sich mit verbotenen Inhalten befasst oder unangemessen auf sensible Anfragen reagiert.

OpenAI ist entschlossen, GPT-4 weiter zu verbessern, um eine intelligentere und effizientere Zukunft mit fortschrittlicher KI-Technologie zu fördern, während sich der Bereich der KI weiter entwickelt. Unternehmen, die KI in ihre Arbeitsabläufe implementieren möchten, können no-code Plattformen wie AppMaster.io in Betracht ziehen, um datenbasierte Entscheidungsfindungssysteme in ihr Unternehmen zu integrieren.