OpenAI ujawnia GPT-4: Multimodalną Sztuczną Inteligencję, która zmienia rozumienie tekstu i obrazu.

OpenAI wprowadziło GPT-4, zaawansowaną multimodalną AI zdolną do przetwarzania tekstu i obrazów, odblokowując liczne przypadki użycia. Zaawansowany model jest już dostępny dla abonentów ChatGPT Plus z planami dostępności API.

OpenAI zaprezentowało swój przełomowy model rozumienia tekstu i obrazu, GPT-4, uznając go za najnowszy wyznacznik sukcesu w rozwoju technologii głębokiego uczenia. Ta najnowsza iteracja modelu AI nie tylko przetwarza tekst, ale także rozumie obrazy, znacznie przewyższając możliwości swojego poprzednika, GPT-3.5.

Dostępny dla subskrybentów ChatGPT Plus z narzuconym limitem użycia, GPT-4 pobiera 0,03 USD za 1000 tokenów zachęty (około 750 słów) i 0,06 USD za 1000 tokenów zakończenia (ponownie, prawie 750 słów). Deweloperzy są również mile widziani, aby dołączyć do listy oczekujących na dostęp do API.

GPT-4 zwróciło uwagę na swoją ukrytą integrację z różnymi aplikacjami. Zasilają one Bing Chat Microsoftu, chatbota stworzonego we współpracy z OpenAI. Innymi pierwszymi użytkownikami są Stripe, który używa GPT-4 do streszczania stron biznesowych dla pracowników wsparcia technicznego; Duolingo, które włącza GPT-4 do swojej subskrypcji nauki języków obcych; oraz Morgan Stanley, który wykorzystuje GPT-4 do wyodrębniania i dostarczania informacji o dokumentach firmowych analitykom finansowym. GPT-4 zostało również zintegrowane z automatycznym systemem korepetycji Khan Academy.

Ulepszony w stosunku do GPT-3.5, który akceptował tylko tekst, GPT-4 przyjmuje zarówno tekst jak i obraz, demonstrując wydajność na poziomie człowieka w wielu akademickich benchmarkach. Przewyższył on wyniki z dolnych 10% osiągnięte przez GPT-3.5, osiągając wyniki w granicach górnych 10% progu symulowanego egzaminu adwokackiego.

W ciągu sześciu miesięcy OpenAI udoskonalił GPT-4, wykorzystując spostrzeżenia z wewnętrznego programu testów adwersarza i ChatGPT, jednocześnie współpracując z Microsoftem przy projektowaniu superkomputera w chmurze Azure do szkolenia zaawansowanego modelu AI. W rezultacie GPT-4 wykazuje się większą niezawodnością, kreatywnością i kompetencją w obsłudze skomplikowanych aspektów w porównaniu z jego poprzednią wersją, GPT-3.5.

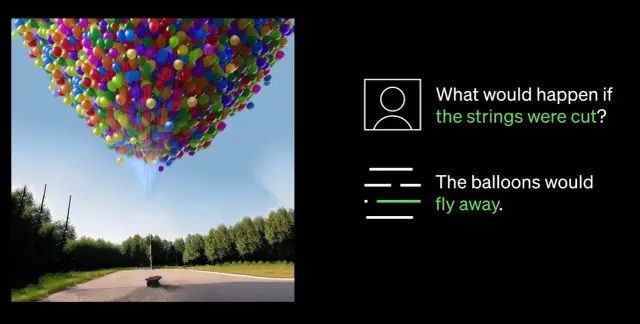

Jednym z najbardziej godnych uwagi osiągnięć GPT-4 jest jego zdolność do rozumienia zarówno obrazów jak i tekstu. Na przykład, może interpretować i podpisywać złożone obrazy, takie jak identyfikacja adaptera Lightning Cable poprzez analizę obrazu podłączonego iPhone'a. Ta zdolność rozumienia obrazów jest obecnie testowana z jednym partnerem Be My Eyes. Ich nowa funkcja Wirtualnego Wolontariusza napędzana przez GPT-4 pomaga użytkownikom odpowiadając na pytania dotyczące obrazów, oferując kompleksową analizę i praktyczne zalecenia oparte na przedstawionych danych obrazu.

Najważniejszym przełomem w możliwościach GPT-4 jest jego zwiększona sterowność. Wprowadzenie komunikatów systemowych za pośrednictwem nowego API pozwala programistom kierować AI poprzez dostarczanie szczegółowych instrukcji dotyczących stylu i zadań. Instrukcje te ustalają kontekst i granice interakcji AI, zapewniając symbiotyczną relację między AI a zasobami ludzkimi.

Pomimo znacznych postępów, OpenAI przyznaje jednak, że GPT-4 ma ograniczenia, w tym błędy w rozumowaniu, błędne informacje i brak wiedzy o wydarzeniach po wrześniu 2021 roku. Dodatkowo GPT-4 może nieumyślnie wprowadzić podatności w produkowanym przez siebie kodzie. Niemniej jednak OpenAI poczyniło postępy w udoskonalaniu GPT-4, dzięki czemu jest mniej prawdopodobne, że zaangażuje się w zakazane treści lub będzie nieodpowiednio reagować na wrażliwe żądania.

W miarę rozwoju dziedziny AI, OpenAI jest zdeterminowane do dalszego doskonalenia GPT-4, wspierając bardziej inteligentną i wydajną przyszłość napędzaną przez zaawansowaną technologię AI. Firmy dążące do wdrożenia AI do swoich przepływów pracy mogą rozważyć zbadanie platform no-code, takich jak AppMaster.io, aby zintegrować systemy podejmowania decyzji oparte na danych w swoich firmach.