Ratenbegrenzung für öffentliche APIs: praktische Quoten und Sperrungs‑Flows

Ratenbegrenzung für öffentliche APIs, die Missbrauch verhindert, ohne echte Nutzer zu blockieren: praktische Limits, pro‑Schlüssel‑Quoten, Sperrmechanismen und Tipps zur Einführung.

Welches Problem Ratenbegrenzung tatsächlich löst

Ratenbegrenzung für öffentliche APIs ist nicht dazu da, Nutzer zu bestrafen. Sie ist ein Sicherheitsventil, das Ihren Dienst verfügbar hält, wenn der Traffic seltsam wird — egal, ob dieses "seltsam" böswillig ist oder einfach ein Fehler im Client.

"Missbrauch" sieht oft anfangs normal aus: ein Scraper, der alle Endpunkte abläuft, um Daten zu kopieren; Brute‑Force‑Loginversuche; Token‑Stuffing gegen Auth‑Routen; oder ein durchdrehender Client, der nach einem Timeout dieselbe Anfrage in einer engen Schleife wiederholt. Manchmal greift überhaupt niemand an — ein Mobile‑App‑Update bringt eine fehlerhafte Cache‑Regel und plötzlich pollt jedes Gerät Ihre API jede Sekunde.

Die Aufgabe ist einfach: die Verfügbarkeit schützen und Kosten kontrollieren, ohne echte Nutzer bei ihrer Arbeit zu blockieren. Wenn Ihr Backend abgerechnet wird (Compute, Datenbank, E‑Mail/SMS, AI‑Aufrufe), kann ein lauter Akteur schnell eine echte Rechnung verursachen.

Allein Ratenbegrenzung reicht aber nicht. Ohne Monitoring und klare Fehlermeldungen erhalten Sie stille Fehler, verwirrte Kunden und Support‑Tickets, die klingen wie "Ihre API ist down", obwohl eigentlich gedrosselt wird.

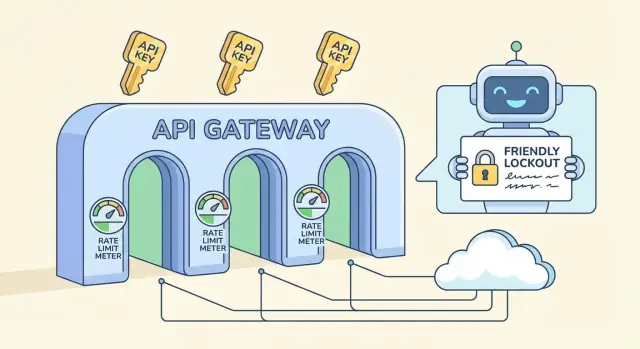

Ein vollständiger Schutz besteht meist aus mehreren getrennten Teilen:

- Rate Limits: Kurzfenster‑Caps (pro Sekunde/Minute), die Spitzen stoppen.

- Quoten: Längere Zeitfenster (pro Tag/Monat), die Nutzung vorhersehbar machen.

- Sperrungen (Lockouts): Zeitweilige Blockierungen bei eindeutig missbräuchlichem Verhalten.

- Ausnahmen: Allowlists für vertrauenswürdige Integrationen, interne Tools oder VIP‑Kunden.

Wenn Sie ein API‑Backend auf einer Plattform wie AppMaster bauen, gelten diese Regeln weiterhin. Selbst mit sauber generiertem Code möchten Sie schützende Defaults, damit ein schlechter Client nicht Ihren gesamten Dienst mitnimmt.

Begriffsklärung: Rate Limits, Quoten, Throttling und Sperrungen

Diese Begriffe werden oft vermischt, lösen aber unterschiedliche Probleme und wirken sich unterschiedlich auf Nutzer aus.

Rate Limit, Quote und Concurrency: Was sie jeweils bedeuten

Ein Rate Limit ist eine Geschwindigkeitsbegrenzung: wie viele Anfragen ein Client in einem kurzen Fenster machen kann (pro Sekunde, pro Minute). Eine Quote ist ein Budget: die Gesamt‑Nutzung über einen längeren Zeitraum (pro Tag, pro Monat). Ein Concurrency Limit begrenzt, wie viele Anfragen gleichzeitig in Bearbeitung sein dürfen — nützlich für teure Endpunkte, auch wenn die Anfragerate normal aussieht.

Wo Sie das Limit ansetzen, ist wichtig:

- Pro IP: einfach, bestraft aber gemeinsame Netze (Büros, Schulen, Mobilfunkanbieter).

- Pro Benutzer: gut für eingeloggte Apps, aber abhängig von zuverlässiger Identität.

- Pro API‑Schlüssel: üblich für öffentliche APIs, klare Verantwortung und einfach zu kommunizieren.

- Pro Endpunkt: nützlich, wenn eine Route deutlich schwerer ist als andere.

Throttling vs. Blockieren und wo Sperrungen passen

Soft Throttling verlangsamt den Client (Verzögerungen, geringere Burst‑Kapazität), sodass er sich erholen kann, ohne Workflows zu zerstören. Hard Blocking lehnt Anfragen sofort ab, üblicherweise mit HTTP 429.

Eine Sperrung ist stärker als ein normales 429. Ein 429 sagt "versuchen Sie es bald nochmal." Eine Sperrung sagt "stoppen Sie, bis eine Bedingung erfüllt ist", z. B. eine Abkühlzeit, eine manuelle Überprüfung oder ein Zurücksetzen des Schlüssels. Sperrungen sollten für eindeutige Missbrauchssignale reserviert werden (Credential Stuffing, aggressives Scraping, wiederholte ungültige Auth), nicht für normale Verkehrsspitzen.

Wenn Sie eine API mit einem Tool wie AppMaster bauen, behandeln Sie diese Kontrollen separat: Kurzfenster‑Limits für Bursts, längere Quoten für Kosten und Sperrungen nur bei wiederholt schlechtem Verhalten.

Praktische Limits wählen, ohne wild zu raten

Gute Limits beginnen mit einem Ziel: das Backend schützen und normalen Nutzern erlauben, ihre Aufgaben zu beenden. Sie brauchen keine perfekten Zahlen am ersten Tag. Sie brauchen eine sichere Basis und eine Möglichkeit zur Anpassung.

Ein einfacher Ausgangspunkt ist ein per‑API‑Schlüssel‑Limit, das zur Art Ihrer API passt:

- Niedriger Traffic: 60–300 Anfragen pro Minute und Schlüssel

- Mittlerer Traffic: 600–1.500 Anfragen pro Minute und Schlüssel

- Hoher Traffic: 3.000–10.000 Anfragen pro Minute und Schlüssel

Teilen Sie dann die Limits nach Endpunkttyp auf. Lese‑Anfragen sind meist günstiger und können höhere Limits haben. Schreib‑Operationen verändern Daten, lösen oft zusätzliche Logik aus und verdienen engere Caps. Ein gängiges Muster ist etwa 1.000/min für GET‑Routen, aber 100–300/min für POST/PUT/DELETE.

Identifizieren Sie außerdem teure Endpunkte und behandeln Sie diese separat: Suche, Berichtserstellung, Exporte, Datei‑Uploads und alles, was mehrere Tabellen trifft oder schwere Geschäftslogik ausführt, sollte ein kleineres Bucket haben, selbst wenn der Rest der API großzügig ist. Wenn Ihr Backend visuelle Workflows (z. B. Business Process Flows) nutzt, ist jeder zusätzliche Schritt echte Arbeit, die sich unter Last multipliziert.

Planen Sie für Bursts mit zwei Fenstern: ein kurzes Fenster, um schnelle Spitzen abzufangen, plus ein längeres Fenster, das anhaltende Nutzung begrenzt. Eine gängige Kombination ist 10 Sekunden plus 10 Minuten. Das hilft echten Nutzern, die schnell klicken, ohne Scraping unbegrenzt zu erlauben.

Entscheiden Sie schließlich, was passiert, wenn der Client das Limit überschreitet. Die meisten öffentlichen APIs geben HTTP 429 mit einer klaren Retry‑Zeit zurück. Wenn die Arbeit verzögert werden kann (z. B. ein Export), überlegen Sie, sie in eine Warteschlange zu stellen, statt hart zu blockieren, damit echte Nutzer trotzdem Ergebnisse bekommen.

Pro‑Schlüssel‑Quoten so gestalten, dass sie fair wirken

Pro‑Schlüssel‑Quoten sind meist fair, weil sie dem Nutzungsverhalten Ihrer Kunden entsprechen: ein Account, ein API‑Schlüssel, klare Verantwortung. IP‑basierte Limits sind weiterhin nützlich, bestrafen aber oft Unschuldige.

Gemeinsame IPs sind der Hauptgrund: Ein ganzes Büro kann eine öffentliche IP nutzen, und Mobilfunkanbieter setzen tausende Geräte hinter wenigen IPs zusammen. Wenn Sie nur auf IP‑Caps setzen, kann ein lauter Nutzer alle anderen ausbremsen. Eine per‑Schlüssel‑Quota vermeidet das, und Sie können ein leichtes per‑IP‑Limit als Rückfall zur Abwehr offensichtlicher Fluten behalten.

Damit Quoten fair wirken, koppeln Sie sie an Kundentiers, ohne neue Nutzer zu fangen. Ein kostenloser oder Test‑Schlüssel sollte echtes Testen erlauben, aber nicht in einem Umfang, der Ihnen schadet. Ein einfaches Muster ist großzügige Bursts, eine moderate Dauer‑Rate und eine Tagesquote, die zum Plan passt.

Eine per‑Schlüssel‑Policy, die vorhersehbar bleibt:

- Kurzbursts erlauben (Page Loads, Batch‑Imports), dann eine konstante Rate erzwingen.

- Eine tägliche Obergrenze pro Schlüssel, um Scraping und eskalierende Loops zu begrenzen.

- Limits je nach Plan erhöhen, aber die gleiche Struktur beibehalten, damit das Verhalten konsistent bleibt.

- Einen niedrigeren Cap für frisch erstellte Schlüssel, bis sie ein gutes Verhalten nachweisen.

- Ein kleines per‑IP‑Limit behalten, um offensichtliche Fluten und falsch konfigurierte Clients zu erwischen.

Um Key‑Sharing und automatisierte Signups zu entmutigen, braucht es keine intensive Überwachung. Beginnen Sie mit einfachen Checks wie ungewöhnlichen Geo‑Wechseln, zu vielen verschiedenen IPs pro Stunde für einen Schlüssel oder vielen neuen Schlüsseln aus derselben Quelle. Erst verlangsamen und dann sperren — erst bei wiederholten Signalen.

Anonymer Traffic ist der Bereich, in dem strengere Caps Sinn machen. Wenn Sie Test‑Schlüssel anbieten, begrenzen Sie sie streng und verlangen eine Basisverifikation, bevor Sie Limits anheben. Wenn Ihre API ein öffentliches Formular speist, erwägen Sie einen eigenen anonymen Endpunkt mit eigener Quota, damit der Rest des Backends geschützt bleibt.

Wenn Sie Ihre API mit AppMaster bauen, ist per‑Schlüssel‑Logik oft einfacher konsistent zu halten, weil Auth, Geschäftsregeln und Antwortverhalten an einem Ort leben.

Clientfreundliche Antworten und Header (damit Nutzer sich erholen können)

Ratenbegrenzung funktioniert langfristig nur, wenn Clients verstehen, was passiert ist und wie sie reagieren sollen. Streben Sie Antworten an, die langweilig vorhersehbar sind: gleicher Statuscode, gleiche Felder, gleiche Bedeutung über Endpunkte hinweg.

Wenn ein Client ein Limit trifft, geben Sie HTTP 429 (Too Many Requests) mit einer klaren Nachricht und einer konkreten Wartezeit zurück. Der schnellste Gewinn ist das Hinzufügen von Retry-After, denn selbst einfache Clients können dann korrekt pausieren.

Eine kleine Menge an Headern macht Limits selbsterklärend. Halten Sie die Namen konsistent und fügen Sie sie sowohl auf erfolgreichen Antworten (damit Clients ihr Tempo anpassen können) als auch auf 429‑Antworten hinzu (damit Clients sich erholen können):

Retry-After: Sekunden bis zum nächsten VersuchX-RateLimit-Limit: aktuell erlaubte Anfragen pro FensterX-RateLimit-Remaining: verbleibende Anfragen im aktuellen FensterX-RateLimit-Reset: wann das Fenster zurückgesetzt wird (Epoch‑Seconds oder ISO‑Zeit)X-RateLimit-Policy: kurzer Text wie "60 requests per 60s"

Machen Sie den Fehlerkörper so strukturiert wie Ihre Erfolgsantworten. Ein gängiges Muster ist ein Error‑Objekt mit stabilem code, einer benutzerfreundlichen message und Hinweisen zur Wiederherstellung.

{

"error": {

"code": "rate_limit_exceeded",

"message": "Too many requests. Please retry after 12 seconds.",

"retry_after_seconds": 12,

"limit": 60,

"remaining": 0,

"reset_at": "2026-01-25T12:34:56Z"

}

}

Sagen Sie Clients, wie sie bei 429s zurückfallen sollen. Exponentielles Backoff ist ein guter Standard: warten Sie 1s, dann 2s, dann 4s und begrenzen Sie es (z. B. bei 30–60 Sekunden). Seien Sie auch explizit, wann sie aufhören sollen zu retrien.

Vermeiden Sie Überraschungen in der Nähe von Quoten. Wenn ein Schlüssel kurz vor dem Cap steht (z. B. 80–90 % erreicht), fügen Sie ein Warnfeld oder einen Header hinzu, damit Clients vor dem Fail langsamer werden können. Das ist besonders wichtig, wenn ein Skript mehrere Routen schnell anfragt und Budget schneller aufbraucht als erwartet.

Schritt für Schritt: Ein einfacher Rollout‑Plan für Limits und Quoten

Ein Rollout funktioniert am besten, wenn Sie Limits als Produktverhalten behandeln, nicht als einmalige Firewall‑Regel. Das Ziel bleibt: das Backend schützen und normale Kunden bewegt halten.

Beginnen Sie mit einer schnellen Inventur. Listen Sie jeden Endpunkt auf und markieren Sie ihn nach Kosten (CPU, Datenbankarbeit, Drittanbieter‑Aufrufe) und Risiko (Login, Passwort‑Reset, Suche, Datei‑Upload). So vermeiden Sie, dass Sie überall dieselbe grobe Grenze anwenden.

Eine Reihenfolge für den Rollout, die Überraschungen meist vermeidet:

- Endpunkte nach Kosten und Risiko taggen und entscheiden, welche strengere Regeln brauchen (Login, Bulk‑Export).

- Identifikationsschlüssel in Prioritätsreihenfolge wählen: zuerst API‑Schlüssel, dann User‑ID, IP nur als Fallback.

- Kurzfenster‑Limits (pro 10 Sekunden oder pro Minute) hinzufügen, um Bursts und Skripte zu stoppen.

- Längerfristige Quoten (pro Stunde oder pro Tag) hinzufügen, um anhaltende Nutzung zu begrenzen.

- Allowlists für vertrauenswürdige Systeme und interne Tools hinzufügen, damit Ops‑Arbeit nicht blockiert wird.

Halten Sie die erste Version konservativ. Es ist einfacher, später zu lockern, als verärgerte Nutzer freizuschalten.

Überwachen und optimieren Sie, dann versionieren Sie Ihre Policy. Verfolgen Sie, wie viele Anfragen Limits treffen, welche Endpunkte das auslösen und wie viele eindeutige Schlüssel betroffen sind. Wenn Sie Zahlen ändern, behandeln Sie das wie eine API‑Änderung: dokumentieren, schrittweise einführen und alte und neue Regeln getrennt halten, damit ein schnelles Rollback möglich ist.

Wenn Sie Ihre API mit AppMaster bauen, planen Sie diese Regeln zusammen mit Ihren Endpunkten und Geschäftslogiken, damit Limits den realen Kosten jedes Workflows entsprechen.

Sperrungs‑Workflows, die Missbrauch ohne Drama stoppen

Sperrungen sind der Sicherheitsgurt. Sie sollten offensichtlichen Missbrauch schnell stoppen, aber normalen Nutzern einen klaren Weg zur Wiederherstellung lassen, wenn etwas schiefgeht.

Eine ruhige Herangehensweise sind progressive Strafen. Gehen Sie davon aus, dass der Client falsch konfiguriert ist, nicht böswillig, und eskalieren Sie nur, wenn sich das Muster wiederholt.

Eine einfache progressive Leiter

Verwenden Sie wenige Schritte, die leicht zu erklären und umzusetzen sind:

- Warnen: den Client informieren, dass er sich den Limits nähert und wann es zurücksetzt.

- Verlangsamen: kurze Verzögerungen oder engere Per‑Second‑Limits für den Schlüssel hinzufügen.

- Temporäre Sperrung: für Minuten blockieren (nicht Stunden) mit einer genauen Entsperrzeit.

- Längere Sperrung: erst nach wiederholten Bursts über mehrere Fenster.

- Manuelle Überprüfung: bei Mustern, die absichtlich erscheinen oder immer wieder auftreten.

Wichtig ist, was Sie sperren. Per‑API‑Schlüssel ist meist am fairsten, weil es den Aufrufer trifft, nicht alle hinter einem gemeinsamen Netzwerk. Per‑Account hilft, wenn Nutzer Schlüssel rotieren. Per‑IP kann bei anonymem Traffic helfen, aber sorgt für False Positives bei NATs, Büros und Mobilfunkanbietern. Bei ernsthaftem Missbrauch kombinieren Sie Signale (z. B. sperren Sie den Schlüssel und verlangen zusätzliche Checks für die IP), aber halten Sie die Blast‑Radius klein.

Machen Sie Sperrungen zeitbasiert mit einfachen Regeln: "gesperrt bis 14:05 UTC" und "setzt nach 30 Minuten gutem Verhalten zurück." Vermeiden Sie permanente Bans für automatisierte Systeme. Ein fehlerhafter Client kann schnell in eine Schleife geraten und Limits verbrennen, daher sollten Strafen über die Zeit abklingen. Eine anhaltende Phase mit niedriger Rate sollte das Strafniveau reduzieren.

Wenn Sie Ihre API in AppMaster bauen, lässt sich diese Leiter gut auf gespeicherte Zähler und einen Business Process abbilden, der entscheiden kann: erlauben, verlangsamen oder blockieren und die Entsperrzeit für den Schlüssel schreiben.

Für Wiederholungstäter behalten Sie einen Weg zur manuellen Prüfung. Streiten Sie nicht mit Nutzern. Fragen Sie nach Request‑IDs, Zeitstempeln und dem API‑Schlüssel‑Namen und entscheiden Sie anhand der Beweise.

Häufige Fehler, die False Positives verursachen

False Positives tauchen auf, wenn Ihre Abwehrmechanismen normale Nutzer blockieren. Meistens passieren sie, weil Regeln zu simpel sind für die tatsächliche Nutzung Ihrer API.

Ein klassischer Fehler ist ein globales Limit für alles. Wenn Sie eine günstige Read‑Route und einen teuren Export gleich behandeln, schützen Sie entweder die günstige Route zu stark (ärgerlich) oder die teure zu wenig (gefährlich). Teilen Sie Limits nach Endpunktkosten und machen Sie schwere Pfade strenger.

Nur IP‑basiertes Limiting ist eine weitere Falle. Viele echte Nutzer teilen eine öffentliche IP (Büros, Schulen, Mobilfunk). Ein schwerer Nutzer kann alle blockieren, und es sieht wie zufällige Ausfälle aus. Bevorzugen Sie zuerst per‑API‑Schlüssel‑Limits und nutzen Sie IP nur als sekundäres Signal für offensichtlichen Missbrauch.

Ausfälle können ebenfalls False Positives erzeugen. Wenn Ihr Limiter‑Store ausfällt, kann "fail closed" Ihre ganze API runterziehen. "Fail open" kann einen Spike einladen, der Ihr Backend trotzdem überlastet. Wählen Sie einen klaren Fallback: behalten Sie eine kleine Notfall‑Obergrenze am Edge und degradieren Sie nicht‑kritische Endpunkte graceful.

Das Client‑Handling ist wichtiger, als viele Teams erwarten. Wenn Sie ein generisches 429 ohne klare Nachricht zurückgeben, retryen Nutzer stärker und triggern mehr Blocks. Senden Sie immer Retry-After und halten Sie den Fehlertext spezifisch ("Zu viele Anfragen für diesen Schlüssel. Versuchen Sie es in 30 Sekunden erneut.").

Das am leichtesten vermeidbare Problem ist Geheimhaltung. Versteckte Limits wirken wie Bugs, wenn Kunden unter Produktionslast zum ersten Mal darauf stoßen. Teilen Sie eine einfache Policy und halten Sie sie stabil.

Kurze Checkliste, um False Positives zu vermeiden:

- Separate Limits für teure vs. günstige Endpunkte

- Primäres Limiting per API‑Schlüssel, nicht nur per IP

- Definiertes Verhalten, wenn der Limiter ausfällt

- Klare 429‑Antworten mit

Retry-After - Limits dokumentiert und kommuniziert vor der Durchsetzung

Wenn Sie Ihre API mit einem Tool wie AppMaster bauen, bedeutet das oft, unterschiedliche Caps pro Endpunkt zu setzen und konsistente Fehlerpayloads zurückzugeben, damit Clients ohne Ratenraten zurückfallen können.

Monitoring und Alerting, das wirklich hilft

Ratenbegrenzung funktioniert nur, wenn Sie in Echtzeit sehen, was passiert. Das Ziel ist nicht, jede Spitze zu fangen, sondern Muster zu erkennen, die in Ausfälle oder verärgerte Nutzer münden.

Beginnen Sie mit einer kleinen Menge an Signalen, die sowohl Volumen als auch Intent erklären:

- Requests pro Minute (gesamt und pro API‑Schlüssel)

- 429‑Rate (gedrosselte Anfragen) und 5xx‑Rate (Backend‑Schmerzen)

- Wiederholte 401/403‑Bursts (schlechte Schlüssel, Credential Stuffing, falsch konfigurierte Clients)

- Top‑Endpunkte nach Volumen und nach Kosten (lange Queries, schwere Exporte)

- Neue oder unerwartete Endpunkte in den Top‑10

Um "bösen Traffic" von "wir haben was ausgerollt" zu trennen, fügen Sie Dashboards Kontext hinzu: Deploy‑Zeit, Feature‑Flag‑Änderungen, Marketing‑Sends. Wenn der Traffic direkt nach einem Release springt und das Verhältnis 429/5xx stabil bleibt, ist es meist Wachstum, kein Missbrauch. Wenn der Anstieg auf einen Schlüssel, einen IP‑Bereich oder einen teuren Endpunkt konzentriert ist, ist Vorsicht geboten.

Alarme sollten langweilig sein. Verwenden Sie Schwellenwerte plus Cooldowns, damit Sie nicht jede Minute wegen desselben Ereignisses gerufen werden:

- 429‑Rate über X% für 10 Minuten, benachrichtigen Sie einmal pro Stunde

- 5xx über Y% für 5 Minuten, page sofort

- Einzelner Schlüssel überschreitet Quote um Z% für 15 Minuten, Untersuchung starten

- 401/403‑Bursts über N/min, markieren für möglichen Missbrauch

Wenn ein Alarm feuert, führen Sie eine kurze Incident‑Notiz: was sich geändert hat, was Sie gesehen haben (Top‑Keys/Endpunkte) und was Sie angepasst haben (Limits, Caches, temporäre Blocks). Mit der Zeit werden diese Notizen Ihr echtes Playbook.

Beispiel: Sie launchen einen neuen Such‑Endpunkt und der Traffic verdoppelt sich. Wenn die meisten Aufrufe diesen Endpunkt über viele Schlüssel hinweg treffen, erhöhen Sie die per‑Schlüssel‑Quota leicht und optimieren den Endpunkt. Wenn ein Schlüssel nonstop Exporte anstößt und Latenz hochtreibt, begrenzen Sie diesen Endpunkt separat und kontaktieren Sie den Besitzer.

Schnelle Checkliste: Sanity‑Checks vor und nach dem Launch

Eine gute Einrichtung ist langweilig, wenn sie funktioniert. Diese Checkliste fängt die Probleme ein, die normalerweise False Positives verursachen oder offensichtliche Lücken lassen.

Bevor Sie einen neuen Endpunkt ausliefern

Führen Sie diese Checks in Staging und kurz nach dem Launch in Produktion aus:

- Identity: Bestätigen Sie, dass der Limiter auf das richtige Feld schaut (API‑Schlüssel zuerst, dann User oder IP als Fallback) und dass rotierte Schlüssel keine alten Strafen erben.

- Limits: Setzen Sie eine Standard‑per‑Key‑Quota und passen Sie sie nach Endpunktkosten an (günstige Lese‑ vs. teure Schreib‑Operation).

- Antworten: Geben Sie klaren Status und Wiederherstellungsinfo zurück (Retry‑Timing, verbleibendes Budget, stabiler Fehlercode).

- Logs: Protokollieren Sie, wer limitiert wurde (Key/User/IP), welche Route, welche Regel ausgelöst wurde und eine Request‑ID für Support.

- Bypass: Behalten Sie eine Notfall‑Allowlist für Ihre Monitore und vertrauenswürdige Integrationen.

Wenn Sie auf AppMaster bauen, behandeln Sie jeden neuen API‑Endpunkt als Kosten‑Tier‑Entscheidung: ein einfacher Lookup kann großzügig sein, während alles, was schwere Business‑Logik triggert, stricter starten sollte.

Wenn ein Vorfall passiert (Missbrauch oder plötzlicher Traffic)

Schützen Sie das Backend und lassen Sie echte Nutzer sich erholen:

- Erhöhen Sie Caps temporär nur für die risikoärmsten Routen (oft Lesezugriffe) und beobachten Sie die Fehlerquoten.

- Fügen Sie eine kurze Allowlist für bekannte gute Kunden hinzu, während Sie untersuchen.

- Verschärfen Sie spezifische riskante Routen statt globale Limits abzusenken.

- Aktivieren Sie stärkere Identität (API‑Schlüssel verlangen, weniger Abhängigkeit von IP), um gemeinsame Netze nicht zu blockieren.

- Erfassen Sie Samples: Top‑Keys, Top‑IPs, User‑Agents und genaue Payload‑Muster.

Bevor Sie einem Kunden Limits erhöhen, prüfen Sie sein normales Anfrageverhalten, den Endpunkt‑Mix und ob er batchen oder Backoff einbauen kann. Bestätigen Sie auch, dass er nicht einen Schlüssel über viele Apps hinweg teilt.

Führen Sie monatlich Review durch: top limitierte Endpunkte, Prozentsatz des Traffics, der Limits trifft, neue High‑Cost‑Routen und ob Ihre Quoten noch zur realen Nutzung passen.

Beispiel‑Szenario: Eine echte öffentliche API schützen, ohne Nutzer zu brechen

Stellen Sie sich vor, Sie betreiben eine öffentliche API, die zwei Apps bedient: ein Kundenportal (hohes Volumen, stetiger Traffic) und ein internes Admin‑Tool (niedriges Volumen, aber mächtige Aktionen). Beide nutzen API‑Schlüssel, und das Portal hat zusätzlich einen Login‑Endpunkt für Endnutzer.

Eines Nachmittags shippt ein Partner ein fehlerhaftes Integration. Es beginnt, fehlgeschlagene Anfragen in einer engen Schleife zu retrien und sendet 200 Anfragen pro Sekunde von einem einzigen API‑Schlüssel. Ohne Schutzmechanismen kann dieser Schlüssel alle anderen verdrängen.

Per‑Schlüssel‑Limits begrenzen den Blast‑Radius. Der fehlerhafte Schlüssel erreicht sein per‑Minute‑Cap, erhält 429‑Antworten und der Rest Ihrer Kunden bleibt funktionsfähig. Sie könnten zudem einen separaten, niedrigeren Limit für teure Endpunkte (wie Exporte) haben, sodass selbst "erlaubter" Traffic die Datenbank nicht überlastet.

Gleichzeitig beginnt ein Brute‑Force‑Loginversuch die Auth‑Route zu hammern. Statt die ganze IP‑Range zu blocken (was echte Nutzer hinter NAT treffen würde), verlangsamen Sie erst und sperren dann basierend auf Verhalten: zu viele fehlgeschlagene Versuche pro Account plus pro IP in einem kurzen Fenster. Der Angreifer erhält progressiv längere Wartezeiten und schließlich eine temporäre Sperre.

Ein echter Kunde, der sein Passwort ein paar Mal falsch eingibt, kann sich erholen, weil Ihre Antworten klar und vorhersehbar sind:

- 429 mit

Retry-After, damit der Client weiß, wann er es erneut versuchen kann - Eine kurze Sperrzeit (z. B. 10–15 Minuten), kein permanenter Bann

- Konsistente Fehlermeldungen, die nicht preisgeben, ob ein Account existiert

Zur Bestätigung beobachten Sie einige Metriken:

- 429‑Rate nach API‑Schlüssel und Endpunkt

- Auth‑Fehlerrate und Sperrungsanzahl

- P95‑Latenz und Datenbank‑CPU während des Vorfalls

- Anzahl betroffener eindeutiger Schlüssel (sollte klein sein)

So sieht schützende Ratenbegrenzung aus, wenn sie Ihr Backend abschirmt, ohne normale Nutzer zu bestrafen.

Nächste Schritte: Kleine Policy festlegen und iterieren

Sie brauchen am ersten Tag kein perfektes Modell. Starten Sie mit einer kleinen, klaren Policy und verbessern Sie sie, während Sie lernen, wie echte Nutzer sich verhalten.

Eine solide erste Version hat meist drei Teile:

- Eine per‑Schlüssel‑Baseline (Anfragen pro Minute), die die meisten Endpunkte abdeckt

- Engere Caps für teure Endpunkte (Suche, Exporte, Datei‑Uploads, komplexe Reports)

- Klare 429‑Antworten mit einer kurzen Nachricht, die Clients sagt, was sie als Nächstes tun sollen

Fügen Sie Sperrungen nur dort hinzu, wo das Missbrauchsrisiko hoch ist und Absicht leicht zu erkennen ist. Signup, Login, Passwort‑Reset und Token‑Erzeugung sind typische Kandidaten. Halten Sie Sperrungen zuerst kurz (Minuten, nicht Tage) und bevorzugen Sie progressive Friktion: verlangsamen, dann temporär blockieren, dann stärkeren Check verlangen.

Schreiben Sie die Policy in einfacher Sprache auf, damit der Support sie ohne Entwicklerhilfe erklären kann. Enthalten Sie, was begrenzt wird (per API‑Schlüssel, per IP, per Account), das Reset‑Fenster und wie ein Kunde sich erholen kann.

Wenn Sie dies beim Aufbau eines neuen Backends umsetzen, kann AppMaster eine praktische Lösung sein: Sie können APIs erstellen, Geschäftsworkflows definieren (inklusive Zähler und Sperrungsentscheidungen) visuell und dann in Cloud‑Provider deployen oder den generierten Quellcode exportieren, wenn Sie volle Kontrolle benötigen.