OpenAI onthult GPT-4: de multimodale AI die tekst- en beeldbegrip verandert

OpenAI heeft GPT-4 geïntroduceerd, een geavanceerde multimodale AI die tekst en afbeeldingen kan verwerken en daarmee tal van use cases ontsluit. Het geavanceerde model is nu beschikbaar voor ChatGPT Plus-abonnees met plannen voor API-toegankelijkheid.

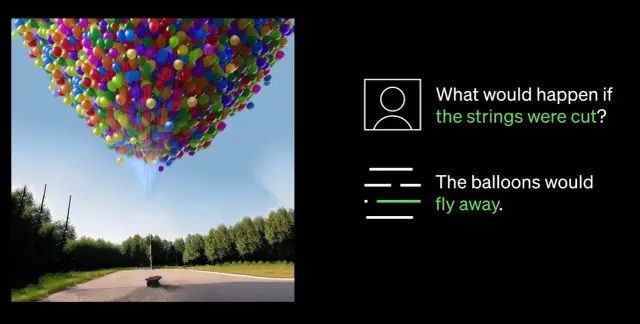

OpenAI heeft zijn baanbrekend tekst- en beeldbegripmodel, GPT-4, onthuld en geprezen als de meest recente benchmark van succes in evoluerende deep learning technologie. Deze nieuwste iteratie van het AI-model verwerkt niet alleen tekst, maar begrijpt ook beelden, en overtreft daarmee aanzienlijk de mogelijkheden van zijn voorganger GPT-3.5.

GPT-4 is toegankelijk voor abonnees van ChatGPT Plus met een opgelegde gebruikslimiet en kost $0,03 voor 1.000 prompt tokens (ongeveer 750 woorden) en $0,06 voor 1.000 completion tokens (opnieuw bijna 750 woorden). Ontwikkelaars zijn ook welkom op de wachtlijst voor toegang tot de API.

GPT-4 heeft de aandacht getrokken voor zijn heimelijke integratie in verschillende toepassingen. Het voedt Microsofts Bing Chat, een chatbot die is ontwikkeld in samenwerking met OpenAI. Andere vroege gebruikers zijn Stripe, dat GPT-4 gebruikt voor het samenvatten van zakelijke websites voor ondersteunend personeel; Duolingo, dat GPT-4 verwerkt in zijn premium taalleerabonnement; en Morgan Stanley, dat GPT-4 gebruikt om informatie uit bedrijfsdocumenten te halen en te leveren aan financiële analisten. GPT-4 is ook geïntegreerd in het geautomatiseerde begeleidingssysteem van Khan Academy.

GPT-4 is verbeterd ten opzichte van GPT-3.5, dat alleen tekstinvoer accepteerde, en kan zowel tekst als afbeeldingen verwerken. Het overtrof de onderste 10% scores van GPT-3.5 door scores te behalen binnen de top 10% van een gesimuleerd advocatuurexamen.

Gedurende zes maanden heeft OpenAI GPT-4 verfijnd aan de hand van inzichten uit een intern testprogramma voor tegenstanders en ChatGPT, terwijl het samen met Microsoft een Azure-cloudsupercomputer ontwierp om het geavanceerde AI-model te trainen. Het resultaat is dat GPT-4 in vergelijking met de vorige versie, GPT-3.5, betrouwbaarder, creatiever en vaardiger is in het omgaan met ingewikkelde aspecten.

Een van de opvallendste verbeteringen in GPT-4 is zijn vermogen om zowel beelden als tekst te begrijpen. Het kan bijvoorbeeld complexe beelden interpreteren en van bijschriften voorzien, zoals het identificeren van een Lightning Cable-adapter door een ingeplugde iPhone-afbeelding te analyseren. Dit beeldbegrip wordt momenteel getest met partner Be My Eyes. Hun nieuwe GPT-4-functie Virtual Volunteer helpt gebruikers bij het beantwoorden van vragen over beelden en biedt een uitgebreide analyse en praktische aanbevelingen op basis van de gepresenteerde beeldgegevens.

Een belangrijke doorbraak in de mogelijkheden van GPT-4 is de verbeterde stuurbaarheid. Door de introductie van systeemberichten via de nieuwe API kunnen ontwikkelaars de AI sturen door gedetailleerde instructies te geven over stijl en taken. Deze instructies bepalen de context en de grenzen voor AI-interacties en zorgen voor een symbiotische relatie tussen AI en menselijke hulpbronnen.

Ondanks de aanzienlijke vooruitgang erkent OpenAI echter dat GPT-4 beperkingen heeft, zoals redeneerfouten, foutieve informatie en gebrek aan kennis over gebeurtenissen na september 2021. Bovendien kan GPT-4 onbedoeld kwetsbaarheden introduceren in de code die het produceert. Niettemin heeft OpenAI vooruitgang geboekt bij het verfijnen van GPT-4, waardoor de kans kleiner is dat het zich bezighoudt met verboden inhoud of ongepast reageert op gevoelige verzoeken.

Terwijl het AI-veld zich blijft ontwikkelen, blijft OpenAI vastbesloten om GPT-4 verder te verbeteren en zo een intelligentere en efficiëntere toekomst te bevorderen die wordt aangedreven door geavanceerde AI-technologie. Bedrijven die AI in hun workflows willen implementeren, kunnen overwegen om no-code platforms zoals AppMaster.io te onderzoeken om op gegevens gebaseerde besluitvormingssystemen in hun bedrijf te integreren.