OpenAI presenta GPT-4: la IA multimodal que transforma la comprensión de textos e imágenes

OpenAI ha presentado GPT-4, una IA multimodal avanzada capaz de procesar texto e imágenes, desbloqueando numerosos casos de uso. El modelo avanzado ya está disponible para los suscriptores de ChatGPT Plus con planes de accesibilidad a la API.

OpenAI ha presentado su revolucionario modelo de comprensión de texto e imágenes, GPT-4, que considera la referencia más reciente de éxito en la evolución de la tecnología de aprendizaje profundo. Esta última iteración del modelo de IA no solo procesa texto, sino que también comprende imágenes superando significativamente las capacidades de su predecesor, GPT-3.5.

Accesible para los suscriptores de ChatGPT Plus con un límite de uso impuesto, GPT-4 cobra 0,03 dólares por 1.000 tokens de aviso (unas 750 palabras) y 0,06 dólares por 1.000 tokens de finalización (de nuevo, casi 750 palabras). Los desarrolladores también pueden inscribirse en la lista de espera para acceder a la API.

GPT-4 ha llamado la atención por su integración encubierta en varias aplicaciones. Es la base de Bing Chat de Microsoft, un chatbot desarrollado en colaboración con OpenAI. Otros de los primeros usuarios son Stripe, que utiliza GPT-4 para resumir sitios web comerciales para el personal de soporte; Duolingo, que incorpora GPT-4 en su suscripción premium de aprendizaje de idiomas; y Morgan Stanley, que aprovecha GPT-4 para extraer y entregar información de documentos de la empresa a analistas financieros. GPT-4 también se ha integrado en el sistema de tutoría automatizada de Khan Academy.

Mejorado con respecto a GPT-3.5, que sólo aceptaba entradas de texto, GPT-4 acepta entradas tanto de texto como de imágenes, demostrando un rendimiento "de nivel humano" en múltiples parámetros académicos. Superó las puntuaciones del 10% inferior obtenidas por GPT-3.5 al lograr puntuaciones dentro del umbral del 10% superior en un examen de abogacía simulado.

Durante seis meses, OpenAI ha perfeccionado GPT-4 a partir de los resultados de un programa interno de pruebas de adversarios y ChatGPT, al tiempo que colaboraba con Microsoft en el diseño de un superordenador Azure basado en la nube para entrenar el modelo avanzado de IA. Como resultado, GPT-4 exhibe una mayor fiabilidad, creatividad y competencia en el manejo de aspectos intrincados en comparación con su iteración anterior, GPT-3.5.

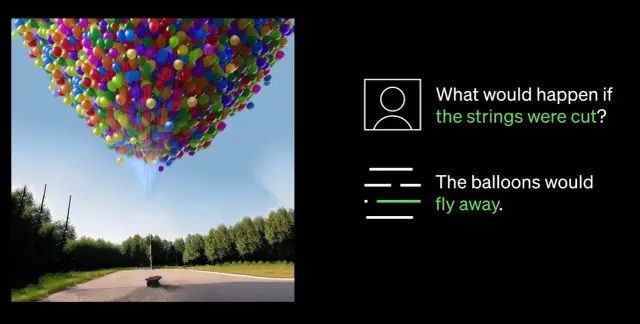

Uno de los avances más notables de GPT-4 es su capacidad para comprender tanto imágenes como texto. Por ejemplo, puede interpretar y subtitular imágenes complejas, como identificar un adaptador de cable Lightning analizando la imagen de un iPhone conectado. Esta capacidad de comprensión de imágenes se está probando actualmente con el socio único Be My Eyes. Su nueva función de Voluntario Virtual potenciada por GPT-4 ayuda a los usuarios respondiendo a preguntas sobre imágenes, ofreciéndoles un análisis exhaustivo y recomendaciones prácticas basadas en los datos de la imagen presentada.

Un avance fundamental en las capacidades de GPT-4 es su mayor direccionabilidad. La introducción de mensajes del sistema a través de la nueva API permite a los desarrolladores guiar a la IA proporcionándole instrucciones detalladas sobre el estilo y las tareas. Estas instrucciones establecen el contexto y los límites de las interacciones de la IA, garantizando una relación simbiótica entre ésta y los recursos humanos.

Sin embargo, a pesar de los avances sustanciales, OpenAI reconoce que GPT-4 tiene limitaciones, como errores de razonamiento, información errónea y desconocimiento de los acontecimientos posteriores a septiembre de 2021. Además, GPT-4 puede introducir inadvertidamente vulnerabilidades en el código que produce. No obstante, OpenAI ha avanzado en el perfeccionamiento de GPT-4, haciendo que sea menos probable que se involucre con contenidos prohibidos o responda de forma inapropiada a peticiones delicadas.

A medida que el campo de la IA sigue evolucionando, OpenAI sigue decidida a mejorar aún más GPT-4, fomentando un futuro más inteligente y eficiente impulsado por la tecnología avanzada de IA. Las empresas que deseen implantar la IA en sus flujos de trabajo pueden considerar la posibilidad de explorar plataformas de no-code como AppMaster.io para integrar en sus negocios sistemas de toma de decisiones basados en datos.