OpenAI tiết lộ GPT-4: Trí tuệ nhân tạo đa phương thức chuyển đổi cách hiểu về văn bản và hình ảnh

OpenAI đã giới thiệu GPT-4, một AI đa phương thức tiên tiến có khả năng xử lý văn bản và hình ảnh, mở khóa nhiều trường hợp sử dụng. Mô hình nâng cao hiện khả dụng cho những người đăng ký ChatGPT Plus có gói hỗ trợ truy cập API.

OpenAI đã tiết lộ mô hình hiểu văn bản và hình ảnh đột phá của mình, GPT-4, ca ngợi đây là chuẩn mực thành công gần đây nhất trong việc phát triển công nghệ học sâu. Phiên bản mô hình AI mới nhất này không chỉ xử lý văn bản mà còn hiểu được hình ảnh, vượt trội đáng kể so với khả năng của người tiền nhiệm GPT-3.5.

Có thể truy cập được đối với người đăng ký ChatGPT Plus với giới hạn sử dụng bắt buộc, GPT-4 tính phí 0,03 đô la cho 1.000 mã thông báo nhanh (khoảng 750 từ) và 0,06 đô la cho 1.000 mã thông báo hoàn thành (một lần nữa, gần 750 từ). Các nhà phát triển cũng được hoan nghênh tham gia danh sách chờ để truy cập API.

GPT-4 đã thu hút được sự chú ý nhờ tích hợp bí mật vào các ứng dụng khác nhau. Nó hỗ trợ Bing Chat của Microsoft, một chatbot được phát triển với sự cộng tác của OpenAI. Những người dùng đầu tiên khác bao gồm Stripe, sử dụng GPT-4 để tóm tắt các trang web kinh doanh cho nhân viên hỗ trợ; Duolingo, kết hợp GPT-4 vào đăng ký học ngôn ngữ cao cấp của mình; và Morgan Stanley, tận dụng GPT-4 để trích xuất và cung cấp thông tin tài liệu của công ty cho các nhà phân tích tài chính. GPT-4 cũng đã được tích hợp vào hệ thống gia sư tự động của Khan Academy.

Được cải tiến so với GPT-3.5, vốn chỉ chấp nhận kiểu nhập văn bản, GPT-4 nhận cả kiểu nhập văn bản và hình ảnh, thể hiện hiệu suất 'ở cấp độ con người' trên nhiều điểm chuẩn học thuật. Nó đã vượt qua 10% điểm thấp nhất mà GPT-3.5 đạt được bằng cách đạt được điểm trong ngưỡng 10% cao nhất của một kỳ thi luật sư mô phỏng.

Trong hơn sáu tháng, OpenAI đã tinh chỉnh GPT-4 bằng cách sử dụng thông tin chuyên sâu từ chương trình thử nghiệm đối thủ nội bộ và ChatGPT trong khi cộng tác với Microsoft trong việc thiết kế một siêu máy tính dựa trên đám mây Azure để đào tạo mô hình AI tiên tiến. Kết quả là, GPT-4 thể hiện độ tin cậy, tính sáng tạo và năng lực cao hơn trong việc xử lý các khía cạnh phức tạp so với phiên bản trước đó, GPT-3.5.

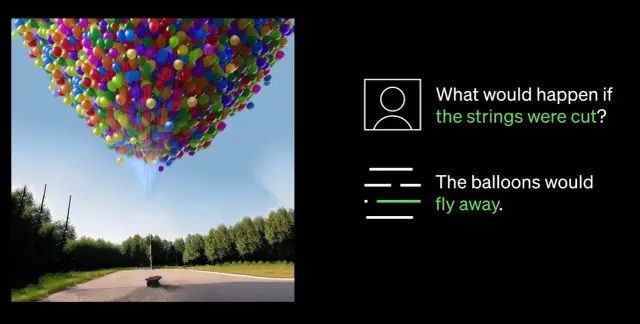

Một trong những cải tiến đáng chú ý nhất trong GPT-4 là khả năng hiểu cả hình ảnh và văn bản. Chẳng hạn, nó có thể giải thích và chú thích các hình ảnh phức tạp, chẳng hạn như xác định bộ điều hợp Cáp Lightning bằng cách phân tích hình ảnh iPhone được cắm vào. Khả năng hiểu hình ảnh này hiện đang được thử nghiệm với đối tác duy nhất Be My Eyes. Tính năng Tình nguyện viên ảo hỗ trợ GPT-4 mới của họ hỗ trợ người dùng bằng cách trả lời các câu hỏi về hình ảnh, đưa ra phân tích toàn diện và đề xuất thực tế dựa trên dữ liệu hình ảnh được trình bày.

Một bước đột phá quan trọng trong khả năng của GPT-4 là khả năng điều khiển nâng cao của nó. Việc giới thiệu các thông báo hệ thống thông qua API mới cho phép các nhà phát triển hướng dẫn AI bằng cách cung cấp các hướng dẫn chi tiết về phong cách và tác vụ. Các hướng dẫn này thiết lập bối cảnh và ranh giới cho các tương tác AI, đảm bảo mối quan hệ cộng sinh giữa AI và nguồn nhân lực.

Tuy nhiên, bất chấp những tiến bộ đáng kể, OpenAI thừa nhận rằng GPT-4 có những hạn chế, bao gồm lỗi lập luận, thông tin nhầm lẫn và thiếu kiến thức về các sự kiện sau tháng 9 năm 2021. Ngoài ra, GPT-4 có thể vô tình tạo ra các lỗ hổng trong mã mà nó tạo ra. Tuy nhiên, OpenAI đã có những bước tiến trong việc tinh chỉnh GPT-4, khiến nó ít có khả năng tương tác với nội dung bị cấm hoặc phản hồi không phù hợp với các yêu cầu nhạy cảm.

Khi lĩnh vực AI tiếp tục phát triển, OpenAI vẫn quyết tâm cải thiện hơn nữa GPT-4, thúc đẩy một tương lai thông minh và hiệu quả hơn được hỗ trợ bởi công nghệ AI tiên tiến. Các công ty đang tìm cách triển khai AI vào quy trình làm việc của họ có thể cân nhắc khám phá các nền tảng no-code như AppMaster.io để tích hợp các hệ thống ra quyết định dựa trên dữ liệu vào doanh nghiệp của họ.