OpenAI, GPT-4 공개: 텍스트 및 이미지 이해를 변화시키는 멀티모달 AI

OpenAI는 텍스트와 이미지를 처리할 수 있는 고급 멀티모달 AI인 GPT-4를 도입하여 수많은 사용 사례를 잠금 해제했습니다. 고급 모델은 이제 API 접근성 계획이 있는 ChatGPT Plus 구독자에게 제공됩니다.

OpenAI는 혁신적인 텍스트 및 이미지 이해 모델인 GPT-4를 공개하여 진화하는 딥 러닝 기술의 성공에 대한 가장 최근의 벤치마크로 칭송했습니다. 이 최신 AI 모델 반복은 텍스트를 처리할 뿐만 아니라 이전 버전인 GPT-3.5의 기능을 훨씬 능가하는 이미지를 이해합니다.

사용 한도가 부과된 ChatGPT Plus 가입자가 이용할 수 있는 GPT-4는 프롬프트 토큰 1,000개(약 750단어)에 0.03달러, 완료 토큰 1,000개(약 750단어)에 0.06달러를 청구합니다. 개발자도 API에 액세스하기 위해 대기자 명단에 가입할 수 있습니다.

GPT-4는 다양한 애플리케이션에 은밀하게 통합되어 주목을 받았습니다. OpenAI와 공동으로 개발한 챗봇인 Microsoft의 Bing Chat을 지원합니다. 다른 얼리 어답터에는 지원 직원을 위한 비즈니스 웹 사이트를 요약하기 위해 GPT-4를 사용하는 Stripe가 포함됩니다. GPT-4를 프리미엄 언어 학습 구독에 통합한 Duolingo GPT-4를 활용하여 회사 문서 정보를 추출하여 재무 분석가에게 전달하는 Morgan Stanley. GPT-4는 Khan Academy의 자동 튜터링 시스템에도 통합되었습니다.

텍스트 입력만 허용하는 GPT-3.5보다 개선된 GPT-4는 텍스트와 이미지 입력을 모두 받아 여러 학술 벤치마크에서 '인간 수준'의 성능을 보여줍니다. 모의 변호사 시험의 상위 10% 임계값 내에서 점수를 달성하여 GPT-3.5에서 달성한 하위 10% 점수를 능가했습니다.

OpenAI는 6개월 동안 내부 적대적 테스트 프로그램 및 ChatGPT의 통찰력을 사용하여 GPT-4를 개선했으며 Microsoft와 협력하여 고급 AI 모델을 교육하기 위해 Azure 클라우드 기반 슈퍼 컴퓨터를 설계했습니다. 결과적으로 GPT-4는 이전 반복인 GPT-3.5에 비해 복잡한 측면을 처리하는 데 향상된 신뢰성, 창의성 및 역량을 보여줍니다.

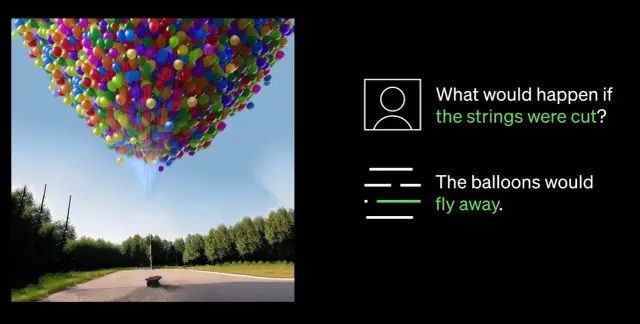

GPT-4에서 가장 주목할만한 발전 중 하나는 이미지와 텍스트를 모두 이해하는 능력입니다. 예를 들어 연결된 iPhone 이미지를 분석하여 Lightning 케이블 어댑터를 식별하는 것과 같이 복잡한 이미지를 해석하고 캡션을 지정할 수 있습니다. 이 이미지 이해 능력은 현재 단일 파트너 Be My Eyes와 함께 테스트 중입니다. 새로운 GPT-4 기반 Virtual Volunteer 기능은 이미지에 대한 질문에 답하고 제시된 이미지 데이터를 기반으로 포괄적인 분석 및 실용적인 권장 사항을 제공함으로써 사용자를 지원합니다.

GPT-4 기능의 가장 중요한 돌파구는 향상된 조종성입니다. 새로운 API를 통한 시스템 메시지 도입으로 개발자는 스타일 및 작업에 대한 자세한 지침을 제공하여 AI를 안내할 수 있습니다. 이러한 지침은 AI 상호 작용에 대한 컨텍스트와 경계를 설정하여 AI와 인적 자원 간의 공생 관계를 보장합니다.

그러나 상당한 발전에도 불구하고 OpenAI는 GPT-4에 추론 오류, 잘못된 정보, 2021년 9월 이후 사건에 대한 지식 부족 등의 한계가 있음을 인정합니다. 또한 GPT-4는 생성하는 코드에 실수로 취약점을 도입할 수 있습니다. 그럼에도 불구하고 OpenAI는 GPT-4를 개선하여 금지된 콘텐츠에 관여하거나 민감한 요청에 부적절하게 응답할 가능성을 줄였습니다.

AI 분야가 계속 발전함에 따라 OpenAI는 GPT-4를 더욱 개선하여 고급 AI 기술로 구동되는 보다 지능적이고 효율적인 미래를 조성하기로 결정했습니다. AI를 워크플로에 구현하려는 회사는 AppMaster.io 와 같은 no-code 플랫폼을 탐색하여 데이터 기반 의사 결정 시스템을 비즈니스에 통합하는 것을 고려할 수 있습니다.