OpenAI、文字・画像理解を変革するマルチモーダルAI「GPT-4」を公開

OpenAIは、テキストと画像を処理できる先進のマルチモーダルAI「GPT-4」を発表し、数々のユースケースを解き明かしました。この先進的なモデルは、APIアクセシビリティのプランがあるChatGPT Plusの契約者に提供されています。

OpenAIは、テキストと画像を理解する画期的なモデル「GPT-4」を発表し、進化するディープラーニング技術における最新の成功のベンチマークと位置づけました。この最新のAIモデルは、テキストを処理するだけでなく、前身であるGPT-3.5の能力を大幅に上回る画像を理解することができます。

GPT-4は、ChatGPT Plusの加入者であれば、利用上限を設けた上で、プロンプトトークン1,000個(約750ワード)で0.03ドル、コンプリートトークン1,000個(やはり約750ワード)で0.06ドルで利用することができます。また、開発者はAPIにアクセスするためのウェイティングリストに参加することを歓迎されています。

GPT-4は、さまざまなアプリケーションに密かに組み込まれていることで注目を集めています。マイクロソフトがOpenAIと共同開発したチャットボット「Bing Chat」を動かしています。その他にも、サポートスタッフ向けにビジネスサイトの要約にGPT-4を使用しているStripe社、プレミアム言語学習にGPT-4を組み込んでいるDuolingo社、金融アナリスト向けに企業文書情報を抽出し配信するためにGPT-4を活用しているMorgan Stanley社などが、いち早く導入しています。また、GPT-4はカーン・アカデミーの自動学習システムにも組み込まれています。

GPT-4は、テキスト入力のみだったGPT-3.5を改良し、テキストと画像の両方を入力できるようにしたもので、複数の学術ベンチマークで「人間レベル」の性能を実証しています。GPT-3.5で下位10%だった点数を上回り、模擬司法試験で上位10%の基準点内に入る点数を達成しました。

OpenAIは6ヶ月間、社内の敵対的テストプログラムとChatGPTから得た知見をもとにGPT-4を改良し、マイクロソフトと協力して高度なAIモデルを訓練するためのAzureクラウドベースのスーパーコンピューターを設計しました。その結果、GPT-4は、以前のバージョンであるGPT-3.5と比較して、信頼性、創造性、複雑な局面を処理する能力が向上しています。

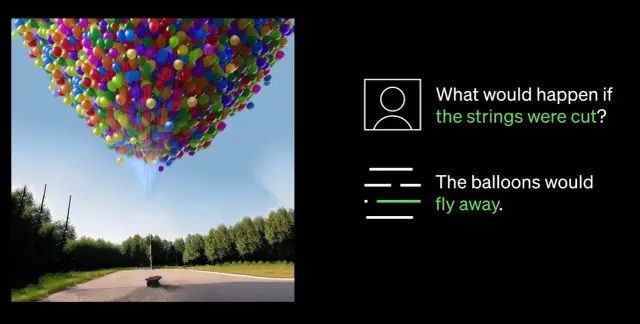

GPT-4で最も注目すべき点は、画像とテキストの両方を理解できるようになったことです。例えば、iPhoneを接続した画像を解析してライトニングケーブルアダプターを特定するなど、複雑な画像を解釈してキャプションを付けることができるようになりました。この画像理解能力は、現在、シングルパートナーのビー・マイ・アイズと共同でテスト中です。GPT-4を活用した新しいバーチャルボランティア機能は、画像に関する質問に答え、提示された画像データに基づいて包括的な分析と実用的な提案を行うことで、ユーザーを支援するものです。

GPT-4の最大の特徴は、ステアリングの強化です。新しいAPIによるシステムメッセージの導入により、開発者はスタイルやタスクに関する詳細な指示を与えることで、AIを誘導することができます。このメッセージは、AIとの対話の文脈や境界を設定し、AIと人間の共生を実現します。

しかし、実質的な進歩にもかかわらず、OpenAIは、推論エラー、誤った情報、2021年9月以降の出来事に関する知識の欠如など、GPT-4に限界があることを認めています。また、GPT-4が生成するコードに不注意で脆弱性が生じる可能性もあります。しかし、OpenAIはGPT-4の改良を進め、禁止されているコンテンツに関与したり、機密性の高いリクエストに不適切に対応したりする可能性を低くしています。

AI分野が進化し続ける中、OpenAIはGPT-4をさらに改良し、高度なAI技術によって、より知的で効率的な未来を育むことを決意しています。ワークフローにAIを導入しようとしている企業は、AppMaster.ioのようなno-code プラットフォームを検討し、データに基づく意思決定システムをビジネスに統合することを検討してみてはいかがでしょうか?