OpenAI เผย GPT-4: AI หลายรูปแบบที่เปลี่ยนความเข้าใจในข้อความและรูปภาพ

OpenAI ได้เปิดตัว GPT-4 ซึ่งเป็น AI หลายรูปแบบขั้นสูงที่สามารถประมวลผลข้อความและรูปภาพ ปลดล็อกกรณีการใช้งานจำนวนมาก ขณะนี้โมเดลขั้นสูงพร้อมใช้งานสำหรับสมาชิก ChatGPT Plus ที่มีแผนสำหรับการเข้าถึง API

OpenAI ได้เปิดตัวโมเดลการทำความเข้าใจข้อความและรูปภาพที่ก้าวล้ำ GPT-4 โดยยกย่องให้เป็นเกณฑ์มาตรฐานล่าสุดแห่งความสำเร็จในการพัฒนาเทคโนโลยีการเรียนรู้เชิงลึก การทำซ้ำล่าสุดของโมเดล AI นี้ไม่เพียงแต่ประมวลผลข้อความเท่านั้น แต่ยังเข้าใจรูปภาพซึ่งเหนือกว่าความสามารถของรุ่นก่อนอย่าง GPT-3.5 อย่างมาก

เข้าถึงได้สำหรับสมาชิกของ ChatGPT Plus ด้วยขีดจำกัดการใช้งานที่กำหนด GPT-4 จะเรียกเก็บเงิน 0.03 ดอลลาร์สำหรับโทเค็นพรอมต์ 1,000 รายการ (ประมาณ 750 คำ) และ 0.06 ดอลลาร์สำหรับโทเค็นการเสร็จสิ้น 1,000 รายการ (อีกครั้ง เกือบ 750 คำ) นักพัฒนาสามารถเข้าร่วมรายการรอเพื่อเข้าถึง API

GPT-4 ได้รับความสนใจจากการผสานรวมแอบแฝงเข้ากับแอปพลิเคชันต่างๆ ขับเคลื่อน Bing Chat ของ Microsoft ซึ่งเป็นแชทบอทที่พัฒนาร่วมกับ OpenAI ผู้ใช้รายแรกอื่นๆ ได้แก่ Stripe ซึ่งใช้ GPT-4 เพื่อสรุปเว็บไซต์ธุรกิจสำหรับเจ้าหน้าที่ฝ่ายสนับสนุน Duolingo ซึ่งรวม GPT-4 ไว้ในการสมัครเรียนภาษาระดับพรีเมียม และ Morgan Stanley ซึ่งใช้ประโยชน์จาก GPT-4 เพื่อแยกและส่งข้อมูลเอกสารของบริษัทให้กับนักวิเคราะห์ทางการเงิน นอกจากนี้ GPT-4 ยังรวมเข้ากับระบบการสอนอัตโนมัติของ Khan Academy

ปรับปรุง GPT-3.5 ซึ่งยอมรับการป้อนข้อความเท่านั้น GPT-4 ใช้ทั้งการป้อนข้อความและรูปภาพ แสดงให้เห็นถึงประสิทธิภาพ 'ระดับมนุษย์' ในเกณฑ์มาตรฐานทางวิชาการหลายรายการ มีคะแนนเกินเกณฑ์ 10% ด้านล่างของ GPT-3.5 โดยได้คะแนนภายในเกณฑ์ 10% แรกของการสอบเนติบัณฑิตจำลอง

กว่าหกเดือน OpenAI ได้ปรับปรุง GPT-4 โดยใช้ข้อมูลเชิงลึกจากโปรแกรมทดสอบของฝ่ายตรงข้ามภายในและ ChatGPT ในขณะที่ร่วมมือกับ Microsoft ในการออกแบบซูเปอร์คอมพิวเตอร์บนคลาวด์ Azure เพื่อฝึกโมเดล AI ขั้นสูง ด้วยเหตุนี้ GPT-4 จึงแสดงความน่าเชื่อถือ ความคิดสร้างสรรค์ และความสามารถในการจัดการด้านที่ซับซ้อนที่เพิ่มขึ้นเมื่อเทียบกับ GPT-3.5 รุ่นก่อนหน้า

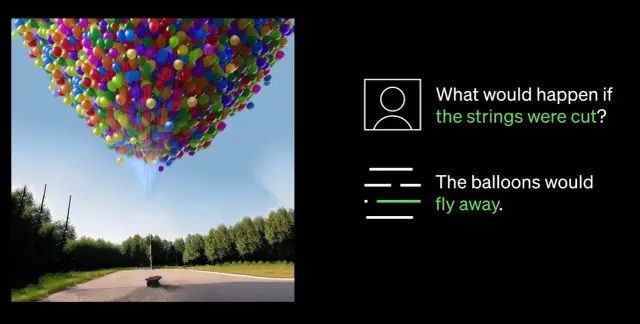

หนึ่งในความก้าวหน้าที่สำคัญที่สุดใน GPT-4 คือความสามารถในการเข้าใจทั้งรูปภาพและข้อความ ตัวอย่างเช่น สามารถตีความและบรรยายภาพที่ซับซ้อน เช่น ระบุอะแดปเตอร์ Lightning Cable โดยการวิเคราะห์ภาพ iPhone ที่เสียบปลั๊ก กำลังทดสอบความสามารถในการเข้าใจภาพนี้กับคู่หู Be My Eyes ฟีเจอร์อาสาสมัครเสมือนที่ขับเคลื่อนด้วย GPT-4 ใหม่ของพวกเขาช่วยผู้ใช้ด้วยการตอบคำถามเกี่ยวกับรูปภาพ นำเสนอการวิเคราะห์ที่ครอบคลุมและคำแนะนำเชิงปฏิบัติตามข้อมูลรูปภาพที่นำเสนอ

ความก้าวหน้าครั้งสำคัญในความสามารถของ GPT-4 คือความสามารถในการบังคับเลี้ยวที่ปรับปรุงให้ดีขึ้น การแนะนำข้อความระบบผ่าน API ใหม่ช่วยให้นักพัฒนาสามารถแนะนำ AI โดยให้คำแนะนำโดยละเอียดเกี่ยวกับรูปแบบและงาน คำแนะนำเหล่านี้สร้างบริบทและขอบเขตสำหรับการโต้ตอบของ AI เพื่อให้มั่นใจถึงความสัมพันธ์ทางชีวภาพระหว่าง AI และทรัพยากรมนุษย์

แม้จะมีความก้าวหน้าอย่างมาก แต่ OpenAI ก็ยอมรับว่า GPT-4 มีข้อจำกัด รวมถึงข้อผิดพลาดในการให้เหตุผล ข้อมูลที่ผิดพลาด และการขาดความรู้เกี่ยวกับเหตุการณ์หลังเดือนกันยายน 2021 นอกจากนี้ GPT-4 อาจแนะนำช่องโหว่ในโค้ดที่สร้างขึ้นโดยไม่ได้ตั้งใจ อย่างไรก็ตาม OpenAI มีความก้าวหน้าในการปรับปรุง GPT-4 ทำให้มีโอกาสน้อยที่จะมีส่วนร่วมกับเนื้อหาต้องห้ามหรือตอบสนองต่อคำขอที่ละเอียดอ่อนอย่างไม่เหมาะสม

ในขณะที่สาขา AI พัฒนาอย่างต่อเนื่อง OpenAI ยังคงมุ่งมั่นที่จะปรับปรุง GPT-4 ต่อไป ส่งเสริมอนาคตที่ชาญฉลาดและมีประสิทธิภาพยิ่งขึ้นซึ่งขับเคลื่อนโดยเทคโนโลยี AI ขั้นสูง บริษัทที่ต้องการนำ AI ไปใช้ในเวิร์กโฟลว์อาจพิจารณาสำรวจแพลตฟอร์ม no-code เช่น AppMaster.io เพื่อรวมระบบการตัดสินใจโดยใช้ข้อมูลเข้ากับธุรกิจของตน