Microsoft Semantic Kernel SDK Menjembatani Kesenjangan antara LLM dan Kode

SDK Kernel Semantik Microsoft menyederhanakan proses integrasi model bahasa besar (LLM) seperti GPT ke dalam kode. Ini menawarkan perilaku mirip sistem operasi untuk LLM API, mengelola perintah yang kompleks, mengatur operasi, dan memastikan hasil yang terfokus.

Microsoft memperkenalkan SDK Kernel Semantik , membuat integrasi model bahasa besar (LLM) seperti GPT-4 ke dalam kode jauh lebih mudah. Kerumitan mengelola permintaan, masukan, dan keluaran terfokus disederhanakan dengan SDK ini, menjembatani kesenjangan antara model bahasa dan pengembang.

Proses pengintegrasian model AI ke dalam kode Anda bisa sangat menantang, karena melibatkan melintasi batas antara dua cara komputasi yang berbeda. Metode pemrograman tradisional tidak cukup untuk berinteraksi dengan LLM. Apa yang dibutuhkan adalah abstraksi tingkat tinggi yang menerjemahkan antara domain yang berbeda, menyediakan cara untuk mengelola konteks dan menjaga keluaran tetap pada data sumber.

Beberapa minggu yang lalu, Microsoft merilis pembungkus LLM pertamanya yang disebut Mesin Prompt . Membangun dari itu, raksasa perangkat lunak kini telah meluncurkan alat C # yang lebih kuat, Semantic Kernel , untuk bekerja dengan Azure OpenAI dan API OpenAI. Alat sumber terbuka ini tersedia di GitHub, bersama dengan beberapa contoh aplikasi.

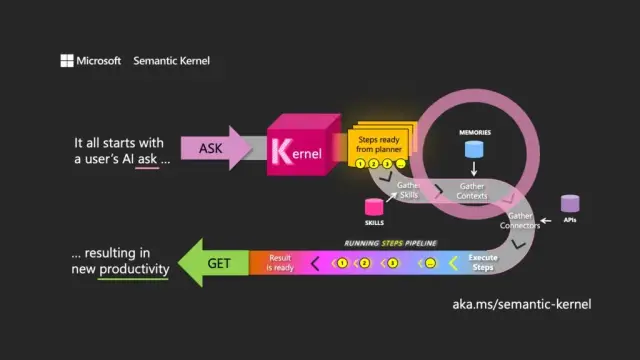

Pilihan nama menandakan pemahaman tentang tujuan utama LLM. Kernel Semantik berfokus pada input dan output bahasa alami dengan mengarahkan model menggunakan permintaan pengguna awal (permintaan) untuk mengatur melewati sumber daya terkait, memenuhi permintaan dan mengembalikan respons (get).

Semantic Kernel berfungsi seperti sistem operasi untuk API LLM, mengambil input, memprosesnya dengan bekerja dengan model bahasa, dan mengembalikan output. Peran orkestrasi kernel sangat penting dalam mengelola tidak hanya perintah dan token yang terkait tetapi juga memori, konektor ke layanan informasi lainnya, dan keterampilan yang telah ditentukan sebelumnya yang memadukan petunjuk dan kode konvensional.

Kernel Semantik mengelola konteks melalui konsep memori, bekerja dengan file dan penyimpanan nilai kunci. Opsi ketiga, memori semantik , memperlakukan konten sebagai vektor atau penyematan, yang merupakan susunan angka yang digunakan LLM untuk mewakili makna teks. Vektor tertanam ini membantu model dasar mempertahankan relevansi, koherensi, dan mengurangi kemungkinan menghasilkan keluaran acak.

Dengan menggunakan penyematan, pengembang dapat memecah perintah besar menjadi blok teks untuk membuat perintah yang lebih fokus tanpa menghabiskan token yang tersedia untuk permintaan (misalnya, GPT-4 memiliki batas 8.192 token per masukan).

Konektor memainkan peran penting dalam Semantic Kernel, memungkinkan integrasi API yang ada dengan LLM. Misalnya, konektor Microsoft Graph dapat mengirim keluaran permintaan dalam email atau membuat deskripsi hubungan dalam bagan organisasi. Konektor juga menyediakan bentuk kontrol akses berbasis peran untuk memastikan bahwa keluaran disesuaikan dengan pengguna, berdasarkan data mereka.

Komponen utama ketiga dari Kernel Semantik adalah keterampilan , yang merupakan wadah fungsi yang memadukan petunjuk LLM dan kode konvensional, mirip dengan Fungsi Azure. Mereka dapat digunakan untuk menyatukan permintaan khusus dan membuat aplikasi bertenaga LLM.

Keluaran dari satu fungsi dapat dirangkai ke fungsi lainnya, memungkinkan pembangunan saluran fungsi yang memadukan pemrosesan asli dan operasi LLM. Dengan cara ini, pengembang dapat membangun keterampilan fleksibel yang dapat dipilih dan dimanfaatkan sesuai kebutuhan.

Meskipun Semantic Kernel adalah alat yang ampuh, namun membutuhkan pemikiran dan perencanaan yang cermat untuk membuat aplikasi yang efektif. Dengan menggunakan SDK secara strategis bersama kode asli, pengembang dapat memanfaatkan potensi LLM, menjadikan proses pengembangan lebih efisien dan produktif. Untuk membantu memulai, Microsoft menyediakan daftar pedoman praktik terbaik yang dipelajari dari membangun aplikasi LLM dalam bisnisnya sendiri.

Dalam konteks pengembangan perangkat lunak modern, Semantic Kernel SDK Microsoft memposisikan dirinya sebagai kunci untuk mengintegrasikan model bahasa besar dalam berbagai aplikasi. Implementasinya dapat sangat menguntungkan alat seperti platform no-codeAppMaster dan pembuat situs web , menawarkan solusi yang lebih fleksibel dan efisien untuk berbagai pengguna.